Karpenter

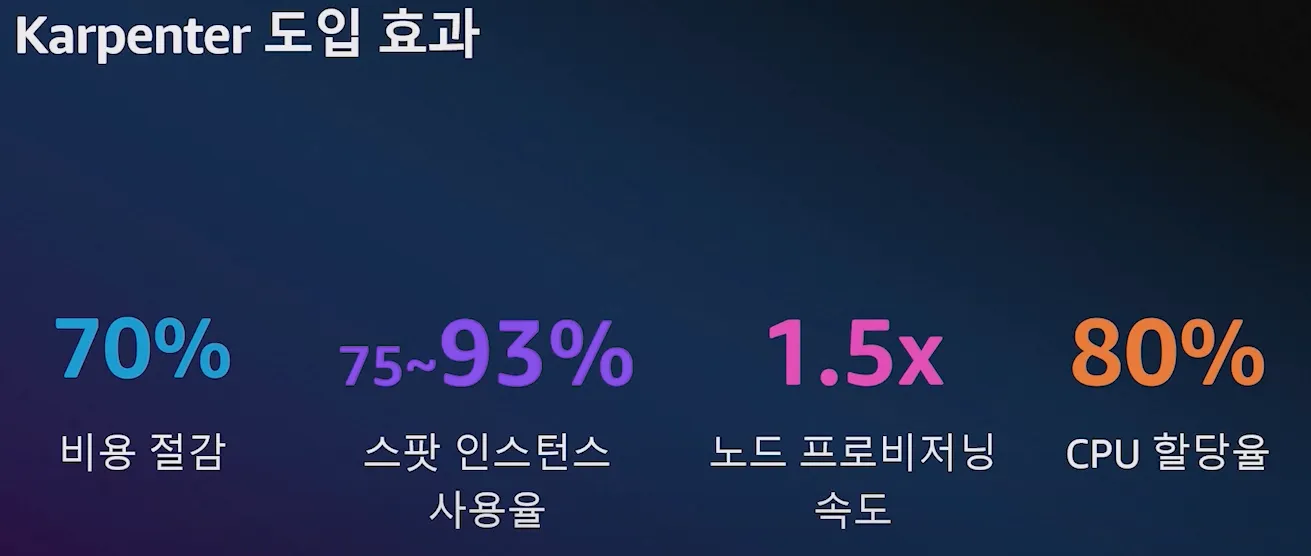

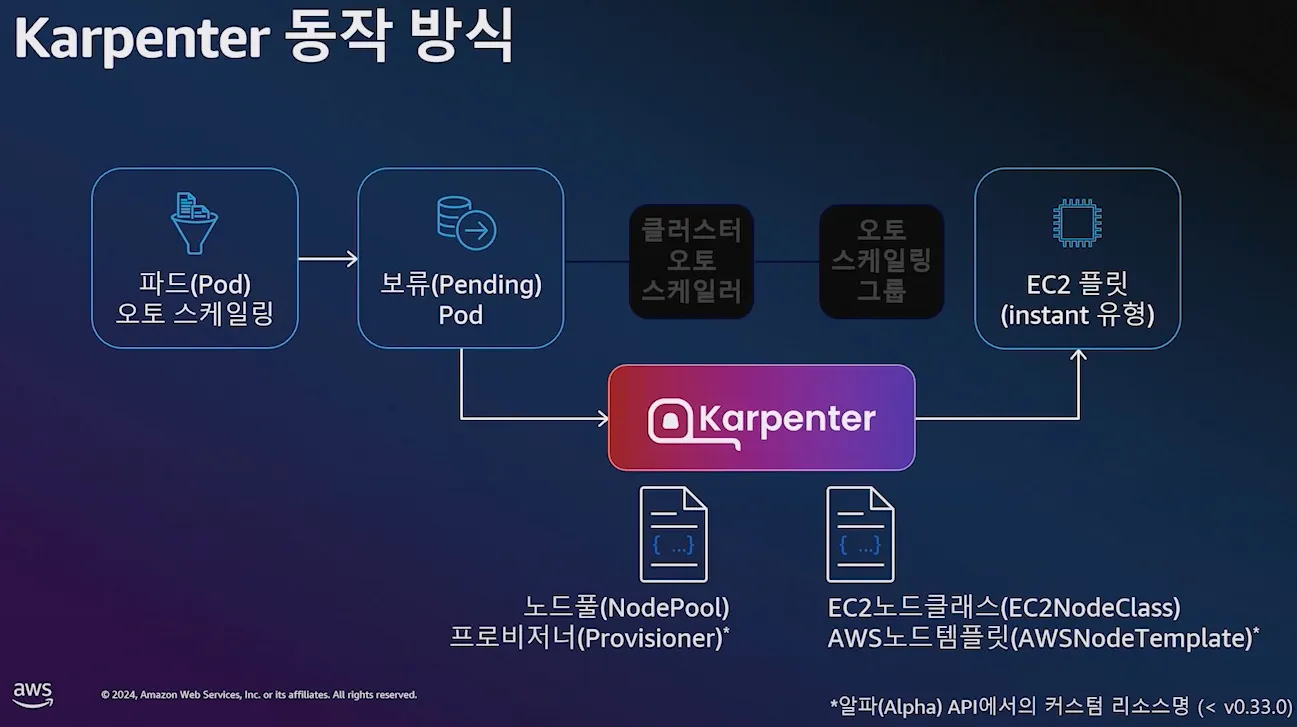

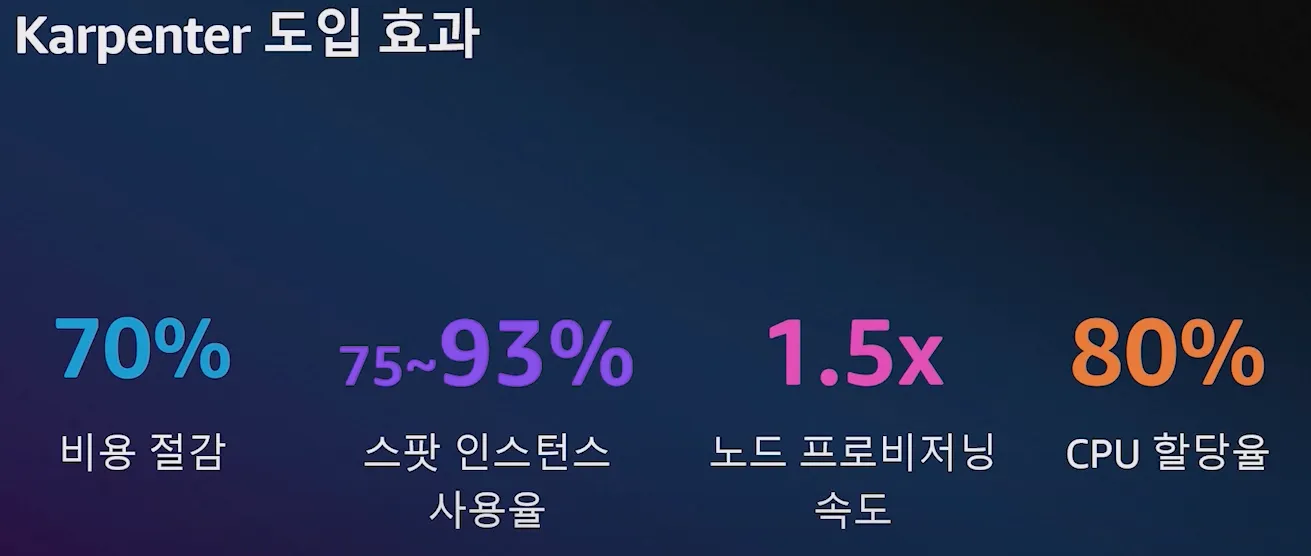

고성능의 지능형 kubernetes 컴퓨팅 프로비저닝 및 관리 솔루션, 수초 이내에 대응 가능, 더 낮은 컴퓨팅 비용으로 노드 선택

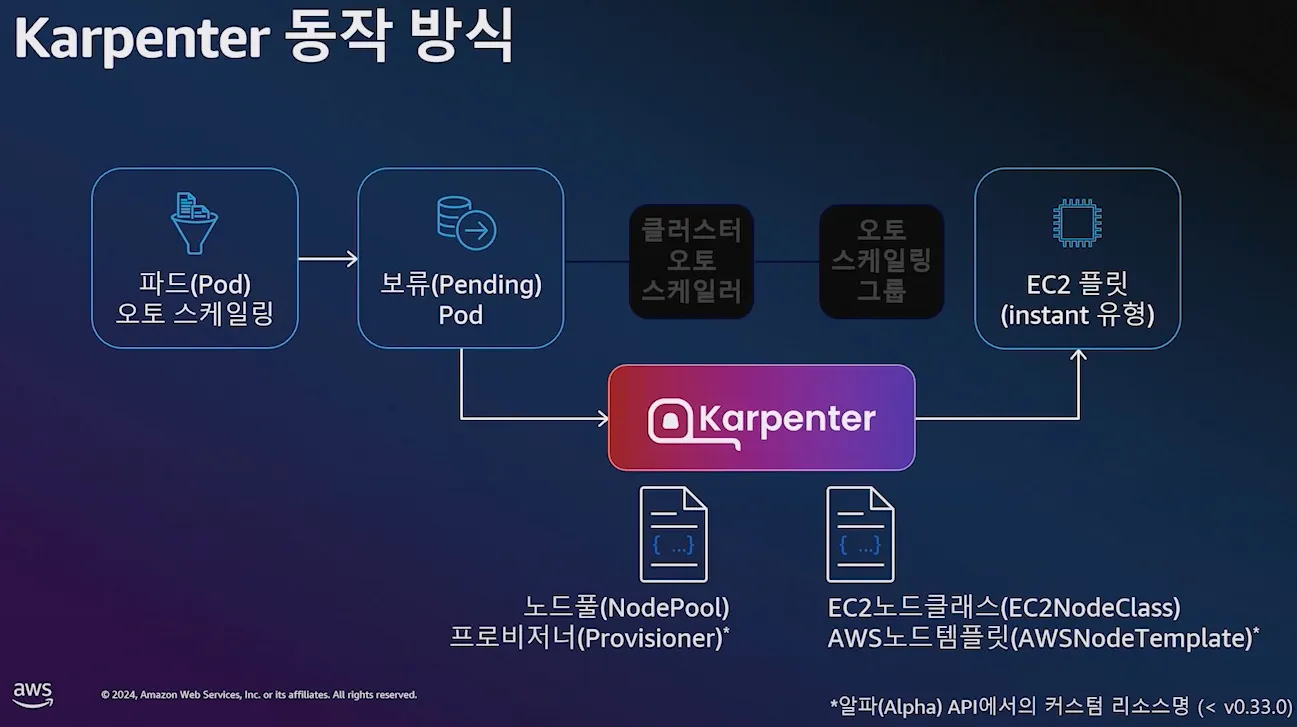

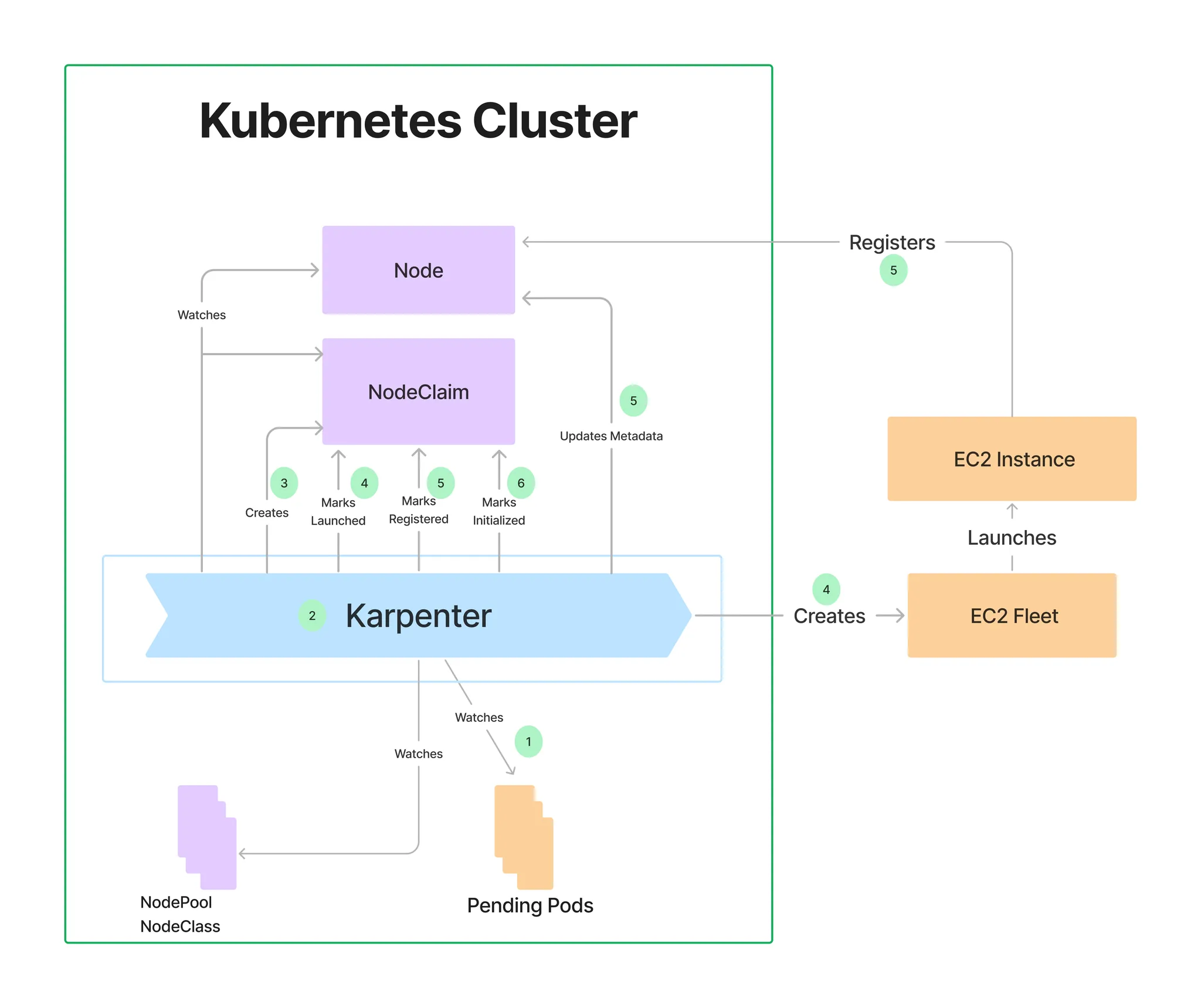

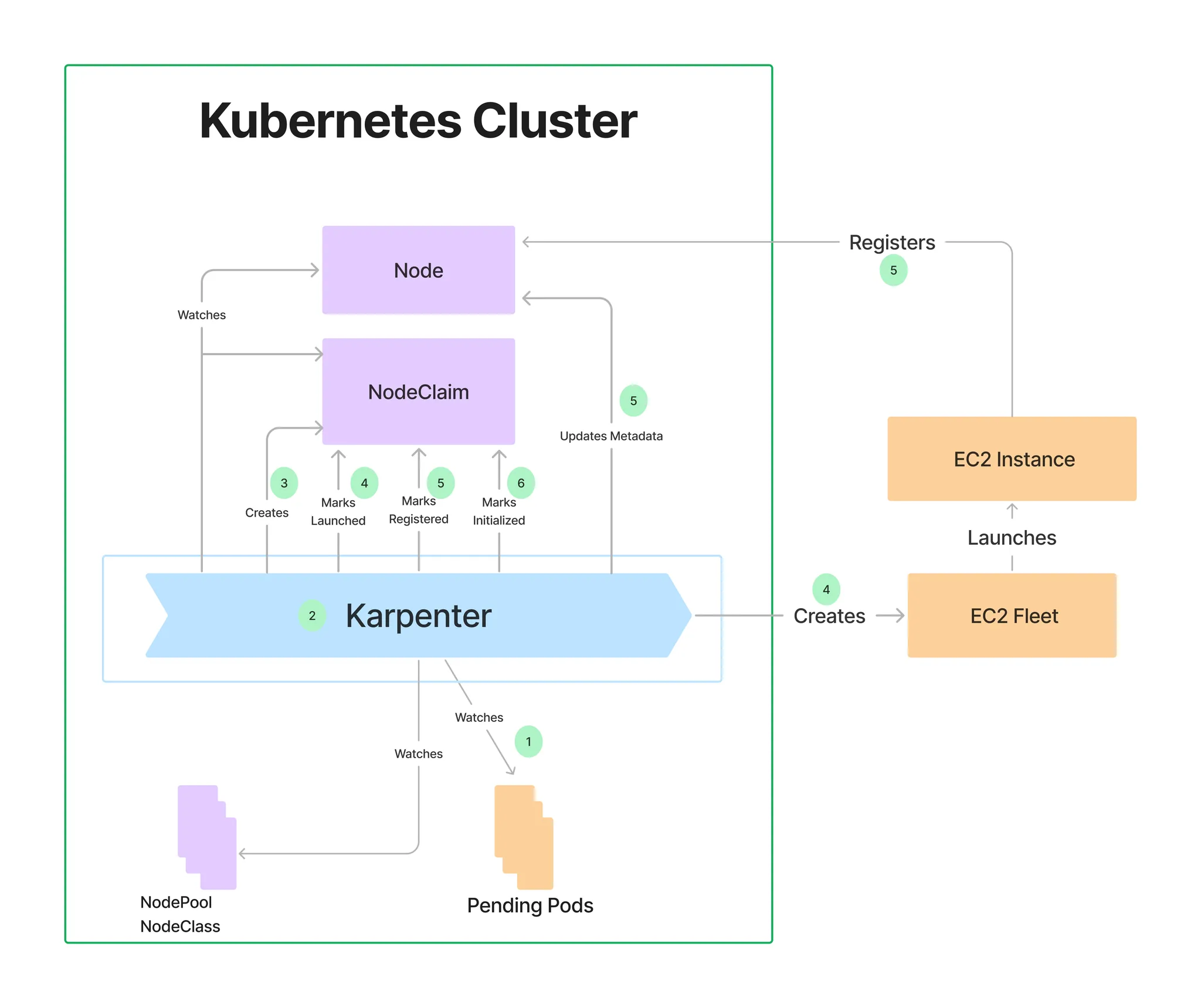

- 작동방식

모니터링 -> Pending POD 확인 -> 스펙 평가 -> 생성 => Provisioning

모니터링 -> 비어있는 노드 확인 -> 제거 => Deprovisioning

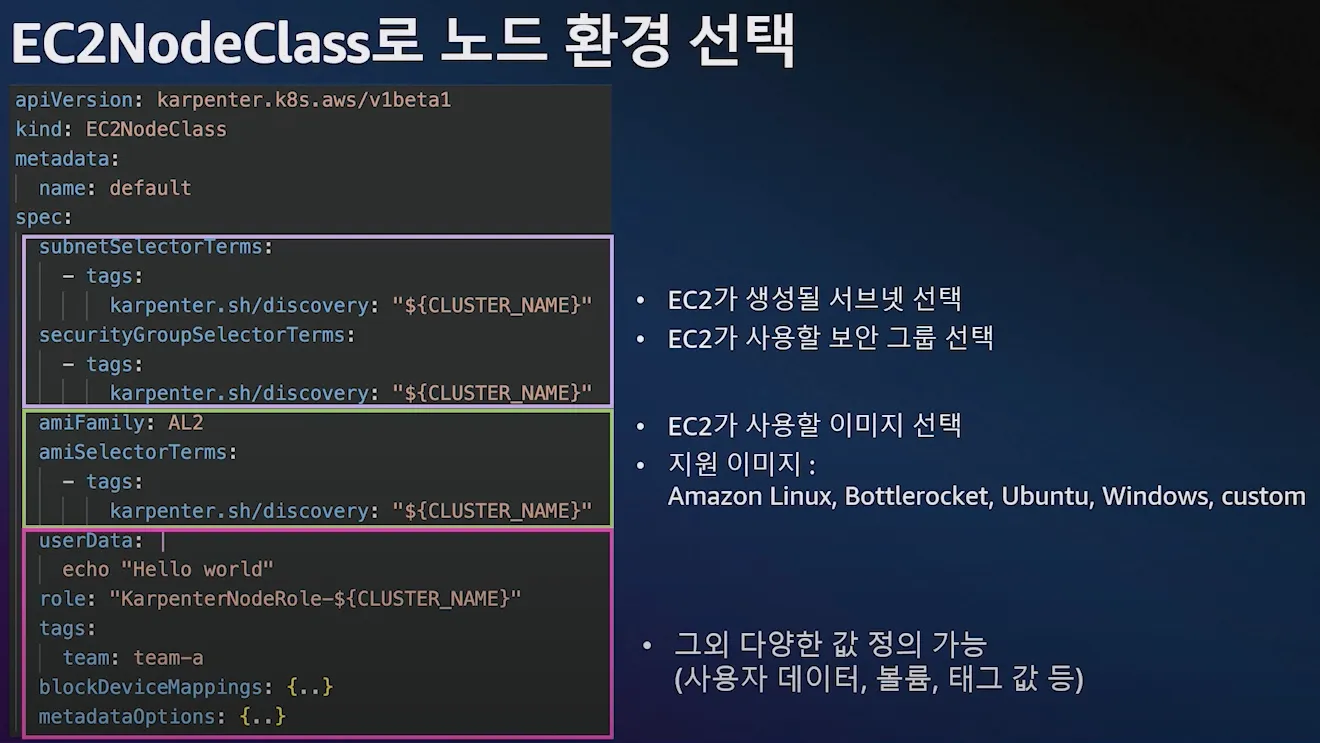

Provisioning CRD : 시작 템플릿 필요 없음

- 필수 : 보안그룹, 서브넷

- 리소스 찾는 방식 : 태그 기반, 리소스 ID 명시

- 인스턴스 타입은 가드레일 ㅂ아식으로 선언 : 스판(우선) vs 온디멘드, 다양한 인스턴스 Type 가능

1) POD에 적합한 인스턴스 중 가장 저렴한 인스턴스로 증설

2) PV를 위해 단일 서브넷에 노드 그룹을 만들 필요가 없음 -> 자동으로 PV가 존재하는 서브넷에 노드를 만듦

3) 사용하지 않는 노드를 자동으로 정리, 일정 기간이 지나면 노드를 자동으로 만료 시킬 수 있음

4) 노드를 줄여도 다른 노드에 충분한 여유가 있다면 자동으로 정리

5) 큰 노드 하나가 작은 노드 여러개 보다 비용이 저렴하다면 자동으로 합침

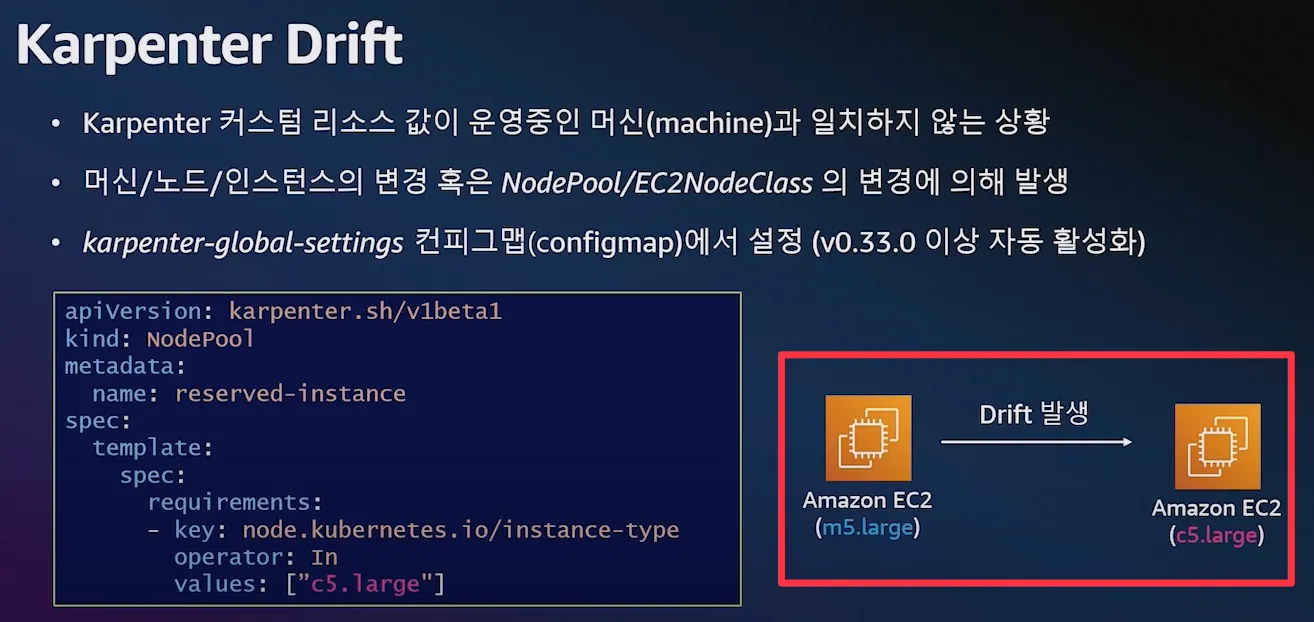

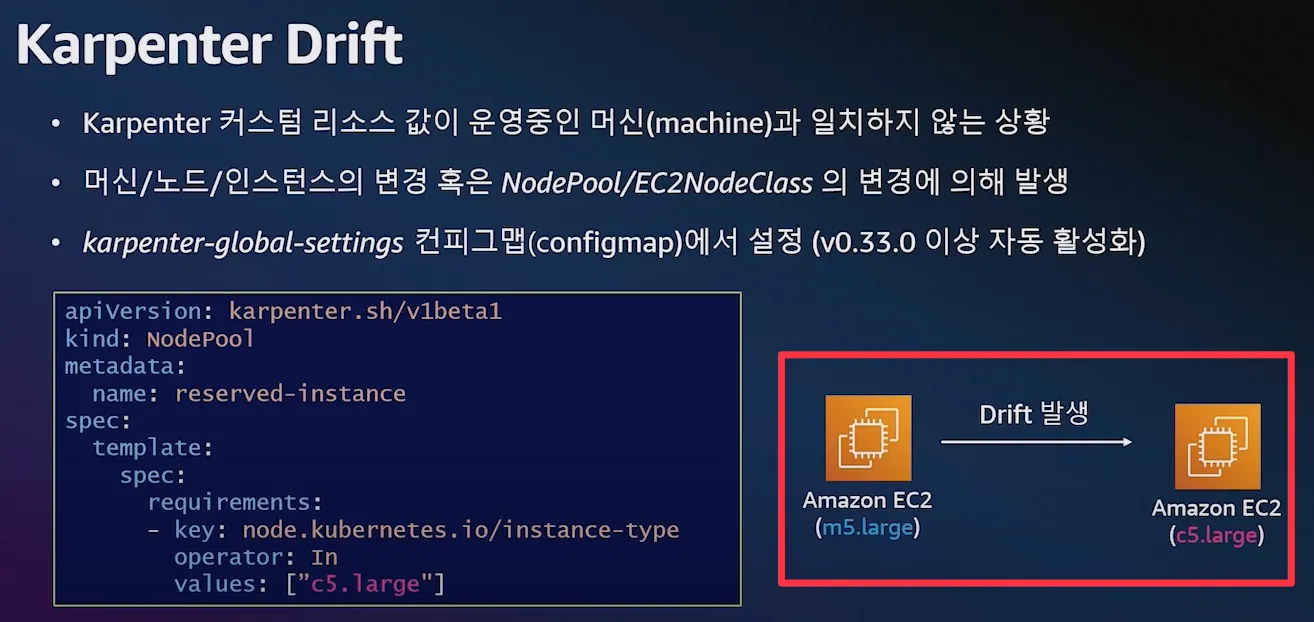

Drift : 선언한 값과 운영 머신 값이 일치하지 않을 경우 재조정

Drift 활용 : 패치 및 업그레이드

자원 생성 전 변수 설정

# 변수 설정

export KARPENTER_NAMESPACE="kube-system"

export KARPENTER_VERSION="1.2.1"

export K8S_VERSION="1.32"

export AWS_PARTITION="aws" # if you are not using standard partitions, you may need to configure to aws-cn / aws-us-gov

export CLUSTER_NAME="ssungz-karpenter-demo" # ${USER}-karpenter-demo

export AWS_DEFAULT_REGION="ap-northeast-2"

export AWS_ACCOUNT_ID="$(aws sts get-caller-identity --query Account --output text)"

export TEMPOUT="$(mktemp)"

export ALIAS_VERSION="$(aws ssm get-parameter --name "/aws/service/eks/optimized-ami/${K8S_VERSION}/amazon-linux-2023/x86_64/standard/recommended/image_id" --query Parameter.Value | xargs aws ec2 describe-images --query 'Images[0].Name' --image-ids | sed -r 's/^.*(v[[:digit:]]+).*$/\1/')"

# 확인

echo "${KARPENTER_NAMESPACE}" "${KARPENTER_VERSION}" "${K8S_VERSION}" "${CLUSTER_NAME}" "${AWS_DEFAULT_REGION}" "${AWS_ACCOUNT_ID}" "${TEMPOUT}" "${ALIAS_VERSION}"

Cluster 생성

## CloudFormation Stack으로 생성

curl -fsSL https://raw.githubusercontent.com/aws/karpenter-provider-aws/v"${KARPENTER_VERSION}"/website/content/en/preview/getting-started/getting-started-with-karpenter/cloudformation.yaml > "${TEMPOUT}" \

&& aws cloudformation deploy \

--stack-name "Karpenter-${CLUSTER_NAME}" \

--template-file "${TEMPOUT}" \

--capabilities CAPABILITY_NAMED_IAM \

--parameter-overrides "ClusterName=${CLUSTER_NAME}"

## 클러스터 생성 : EKS 클러스터 생성 15분 정도 소요

eksctl create cluster -f - <<EOF

---

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: ${CLUSTER_NAME}

region: ${AWS_DEFAULT_REGION}

version: "${K8S_VERSION}"

tags:

karpenter.sh/discovery: ${CLUSTER_NAME}

iam:

withOIDC: true

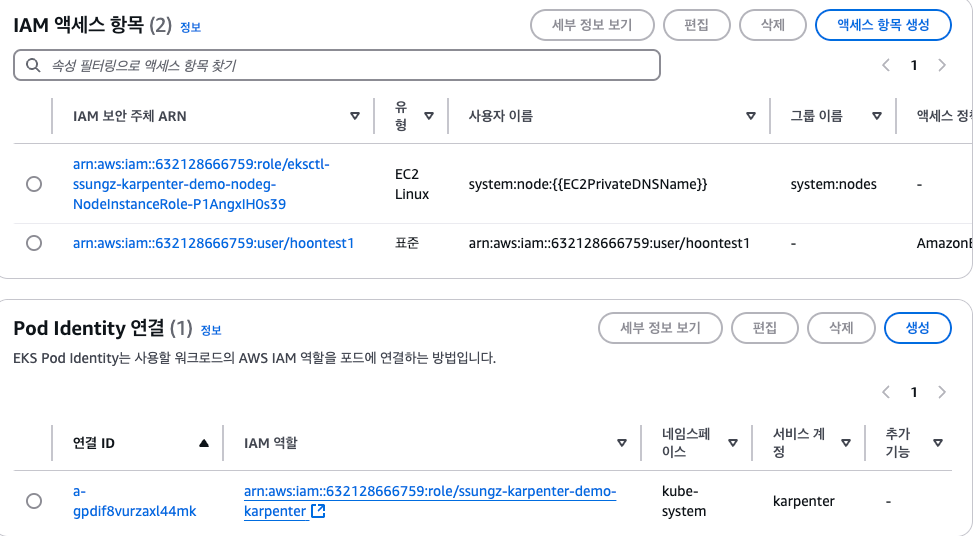

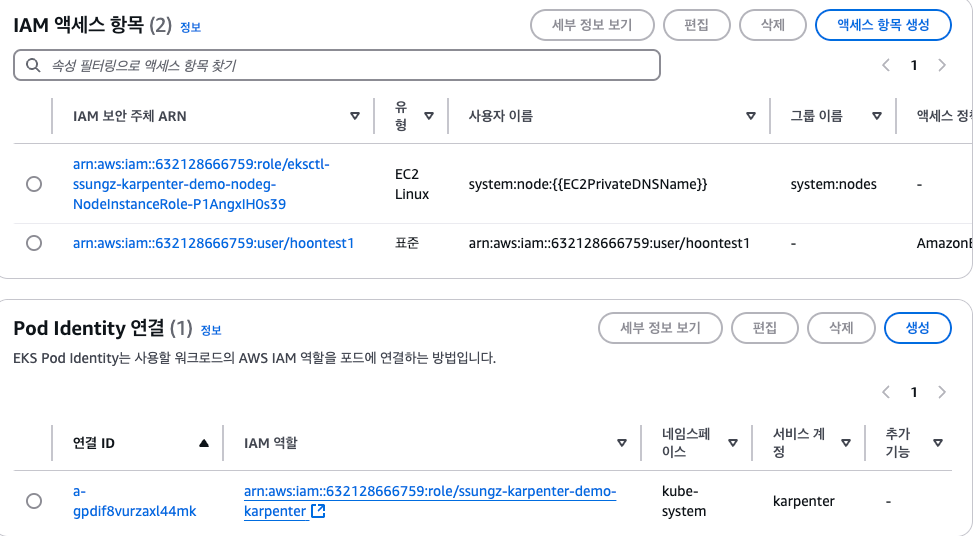

podIdentityAssociations:

- namespace: "${KARPENTER_NAMESPACE}"

serviceAccountName: karpenter

roleName: ${CLUSTER_NAME}-karpenter

permissionPolicyARNs:

- arn:${AWS_PARTITION}:iam::${AWS_ACCOUNT_ID}:policy/KarpenterControllerPolicy-${CLUSTER_NAME}

iamIdentityMappings:

- arn: "arn:${AWS_PARTITION}:iam::${AWS_ACCOUNT_ID}:role/KarpenterNodeRole-${CLUSTER_NAME}"

username: system:node:{{EC2PrivateDNSName}}

groups:

- system:bootstrappers

- system:nodes

## If you intend to run Windows workloads, the kube-proxy group should be specified.

# For more information, see https://github.com/aws/karpenter/issues/5099.

# - eks:kube-proxy-windows

managedNodeGroups:

- instanceType: m5.large

amiFamily: AmazonLinux2023

name: ${CLUSTER_NAME}-ng

desiredCapacity: 2

minSize: 1

maxSize: 10

iam:

withAddonPolicies:

externalDNS: true

addons:

- name: eks-pod-identity-agent

EOF

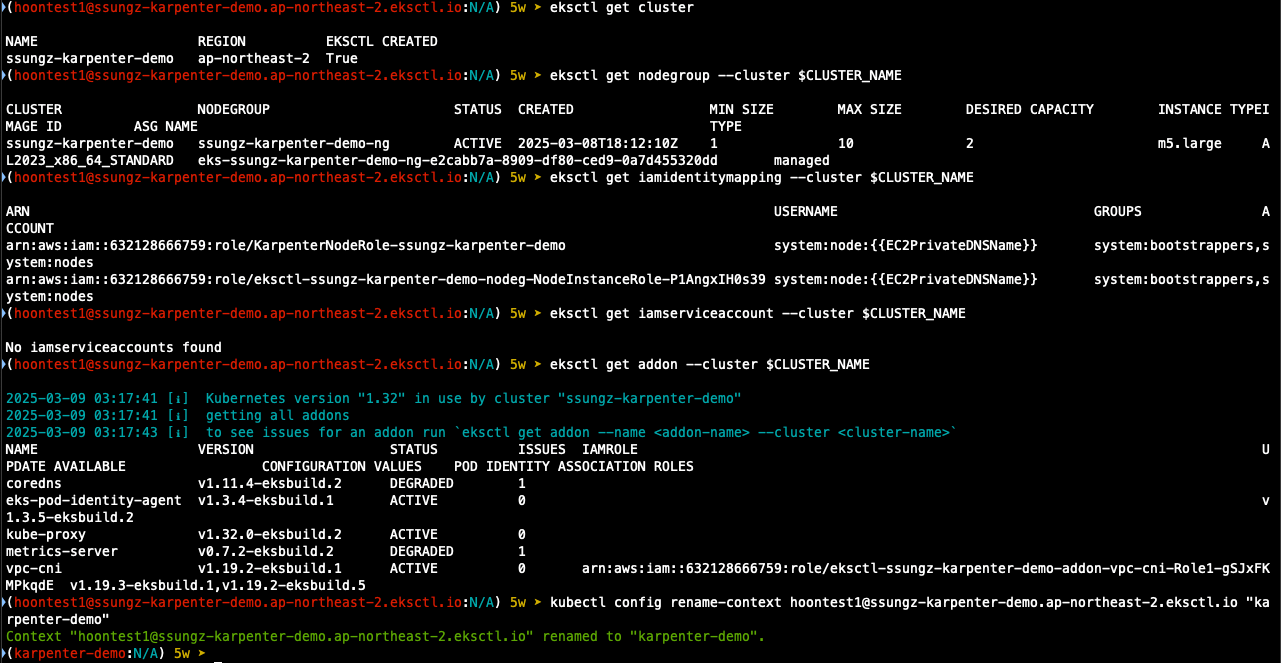

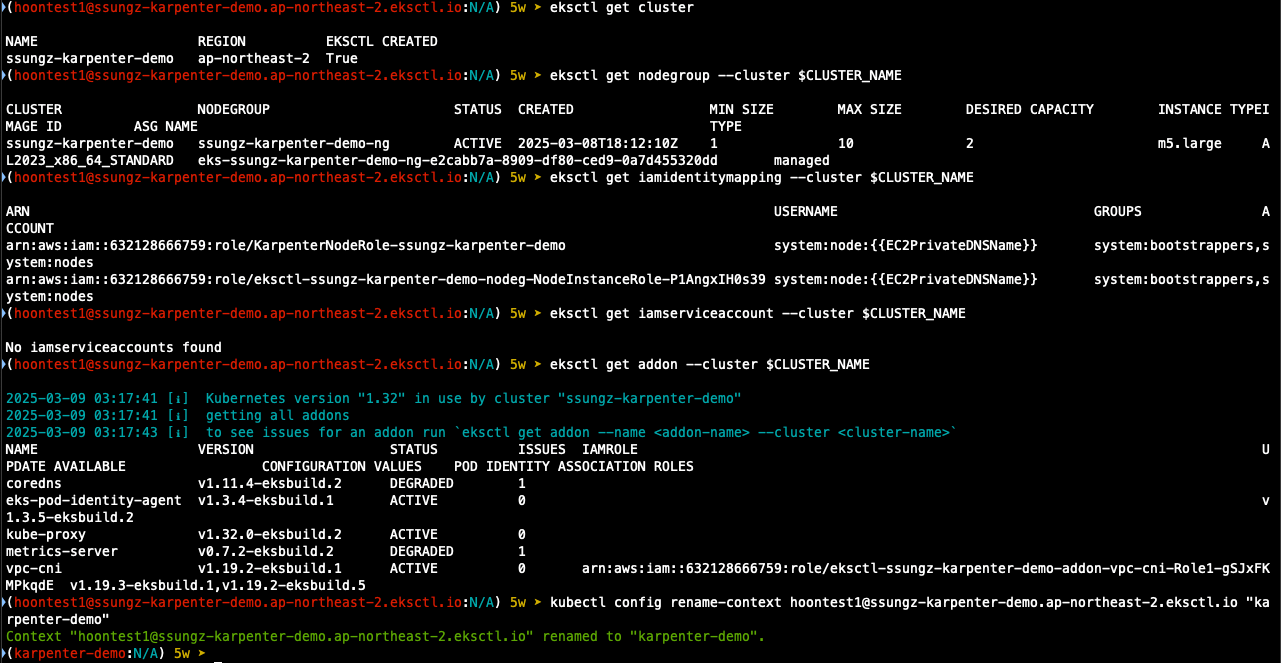

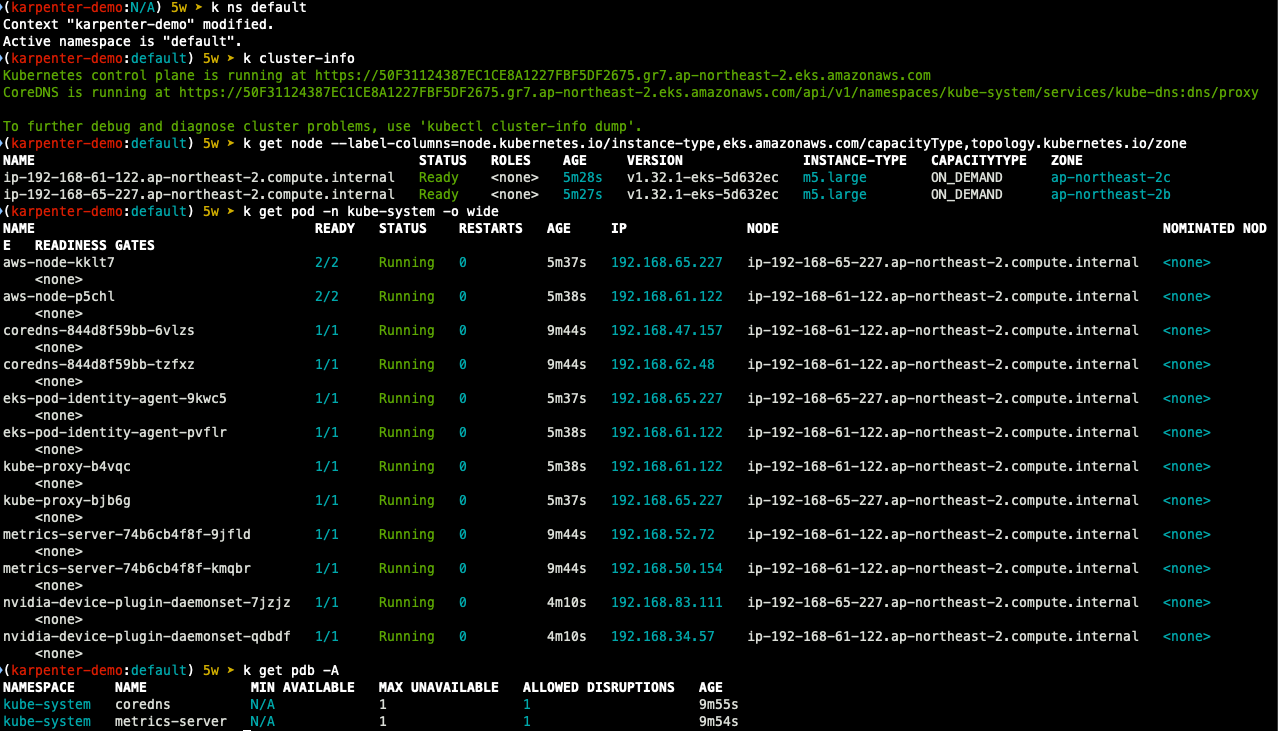

Cluster 생성 확인

## eks 배포 확인

eksctl get cluster

eksctl get nodegroup --cluster $CLUSTER_NAME

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

eksctl get addon --cluster $CLUSTER_NAME

## Context rename

kubectl ctx

kubectl config rename-context "<각자 자신의 IAM User>@<자신의 Nickname>-karpenter-demo.ap-northeast-2.eksctl.io" "karpenter-demo"

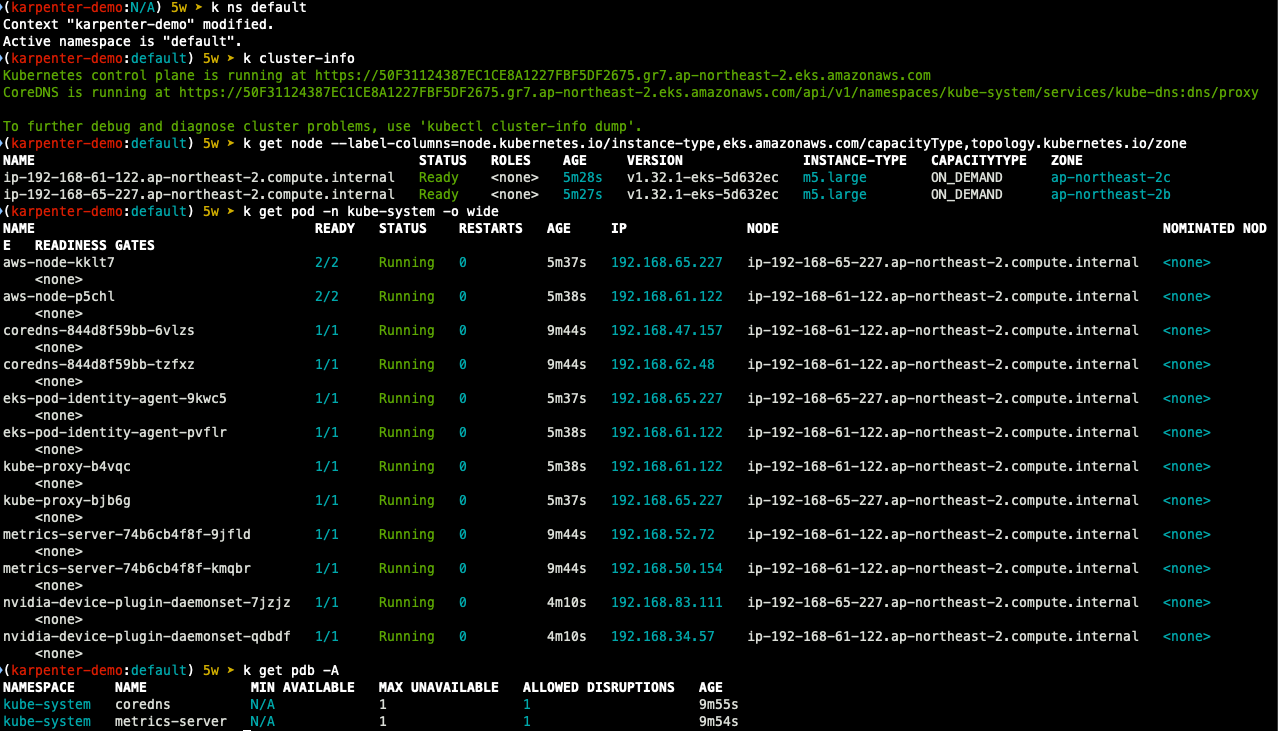

## kubernetes 확인

kubectl ns default

kubectl cluster-info

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get pod -n kube-system -owide

kubectl get pdb -A

kubectl describe cm -n kube-system aws-auth

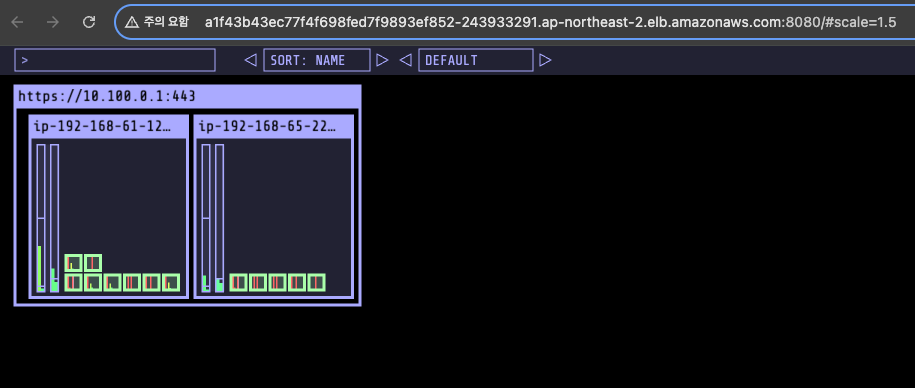

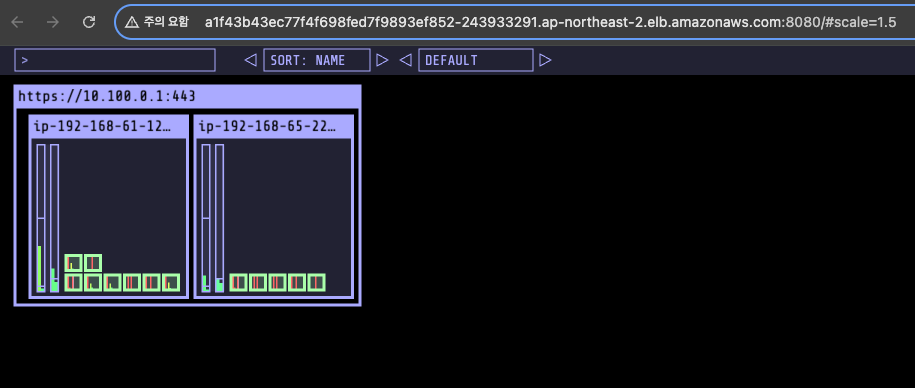

## kube-ops-view install

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=LoadBalancer --set env.TZ="Asia/Seoul" --namespace kube-system

echo -e "http://$(kubectl get svc -n kube-system kube-ops-view -o jsonpath="{.status.loadBalancer.ingress[0].hostname}"):8080/#scale=1.5"

open "http://$(kubectl get svc -n kube-system kube-ops-view -o jsonpath="{.status.loadBalancer.ingress[0].hostname}"):8080/#scale=1.5"

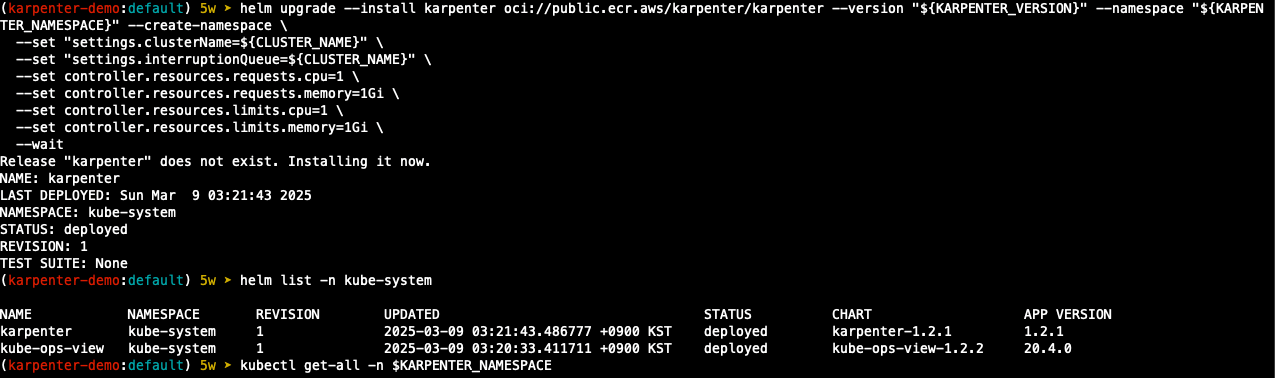

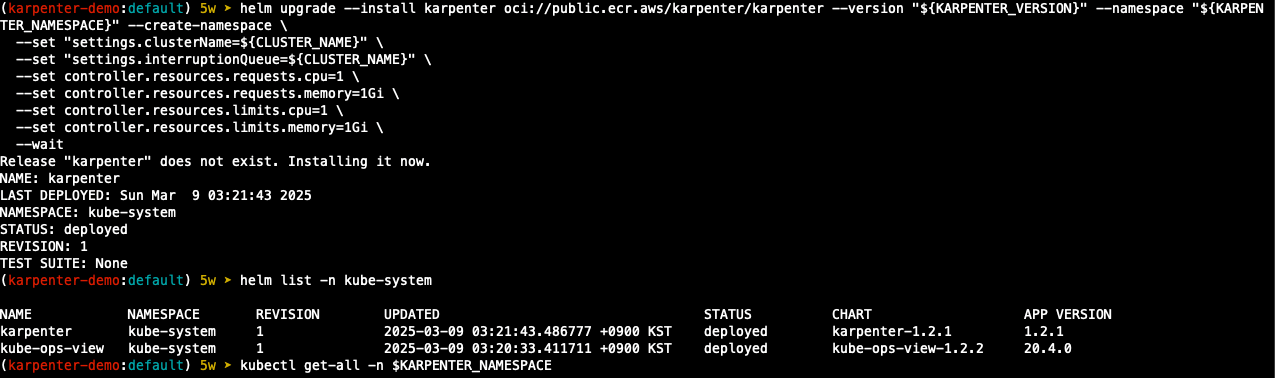

Karpenter 설치

helm registry logout public.ecr.aws

## Karpenter 설치를 위한 변수 설정 및 확인

export CLUSTER_ENDPOINT="$(aws eks describe-cluster --name "${CLUSTER_NAME}" --query "cluster.endpoint" --output text)"

export KARPENTER_IAM_ROLE_ARN="arn:${AWS_PARTITION}:iam::${AWS_ACCOUNT_ID}:role/${CLUSTER_NAME}-karpenter"

echo "${CLUSTER_ENDPOINT} ${KARPENTER_IAM_ROLE_ARN}"

## karpenter 설치

helm upgrade --install karpenter oci://public.ecr.aws/karpenter/karpenter --version "${KARPENTER_VERSION}" --namespace "${KARPENTER_NAMESPACE}" --create-namespace \

--set "settings.clusterName=${CLUSTER_NAME}" \

--set "settings.interruptionQueue=${CLUSTER_NAME}" \

--set controller.resources.requests.cpu=1 \

--set controller.resources.requests.memory=1Gi \

--set controller.resources.limits.cpu=1 \

--set controller.resources.limits.memory=1Gi \

--wait

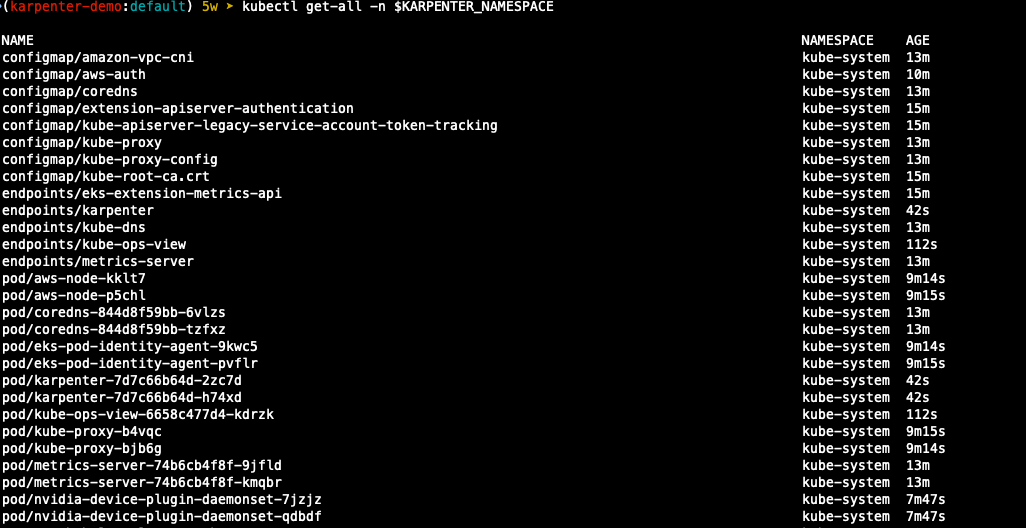

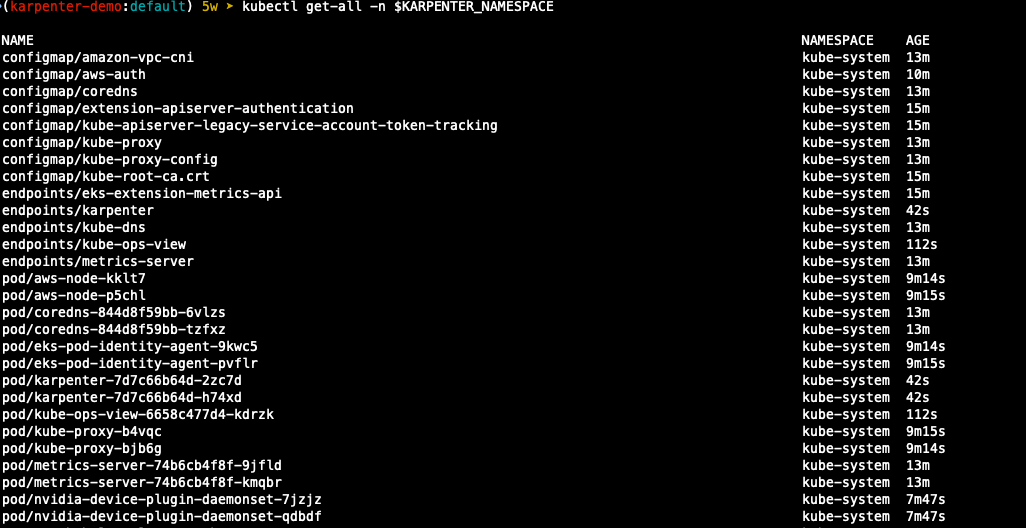

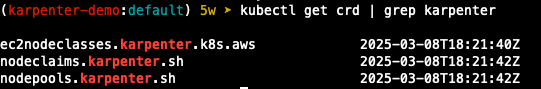

## 확인

helm list -n kube-system

kubectl get-all -n $KARPENTER_NAMESPACE

kubectl get all -n $KARPENTER_NAMESPACE

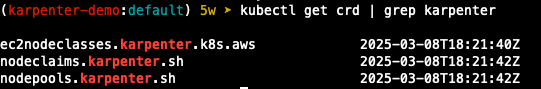

kubectl get crd | grep karpenter

- karpenter는 clusterfirst 기본적으로 pod dns 정책을 사용. karpenter가 dns 서비스 pod의 용량을 관리해야 하는 경우 karpenter가 시작될 때 dns가 실행되지 않음을 의미하며, 이 경우 dns 정책을 default with로 설정해야함.

--set dnsPolicy=Default 이렇게 설정하면 karpenter가 내부 dns 확인 대신 호스트 dns 확인을 사용하기 때문에 dns 서비스 pod 에 대한 종속성이 없어지게함

- karpenter는 노드 용량 추적을 ㅜ이해 클러스터의 CloudProvider 머신과 Customresources 간의 매핑을 만들며, 이 매핑이 일관되도록 하기 위해 karpenter는 다음 태그 키를 활용

1) karpenter.sh/managed-by

2) karpenter.sh/nodepool

3) kubernetes.io/cluster/${CLUSTER_NAME}

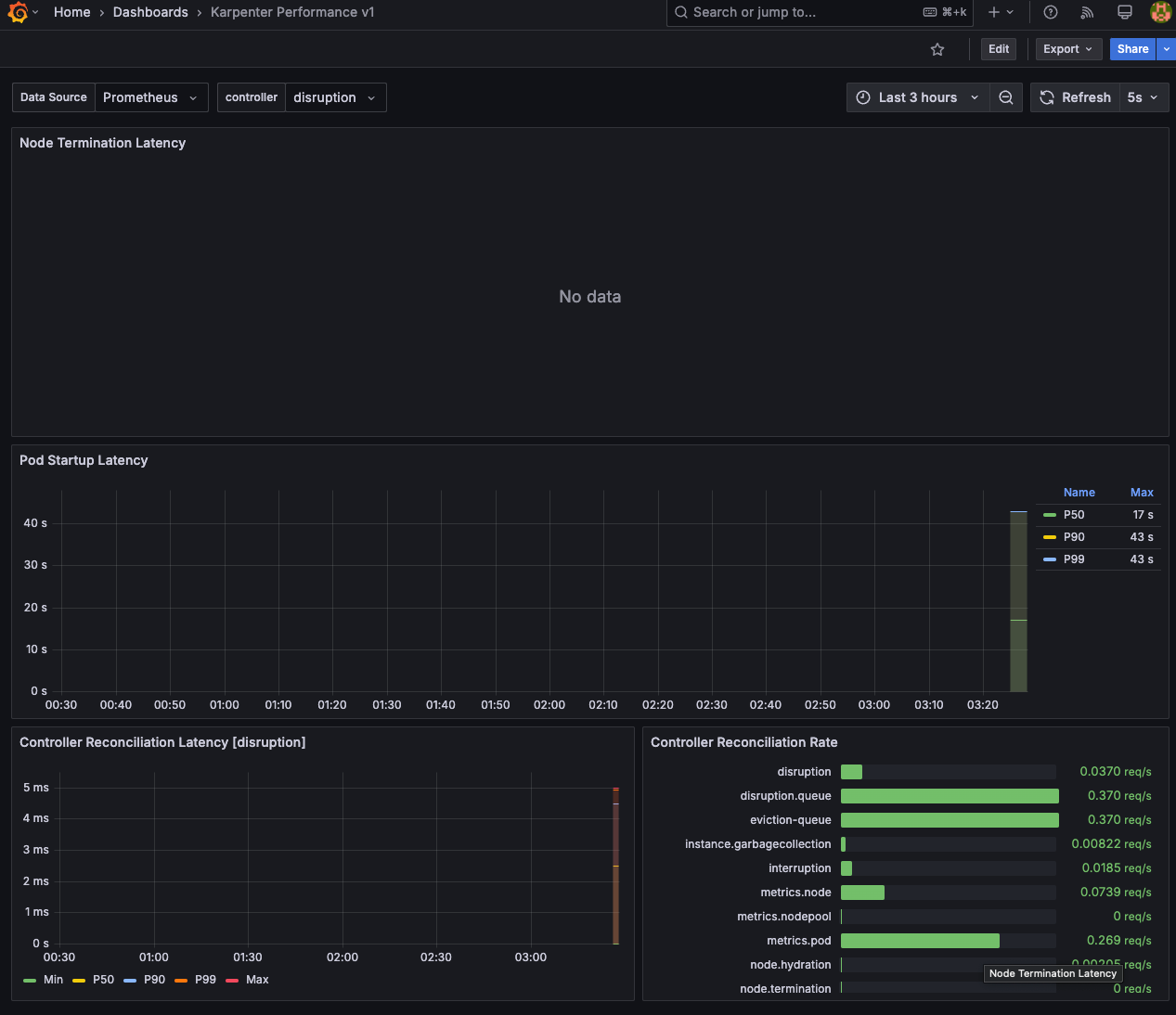

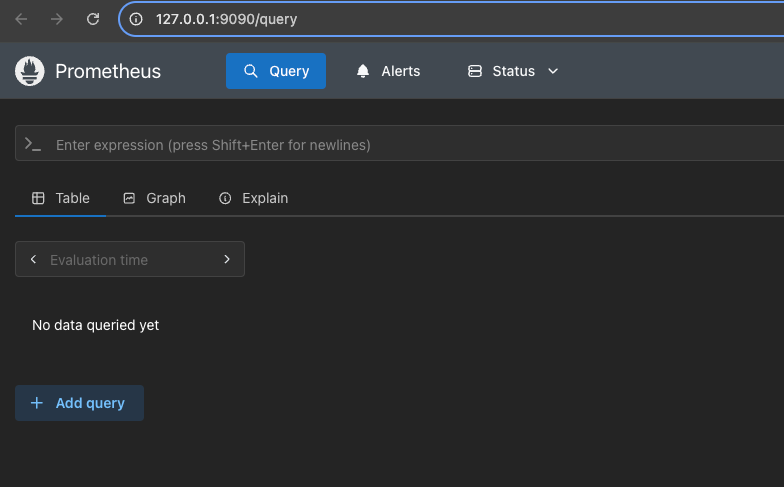

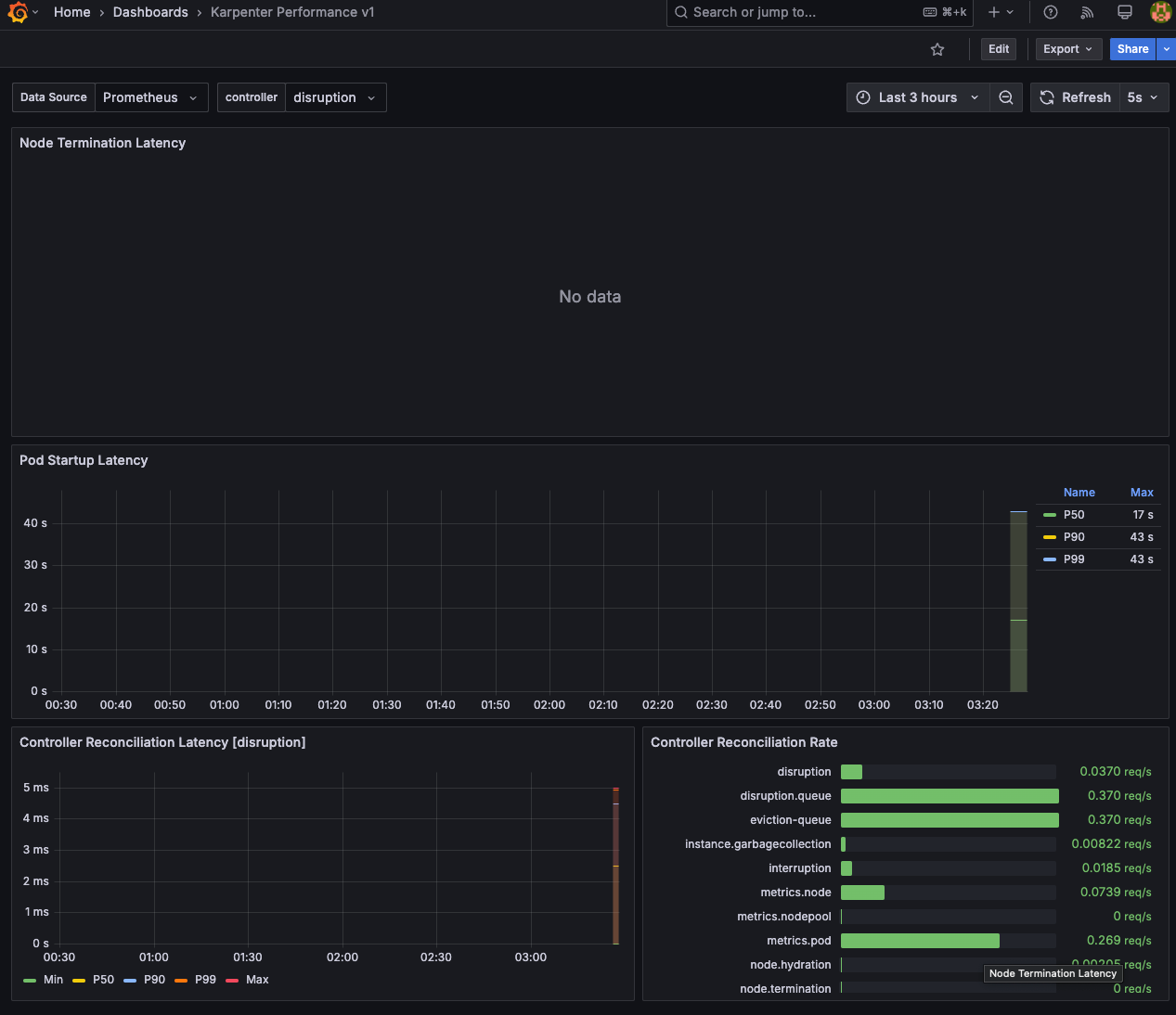

Prometheus / Grafana 설치

#

helm repo add grafana-charts https://grafana.github.io/helm-charts

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

helm repo update

kubectl create namespace monitoring

# 프로메테우스 설치

curl -fsSL https://raw.githubusercontent.com/aws/karpenter-provider-aws/v"${KARPENTER_VERSION}"/website/content/en/preview/getting-started/getting-started-with-karpenter/prometheus-values.yaml | envsubst | tee prometheus-values.yaml

helm install --namespace monitoring prometheus prometheus-community/prometheus --values prometheus-values.yaml

# 프로메테우스 얼럿매니저 미사용으로 삭제

kubectl delete sts -n monitoring prometheus-alertmanager

# 프로메테우스 접속 설정

export POD_NAME=$(kubectl get pods --namespace monitoring -l "app.kubernetes.io/name=prometheus,app.kubernetes.io/instance=prometheus" -o jsonpath="{.items[0].metadata.name}")

kubectl --namespace monitoring port-forward $POD_NAME 9090 &

open http://127.0.0.1:9090

# 그라파나 설치

curl -fsSL https://raw.githubusercontent.com/aws/karpenter-provider-aws/v"${KARPENTER_VERSION}"/website/content/en/preview/getting-started/getting-started-with-karpenter/grafana-values.yaml | tee grafana-values.yaml

helm install --namespace monitoring grafana grafana-charts/grafana --values grafana-values.yaml

# admin 암호

kubectl get secret --namespace monitoring grafana -o jsonpath="{.data.admin-password}" | base64 --decode ; echo

17JUGSjgxK20m4NEnAaG7GzyBjqAMHMFxRnXItLj

# 그라파나 접속

kubectl port-forward --namespace monitoring svc/grafana 3000:80 &

open http://127.0.0.1:3000

Create NodePool

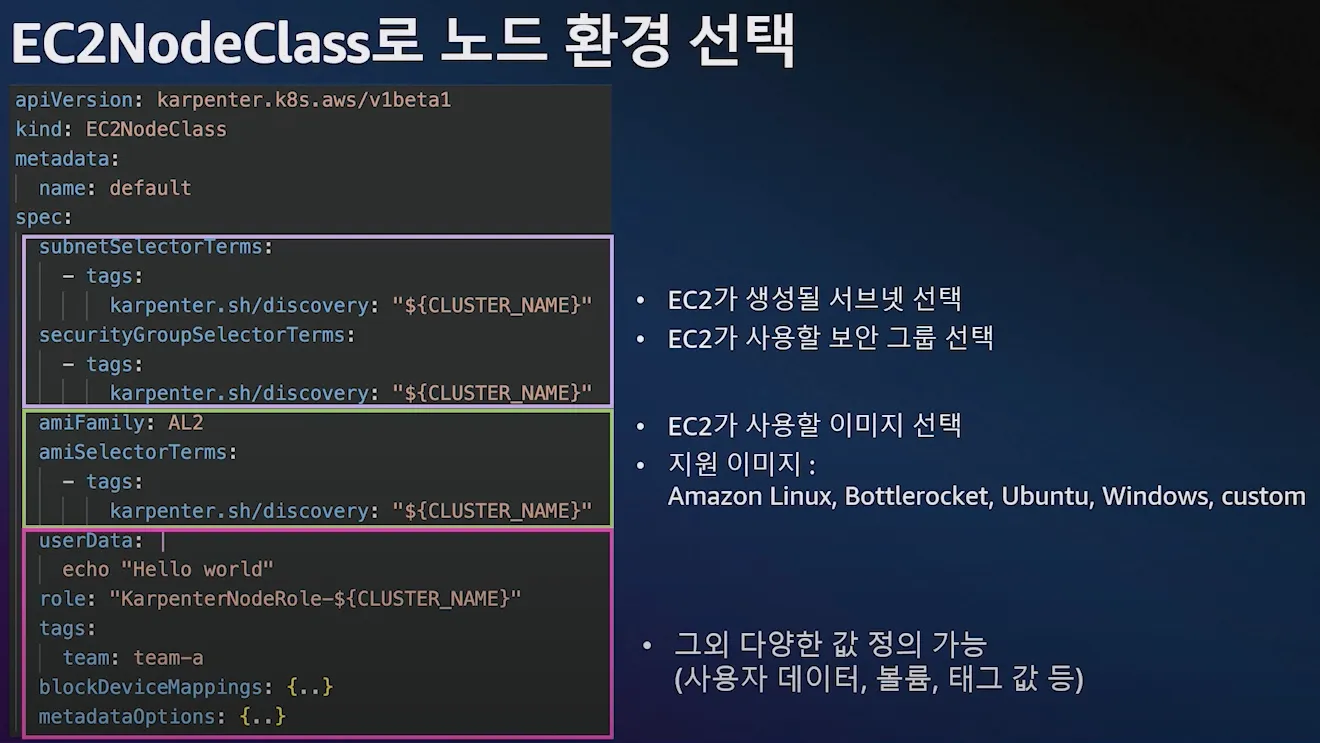

- 관리 리소스는 securityGroupSelector and subnetSelector로 찾음

- consolidationPolicy: 미사용 노드 정리 정책, 데몬셋 제외

- 단일 karpenter nodepool은 여러 다른 파드 모양을 처리할 수 있으며, karpenter는 레이블 및 친화성과 같은 포드속성을 기반으로 스케줄링 및 프로비저닝 결정을 내린다. 즉, karpenter는 여러 다른 노드 그룹을 관리할 필요성을 제거함.

- consolidationPolicy는 karpenter가 노드를 제거하고 교체하여 클러스터 비용을 줄이도록 구성, 결과적으로 통합은 클러스터의 모든 빈 노드를 종료함

## 변수 설정

echo $ALIAS_VERSION

v20250228

## Nodepool 생성

cat <<EOF | envsubst | kubectl apply -f -

apiVersion: karpenter.sh/v1

kind: NodePool

metadata:

name: default

spec:

template:

spec:

requirements:

- key: kubernetes.io/arch

operator: In

values: ["amd64"]

- key: kubernetes.io/os

operator: In

values: ["linux"]

- key: karpenter.sh/capacity-type

operator: In

values: ["on-demand"]

- key: karpenter.k8s.aws/instance-category

operator: In

values: ["c", "m", "r"]

- key: karpenter.k8s.aws/instance-generation

operator: Gt

values: ["2"]

nodeClassRef:

group: karpenter.k8s.aws

kind: EC2NodeClass

name: default

expireAfter: 720h # 30 * 24h = 720h

limits:

cpu: 1000

disruption:

consolidationPolicy: WhenEmptyOrUnderutilized

consolidateAfter: 1m

---

apiVersion: karpenter.k8s.aws/v1

kind: EC2NodeClass

metadata:

name: default

spec:

role: "KarpenterNodeRole-${CLUSTER_NAME}" # replace with your cluster name

amiSelectorTerms:

- alias: "al2023@${ALIAS_VERSION}" # ex) al2023@latest

subnetSelectorTerms:

- tags:

karpenter.sh/discovery: "${CLUSTER_NAME}" # replace with your cluster name

securityGroupSelectorTerms:

- tags:

karpenter.sh/discovery: "${CLUSTER_NAME}" # replace with your cluster name

EOF

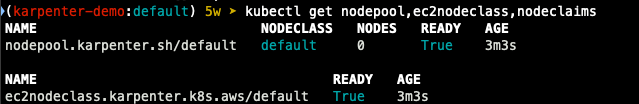

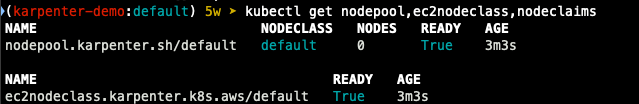

# 확인

kubectl get nodepool,ec2nodeclass,nodeclaims

Scale up Deployment

## pause 파드 1개에 CPU 1개 최소 보장 할당할 수 있게 디플로이먼트 배포

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: inflate

spec:

replicas: 0

selector:

matchLabels:

app: inflate

template:

metadata:

labels:

app: inflate

spec:

terminationGracePeriodSeconds: 0

securityContext:

runAsUser: 1000

runAsGroup: 3000

fsGroup: 2000

containers:

- name: inflate

image: public.ecr.aws/eks-distro/kubernetes/pause:3.7

resources:

requests:

cpu: 1

securityContext:

allowPrivilegeEscalation: false

EOF

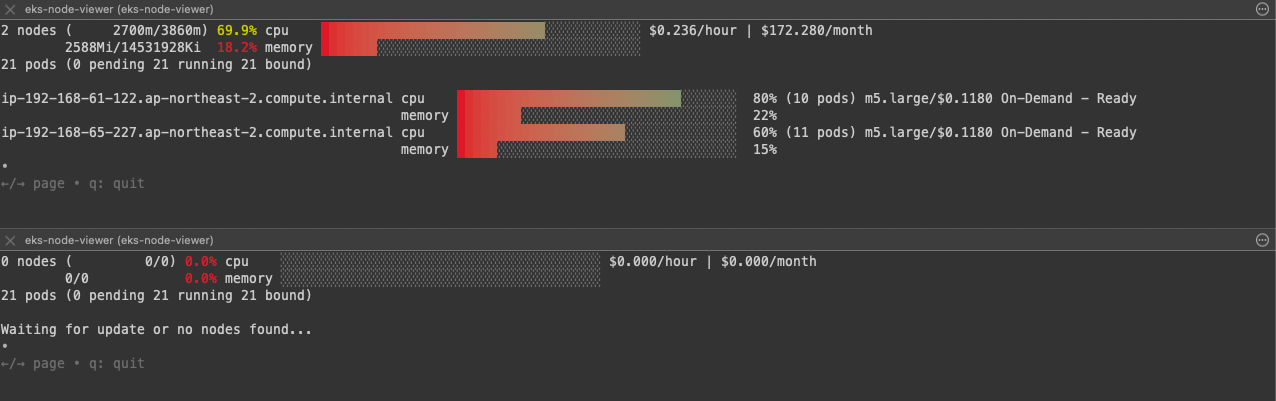

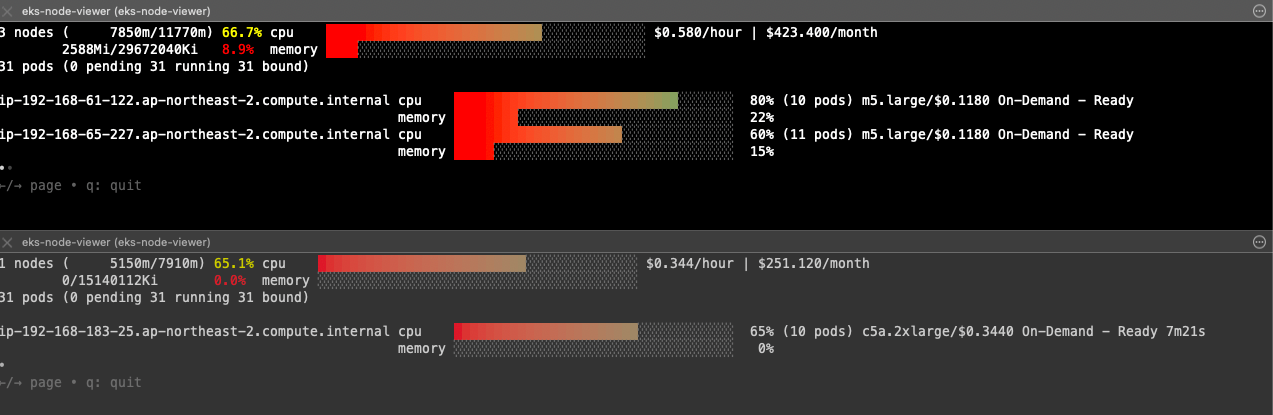

## [신규 터미널] 모니터링

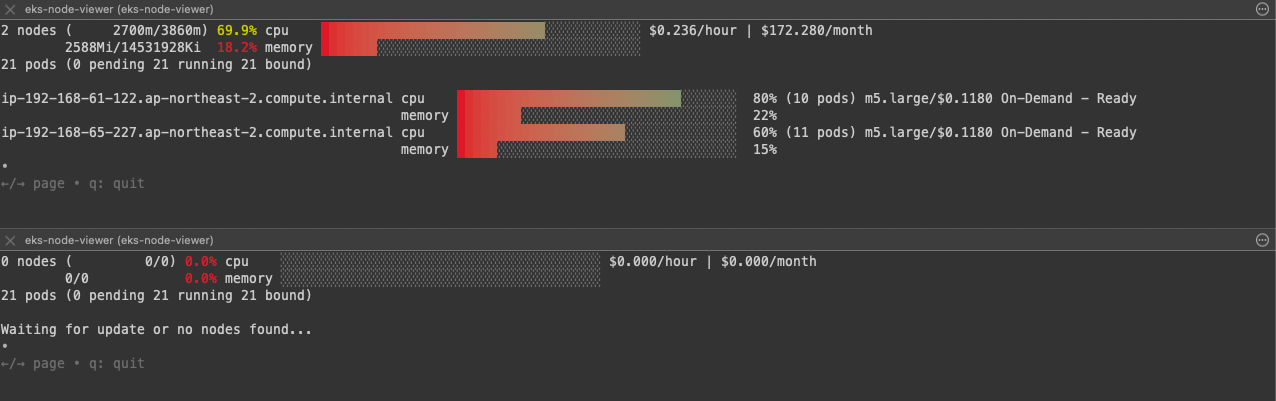

eks-node-viewer --resources cpu,memory

eks-node-viewer --resources cpu,memory --node-selector "karpenter.sh/registered=true" --extra-labels eks-node-viewer/node-age

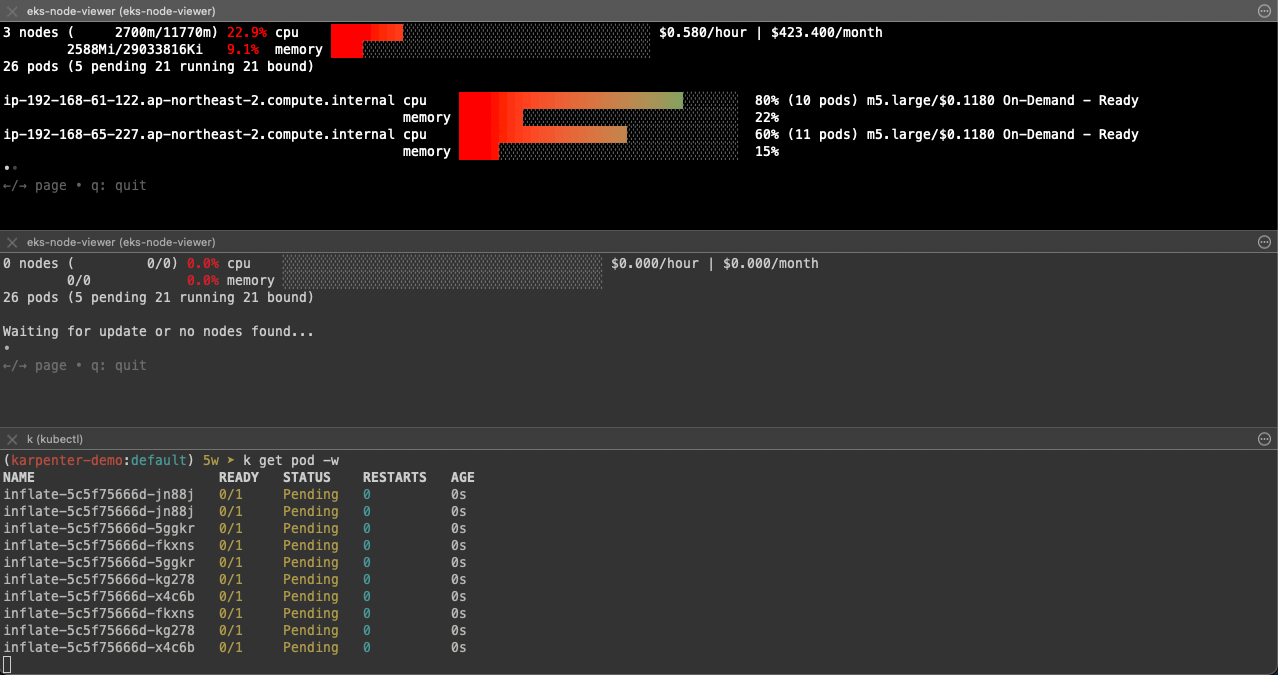

## Scale up

kubectl get pod

kubectl scale deployment inflate --replicas 5

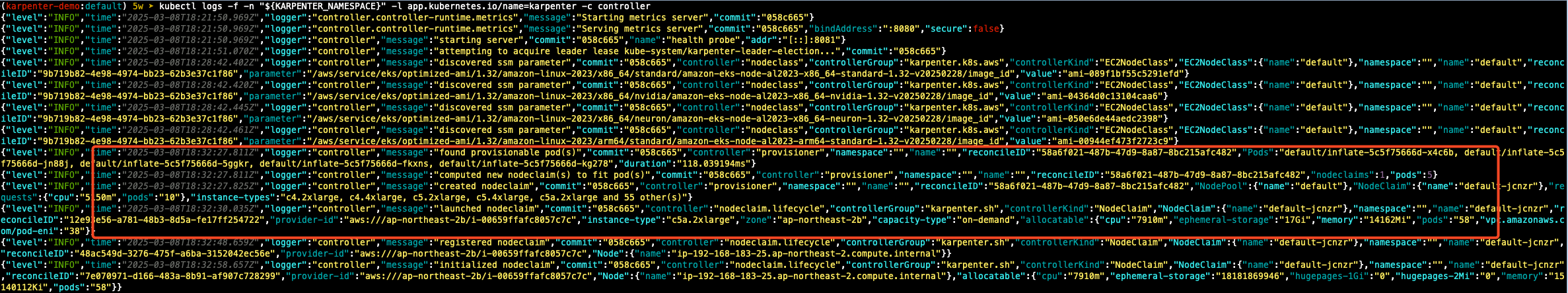

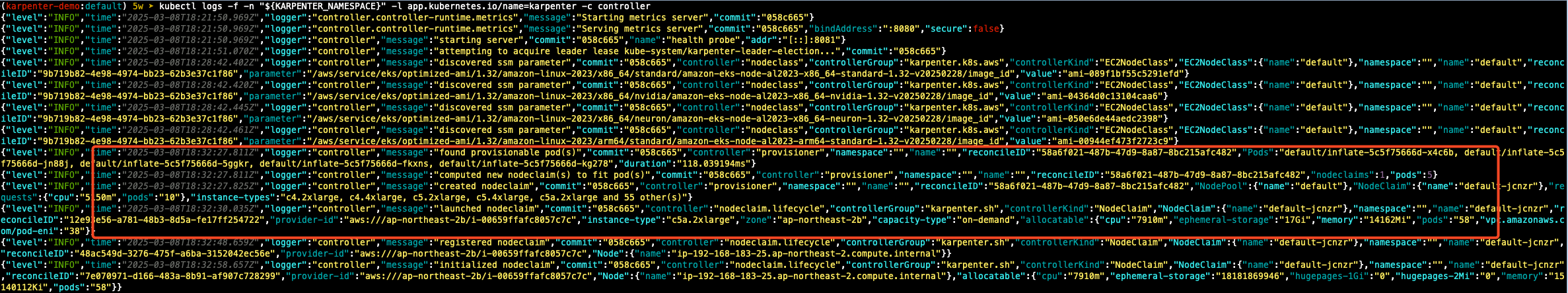

## 출력 로그 분석해보자!

kubectl logs -f -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller

kubectl logs -f -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller | jq '.'

kubectl logs -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller | grep 'launched nodeclaim' | jq '.'

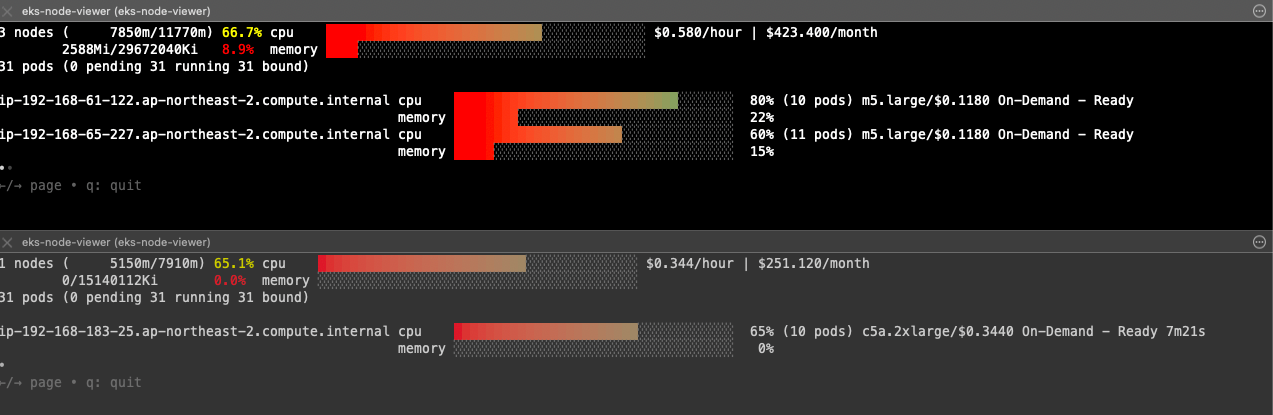

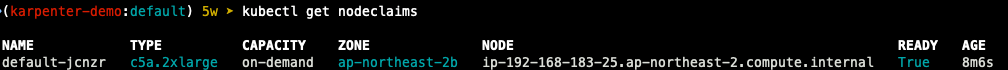

## 확인

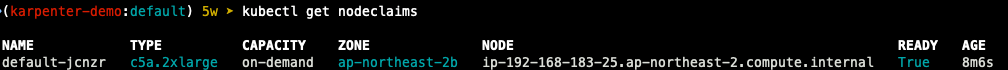

kubectl get nodeclaims

NAME TYPE CAPACITY ZONE NODE READY AGE

default-8f5vd c5a.2xlarge on-demand ap-northeast-2c ip-192-168-176-171.ap-northeast-2.compute.internal True 79s

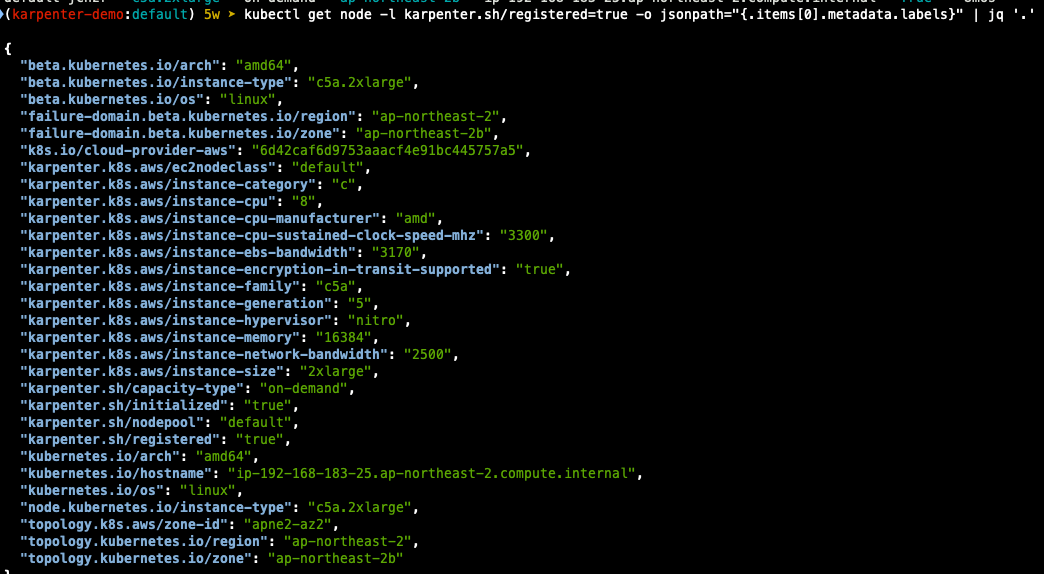

kubectl describe nodeclaims

#

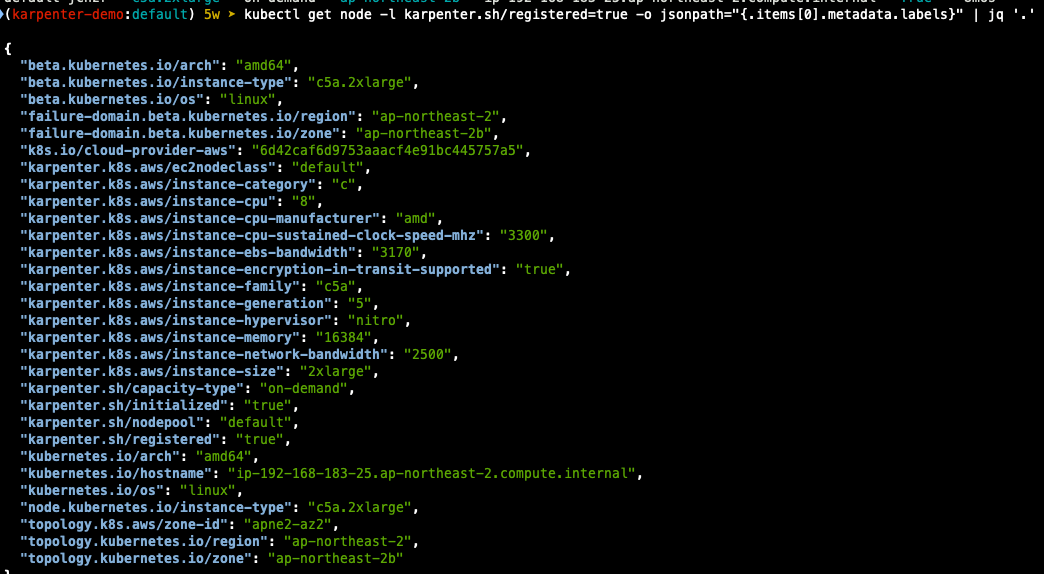

kubectl get node -l karpenter.sh/registered=true -o jsonpath="{.items[0].metadata.labels}" | jq '.'

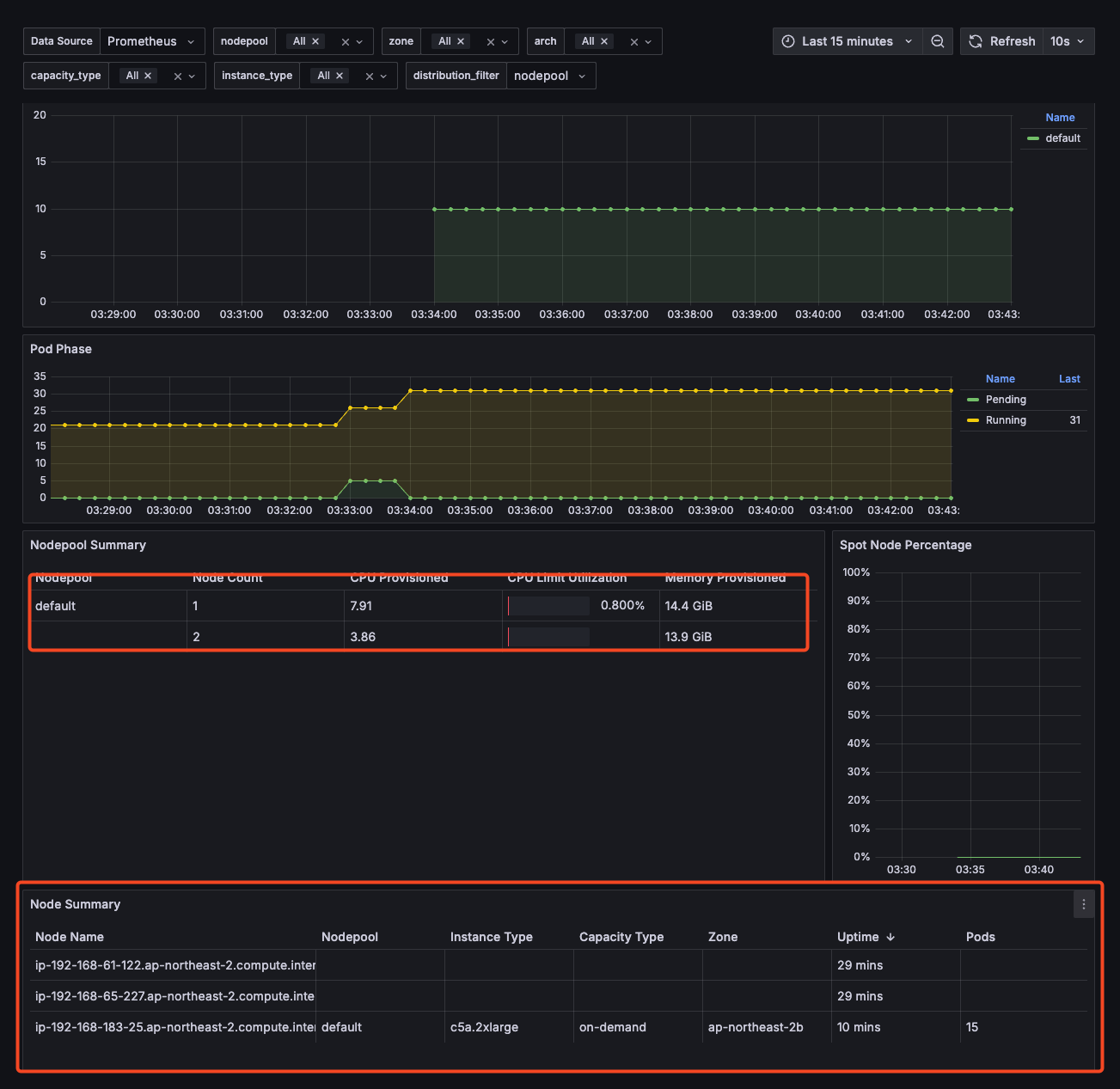

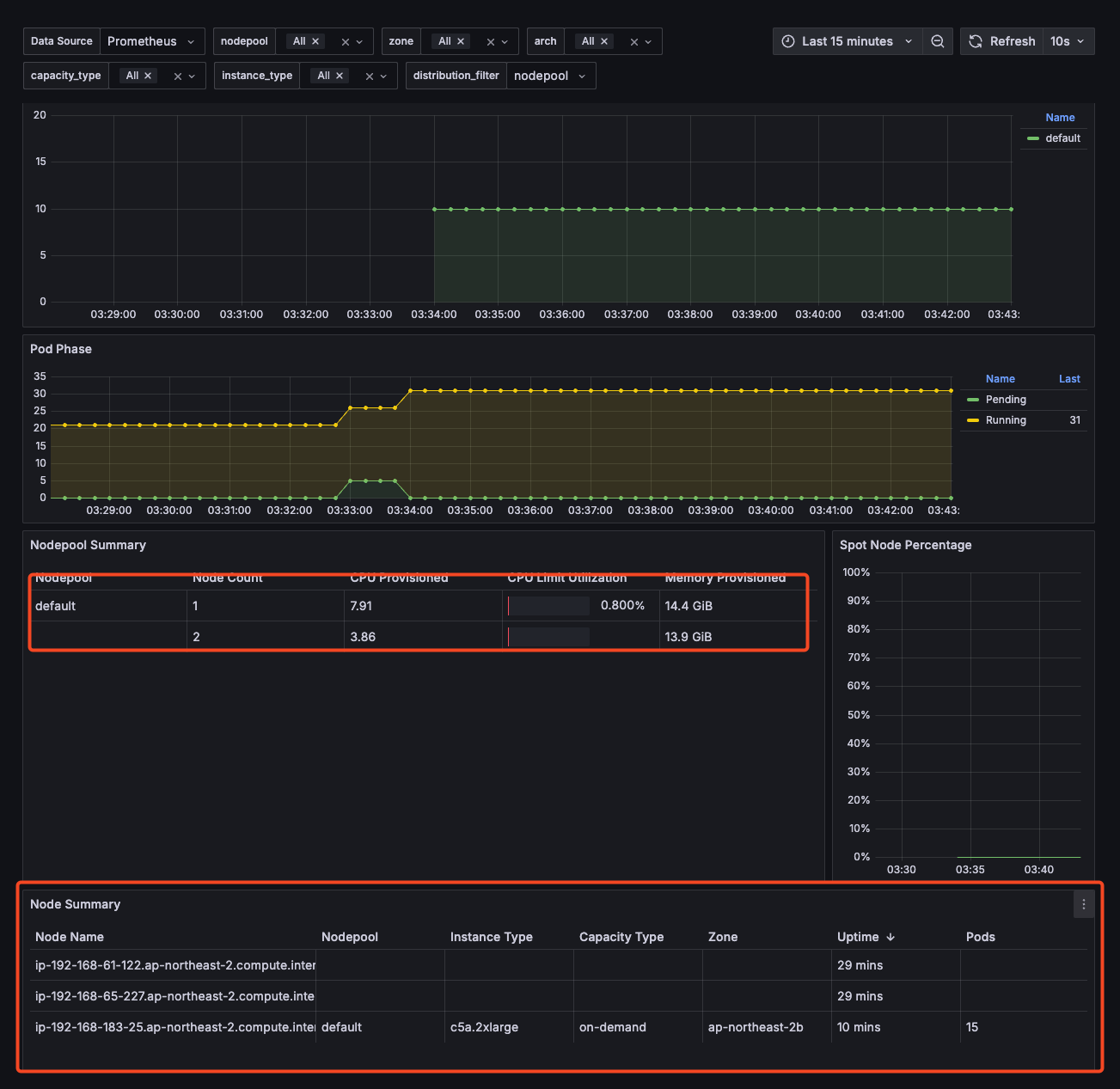

빨간색 표시가 있는 로그를 보면, 5개의 pod가 provisioned 됐고, 지금 노드로는 수용이 안되니 신규 node를 claime 한다고 controller가 메시지를 보냅니다.

controller는 requests 리소스를 확인해서 요구 사항을 충족할 수 있는 Instance type을 나열합니다.

그리고 생성할 노드의 스펙을 결정하고, az와 capacity-type을 결정해 node를 실행합니다.

이 예제에서는 on-demand로 노드가 생성되는 것을 확인할 수 있습니다.

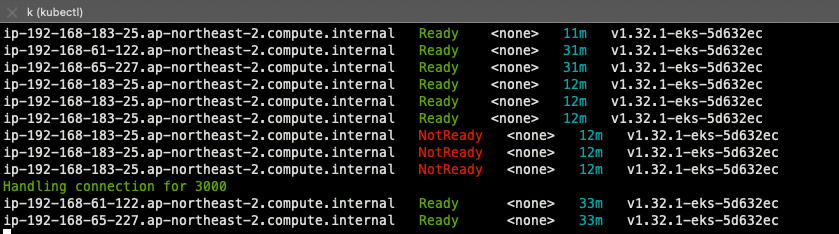

실제 node가 클러스터에 조인되기 ㄷ까지는 3분 내외로 진행되었습니다.

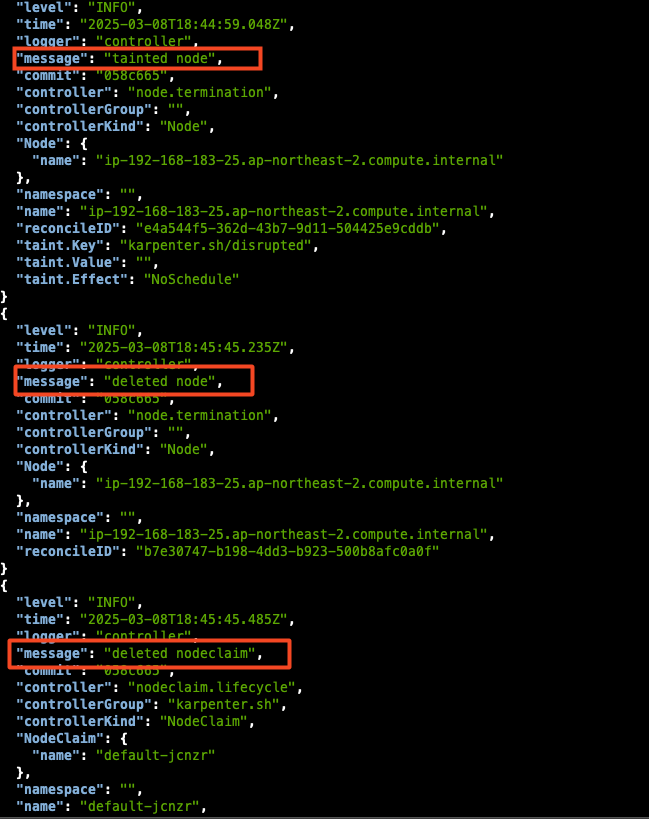

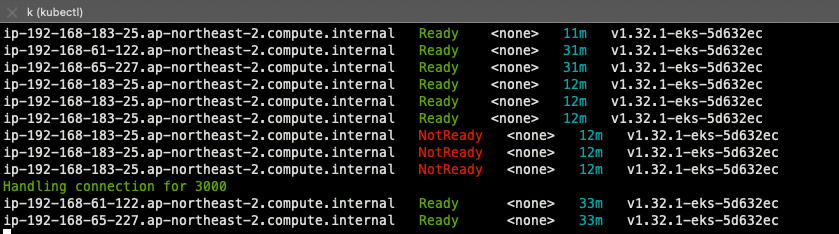

Scale Down Deployment

kubectl delete deployment inflate && date

kubectl logs -f -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller | jq '.'

kubectl get nodeclaims

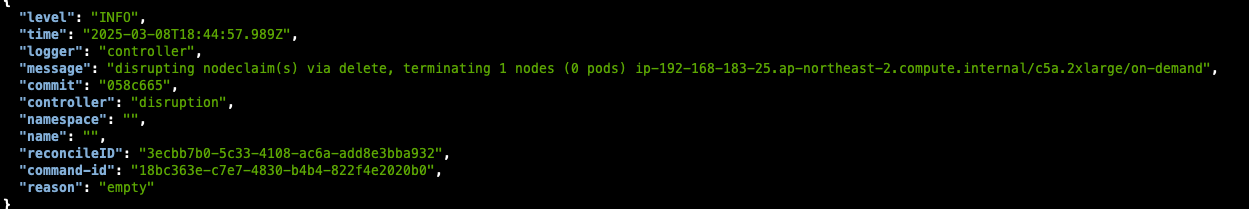

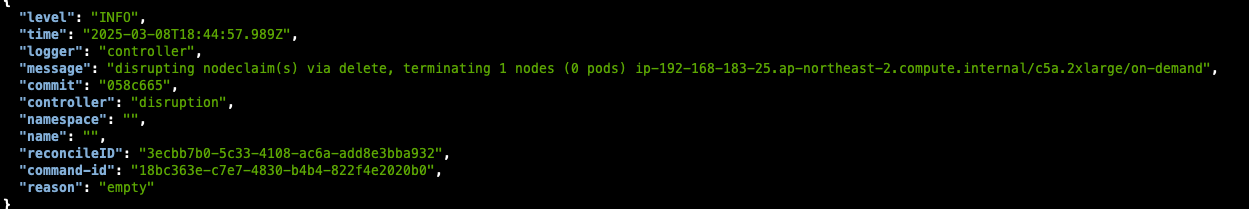

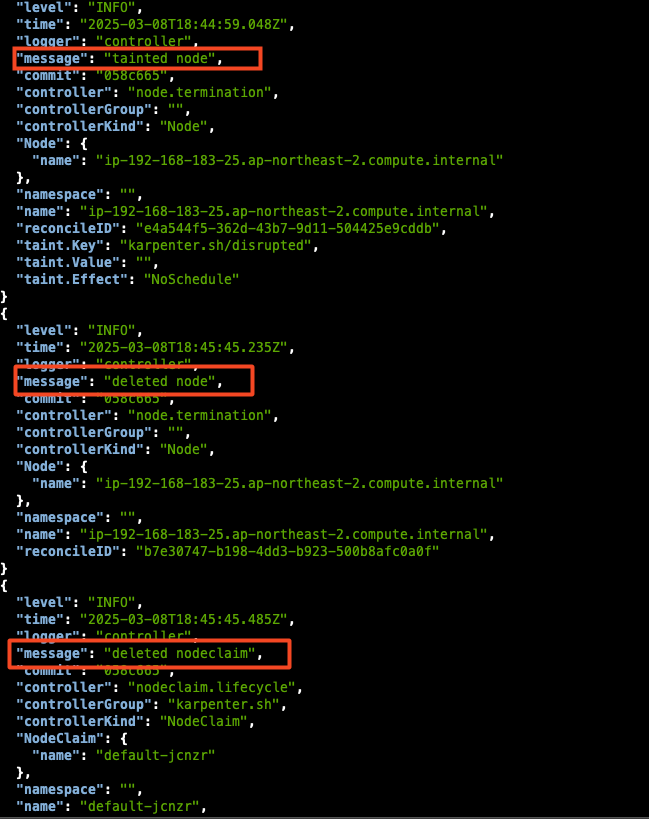

pod 삭제 후 1분뒤에 terminate 명령이 들어가고, taint 후 노드 종료까지는 3~4분 가량 소요되었습니다.

노드가 삭제된 이후 nodeclaim을 삭제하는 것을 확인할 수 있습니다.

'Cloud > AWS' 카테고리의 다른 글

| [AWS] EKS Mode/Nodes (0) | 2025.03.23 |

|---|---|

| [AWS] EKS Security (0) | 2025.03.13 |

| [AWS] EKS Autoscaler - CPA (0) | 2025.03.09 |

| [AWS] EKS Autoscaler - CAS (0) | 2025.03.09 |

| [AWS] EKS Autoscaling - VPA (0) | 2025.03.08 |

Karpenter

고성능의 지능형 kubernetes 컴퓨팅 프로비저닝 및 관리 솔루션, 수초 이내에 대응 가능, 더 낮은 컴퓨팅 비용으로 노드 선택

- 작동방식

모니터링 -> Pending POD 확인 -> 스펙 평가 -> 생성 => Provisioning

모니터링 -> 비어있는 노드 확인 -> 제거 => Deprovisioning

Provisioning CRD : 시작 템플릿 필요 없음

- 필수 : 보안그룹, 서브넷

- 리소스 찾는 방식 : 태그 기반, 리소스 ID 명시

- 인스턴스 타입은 가드레일 ㅂ아식으로 선언 : 스판(우선) vs 온디멘드, 다양한 인스턴스 Type 가능

1) POD에 적합한 인스턴스 중 가장 저렴한 인스턴스로 증설

2) PV를 위해 단일 서브넷에 노드 그룹을 만들 필요가 없음 -> 자동으로 PV가 존재하는 서브넷에 노드를 만듦

3) 사용하지 않는 노드를 자동으로 정리, 일정 기간이 지나면 노드를 자동으로 만료 시킬 수 있음

4) 노드를 줄여도 다른 노드에 충분한 여유가 있다면 자동으로 정리

5) 큰 노드 하나가 작은 노드 여러개 보다 비용이 저렴하다면 자동으로 합침

Drift : 선언한 값과 운영 머신 값이 일치하지 않을 경우 재조정

Drift 활용 : 패치 및 업그레이드

자원 생성 전 변수 설정

# 변수 설정

export KARPENTER_NAMESPACE="kube-system"

export KARPENTER_VERSION="1.2.1"

export K8S_VERSION="1.32"

export AWS_PARTITION="aws" # if you are not using standard partitions, you may need to configure to aws-cn / aws-us-gov

export CLUSTER_NAME="ssungz-karpenter-demo" # ${USER}-karpenter-demo

export AWS_DEFAULT_REGION="ap-northeast-2"

export AWS_ACCOUNT_ID="$(aws sts get-caller-identity --query Account --output text)"

export TEMPOUT="$(mktemp)"

export ALIAS_VERSION="$(aws ssm get-parameter --name "/aws/service/eks/optimized-ami/${K8S_VERSION}/amazon-linux-2023/x86_64/standard/recommended/image_id" --query Parameter.Value | xargs aws ec2 describe-images --query 'Images[0].Name' --image-ids | sed -r 's/^.*(v[[:digit:]]+).*$/\1/')"

# 확인

echo "${KARPENTER_NAMESPACE}" "${KARPENTER_VERSION}" "${K8S_VERSION}" "${CLUSTER_NAME}" "${AWS_DEFAULT_REGION}" "${AWS_ACCOUNT_ID}" "${TEMPOUT}" "${ALIAS_VERSION}"

Cluster 생성

## CloudFormation Stack으로 생성

curl -fsSL https://raw.githubusercontent.com/aws/karpenter-provider-aws/v"${KARPENTER_VERSION}"/website/content/en/preview/getting-started/getting-started-with-karpenter/cloudformation.yaml > "${TEMPOUT}" \

&& aws cloudformation deploy \

--stack-name "Karpenter-${CLUSTER_NAME}" \

--template-file "${TEMPOUT}" \

--capabilities CAPABILITY_NAMED_IAM \

--parameter-overrides "ClusterName=${CLUSTER_NAME}"

## 클러스터 생성 : EKS 클러스터 생성 15분 정도 소요

eksctl create cluster -f - <<EOF

---

apiVersion: eksctl.io/v1alpha5

kind: ClusterConfig

metadata:

name: ${CLUSTER_NAME}

region: ${AWS_DEFAULT_REGION}

version: "${K8S_VERSION}"

tags:

karpenter.sh/discovery: ${CLUSTER_NAME}

iam:

withOIDC: true

podIdentityAssociations:

- namespace: "${KARPENTER_NAMESPACE}"

serviceAccountName: karpenter

roleName: ${CLUSTER_NAME}-karpenter

permissionPolicyARNs:

- arn:${AWS_PARTITION}:iam::${AWS_ACCOUNT_ID}:policy/KarpenterControllerPolicy-${CLUSTER_NAME}

iamIdentityMappings:

- arn: "arn:${AWS_PARTITION}:iam::${AWS_ACCOUNT_ID}:role/KarpenterNodeRole-${CLUSTER_NAME}"

username: system:node:{{EC2PrivateDNSName}}

groups:

- system:bootstrappers

- system:nodes

## If you intend to run Windows workloads, the kube-proxy group should be specified.

# For more information, see https://github.com/aws/karpenter/issues/5099.

# - eks:kube-proxy-windows

managedNodeGroups:

- instanceType: m5.large

amiFamily: AmazonLinux2023

name: ${CLUSTER_NAME}-ng

desiredCapacity: 2

minSize: 1

maxSize: 10

iam:

withAddonPolicies:

externalDNS: true

addons:

- name: eks-pod-identity-agent

EOF

Cluster 생성 확인

## eks 배포 확인

eksctl get cluster

eksctl get nodegroup --cluster $CLUSTER_NAME

eksctl get iamidentitymapping --cluster $CLUSTER_NAME

eksctl get iamserviceaccount --cluster $CLUSTER_NAME

eksctl get addon --cluster $CLUSTER_NAME

## Context rename

kubectl ctx

kubectl config rename-context "<각자 자신의 IAM User>@<자신의 Nickname>-karpenter-demo.ap-northeast-2.eksctl.io" "karpenter-demo"

## kubernetes 확인

kubectl ns default

kubectl cluster-info

kubectl get node --label-columns=node.kubernetes.io/instance-type,eks.amazonaws.com/capacityType,topology.kubernetes.io/zone

kubectl get pod -n kube-system -owide

kubectl get pdb -A

kubectl describe cm -n kube-system aws-auth

## kube-ops-view install

helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=LoadBalancer --set env.TZ="Asia/Seoul" --namespace kube-system

echo -e "http://$(kubectl get svc -n kube-system kube-ops-view -o jsonpath="{.status.loadBalancer.ingress[0].hostname}"):8080/#scale=1.5"

open "http://$(kubectl get svc -n kube-system kube-ops-view -o jsonpath="{.status.loadBalancer.ingress[0].hostname}"):8080/#scale=1.5"

Karpenter 설치

helm registry logout public.ecr.aws

## Karpenter 설치를 위한 변수 설정 및 확인

export CLUSTER_ENDPOINT="$(aws eks describe-cluster --name "${CLUSTER_NAME}" --query "cluster.endpoint" --output text)"

export KARPENTER_IAM_ROLE_ARN="arn:${AWS_PARTITION}:iam::${AWS_ACCOUNT_ID}:role/${CLUSTER_NAME}-karpenter"

echo "${CLUSTER_ENDPOINT} ${KARPENTER_IAM_ROLE_ARN}"

## karpenter 설치

helm upgrade --install karpenter oci://public.ecr.aws/karpenter/karpenter --version "${KARPENTER_VERSION}" --namespace "${KARPENTER_NAMESPACE}" --create-namespace \

--set "settings.clusterName=${CLUSTER_NAME}" \

--set "settings.interruptionQueue=${CLUSTER_NAME}" \

--set controller.resources.requests.cpu=1 \

--set controller.resources.requests.memory=1Gi \

--set controller.resources.limits.cpu=1 \

--set controller.resources.limits.memory=1Gi \

--wait

## 확인

helm list -n kube-system

kubectl get-all -n $KARPENTER_NAMESPACE

kubectl get all -n $KARPENTER_NAMESPACE

kubectl get crd | grep karpenter

- karpenter는 clusterfirst 기본적으로 pod dns 정책을 사용. karpenter가 dns 서비스 pod의 용량을 관리해야 하는 경우 karpenter가 시작될 때 dns가 실행되지 않음을 의미하며, 이 경우 dns 정책을 default with로 설정해야함.

--set dnsPolicy=Default 이렇게 설정하면 karpenter가 내부 dns 확인 대신 호스트 dns 확인을 사용하기 때문에 dns 서비스 pod 에 대한 종속성이 없어지게함

- karpenter는 노드 용량 추적을 ㅜ이해 클러스터의 CloudProvider 머신과 Customresources 간의 매핑을 만들며, 이 매핑이 일관되도록 하기 위해 karpenter는 다음 태그 키를 활용

1) karpenter.sh/managed-by

2) karpenter.sh/nodepool

3) kubernetes.io/cluster/${CLUSTER_NAME}

Prometheus / Grafana 설치

#

helm repo add grafana-charts https://grafana.github.io/helm-charts

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

helm repo update

kubectl create namespace monitoring

# 프로메테우스 설치

curl -fsSL https://raw.githubusercontent.com/aws/karpenter-provider-aws/v"${KARPENTER_VERSION}"/website/content/en/preview/getting-started/getting-started-with-karpenter/prometheus-values.yaml | envsubst | tee prometheus-values.yaml

helm install --namespace monitoring prometheus prometheus-community/prometheus --values prometheus-values.yaml

# 프로메테우스 얼럿매니저 미사용으로 삭제

kubectl delete sts -n monitoring prometheus-alertmanager

# 프로메테우스 접속 설정

export POD_NAME=$(kubectl get pods --namespace monitoring -l "app.kubernetes.io/name=prometheus,app.kubernetes.io/instance=prometheus" -o jsonpath="{.items[0].metadata.name}")

kubectl --namespace monitoring port-forward $POD_NAME 9090 &

open http://127.0.0.1:9090

# 그라파나 설치

curl -fsSL https://raw.githubusercontent.com/aws/karpenter-provider-aws/v"${KARPENTER_VERSION}"/website/content/en/preview/getting-started/getting-started-with-karpenter/grafana-values.yaml | tee grafana-values.yaml

helm install --namespace monitoring grafana grafana-charts/grafana --values grafana-values.yaml

# admin 암호

kubectl get secret --namespace monitoring grafana -o jsonpath="{.data.admin-password}" | base64 --decode ; echo

17JUGSjgxK20m4NEnAaG7GzyBjqAMHMFxRnXItLj

# 그라파나 접속

kubectl port-forward --namespace monitoring svc/grafana 3000:80 &

open http://127.0.0.1:3000

Create NodePool

- 관리 리소스는 securityGroupSelector and subnetSelector로 찾음

- consolidationPolicy: 미사용 노드 정리 정책, 데몬셋 제외

- 단일 karpenter nodepool은 여러 다른 파드 모양을 처리할 수 있으며, karpenter는 레이블 및 친화성과 같은 포드속성을 기반으로 스케줄링 및 프로비저닝 결정을 내린다. 즉, karpenter는 여러 다른 노드 그룹을 관리할 필요성을 제거함.

- consolidationPolicy는 karpenter가 노드를 제거하고 교체하여 클러스터 비용을 줄이도록 구성, 결과적으로 통합은 클러스터의 모든 빈 노드를 종료함

## 변수 설정

echo $ALIAS_VERSION

v20250228

## Nodepool 생성

cat <<EOF | envsubst | kubectl apply -f -

apiVersion: karpenter.sh/v1

kind: NodePool

metadata:

name: default

spec:

template:

spec:

requirements:

- key: kubernetes.io/arch

operator: In

values: ["amd64"]

- key: kubernetes.io/os

operator: In

values: ["linux"]

- key: karpenter.sh/capacity-type

operator: In

values: ["on-demand"]

- key: karpenter.k8s.aws/instance-category

operator: In

values: ["c", "m", "r"]

- key: karpenter.k8s.aws/instance-generation

operator: Gt

values: ["2"]

nodeClassRef:

group: karpenter.k8s.aws

kind: EC2NodeClass

name: default

expireAfter: 720h # 30 * 24h = 720h

limits:

cpu: 1000

disruption:

consolidationPolicy: WhenEmptyOrUnderutilized

consolidateAfter: 1m

---

apiVersion: karpenter.k8s.aws/v1

kind: EC2NodeClass

metadata:

name: default

spec:

role: "KarpenterNodeRole-${CLUSTER_NAME}" # replace with your cluster name

amiSelectorTerms:

- alias: "al2023@${ALIAS_VERSION}" # ex) al2023@latest

subnetSelectorTerms:

- tags:

karpenter.sh/discovery: "${CLUSTER_NAME}" # replace with your cluster name

securityGroupSelectorTerms:

- tags:

karpenter.sh/discovery: "${CLUSTER_NAME}" # replace with your cluster name

EOF

# 확인

kubectl get nodepool,ec2nodeclass,nodeclaims

Scale up Deployment

## pause 파드 1개에 CPU 1개 최소 보장 할당할 수 있게 디플로이먼트 배포

cat <<EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: inflate

spec:

replicas: 0

selector:

matchLabels:

app: inflate

template:

metadata:

labels:

app: inflate

spec:

terminationGracePeriodSeconds: 0

securityContext:

runAsUser: 1000

runAsGroup: 3000

fsGroup: 2000

containers:

- name: inflate

image: public.ecr.aws/eks-distro/kubernetes/pause:3.7

resources:

requests:

cpu: 1

securityContext:

allowPrivilegeEscalation: false

EOF

## [신규 터미널] 모니터링

eks-node-viewer --resources cpu,memory

eks-node-viewer --resources cpu,memory --node-selector "karpenter.sh/registered=true" --extra-labels eks-node-viewer/node-age

## Scale up

kubectl get pod

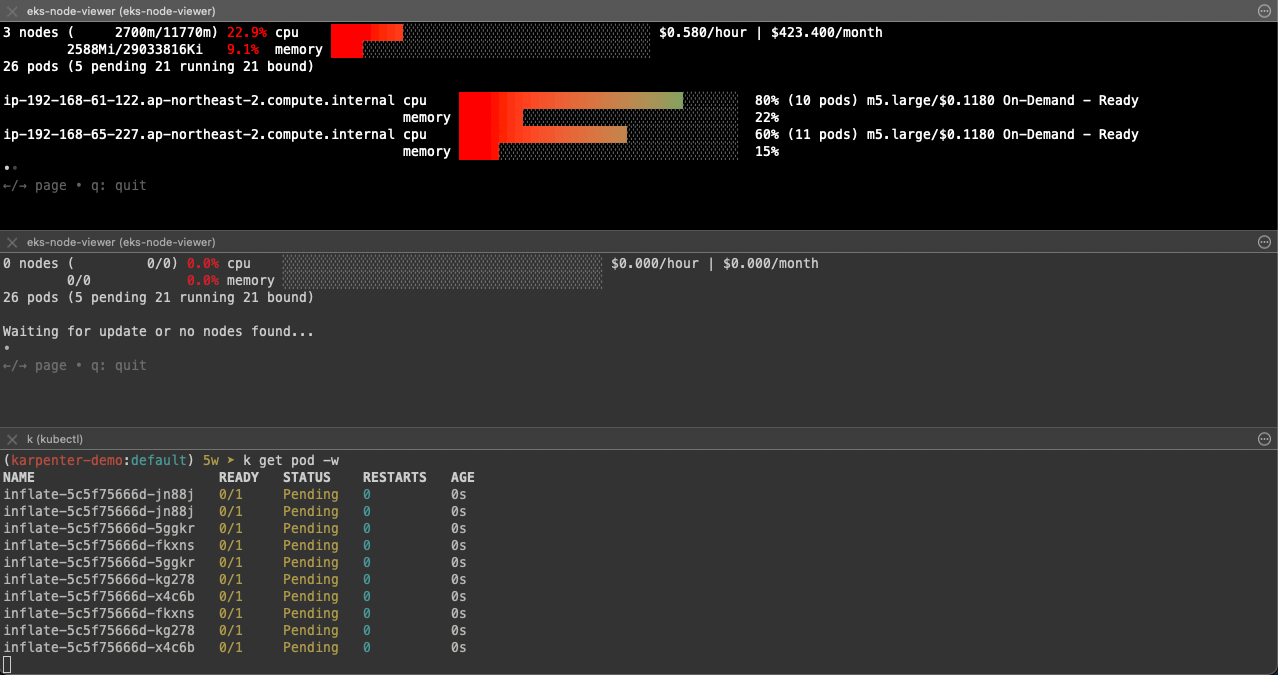

kubectl scale deployment inflate --replicas 5

## 출력 로그 분석해보자!

kubectl logs -f -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller

kubectl logs -f -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller | jq '.'

kubectl logs -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller | grep 'launched nodeclaim' | jq '.'

## 확인

kubectl get nodeclaims

NAME TYPE CAPACITY ZONE NODE READY AGE

default-8f5vd c5a.2xlarge on-demand ap-northeast-2c ip-192-168-176-171.ap-northeast-2.compute.internal True 79s

kubectl describe nodeclaims

#

kubectl get node -l karpenter.sh/registered=true -o jsonpath="{.items[0].metadata.labels}" | jq '.'

빨간색 표시가 있는 로그를 보면, 5개의 pod가 provisioned 됐고, 지금 노드로는 수용이 안되니 신규 node를 claime 한다고 controller가 메시지를 보냅니다.

controller는 requests 리소스를 확인해서 요구 사항을 충족할 수 있는 Instance type을 나열합니다.

그리고 생성할 노드의 스펙을 결정하고, az와 capacity-type을 결정해 node를 실행합니다.

이 예제에서는 on-demand로 노드가 생성되는 것을 확인할 수 있습니다.

실제 node가 클러스터에 조인되기 ㄷ까지는 3분 내외로 진행되었습니다.

Scale Down Deployment

kubectl delete deployment inflate && date

kubectl logs -f -n "${KARPENTER_NAMESPACE}" -l app.kubernetes.io/name=karpenter -c controller | jq '.'

kubectl get nodeclaims

pod 삭제 후 1분뒤에 terminate 명령이 들어가고, taint 후 노드 종료까지는 3~4분 가량 소요되었습니다.

노드가 삭제된 이후 nodeclaim을 삭제하는 것을 확인할 수 있습니다.

'Cloud > AWS' 카테고리의 다른 글

| [AWS] EKS Mode/Nodes (0) | 2025.03.23 |

|---|---|

| [AWS] EKS Security (0) | 2025.03.13 |

| [AWS] EKS Autoscaler - CPA (0) | 2025.03.09 |

| [AWS] EKS Autoscaler - CAS (0) | 2025.03.09 |

| [AWS] EKS Autoscaling - VPA (0) | 2025.03.08 |