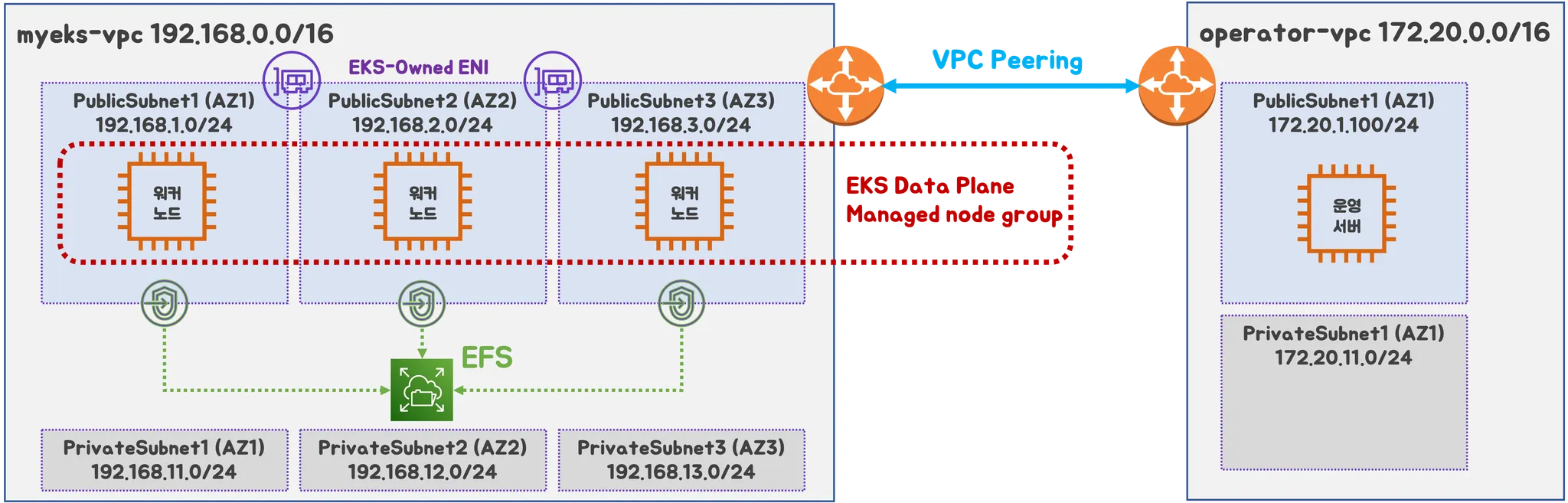

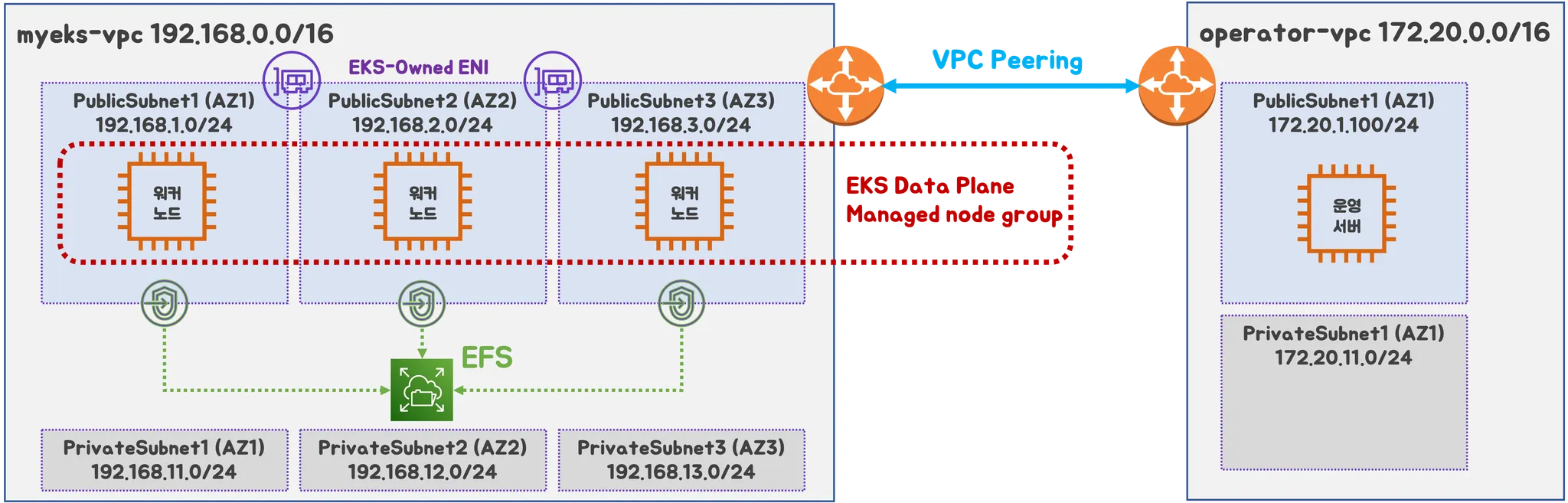

실습 환경

VPC : 2ea

Work node : 3ea (t3.xlarge)

EC2 : 1ea

EFS : 1ea

- kube-ops-view, AWS LoadBalancer Controller, ExternalDNS, gp3 Storageclass 설치

명령어 or 코드 내에 있는 변수는 이름 그대로의 값을 변수로 잡아 설정했으며,

정확한 명령어를 확인하고 싶을 경우 이전 게시글을 참고하시면 됩니다.

## YAML 파일 다운로드

$ curl -O https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/myeks-4week.yaml

## 변수 지정

$ CLUSTER_NAME=myeks

$ SSHKEYNAME={KEY 이름}

$ MYACCESSKEYNAME={aws access key}

$ MYSECRETKEYNAME={aws secret key}

## CloudFormation 배포

### yaml 파일 내에 동일한 이름의 stack이 있을 경우 반드시 정리하고 하자.

### Cluster 배포가 안될 수 있음

$ aws cloudformation deploy --template-file myeks-4week.yaml --stack-name $CLUSTER_NAME --parameter-overrides KeyName=$SSHKEYNAME SgIngressSshCidr=$(curl -s ipinfoio/ip)/32 MyIamUserAccessKeyID=$MYACCESSKEY MyIamUserSecretAccessKey=$MYSECRETKEY ClusterBaseName=$CLUSETR_NAME WorkerNodeInstanceType=$WorkerNodeInstanceType --region ap-northeast-2

## 작업용 EC2 IP 출력

$ aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text

## 내 컴퓨터에서 Cluster config 설정

$ eksctl get cluster

$ eks get nodegroup --cluster $CLUSTER_NAME

$ aws sts get-caller-identity --query Arn

$ aws eks udpate-kubeconfig --name myeks --user-alias {arn user}

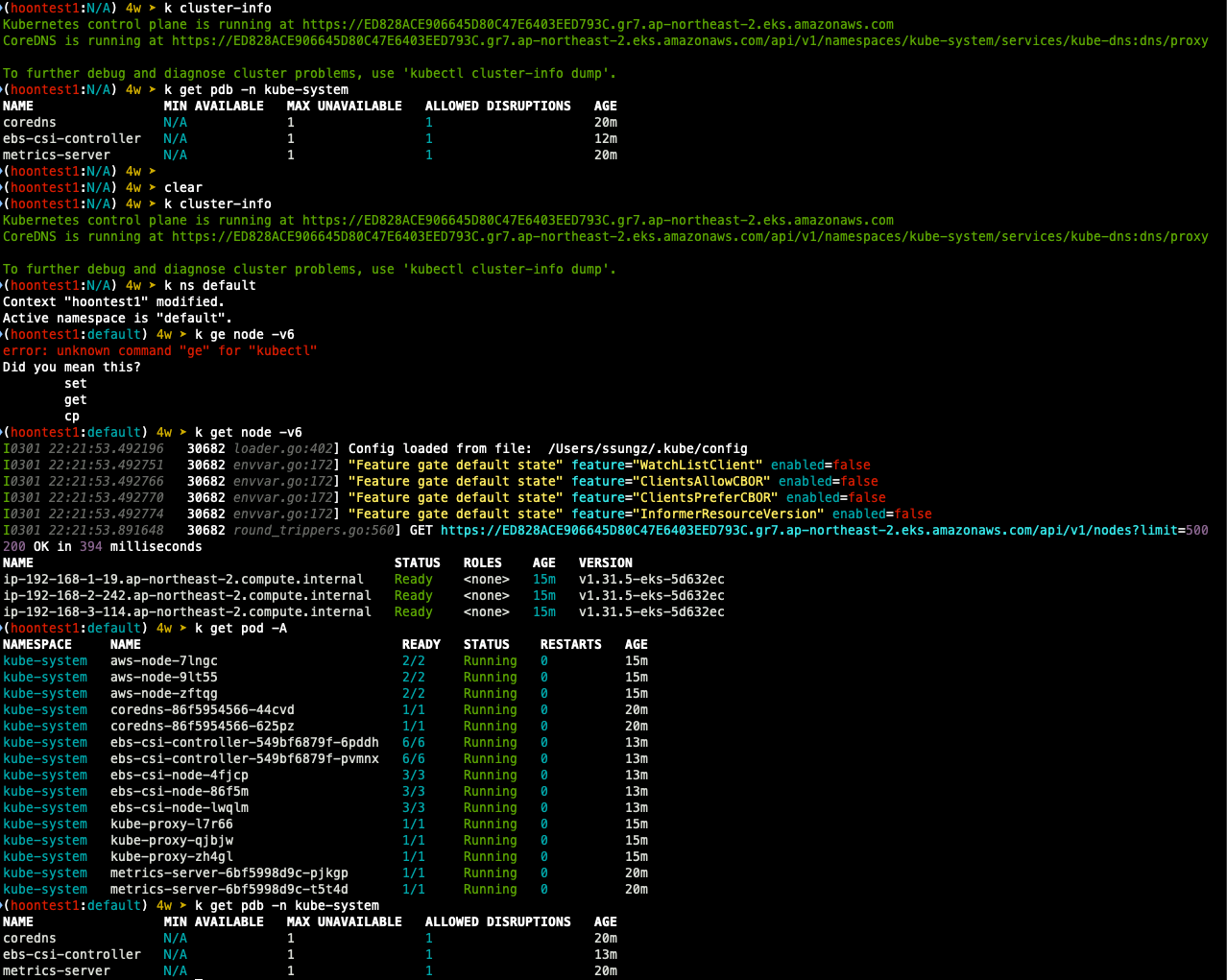

## Cluster 정보 확인

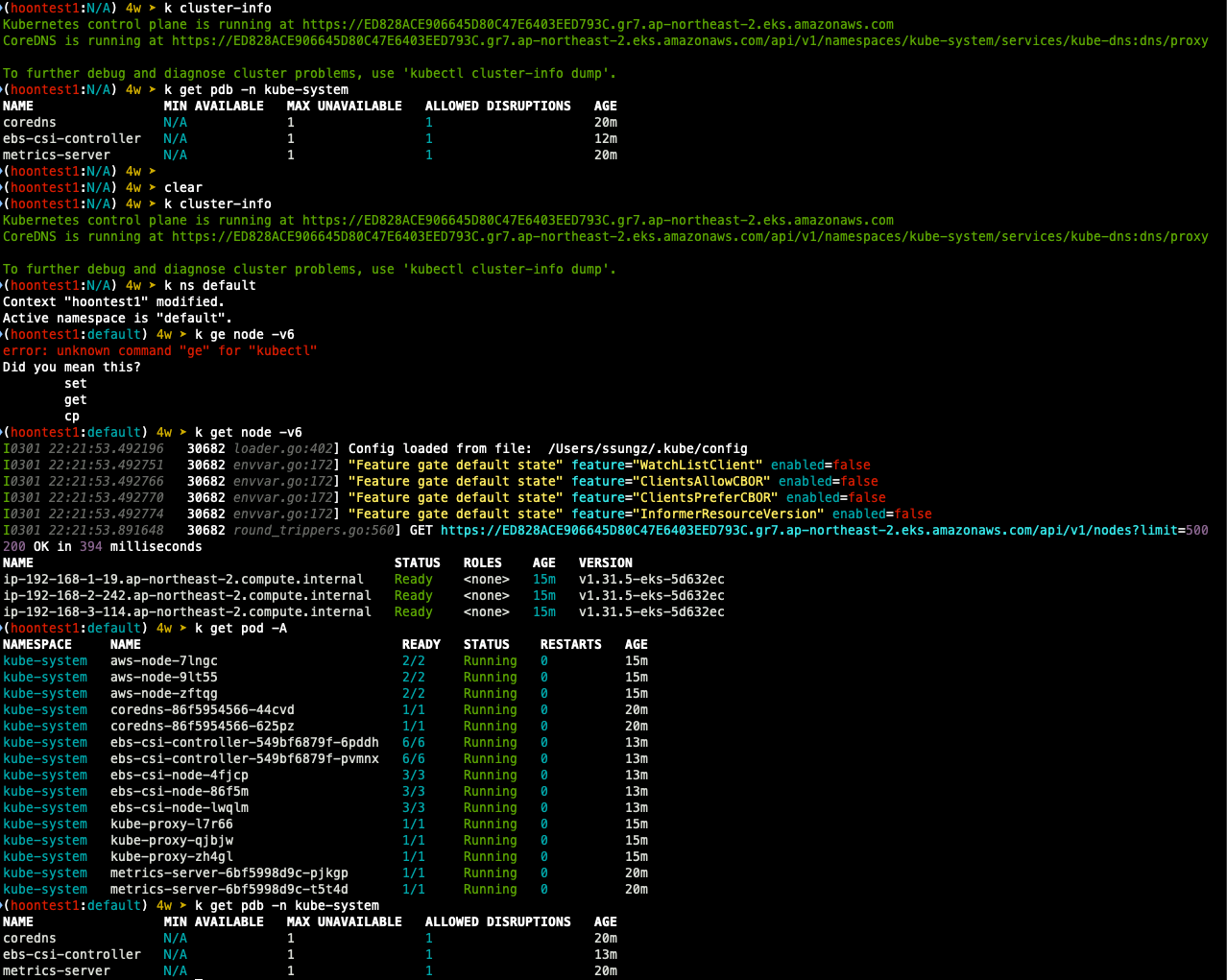

$ k cluster-info

$ k ns default

$ k get node -v6

$ k get pod -A

$ k get pdb -n kube-system

## kube-ops-view

$ helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

$ helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=ClusterIP -- set env.TZ="Asia/Seoul" --namespace kube-system

## gp3 Storageclass

$ cat <<EOF | kubectl apply -f -=

kiund: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: gp3

annotations:

storageclass.kubernetes.io/is-default-class: "true"

allowVolumeExpansion: true

provisioner: ebs.csi.aws.com

volumeBindingMode: WaitForFirstConsumer

parameters:

type: gp3

allowAutoIOPSPerGBIncrease: 'true'

encrypted: 'true'

fsType: xfs

EOF

$ kubectl get sc

## ExternalDNS

$ curl -s https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml | MYDOMAIN=$MyDomain MyDnzHostedZoneID=$MyDnzHostedZoneID envsubst | kubectl apply -f -

## AWS Loadbalancercontroller

$ helm repo add eks https://aws.github.io/eks-charts

$ helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n ube-system --set clusterName=$CLUSTER_NAME \

--set serviceAccount.create=false --set serviceAccount.name=aws-load-balancer-controller

## kube-ops-view 용 ingress 설정

$ cat <<EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

labels:

app.kubernetes.io/name: kubeopsview

name: kubeopsview

namespace: kube-system

spec:

ingressClassName: alb

rules:

- host: kubeopsview.$MyDomain

http:

paths:

- backend:

service:

name: kube-ops-view

port:

number: 8080

path: /

pathType: Prefix

EOF

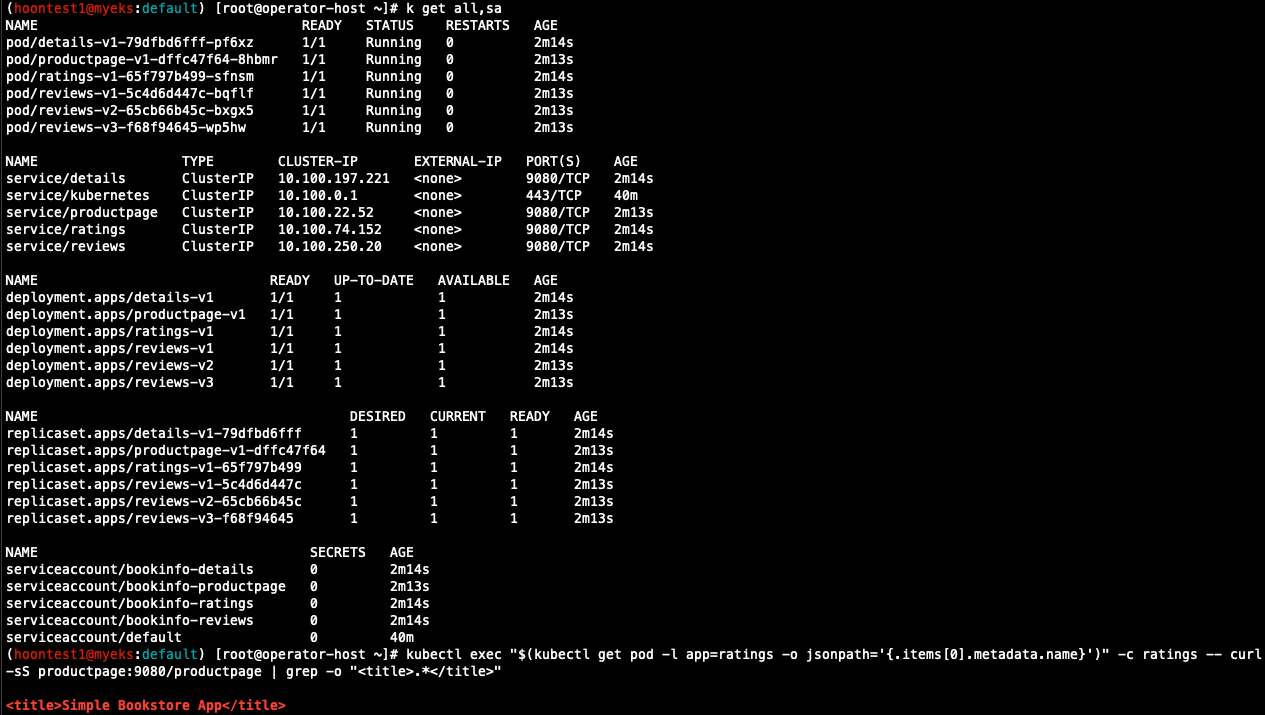

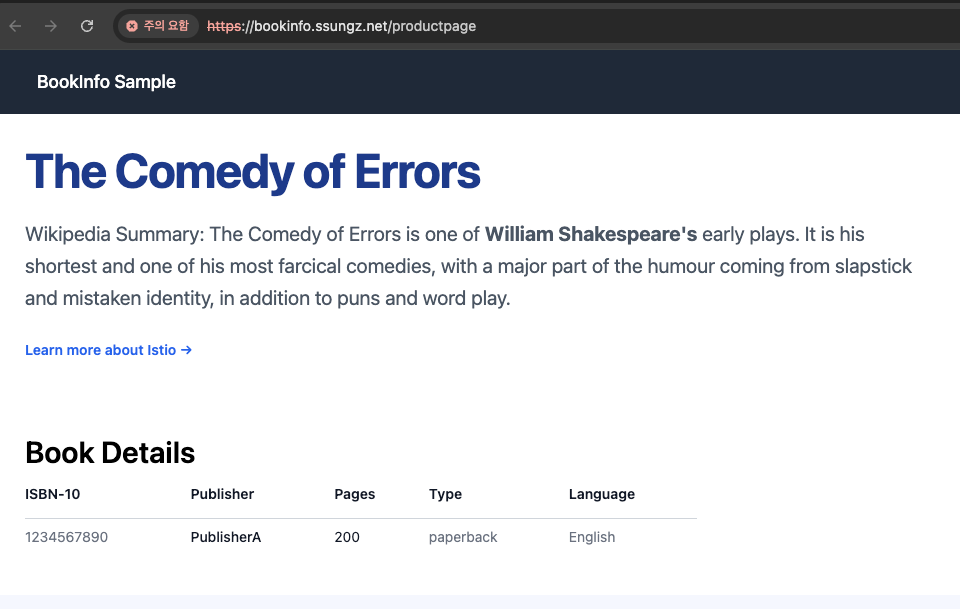

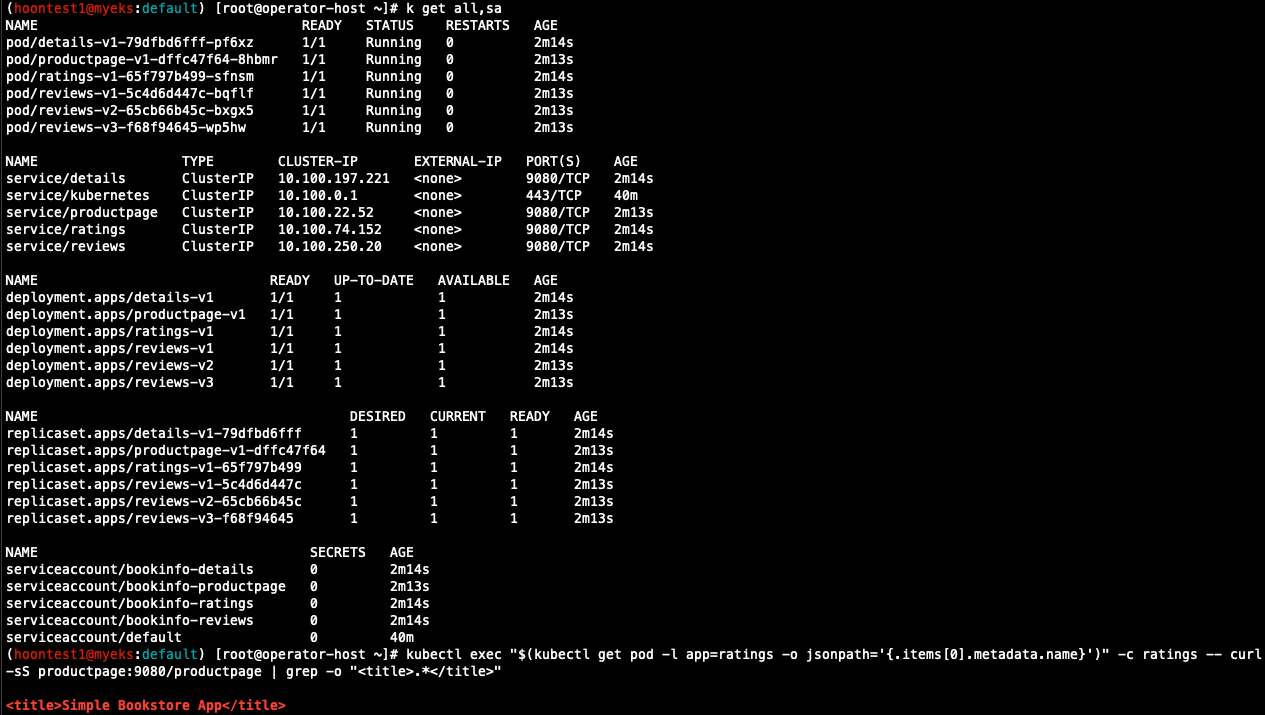

- 실습을 위한 Book info 예제 배포

## BookInfo 배포

$ k apply -f https://raw.githubusercontent.com/istio/istio/refs/heads/master/samples/bookinfo/platform/kube/bookinfo.yaml

## 배포 확인

$ k get all,sa

## Product 웹 접속 확인

$ k exec "${kubectl get pod -l app=ratings -o jsonpath='{.items[0].metadata.name}')" -c ratings -- curl -sS productpage:9080/productpage | grep -o "<title>.*</title>"

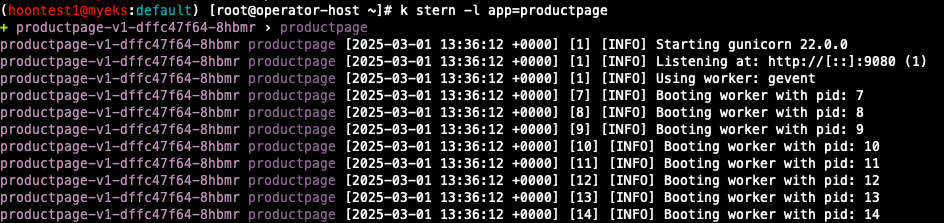

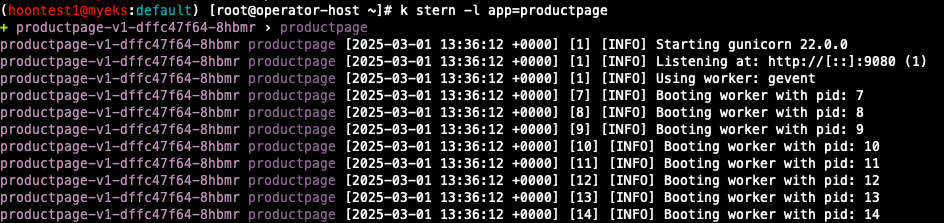

## 로그 확인

$ k stern -l app=productpage

$ k log -l app=productpage -f

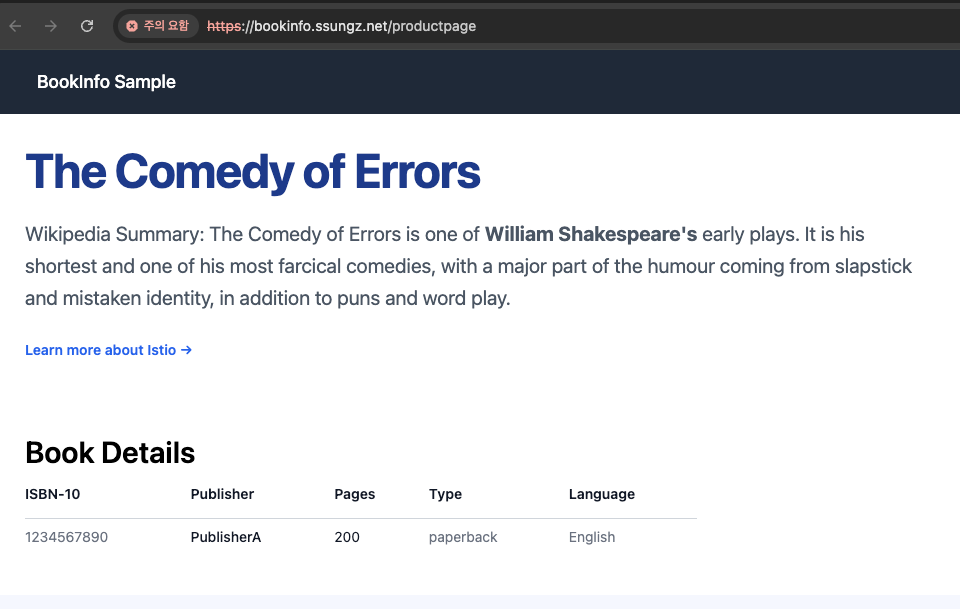

- Productpage 접속

## ingress 설정

cat <<EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

labels:

app.kubernetes.io/name: bookinfo

name: bookinfo

spec:

ingressClassName: alb

rules:

- host: bookinfo.$MyDomain

http:

paths:

- backend:

service:

name: productpage

port:

number: 9080

path: /

pathType: Prefix

EOF

## Ingress 확인

$ kubectl get ingress

## bookinfo 웹 페이지 접속 확인

$ echo -e "bookinfo URL = https://bookinfo.$MyDomain/productpage"

$ open "https://bookinfo.$MyDomain/productpage"

## 트래픽 생성을 위한 반복 접근

$ while true; do curl -s -k https://bookinfo.$MyDomain/productpage | grep -o "<title>.*</title>" ; echo "--------------" ; sleep 1; done

배경 소개

모니터링과 관측 가능성 observability(o11y)의 정의와 차이점

| 측면 | 모니터링 | 관측 가능성 |

| 정의 | 특정 메트릭 추적으로 문제 감지 | 외부 출력 데이터로 시스템 상태 이해 |

| 목표 | 문제 발생 시 감지 및 경고 | 문제 원인 진단 및 시스템 최적화 |

| 데이터 소스 | 미리 정의된 메트릭 (CPU, 메모리 등) | 로그, 메트릭, 트레이스, 이벤트 등 |

| 시스템 유형 | 단순한 시스템, 잘 알려진 파라미터 | 복잡한 분산 시스템, 다중 컴포넌트 |

| 상호작용 방식 | 정적 경고 (임계값 기반) | 동적 쿼리 및 분석 (질문 기반) |

- 모니터링의 정의와 특징: 사전에 정의된 기준을 기반으로 시스템의 상태를 감시에 중점

- 모니터링은 IT 시스템의 운영 상태를 추적하고, 성능 지표를 수집하고, 예상치 못한 문제를 조기에 감지하는 과정입니다.

(예: CPU / MEM 사용량, Latency, Error 와 같은 서비스가 운영되는데 반드시 관찰이 필요한 지표들을 모니터링 합니다.)

- 빈도: 연속적이거나, 일정 간격으로 하지만 일반적으로 서비스 모니터링은 24x365 진행하고, 최근에는 hook or 3rd party 상품으로 모니터링 alert을 수신하기도 합니다.

- 관측 가능성의 정의와 특징 : 수집된 다양한 데이터를 활용하여 예측되지 않은 문제까지 분석

- 관측 가능성은 시스템의 내부 상태를 외부 출력 데이터(로그, 메트릭, 트레이스)를 통해 이해할 수 있는 능력을 의미합니다.

(예: 어플리케이션이 Down되지 않았으나, 속도가 느려지는 이슈가 될 경우 트레이스와 로그를 통해 문제 포인트를 파악하는 케이스)

observability의 메트릭 Metric, 로그 log, 추적 tracing 이란?

| 비교 항목 | 메트릭 (Metrics) | 로그(Logs) | 추적(Tracing) |

| 정의 | 수치로 표현된 성능 데이터 | 시스템 이벤트 기록 | 요청이 시스템을 거치는 과정 추적 |

| 형태 | 숫자 (정량적 데이터) | 텍스트 (비정형 데이터) | 트랜잭션 흐름 데이터 |

| 예시 데이터 | CPU 사용률, 응답 시간, 요청 수 | 오류 메시지, 로그인 시도, API 호출 로그 | A 서비스 → B 서비스 → C 서비스 요청 흐름 |

| 주요 목적 | 시스템 성능 모니터링 및 알람 | 이벤트 분석 및 디버깅 | 서비스 간 호출 경로 및 병목 현상 분석 |

| 저장 방식 | 시계열 데이터베이스(TSDB) | 로그 파일 또는 로그 관리 시스템 | 분산 트레이싱 시스템 (Jaeger, Zipkin) |

| 활용 도구 | Prometheus, Grafana | ELK Stack, Loki | Jaeger, Zipkin |

SLI (Service Level Indicator, 서비스 수준 지표)

- SLI는 서비스 품질을 정량적으로 측정하는 주요 성능 지표

- 서비스의 신뢰성과 성능을 평가하는 데 사용되는 실제 측정 지표

SLO (Service Level Objective, 서비스 수준 목표)

- SLO는 서비스가 유지해야 하는 목표 수준을 정의하는 값으로, SLI에 대한 기준선을 설정

- "이 정도의 성능을 유지해야 한다"는 목표를 의미

SLA (Service Level Agreement, 서비스 수준 계약)

- SLA는 서비스 제공자와 고객 간에 체결된 공식적인 계약, 서비스 품질을 보장하는 법적 문서

- SLA는 SLO와 달리 계약 위반 시 보상이 존재

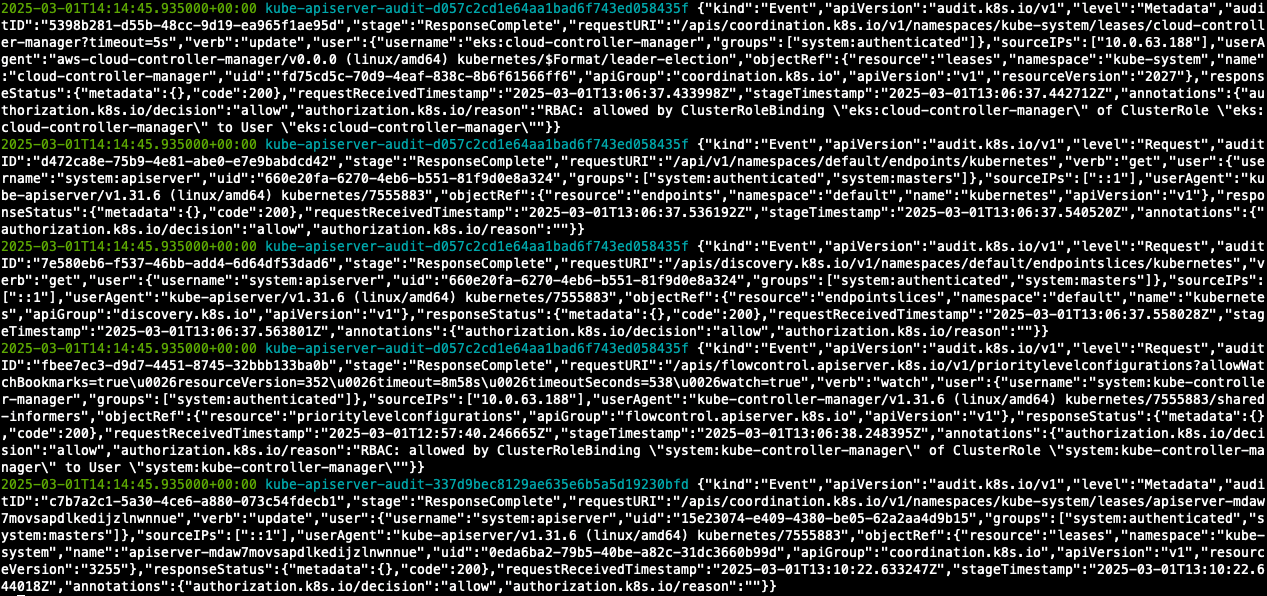

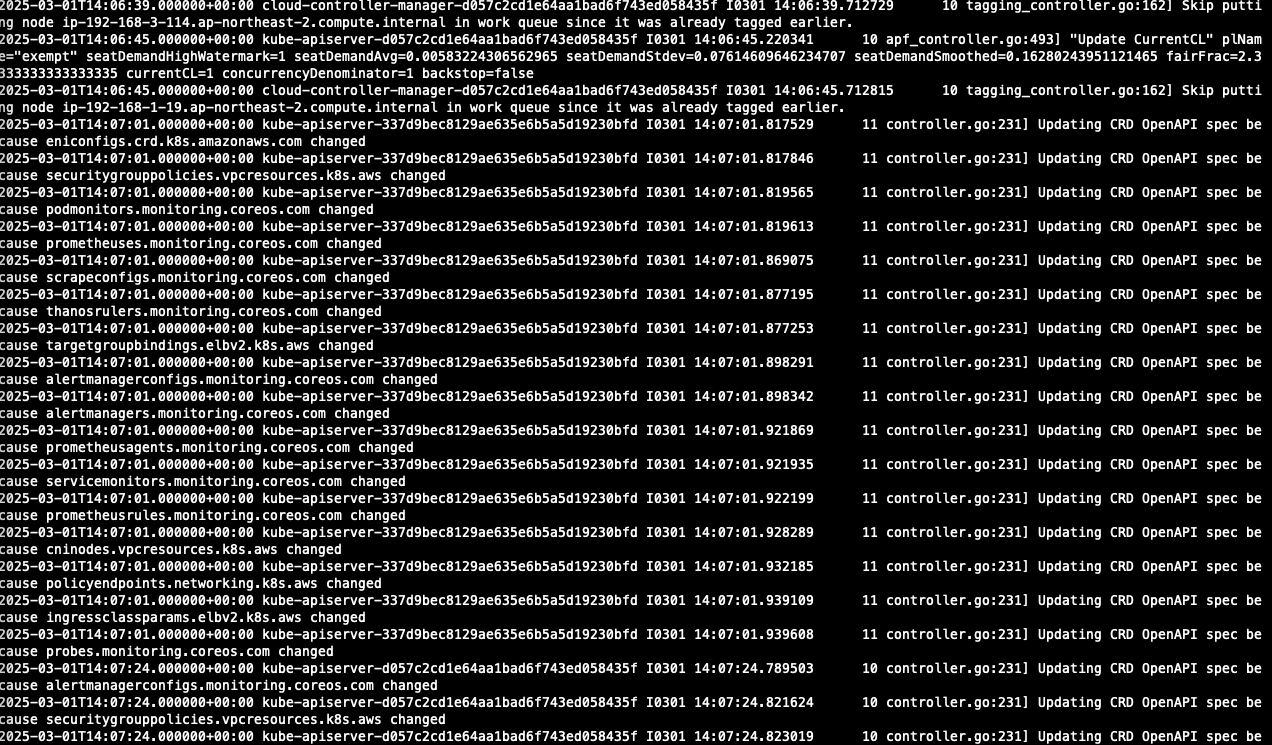

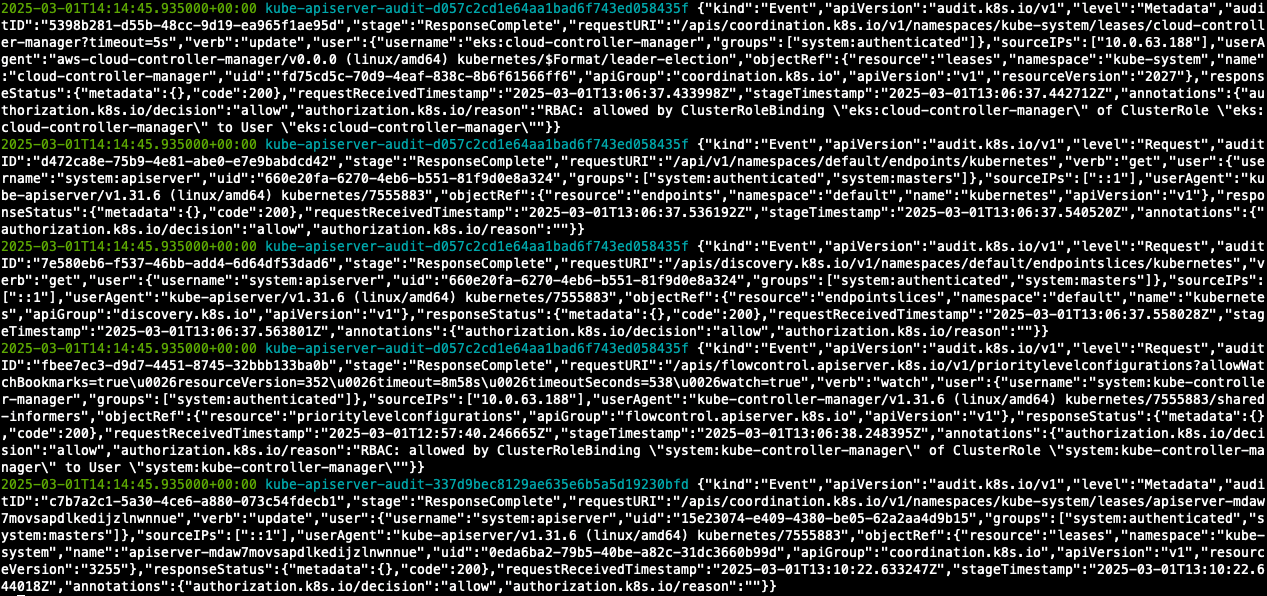

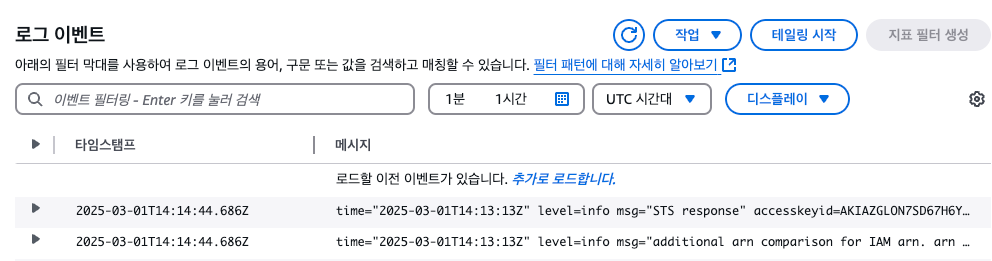

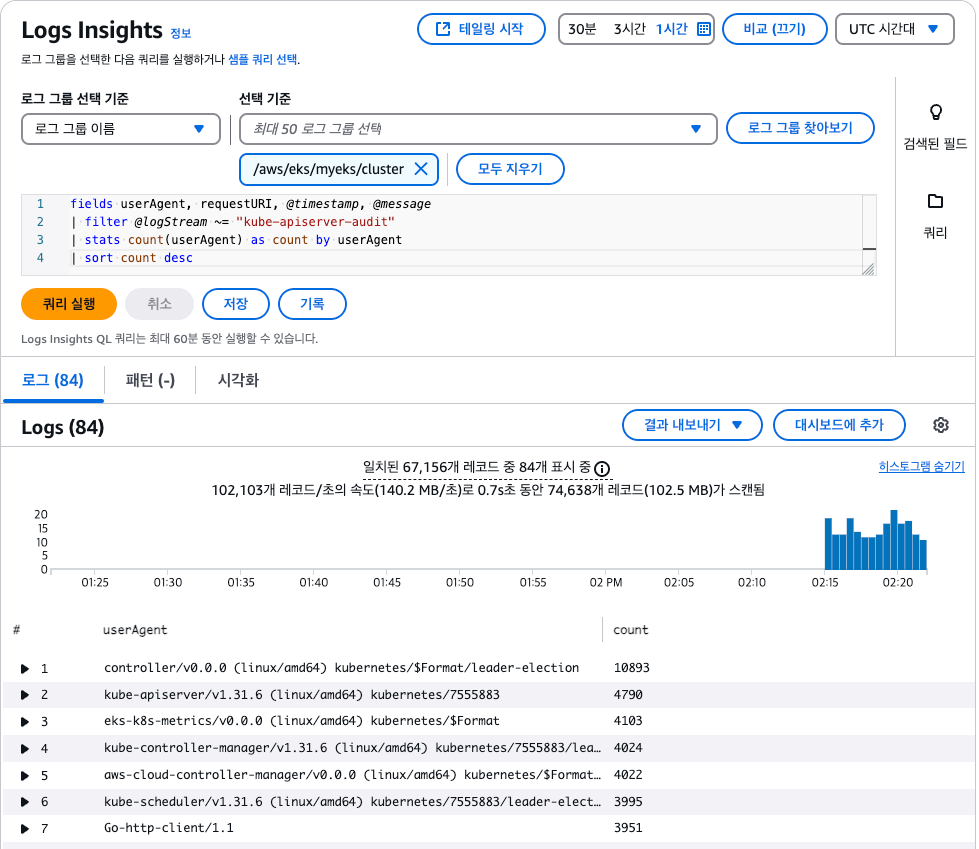

Loggin in EKS

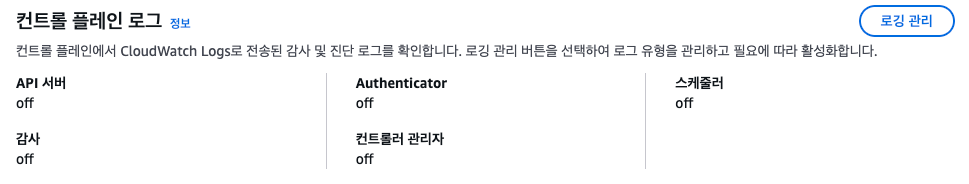

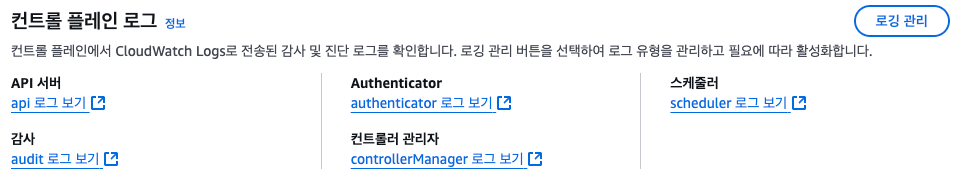

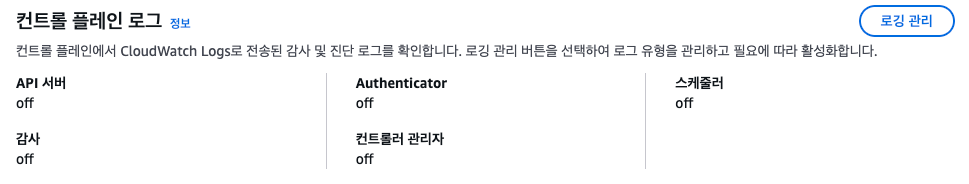

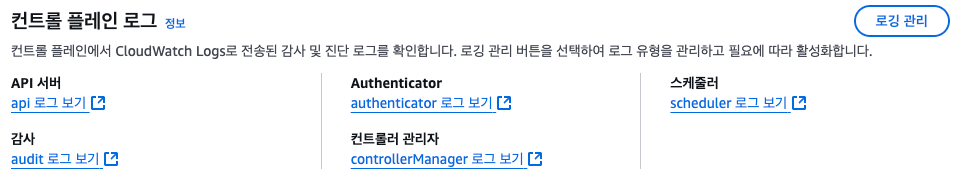

Control Plane Logging

1. Kubernetes API server component logs (api) – kube-apiserver-<nnn...>

2. Audit (audit) – kube-apiserver-audit-<nnn...>

3. Authenticator (authenticator) – authenticator-<nnn...>

4. Controller manager (controllerManager) – kube-controller-manager-<nnn...>

5. Scheduler (scheduler) – kube-scheduler-<nnn...>

- eksctl 기본값

## 모든 로깅 활성화

$ aws eks update-cluster-config --region ap-northeast-2 --name $CLUSTER_NAME \

--logging '{"clusterLogging":[{"types":["api","audit","authenticator","controllerManager","scheduler"],"enabled":true}]}'

## 로그 그룹 확인

$ aws logs describe-log-groups | jq

## 로그 tail 확인

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster | more

## 신규 로그를 바로 출력

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --follow

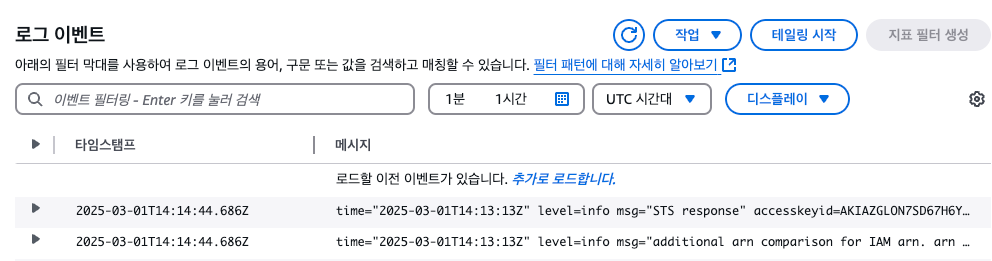

- 콘솔에서도 확인할 수 있습니다.

## 로그 스트림 이름

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix <로그 스트림 prefix> --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-apiserver --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-apiserver-audit --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-scheduler --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix authenticator --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-controller-manager --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix cloud-controller-manager --follow

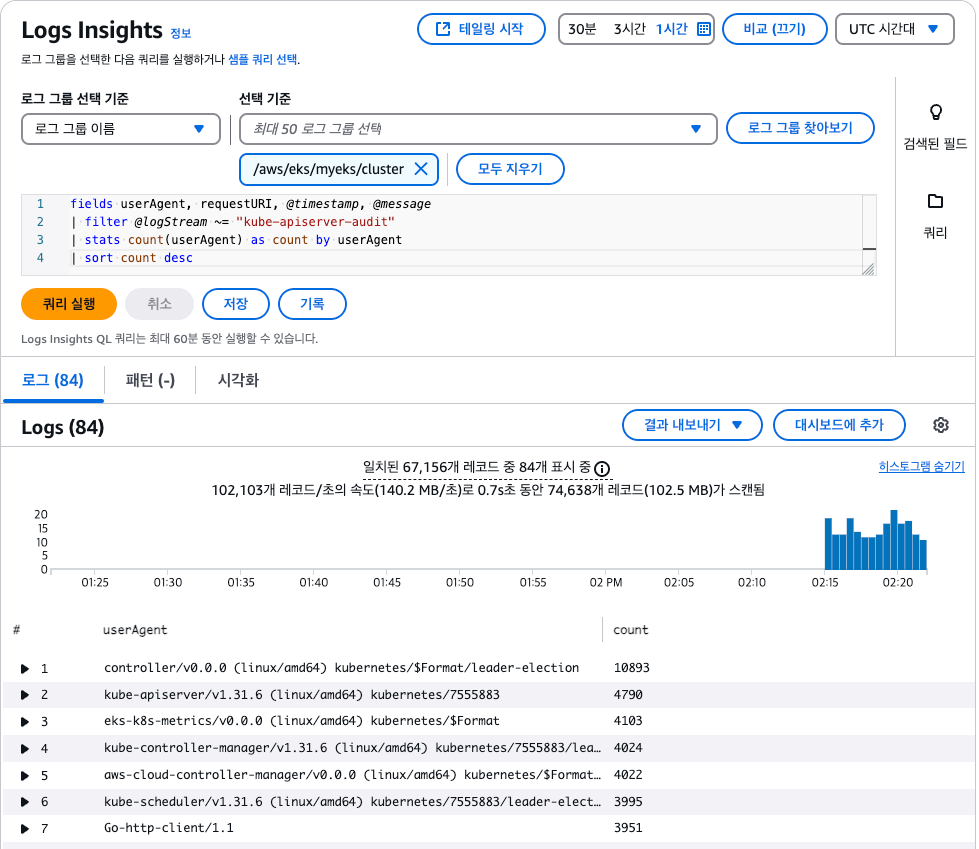

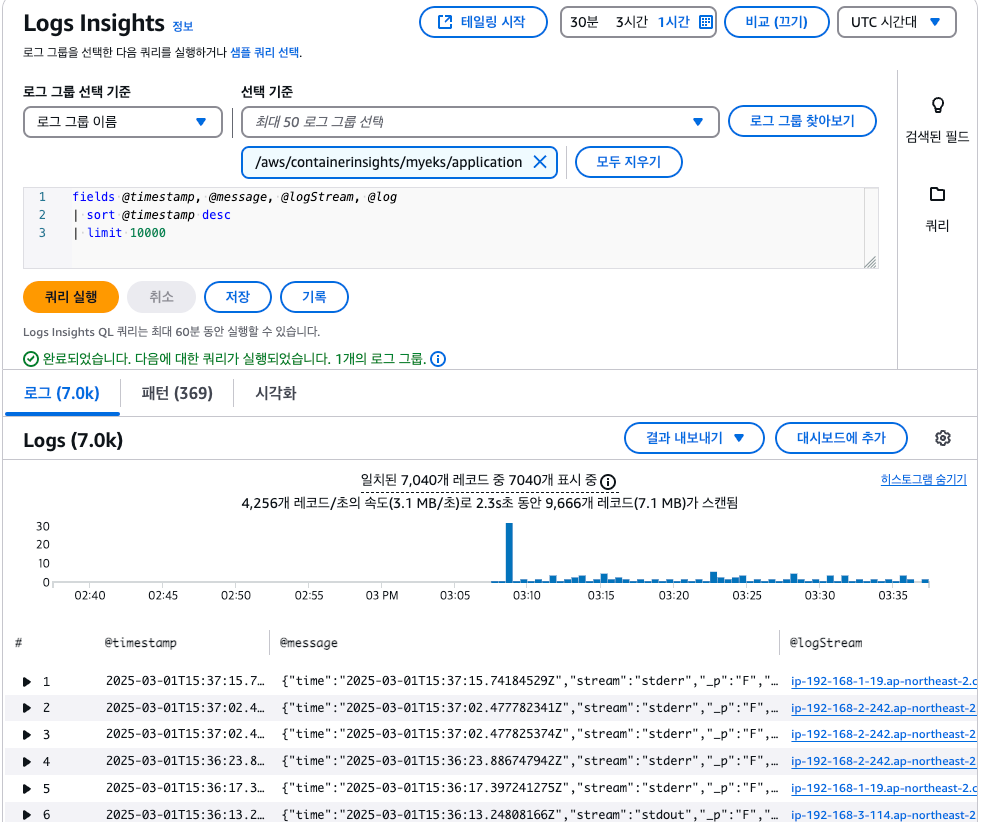

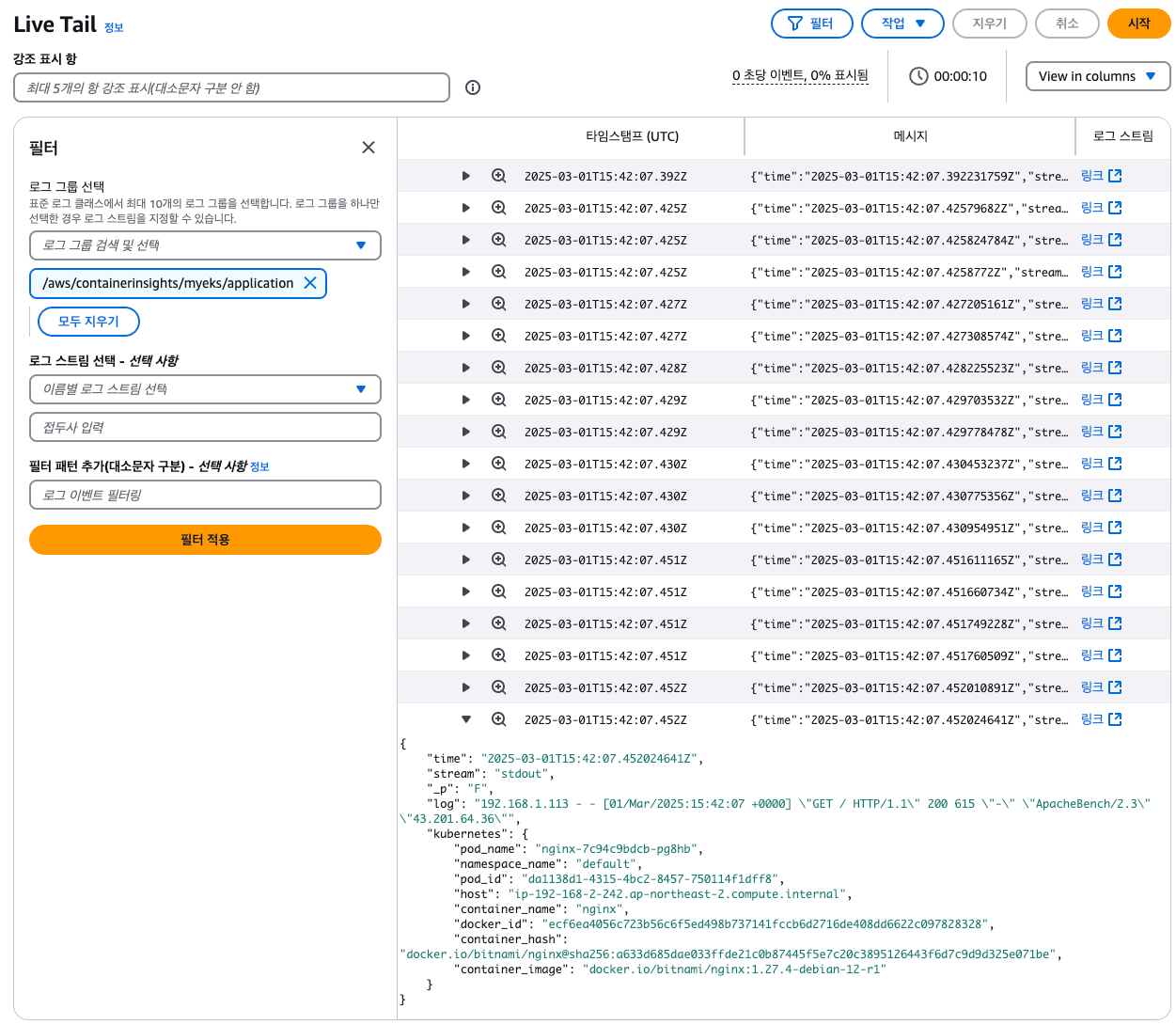

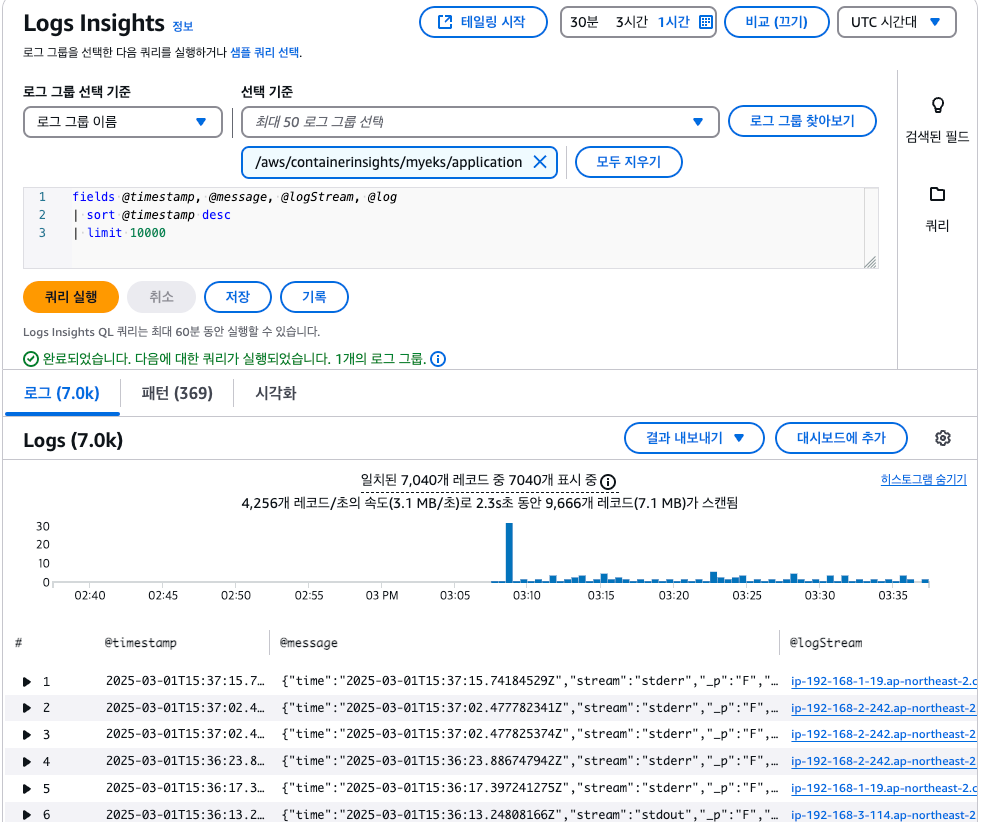

- Log Insights를 통해 다양하게 로그를 확인할 수 있습니다.

## 로그 끄기

$ eksctl utils update-cluster-logging --cluster $CLUSTER_NAME --region ap-northeast-2 --disable-types all --approve

## 로그 그룹 삭제

$ aws logs delete-log-group --log-group-name /aws/eks/$CLUSTER_NAME/cluster

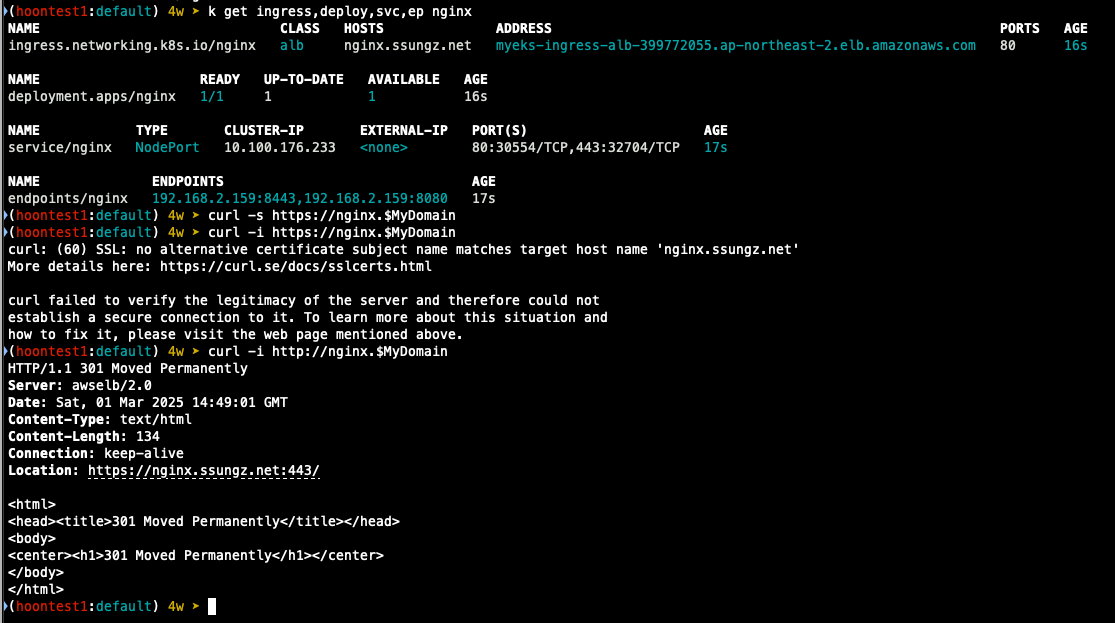

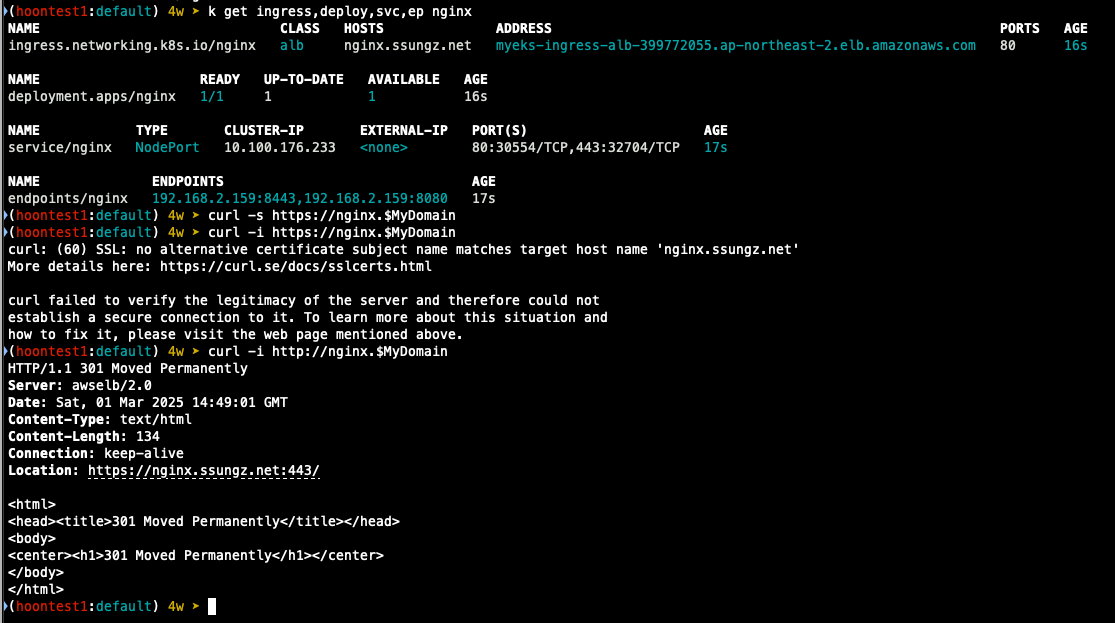

실습을 위한 Pod 배포

- NGINX 파드 배포

## nginx 웹서버 배포

$ helm repo add bitnami https://charts.bitnami.com/bitnami

$ helm repo update

## 도메인, 인증서 확인

$ echo $MyDomain $CERT_ARN

## 파라미터 파일 생성

$ cat <<EOT > nginx-values.yaml

service:

type: NodePort

networkPolicy:

enabled: false

resourcesPreset: "nano"

ingress:

enabled: true

ingressClassName: alb

hostname: nginx.$MyDomain

pathType: Prefix

path: /

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

EOT

## 배포

$ helm install nginx bitnami/nginx --version 19.0.0 -f nginx-values.yaml

## 생성 확인

$ k get ingress,deploy,svc,ep nginx

$ k describe deploy nginx

$ k get targetgroupbindings

## 접속 테스트

$ curl -s https://nginx.$MyDomain

## 로그 확인

$ k stern deploy/nginx

# 반복 접속

$ while true; do curl -s https://nginx.$MyDomain | grep title; date; sleep 1; done

$ while true; do curl -s https://nginx.$MyDomain -I | head -n 1; date; sleep 1; done

- 컨테이너 로그 환경의 로그는 표준 출력 stdou과 표준 에러 stderr로 보내는 것을 권고

## 로그 모니터링

$ k stern deploy/nginx

## 컨테이너 로그 파일 위치

$ k exec -it deploy/nginx -- ls -l /opt/bitnami/nginx/logs/

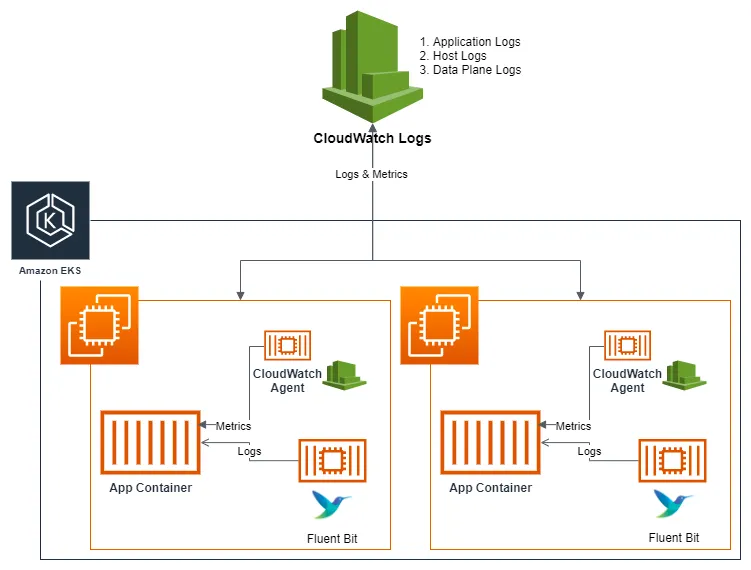

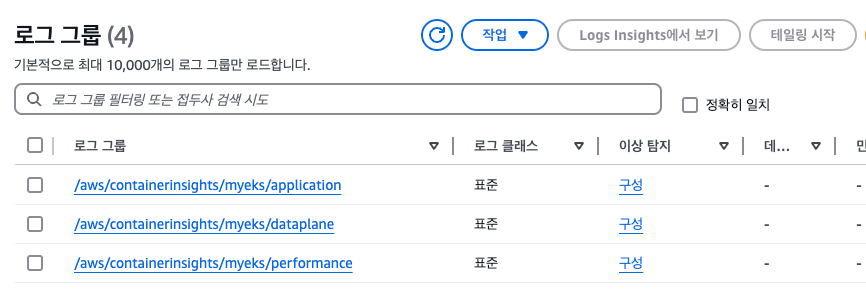

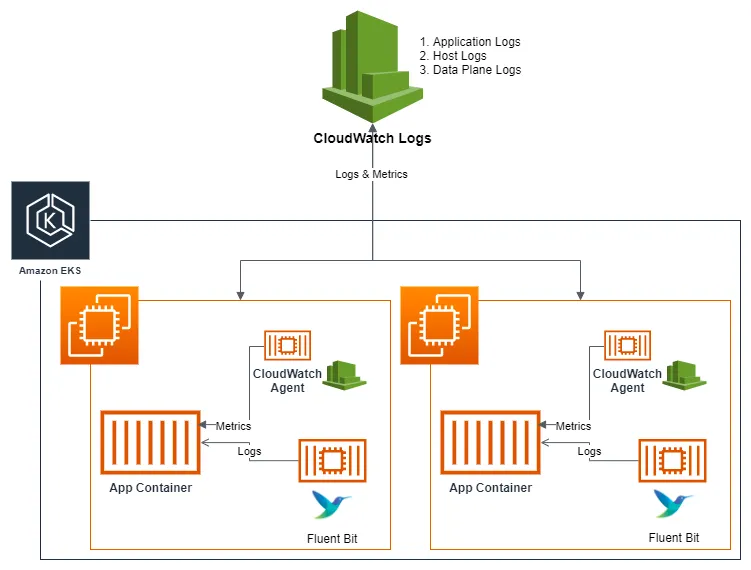

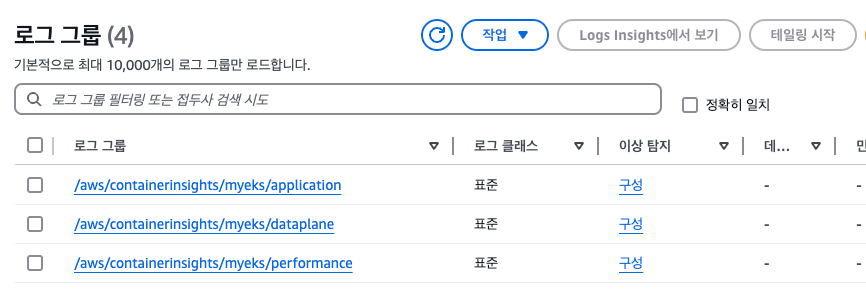

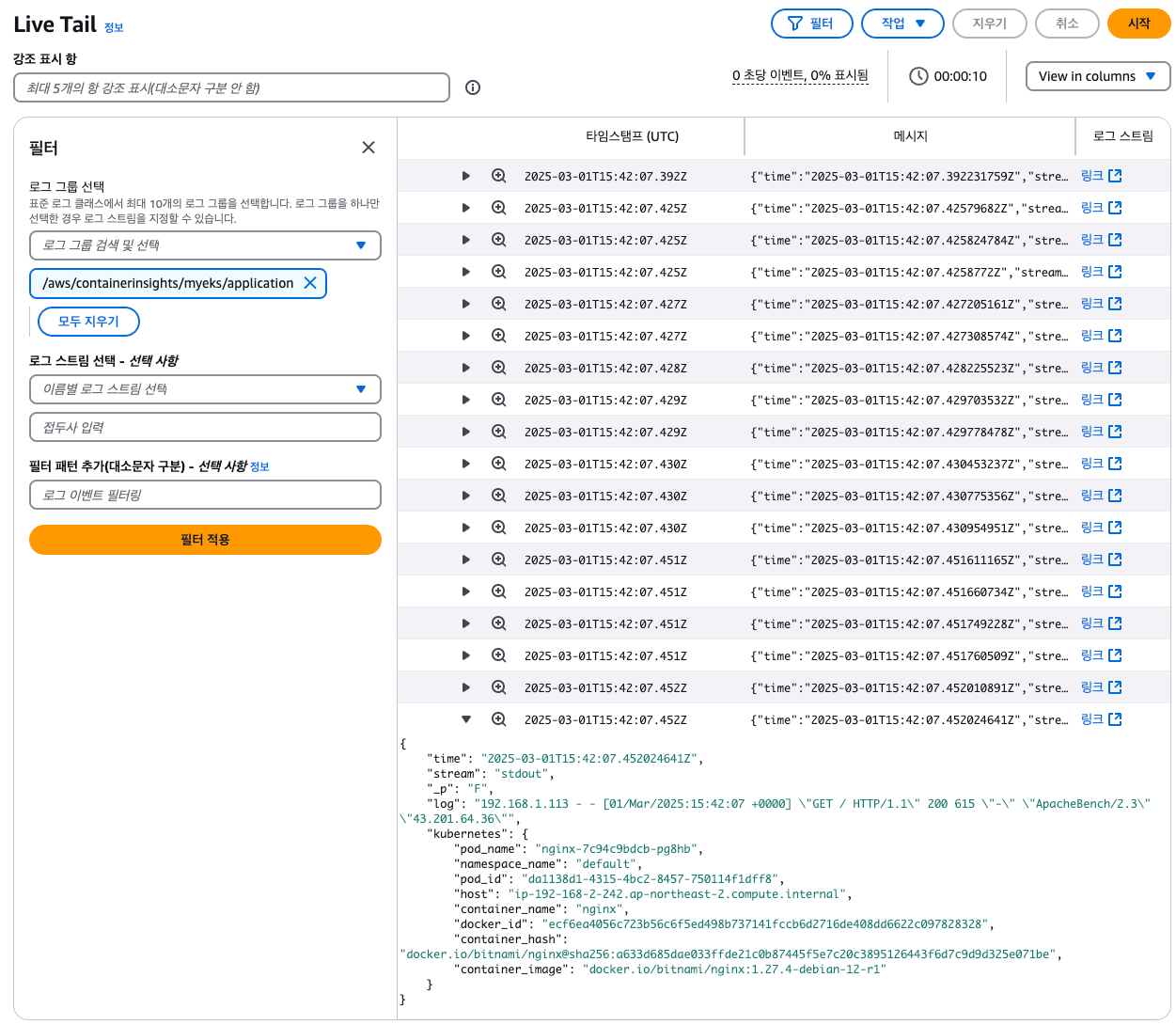

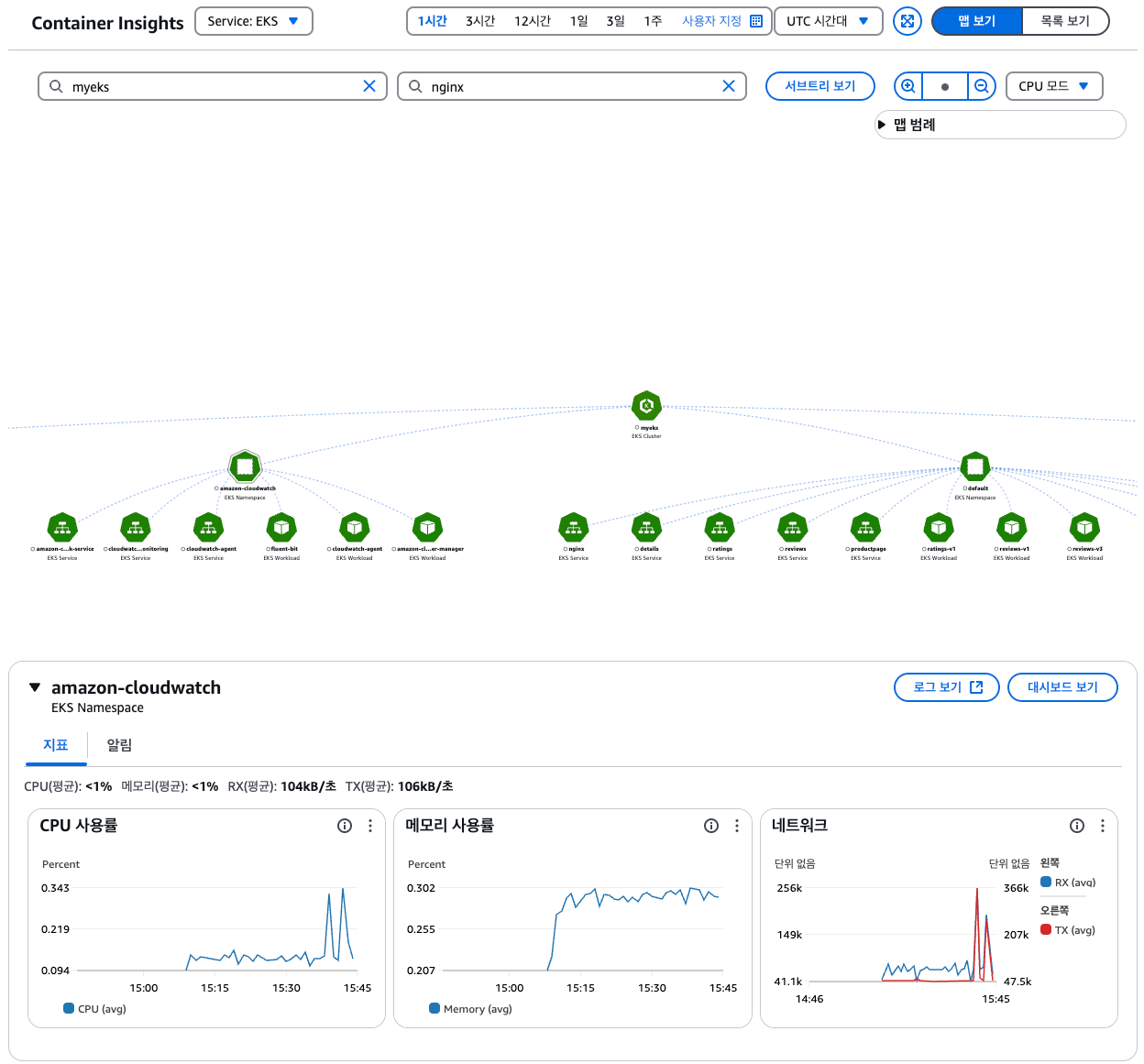

Container Insights metrics in Amazon CloudWatch & Fluent Bit

- Fluent Bit 컨테이너를 데몬셋으로 동작시키고, 아래 로그를 CloudWatch Logs에 전송

1. /aws/containerinsights/cluster_name/application : 각 컨테이너/파드 로그

2. /aws/containerinsights/cluster_name/host : 노드(호스트) 로그 (/var/log/dmesg, secure, messages)

3. /aws/containerinsights/cluster_name/dataplane : 쿠버네티스 데이터 플레인 로그 (journal, kubelet service, kubeproxy.service)

- [저장] : CloudWatch Logs 에 로그를 저장, 로그 그룹 별 로그 보존 기간 설정 가능

- [시각화] : CloudWatch 의 logs insights 를 사용하여 대상 로그를 분석하고, CloudWatch의 대시보드로 시각화

- 노드의 로그 확인

1) application 로그 소스, 파드로그

## 로그 위치 확인

$ for node in $N1 $N2 $N3; do echo ">>> $node <<<"; ssh ec2-user@$node sudo tree /var/log/containers; echo; done

$ for node in $N1 $N2 $N3; do echo ">>> $node <<<"; ssh ec2-user@$node sudo ls -al /var/log/containers; echo; done

2) host 로그 소스, 노드 로그

## 로그 위치

$ for node in $N1 $N2 $N3; do echo ">>>>> $node <<<<<"; ssh ec2-user@$node sudo tree /var/log/ -L 1; echo; done

$ for node in $N1 $N2 $N3; do echo ">>>>> $node <<<<<"; ssh ec2-user@$node sudo ls -la /var/log/; echo; done

## 호스트 로그 화깅ㄴ

## AML 운영체제는 rocky 계열과 로그 이름이 다름

$ for node in $N1 $N2 $N3; do echo ">>>>> $node <<<<<"; ssh ec2-user@$node sudo cat /var/log/audit/audit.log; echo; done

3) dataplane로그 소스 쿠버네티스 데이터 플레인 로그

## 로그 위치 확인

$ for node in $N1, $N2 $N3; do echo ">>>> $node <<<<"; ssh ec2-user@$node sudo tree /var/log/journal -L 1; echo; done

## 저널 로그 확인

$ ssh ec2-user@$N3 sudo journalctl -x -n 200

$ ssh ec2-user@$N3 sudo journalctl -f## CloudWatch Container Observability 설치

## IRSA 설정

$ eksctl create iamserviceaccount \

--name cloudwatch-agent \

--namespace amazon-cloudwatch --cluster $CLUSTER_NAME \

--role-name $CLUSTER_NAME-cloudwatch-agent-role \

--attach-policy-arn arn:aws:iam::aws:policy/CloudWatchAgentServerPolicy \

--role-only \

--approve

## addon 배포

$ aws eks create-addon --addon-name amazon-cloudwatch-observability --cluster-name myeks --service-account-role-arn arn:aws:iam::<IAM User Account ID직접 입력>:role/myeks-cloudwatch-agent-role

## addon 확인

aws eks list-addons --cluster-name myeks --output table

## 설치 확인

$ k get crd | grep -i cloudwatch

amazoncloudwatchagents.cloudwatch.aws.amazon.com 2025-03-01T15:06:51Z

dcgmexporters.cloudwatch.aws.amazon.com 2025-03-01T15:06:51Z

instrumentations.cloudwatch.aws.amazon.com 2025-03-01T15:06:52Z

neuronmonitors.cloudwatch.aws.amazon.com 2025-03-01T15:06:52Z

- cloudwatch-agent 설정 확인

## cloudwatch-agent 설정 확인

$ k describe cm cloudwatch-agent -n amazon-cloudwatch

Name: cloudwatch-agent

Namespace: amazon-cloudwatch

Labels: app.kubernetes.io/component=amazon-cloudwatch-agent

app.kubernetes.io/instance=amazon-cloudwatch.cloudwatch-agent

app.kubernetes.io/managed-by=amazon-cloudwatch-agent-operator

app.kubernetes.io/name=cloudwatch-agent

app.kubernetes.io/part-of=amazon-cloudwatch-agent

app.kubernetes.io/version=1.300052.0b1024

Annotations: <none>

Data

====

cwagentconfig.json:

----

{"agent":{"region":"ap-northeast-2"},"logs":{"metrics_collected":{"application_signals":{"hosted_in":"myeks"},"kubernetes":{"cluster_name":"myeks","enhanced_container_insights":true}}},"traces":{"traces_collected":{"application_signals":{}}}}

BinaryData

====

Events: <none>

$ k get cm cloudwatch-agent -n amazon-cloudwatch -o jsonpath="{.data.cwagentconfig\.json}" | jq

{

"agent": {

"region": "ap-northeast-2"

},

"logs": {

"metrics_collected": {

"application_signals": {

"hosted_in": "myeks"

},

"kubernetes": {

"cluster_name": "myeks",

"enhanced_container_insights": true

}

}

},

"traces": {

"traces_collected": {

"application_signals": {}

}

}

}

## fluent bit 로그의 input/filter/output 설정 확인

$ k describe cm fluent-bit-config -n amazon-cloudwatch

application-log.conf:

----

[INPUT]

Name tail

Tag application.*

Exclude_Path /var/log/containers/cloudwatch-agent*, /var/log/containers/fluent-bit*, /var/log/containers/aws-node*, /var/log/containers/kube-proxy*

Path /var/log/containers/*.log

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_container.db

Mem_Buf_Limit 50MB

Skip_Long_Lines On

Refresh_Interval 10

Rotate_Wait 30

storage.type filesystem

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag application.*

Path /var/log/containers/fluent-bit*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_log.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag application.*

Path /var/log/containers/cloudwatch-agent*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_cwagent.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[FILTER]

Name aws

Match application.*

az false

ec2_instance_id false

Enable_Entity true

[FILTER]

Name kubernetes

Match application.*

Kube_URL https://kubernetes.default.svc:443

Kube_Tag_Prefix application.var.log.containers.

Merge_Log On

Merge_Log_Key log_processed

K8S-Logging.Parser On

K8S-Logging.Exclude Off

Labels Off

Annotations Off

Use_Kubelet On

Kubelet_Port 10250

Buffer_Size 0

Use_Pod_Association On

[OUTPUT]

Name cloudwatch_logs

Match application.*

region ${AWS_REGION}

log_group_name /aws/containerinsights/${CLUSTER_NAME}/application

log_stream_prefix ${HOST_NAME}-

auto_create_group true

extra_user_agent container-insights

add_entity true

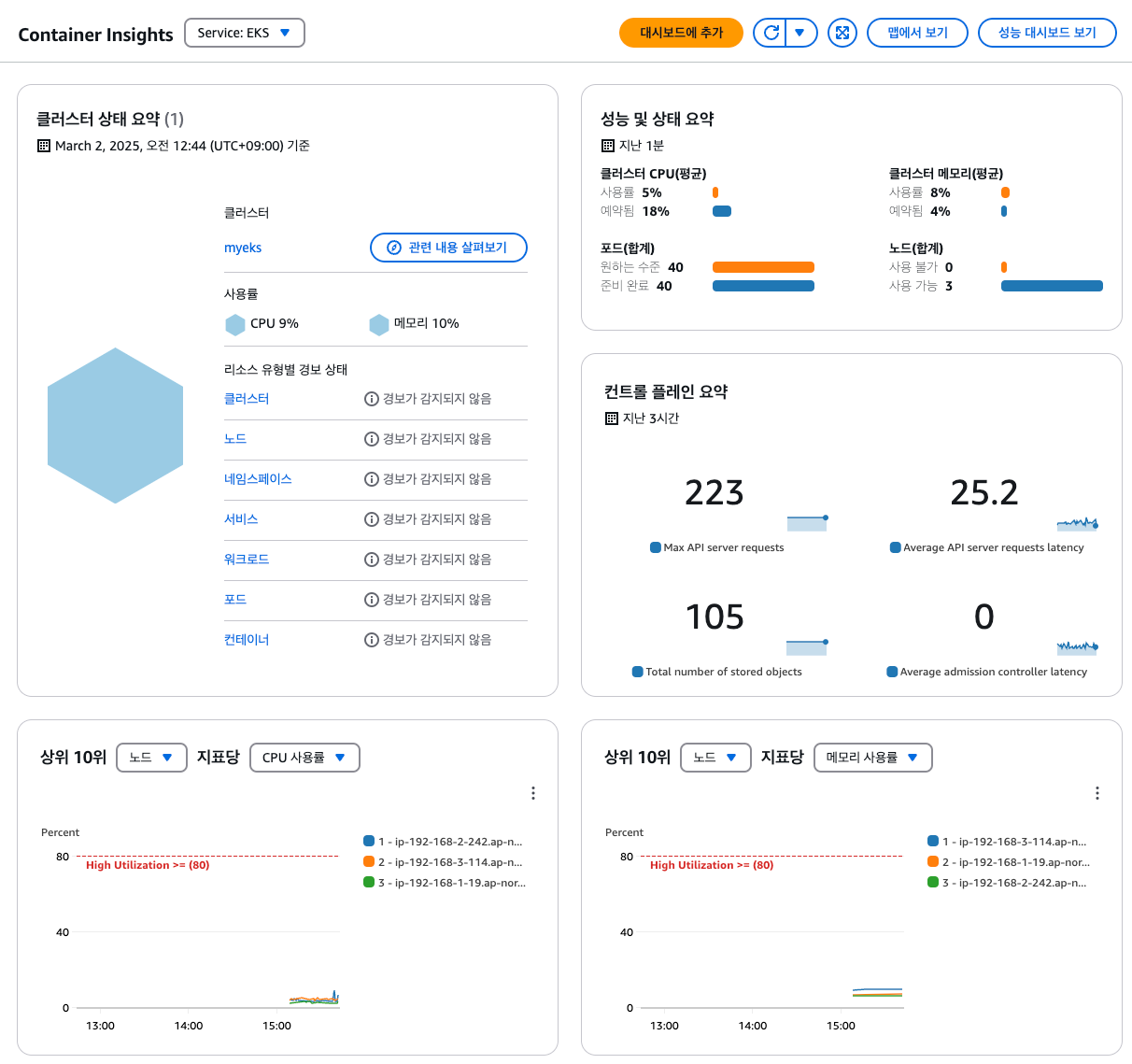

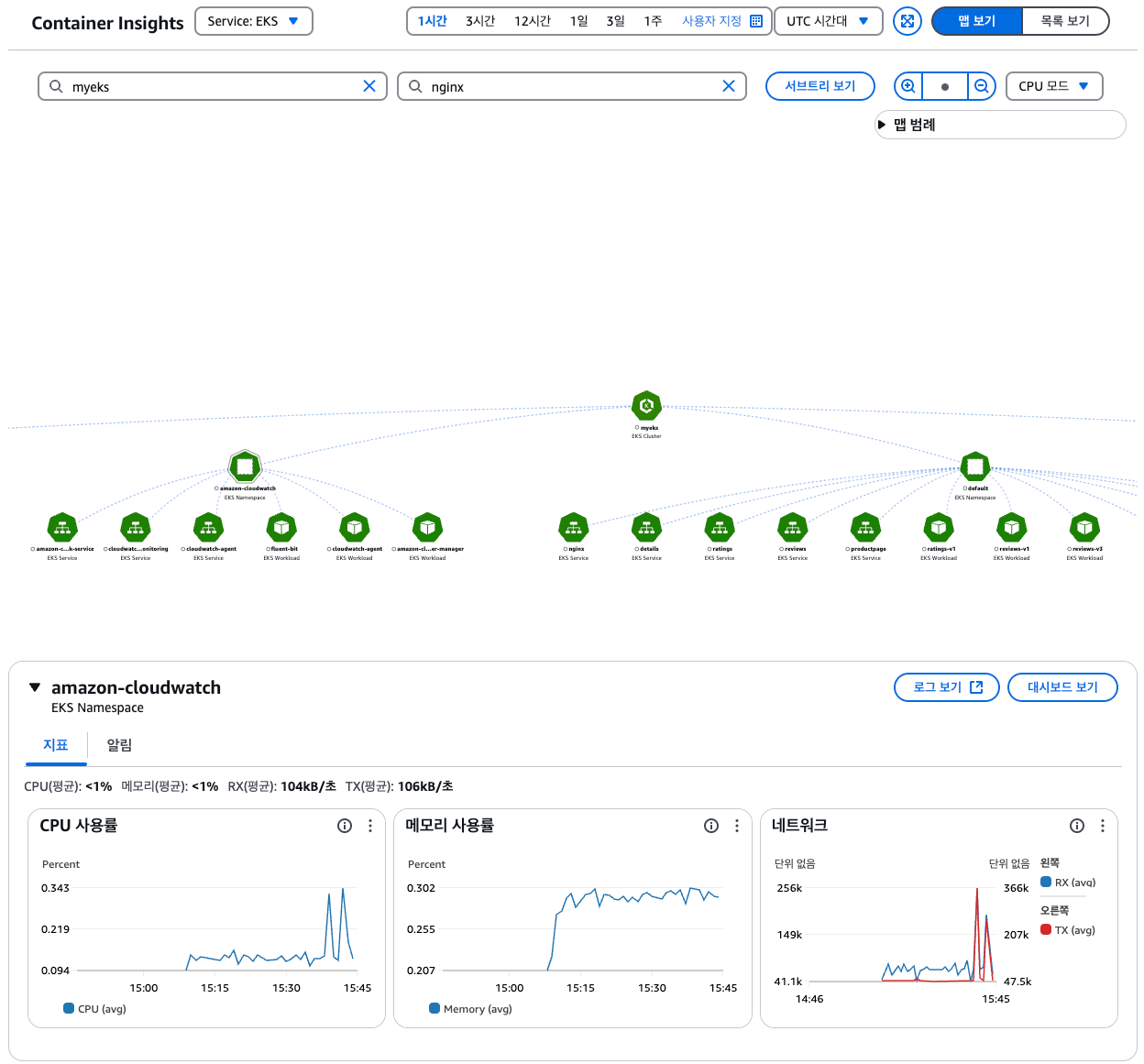

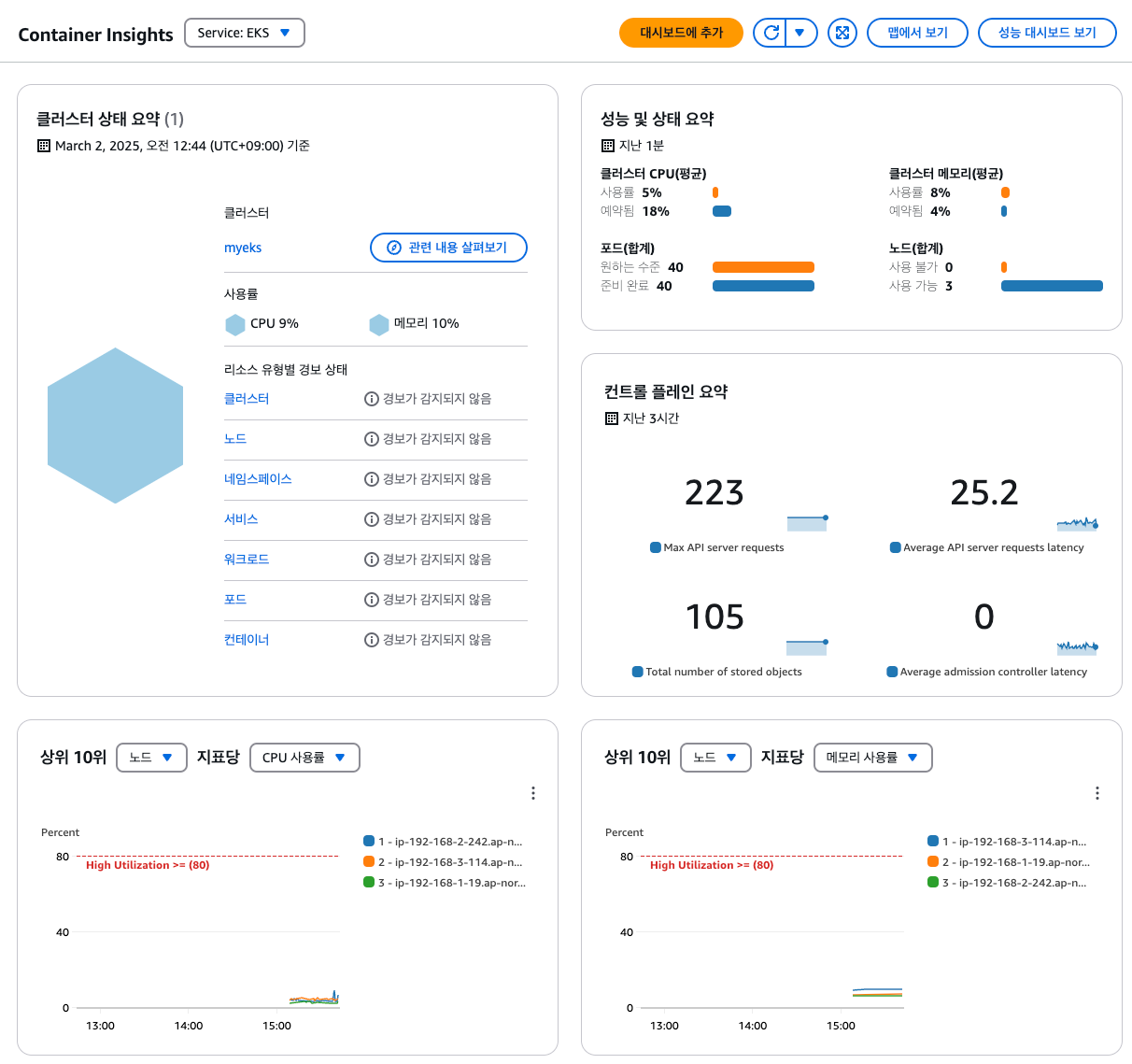

- (콘솔) 메트릭 확인 : CW > 인사이트 > Container Insights

운영 서버 EC2 에서 반복 접근하고 로그 확인하기

## 부하 발생

$ yum install -y httpd

$ ab -c 500 -n 30000 https://nginx.$MyDomain/

## 파드 로그 확인

$ k stern deploy/nginx

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

- 콘솔에서 확인하기

- 메트릭 확인 : cloudwatch > insights > container insights

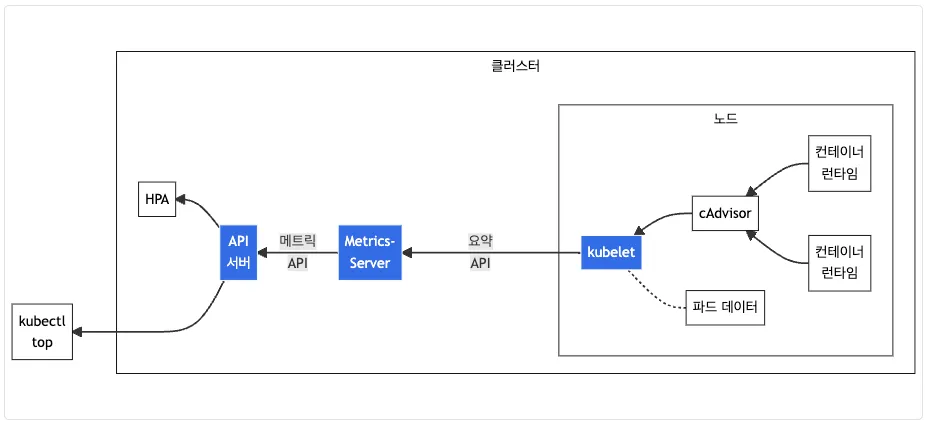

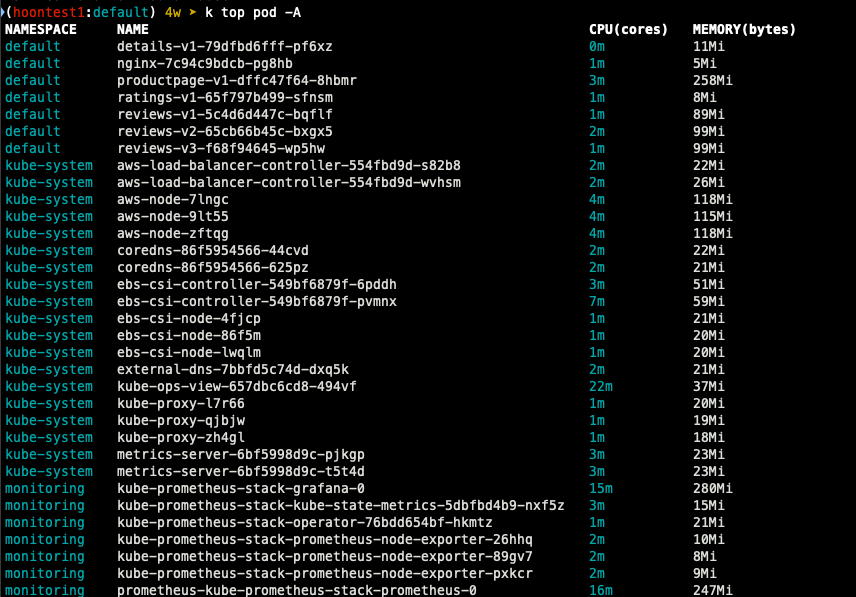

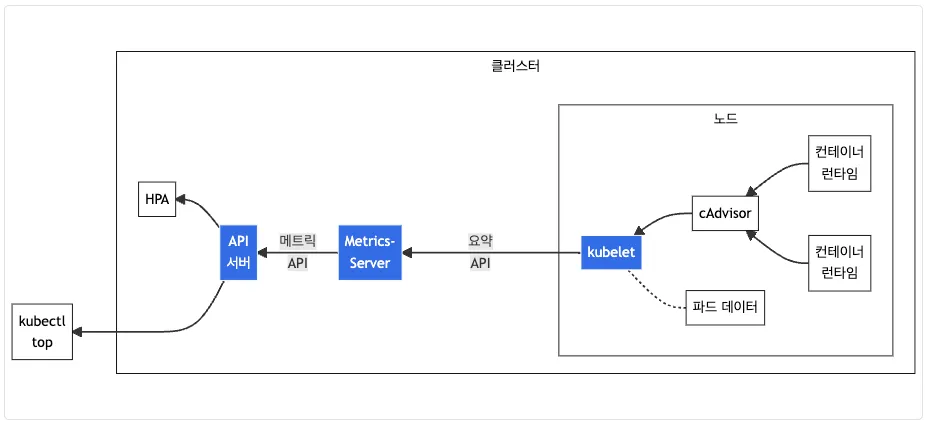

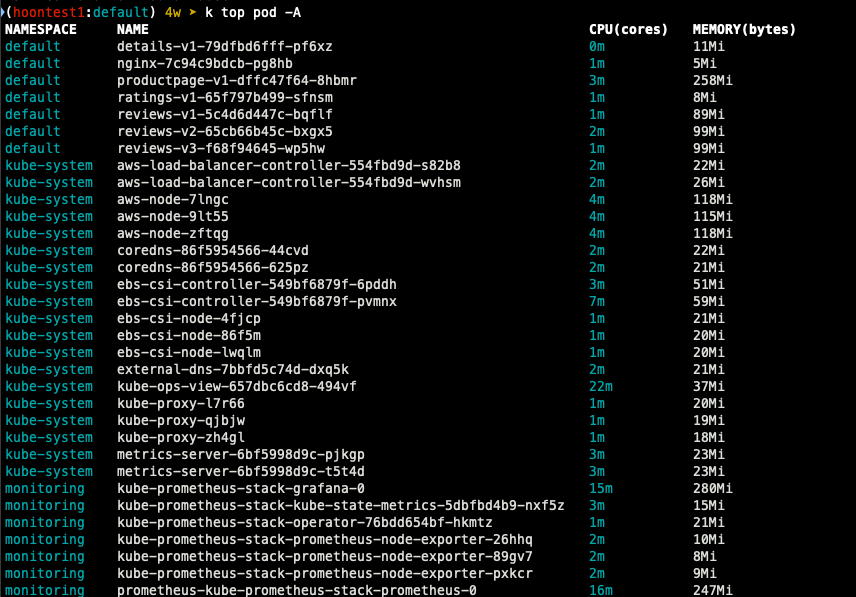

Metric-Server & kwatch & botkube

Metrics-server 확인 : kubelet으로부터 수집한 리소스 메트릭을 수집 및 집계하는 클러스터 애드온 구성 요소

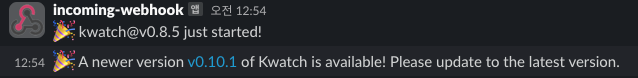

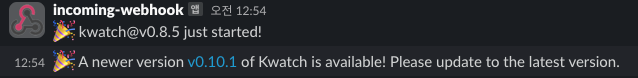

kwatch : 클러스터와 앱에서 탐지되는 것들을 실시간으로 slack, discord와 같은 도구에 노티해준다.

## 닉네임 설정

NICK=ssungz

## configmap 생성

$ cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Namespace

metadata:

name: kwatch

---

apiVersion: v1

kind: ConfigMap

metadata:

name: kwatch

namespace: kwatch

data:

config.yaml: |

alert:

slack:

webhook: 'slack webhook url'

title: $NICK-eks

pvcMonitor:

enabled: true

interval: 5

threshold: 70

EOF

## 배포

$ k apply -f https://raw.githubusercontent.com/abahmed/kwatch/v0.8.5/deploy/deploy.yaml

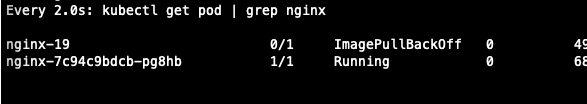

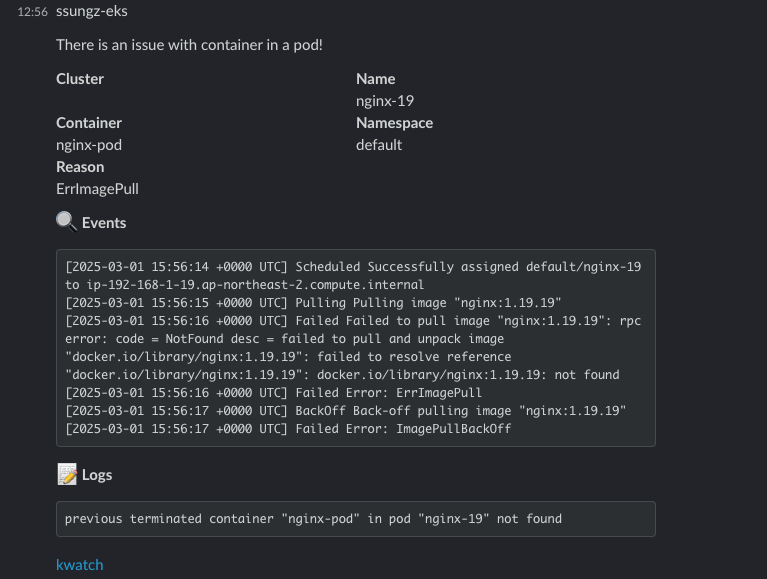

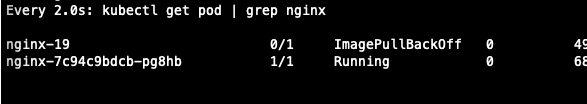

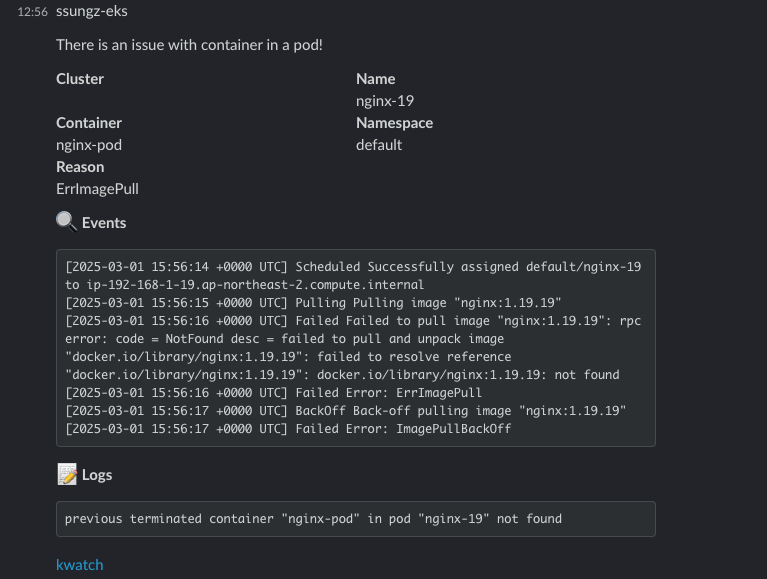

- 잘못된 이미지 파드 배포 및 확인

## 모니터링

$ watch kubectl get pod

## 잘못된 이미지 정보의 파드 배포

$ cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: nginx-19

spec:

containers:

- name: nginx-pod

image: nginx:1.19.19 # 존재하지 않는 이미지 버전

EOF

kubectl get events -w

## 이미지 업데이트 방안 : set 사용

$ k set image pod nginx-19 nginx-pod=nginx:1.19

## 삭제

$ k delete pod nginx-19

- Slack alert 확인

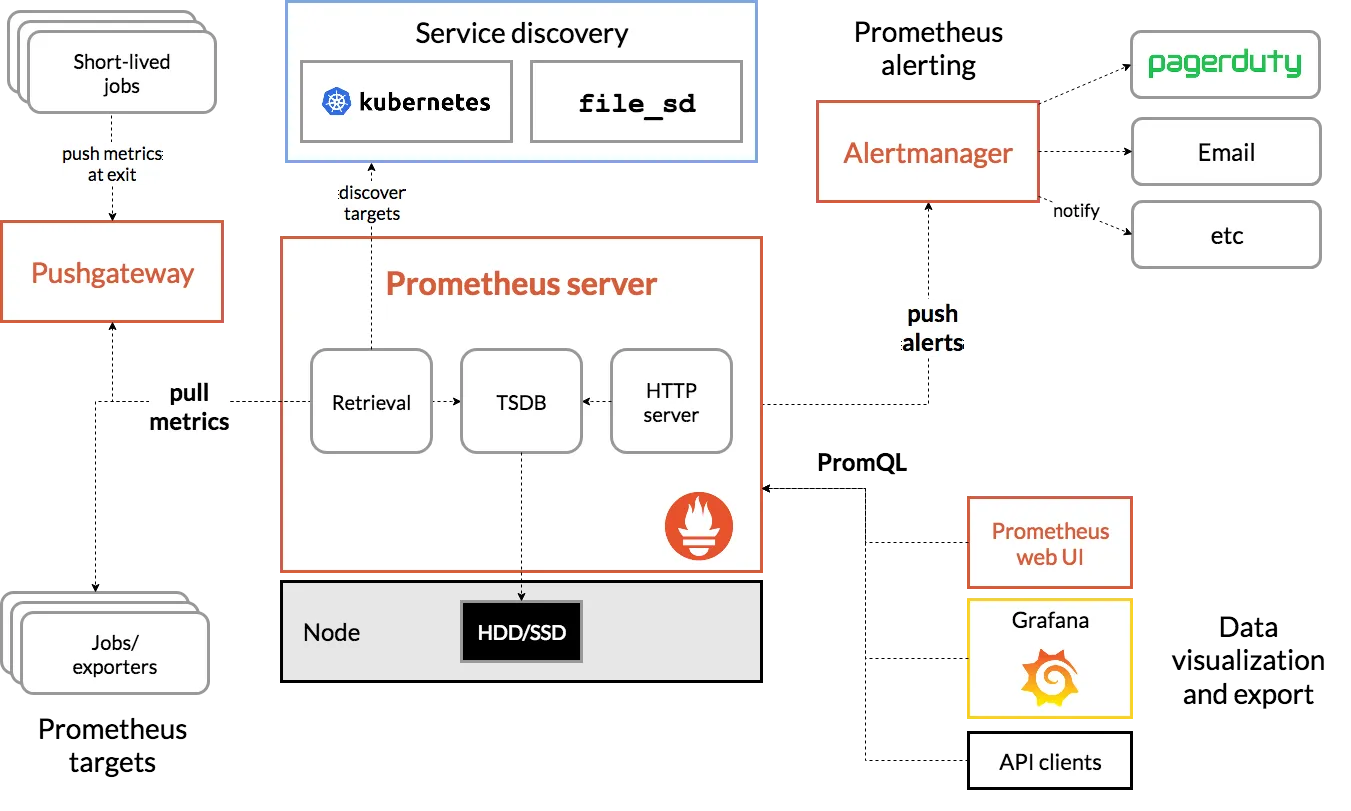

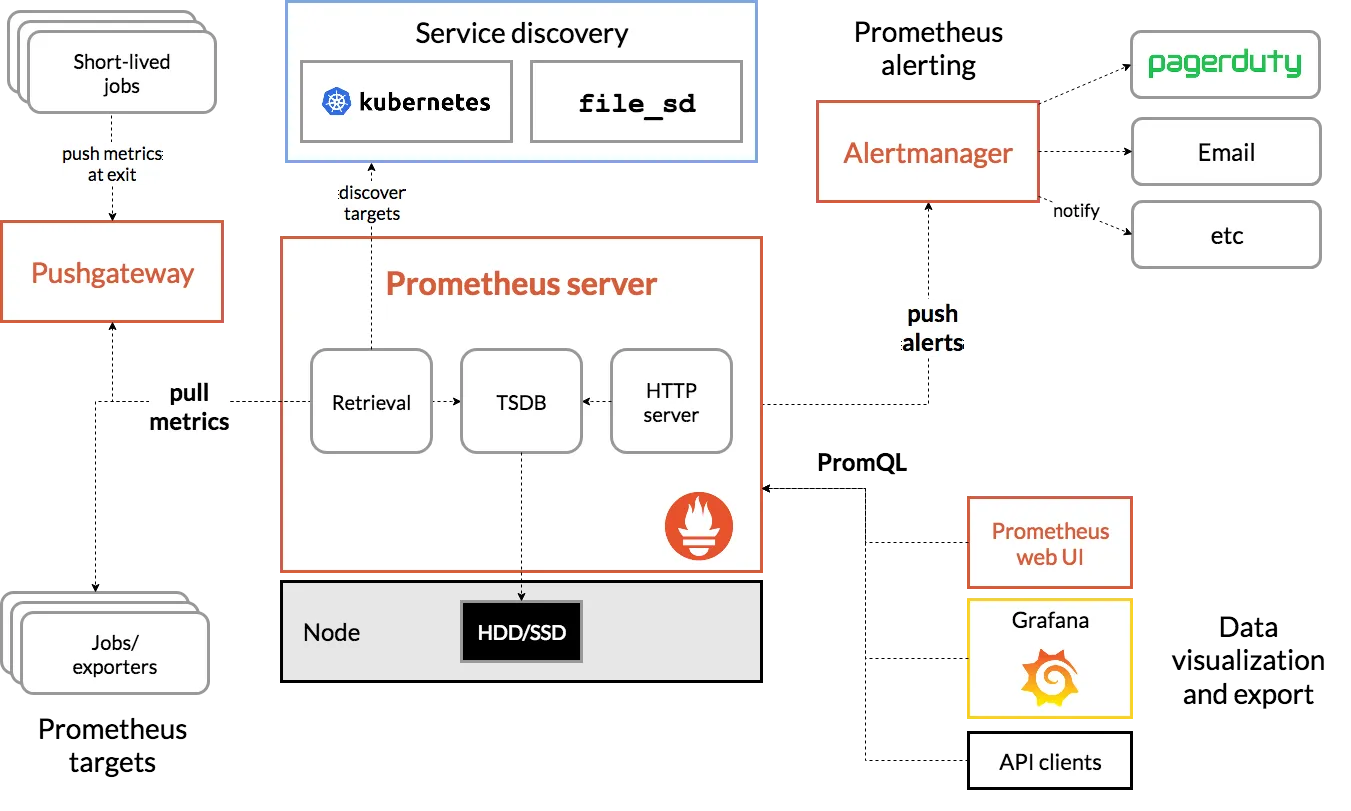

프로메테우스-스택

프로메테우스는 오픈소스로 모니터링과 alert를 주 기능으로 제공합니다.

다음은 해당 내용을 표로 만든 것입니다.

프로메테우스가 시각화에 뛰어나지 않기 때문에 시각화가 뛰어난 grafana에 data source로 추가하여 모니터링합니다.

| 구성 요소 | 설명 |

| Prometheus | 시계열(time-series) 데이터 수집 및 저장 |

| Grafana | Prometheus 데이터를 시각화하는 대시보드 도구 |

| Alertmanager | Prometheus 경고(Alert)를 관리 및 전송 |

| Node Exporter | Kubernetes 노드 및 시스템 메트릭 수집 |

| Kube State Metrics | Kubernetes 리소스 상태(Pod, Node, Deployment 등) 메트릭 제공 |

| cAdvisor | 컨테이너 리소스 사용량 모니터링 (CPU, 메모리, 디스크, 네트워크) |

운영 EC2에 프로메테우스 직접 설치

# 최신 버전 다운로드

wget https://github.com/prometheus/prometheus/releases/download/v3.2.0/prometheus-3.2.0.linux-amd64.tar.gz

# 압축 해제

tar -xvf prometheus-3.2.0.linux-amd64.tar.gz

cd prometheus-3.2.0.linux-amd64

ls -l

# 바이너리 파일 및 설정 파일 위치 이동

mv prometheus /usr/local/bin/

mv promtool /usr/local/bin/

mkdir -p /etc/prometheus /var/lib/prometheus

mv prometheus.yml /etc/prometheus/

cat /etc/prometheus/prometheus.yml

# 계정 생성 및 권한 설정

useradd --no-create-home --shell /sbin/nologin prometheus

chown -R prometheus:prometheus /etc/prometheus /var/lib/prometheus

chown prometheus:prometheus /usr/local/bin/prometheus /usr/local/bin/promtool

# 서비스 설정 변경

tee /etc/systemd/system/prometheus.service > /dev/null <<EOF

[Unit]

Description=Prometheus

Wants=network-online.target

After=network-online.target

[Service]

User=prometheus

Group=prometheus

Type=simple

ExecStart=/usr/local/bin/prometheus \

--config.file=/etc/prometheus/prometheus.yml \

--storage.tsdb.path=/var/lib/prometheus \

--web.listen-address=0.0.0.0:9090

[Install]

WantedBy=multi-user.target

EOF

# 서비스 등록 및 데몬 시작

systemctl daemon-reload

systemctl enable --now prometheus

systemctl status prometheus

ss -tnlp

# 접속 테스트

curl localhost:9090/metrics

echo -e "http://$(curl -s ipinfo.io/ip):9090"

- node_exporter 설치

서버의 OS 메트릭을 수집 (CPU, Disk, FS 정보가 있는 /proc, /sys를 통해 수집)

# Node Exporter 최신 버전 다운로드

cd ~

wget https://github.com/prometheus/node_exporter/releases/download/v1.9.0/node_exporter-1.9.0.linux-amd64.tar.gz

tar xvfz node_exporter-1.9.0.linux-amd64.tar.gz

cd node_exporter-1.9.0.linux-amd64

cp node_exporter /usr/local/bin/

# 계정 생성 및 권한 설정

groupadd -f node_exporter

useradd -g node_exporter --no-create-home --shell /sbin/nologin node_exporter

chown node_exporter:node_exporter /usr/local/bin/node_exporter

# 서비스 정보 설정

tee /etc/systemd/system/node_exporter.service > /dev/null <<EOF

[Unit]

Description=Node Exporter

Documentation=https://prometheus.io/docs/guides/node-exporter/

Wants=network-online.target

After=network-online.target

[Service]

User=node_exporter

Group=node_exporter

Type=simple

Restart=on-failure

ExecStart=/usr/local/bin/node_exporter \

--web.listen-address=:9200

[Install]

WantedBy=multi-user.target

EOF

# 서비스 등록 및 실행

systemctl daemon-reload

systemctl enable --now node_exporter

systemctl status node_exporter

ss -tnlp

# 접속 테스트

curl localhost:9200/metrics

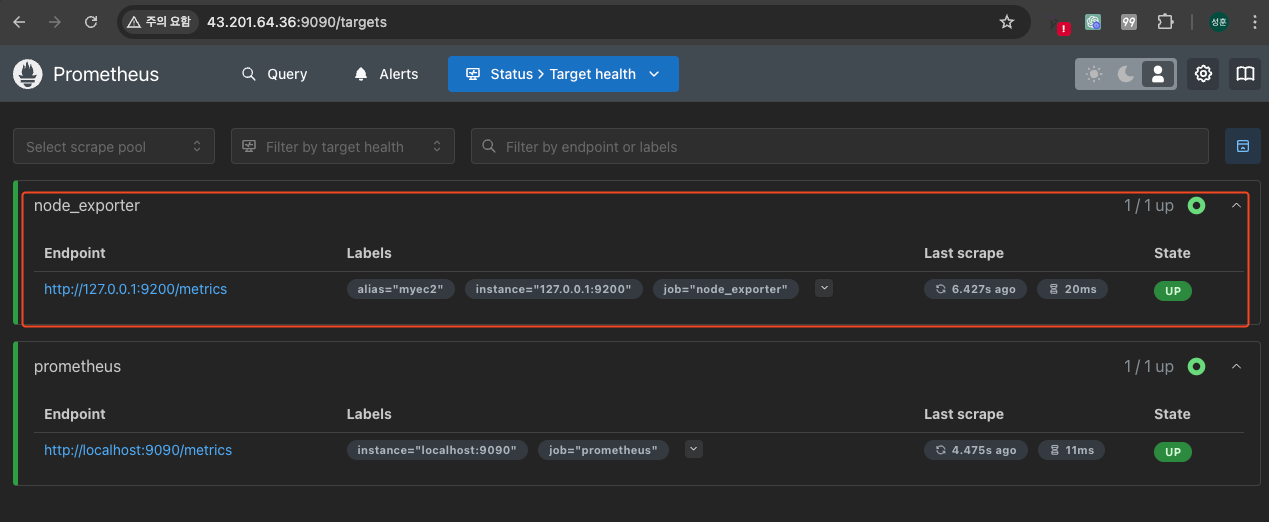

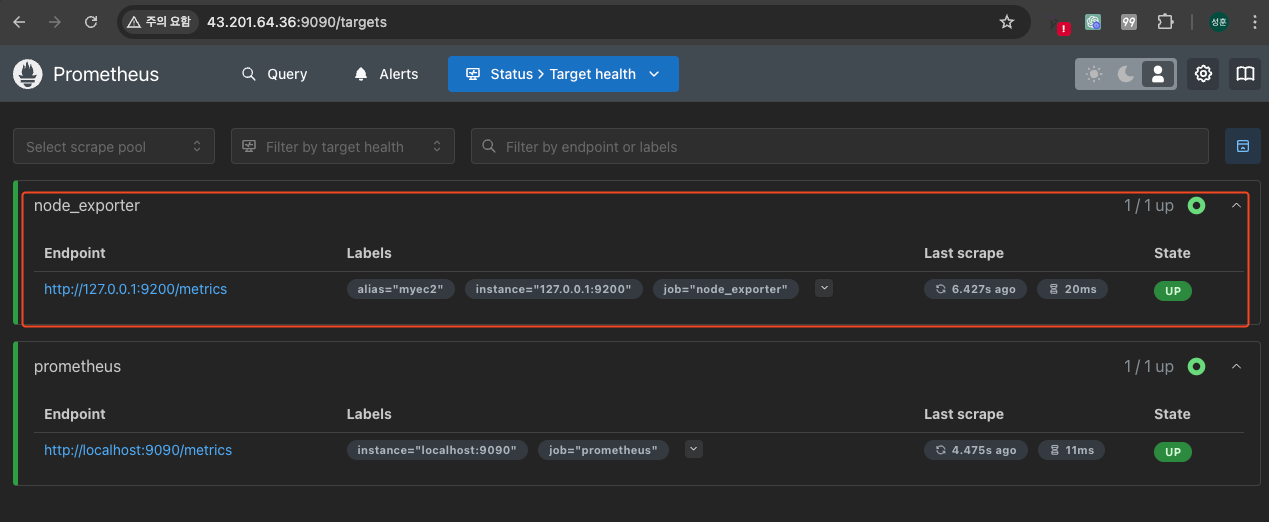

- prometheus 설정 수집 대상 target 추가

# prometheus.yml 수정

cat << EOF >> /etc/prometheus/prometheus.yml

- job_name: 'node_exporter'

static_configs:

- targets: ["127.0.0.1:9200"]

labels:

alias: 'myec2'

EOF

# prometheus 데몬 재기동

systemctl restart prometheus.service

systemctl status prometheus

- 프로메테우스-스택 설치

# 모니터링

watch kubectl get pod,pvc,svc,ingress -n monitoring

# repo 추가

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

# 파라미터 파일 생성

cat <<EOT > monitor-values.yaml

prometheus:

prometheusSpec:

scrapeInterval: "15s"

evaluationInterval: "15s"

podMonitorSelectorNilUsesHelmValues: false

serviceMonitorSelectorNilUsesHelmValues: false

retention: 5d

retentionSize: "10GiB"

storageSpec:

volumeClaimTemplate:

spec:

storageClassName: gp3

accessModes: ["ReadWriteOnce"]

resources:

requests:

storage: 30Gi

ingress:

enabled: true

ingressClassName: alb

hosts:

- prometheus.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

grafana:

defaultDashboardsTimezone: Asia/Seoul

adminPassword: prom-operator

ingress:

enabled: true

ingressClassName: alb

hosts:

- grafana.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

persistence:

enabled: true

type: sts

storageClassName: "gp3"

accessModes:

- ReadWriteOnce

size: 20Gi

alertmanager:

enabled: false

defaultRules:

create: false

kubeControllerManager:

enabled: false

kubeEtcd:

enabled: false

kubeScheduler:

enabled: false

prometheus-windows-exporter:

prometheus:

monitor:

enabled: false

EOT

cat monitor-values.yaml

# 배포

helm install kube-prometheus-stack prometheus-community/kube-prometheus-stack --version 69.3.1 \

-f monitor-values.yaml --create-namespace --namespace monitoring

## 확인

helm list -n monitoring

kubectl get sts,ds,deploy,pod,svc,ep,ingress,pvc,pv -n monitoring

kubectl get-all -n monitoring

kubectl get prometheus,servicemonitors -n monitoring

kubectl get crd | grep monitoring

kubectl df-pv

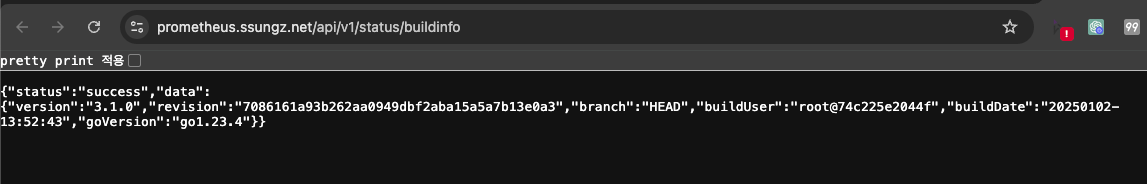

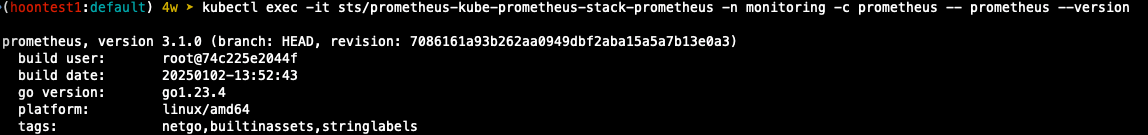

## 프로메테우스 버전 확인

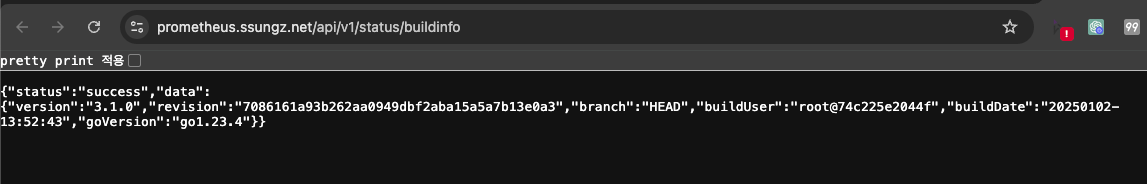

echo -e "https://prometheus.$MyDomain/api/v1/status/buildinfo"

open https://prometheus.$MyDomain/api/v1/status/buildinfo # macOS

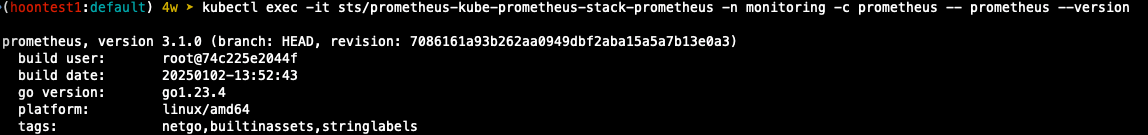

kubectl exec -it sts/prometheus-kube-prometheus-stack-prometheus -n monitoring -c prometheus -- prometheus --version

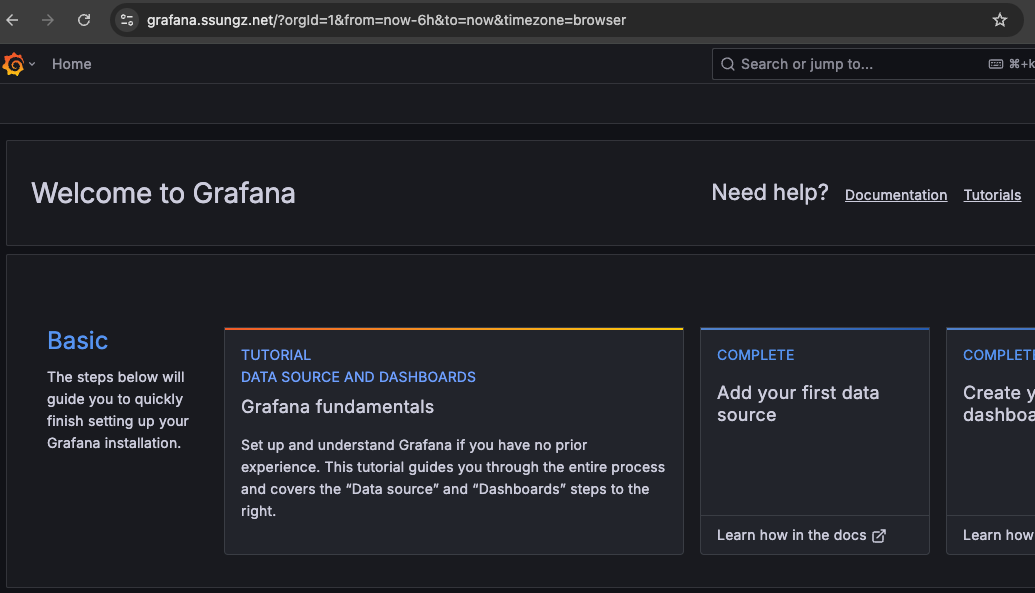

# 그라파나 웹 접속

echo -e "https://grafana.$MyDomain"

open "https://grafana.$MyDomain" # macOS

- 프로메테우스 버전

- 그라파나 웹 페이지 접속

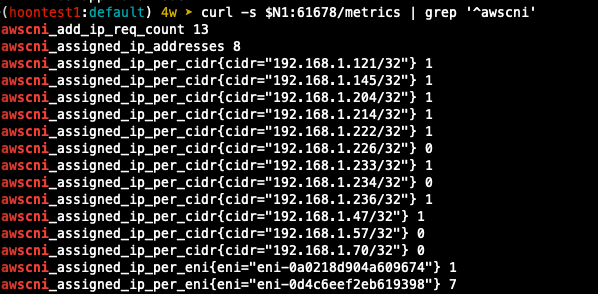

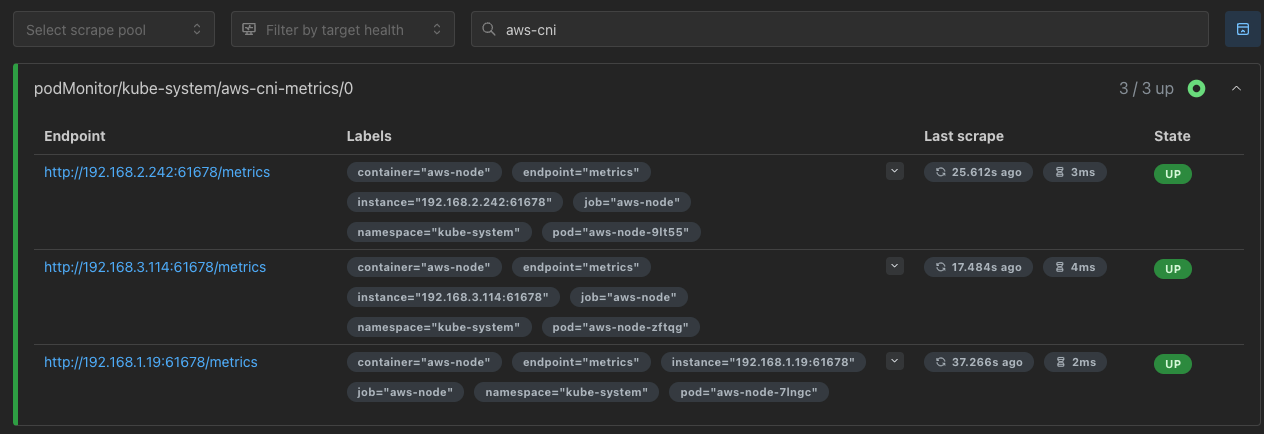

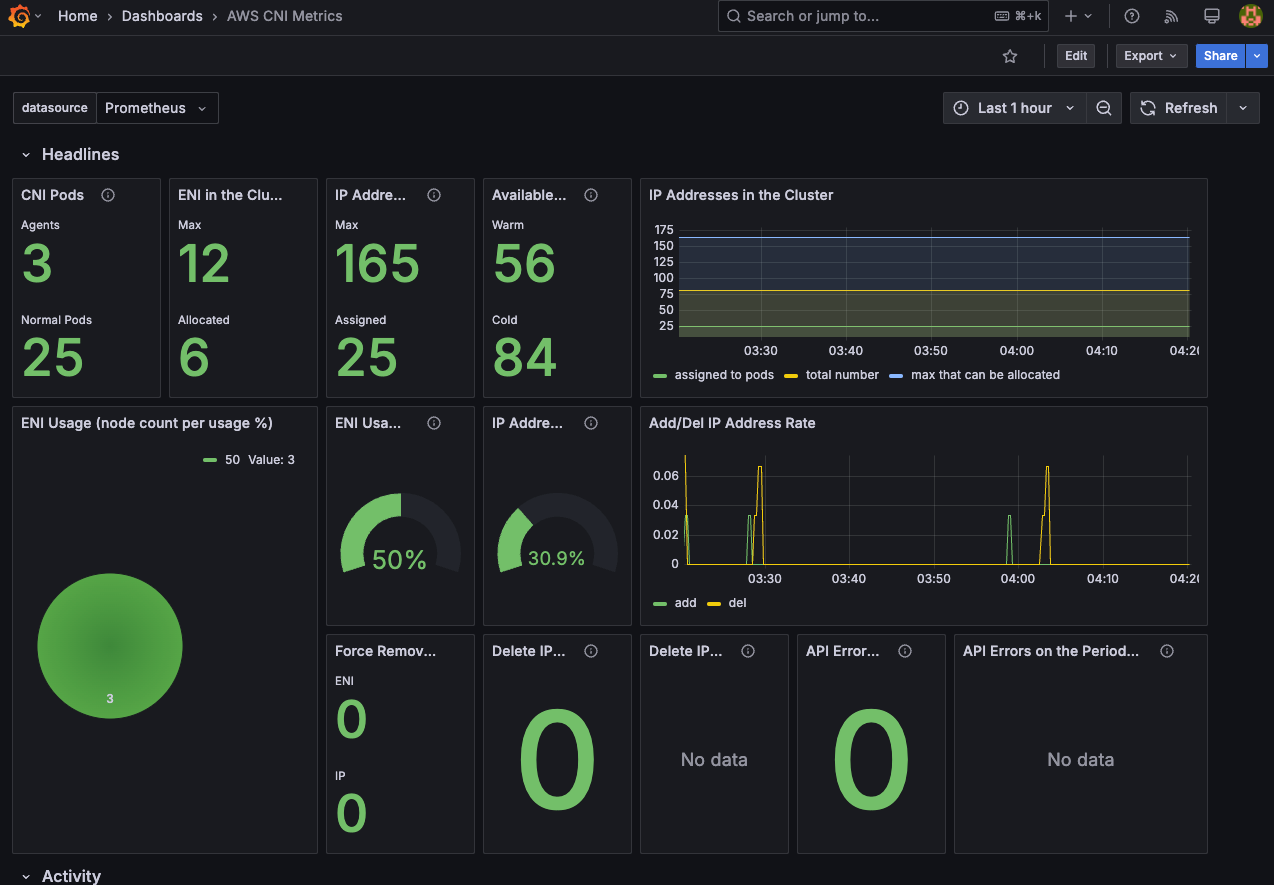

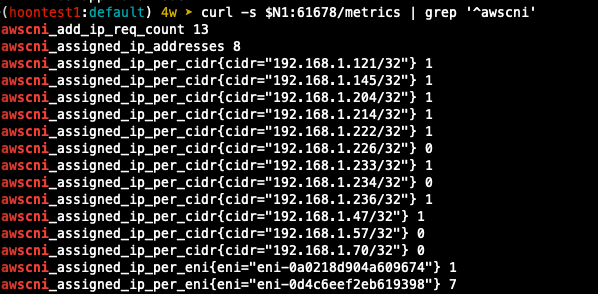

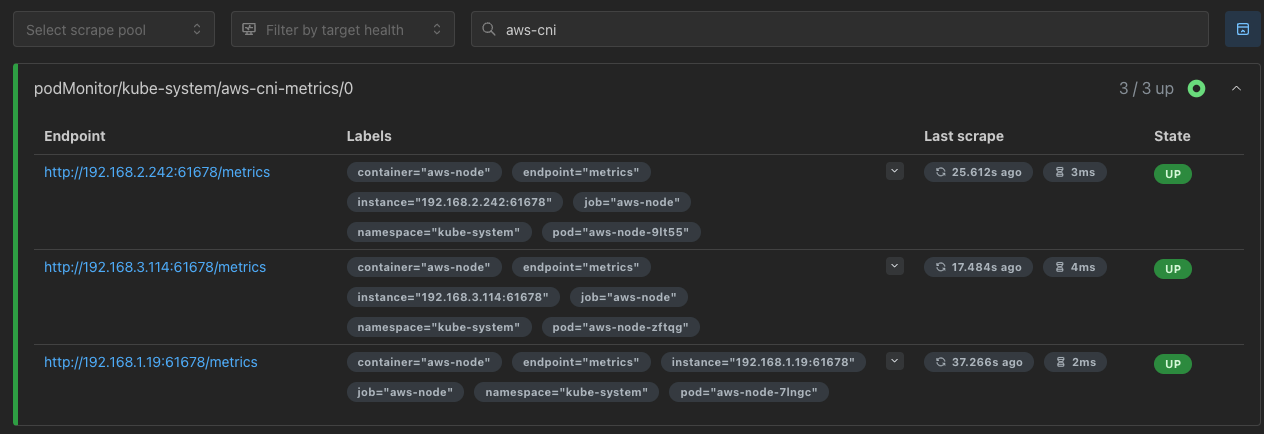

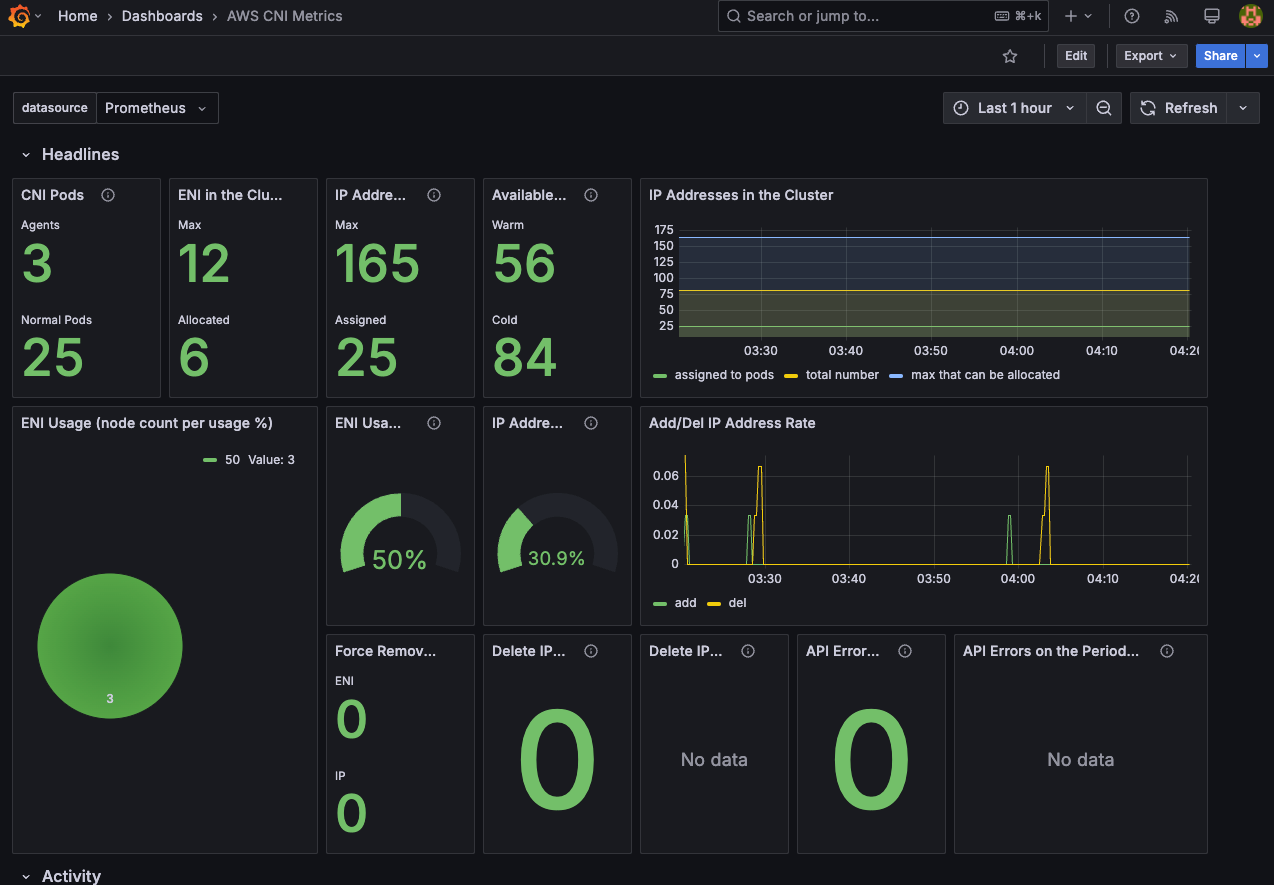

AWS CNI Metrics 수집

## 수집 전 사전 설정으로 podmonitor 배포

cat <<EOF | kubectl create -f -

apiVersion: monitoring.coreos.com/v1

kind: PodMonitor

metadata:

name: aws-cni-metrics

namespace: kube-system

spec:

jobLabel: k8s-app

namespaceSelector:

matchNames:

- kube-system

podMetricsEndpoints:

- interval: 30s

path: /metrics

port: metrics

selector:

matchLabels:

k8s-app: aws-node

EOF

## 배포 확인

$ k get podmonitor -n kube-system

$ k get podmonitor -n kube-system aws-cni-metrics -o yaml | k neat

## metrics url 접속 확인

$ curl -s $N1:61678/metrics | grep '^awscni'

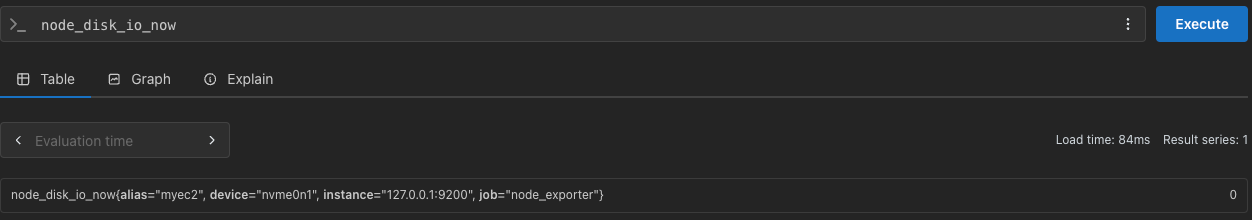

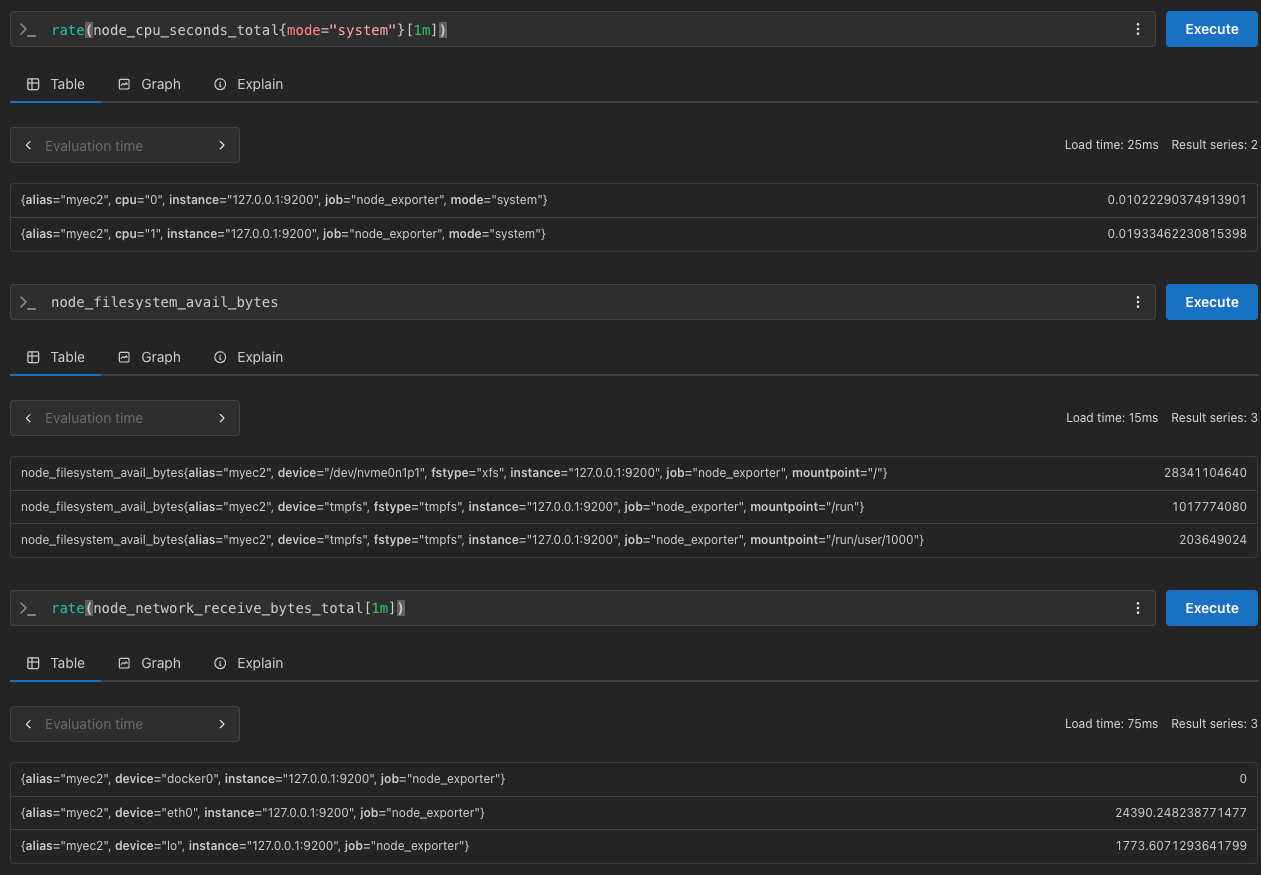

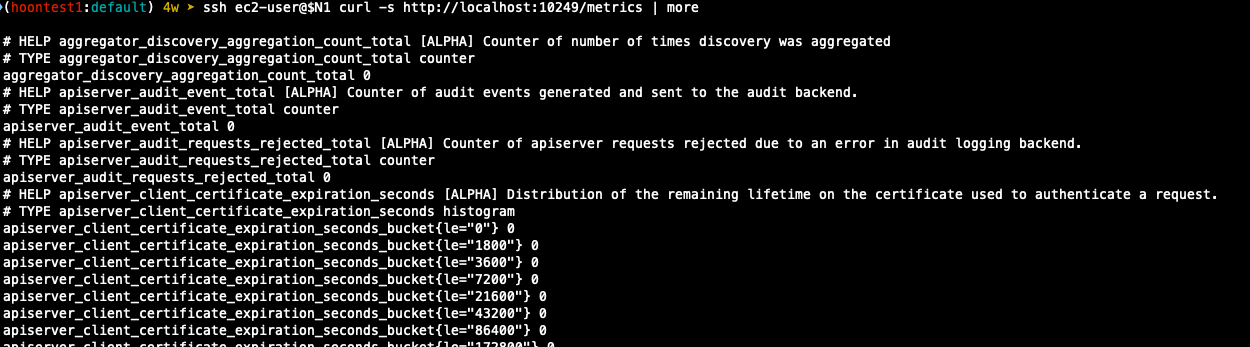

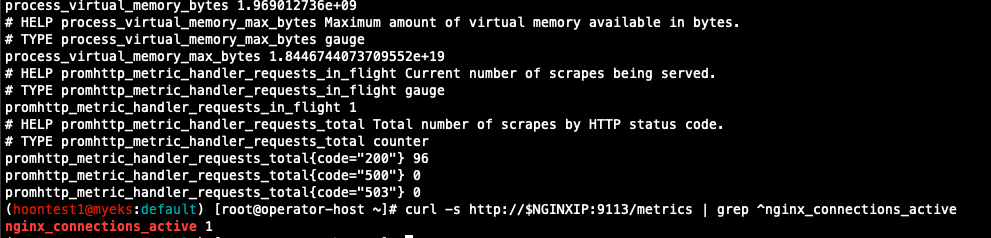

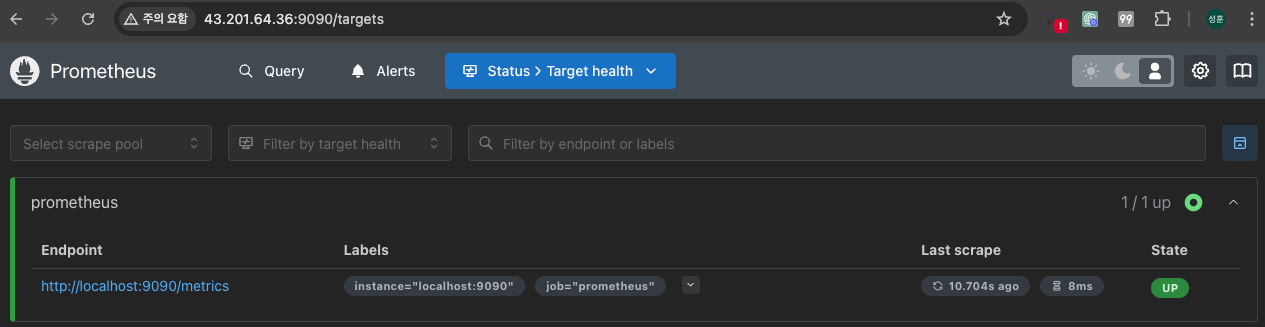

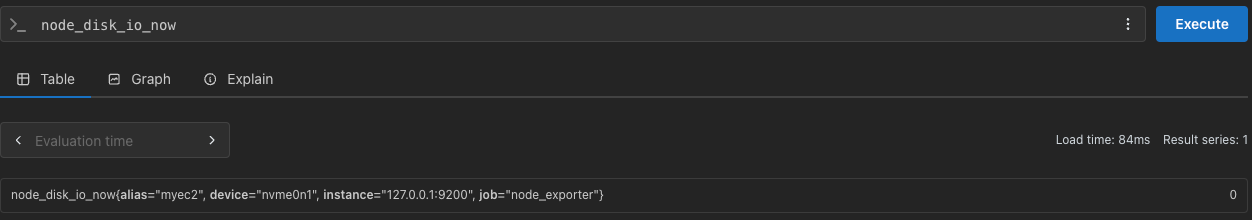

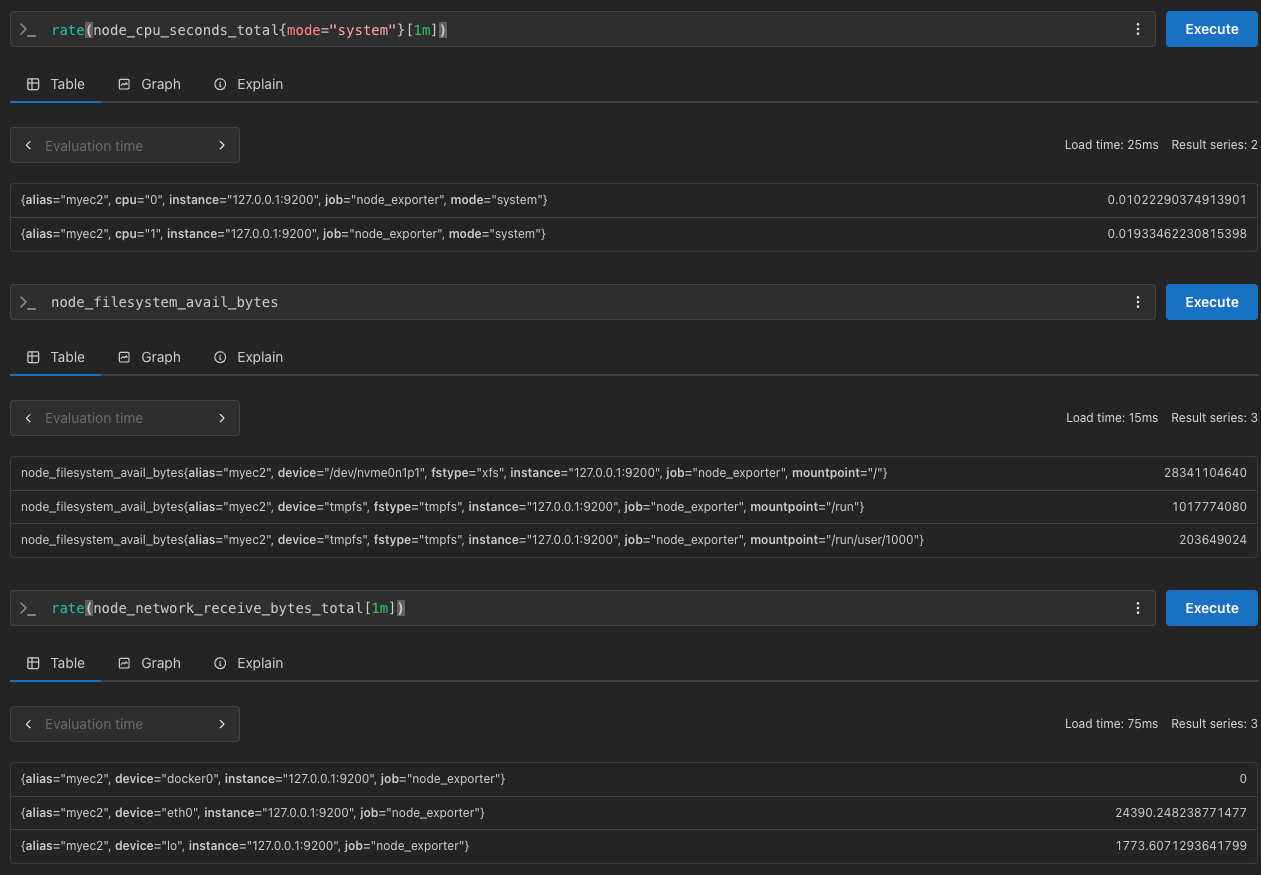

프로메테우스 기본 사용

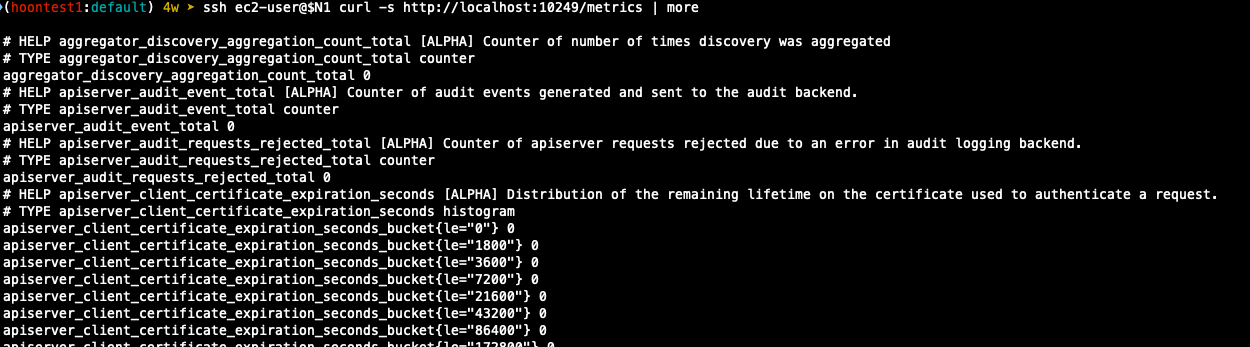

- 모니터링 대상이 되는 서비스는 일반적으로 자체 웹 서버의 /metrics 엔드포인트 경로에 다양한 메트릭 정보를 노출

- 이후 프로메테우스는 해당 경로에 http get 방식의 메트릭 정보를 가져와 TSDB 형식으로 저장

## 프로메테우스가 각 서비스의 포트로 접속하여 메트릭 정보 확인

$ k get node -o wide

$ k get svc,ep -n monitoring kube-prometheus-stack-prometheus-node-exporter

## (노드 익스포터 경우) 노드의 9100번 포트의 /metrics 접속 시 다양한 메트릭 정보르 확일할 수 있음

$ ssh ec2-user@$N1 curl -s localhost:9100/metrics

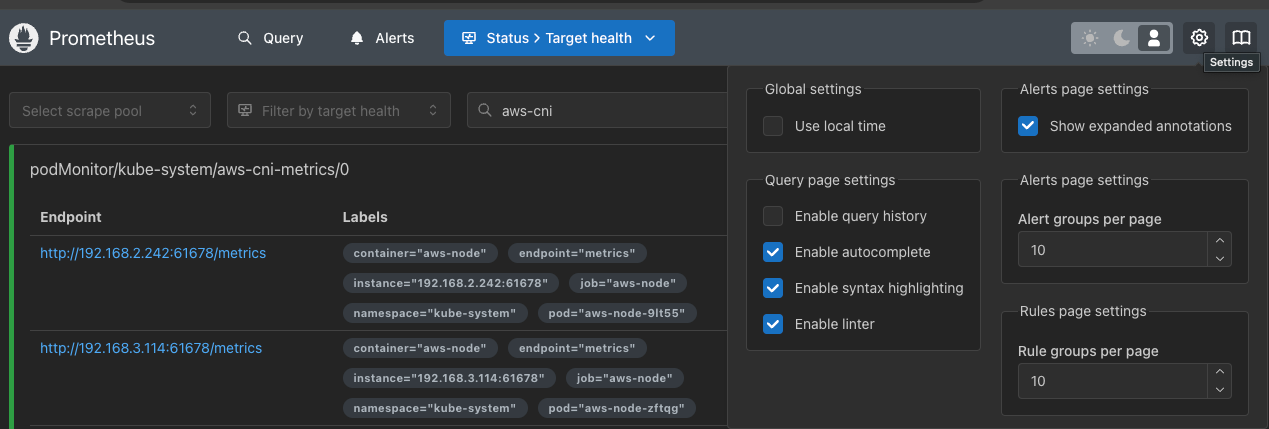

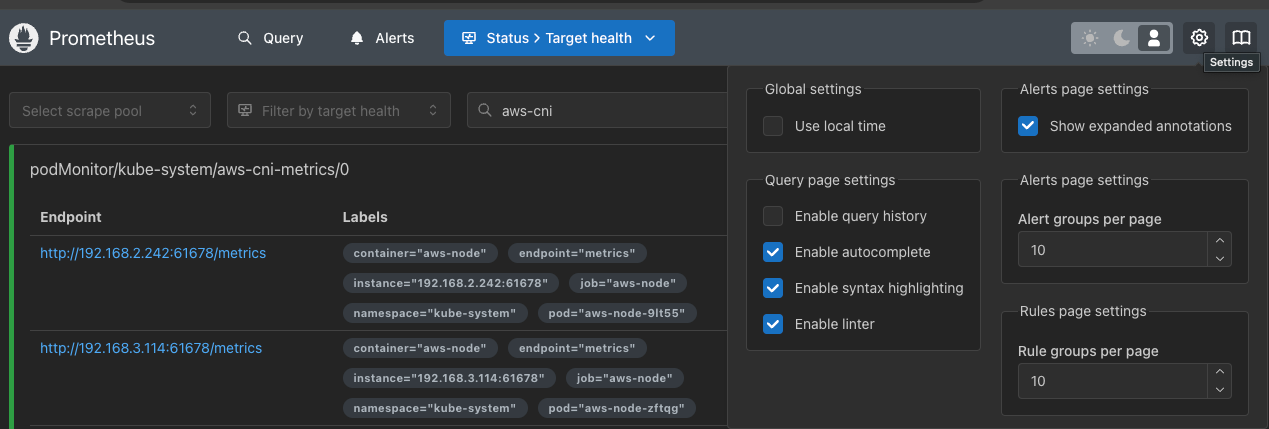

프로메테우스 웹 페이지 메뉴

- Query : 프로메테우스 자체 점색어인 PromQL을 이용하여 메트릭 정보 조회

- Alerts : 사전에 정의한 경고 정책에 대한 알람

- Status : 경고 메시지 정책, 모니터링 대상과 같은 현재 상태

- User local time : 출력 시간을 로컬 타임으로 설정

- Enable Query history : PromQL 쿼리 히스토리 활성화

- Enable autocomplete : 자동 완성 기능 활성화

- Enable highlighting : 하이라이팅 기능 활성화

- Enable linter : 문법 오류 감지, 자동 코스 스타일 체크

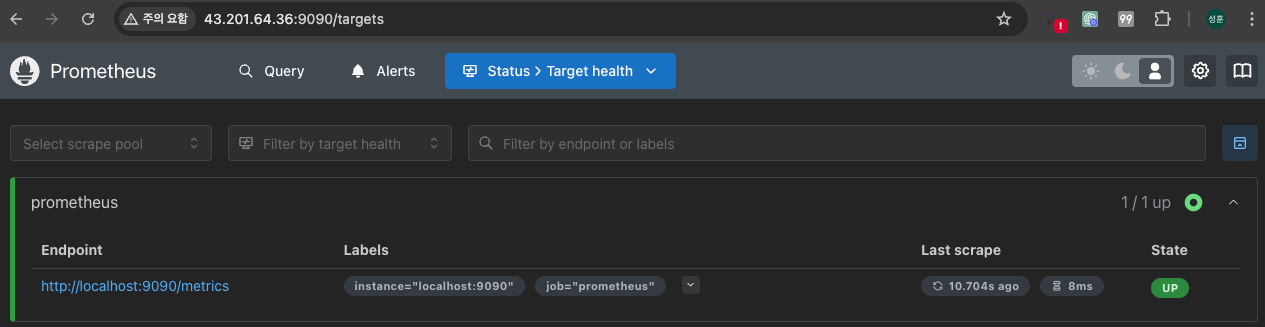

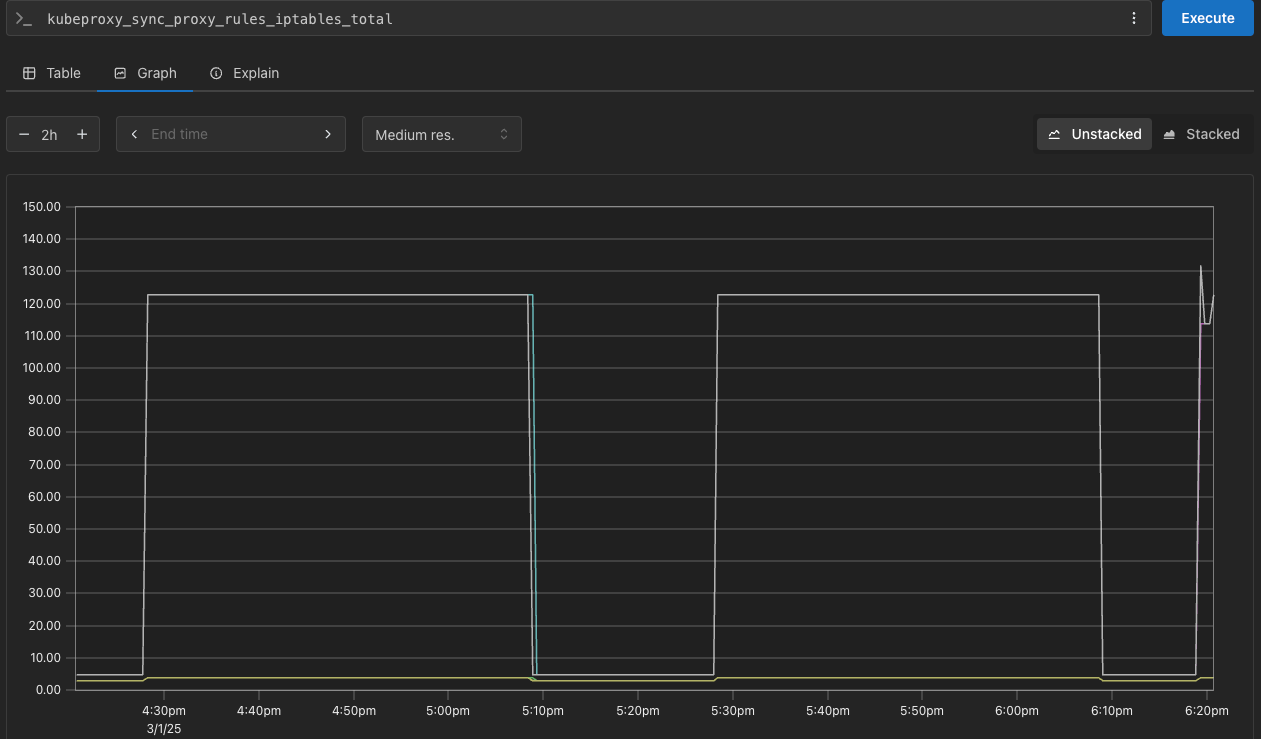

전체 메트릭 대상 확인 : Status > Target health

(kube-proxy 예시)

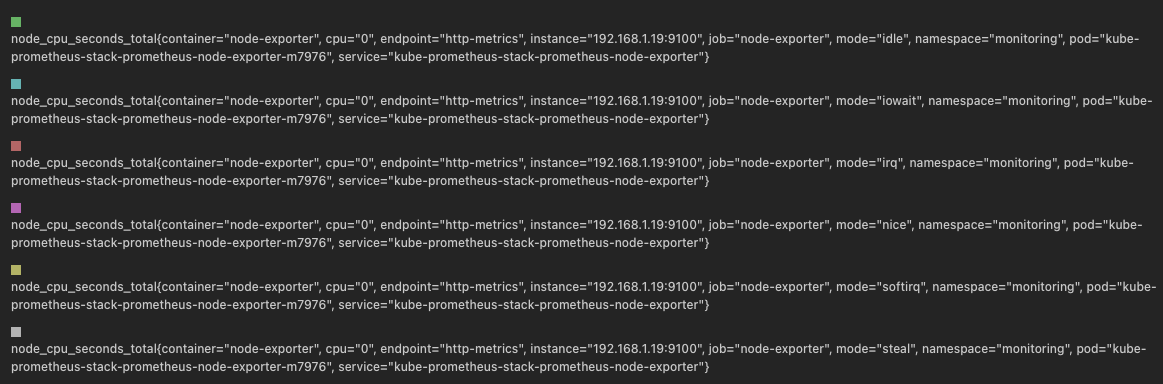

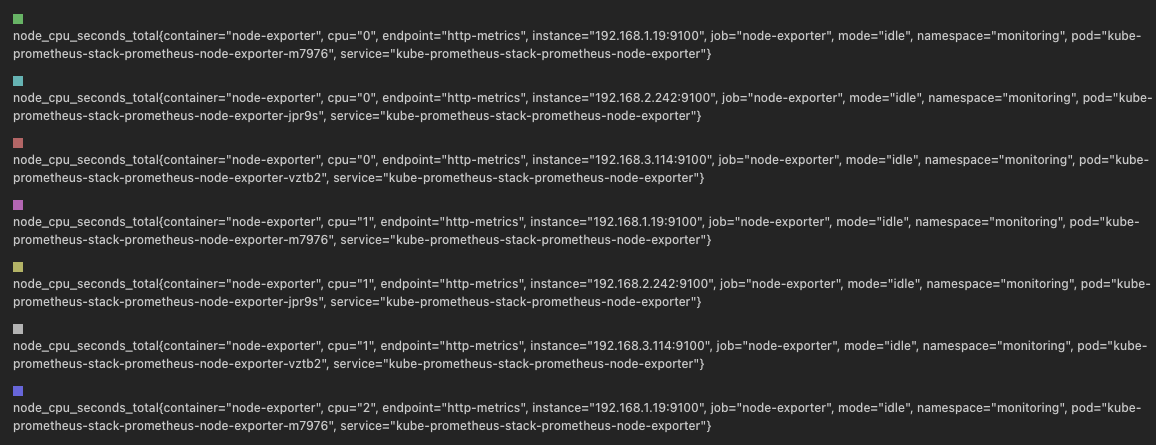

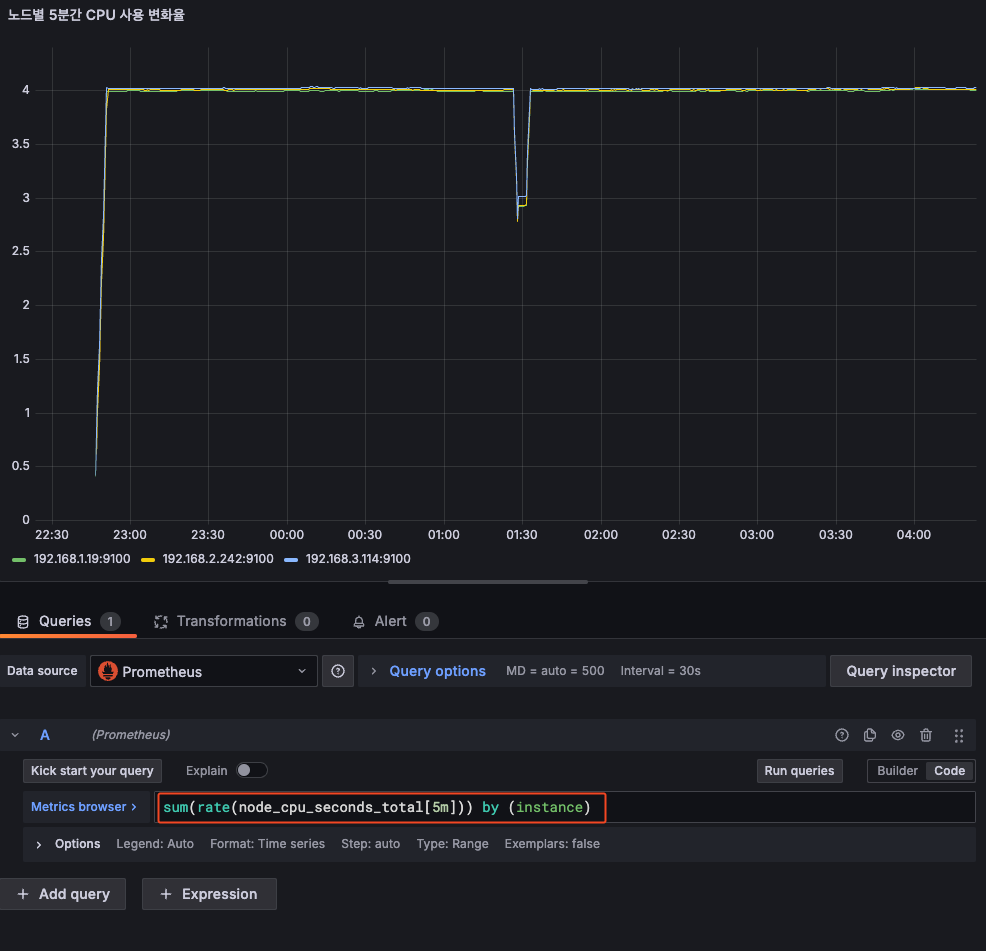

메트릭을 그래프로 조회

## 프로메테우스 웹의 Query에서 수행

# 초당 node의 cpu 정보

node_cpu_seconds_total

## idle mode만 조회

node_cpu_seconds_total{mode="idle"}

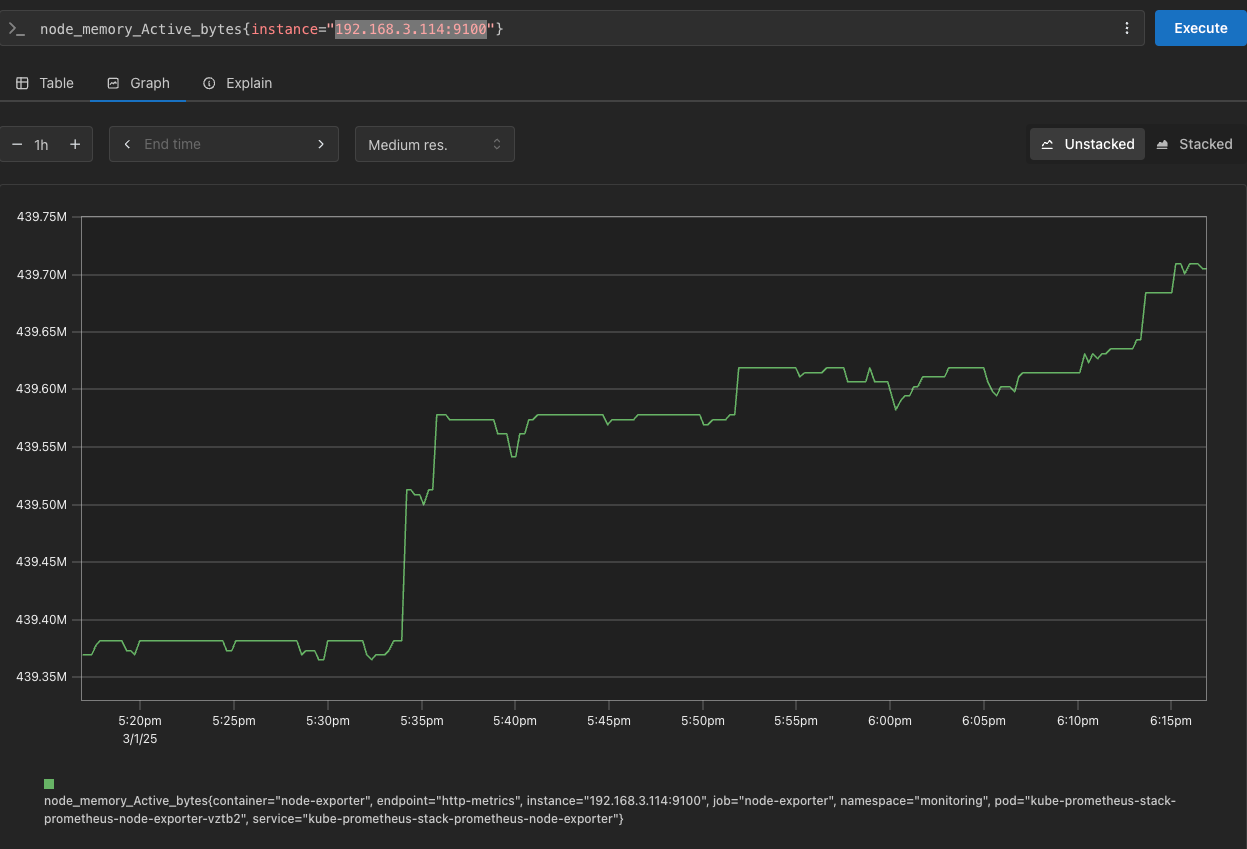

PromQL 쿼리

# Table 아래 쿼리 입력 후 Execute 클릭 -> Graph 확인

## 출력되는 메트릭 정보는 node-exporter 를 통해서 노드에서 수집된 정보

node_memory_Active_bytes

# 특정 노드(인스턴스) 필터링 : 아래 IP는 출력되는 자신의 인스턴스 PrivateIP 입력 후 Execute 클릭 -> Graph 확인

node_memory_Active_bytes{instance="192.168.3.114:9100"}

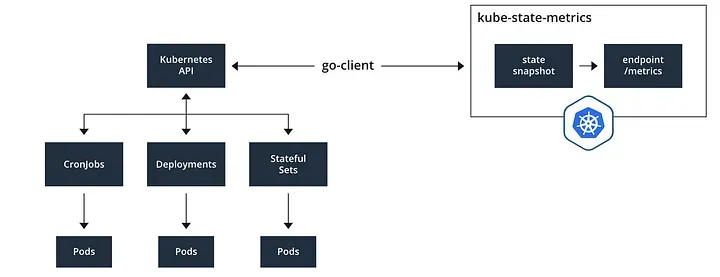

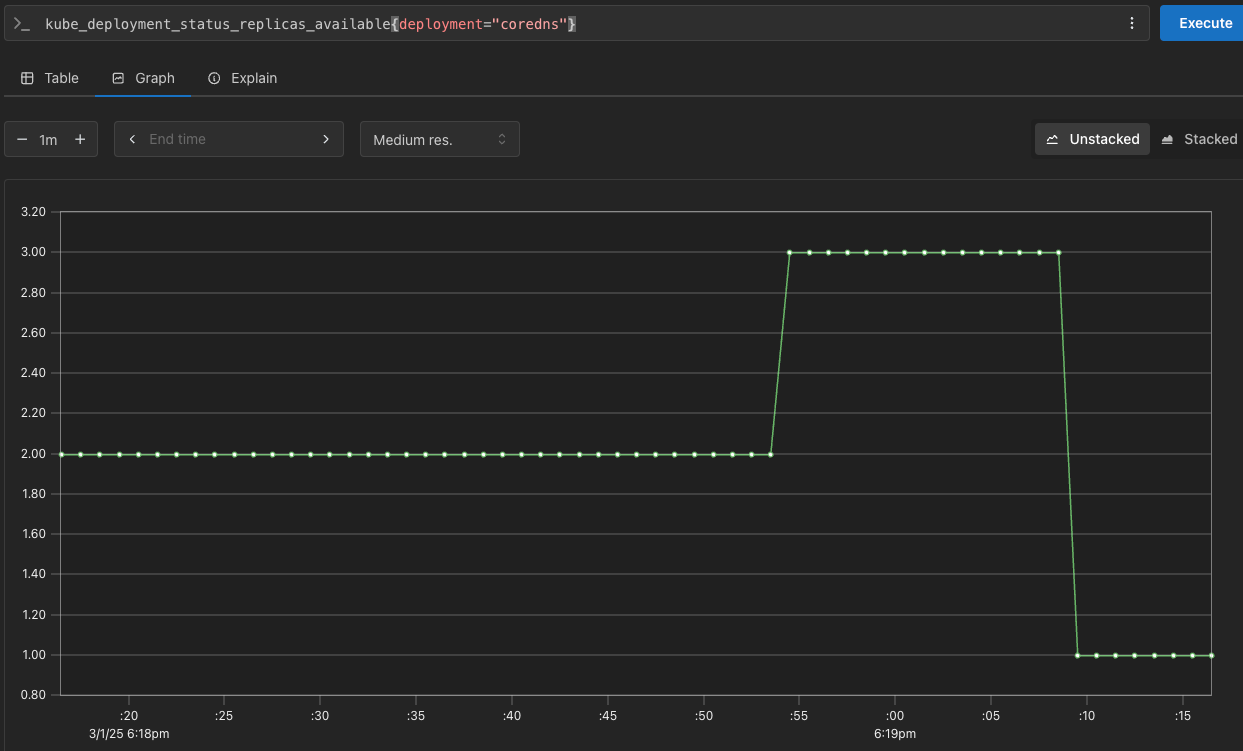

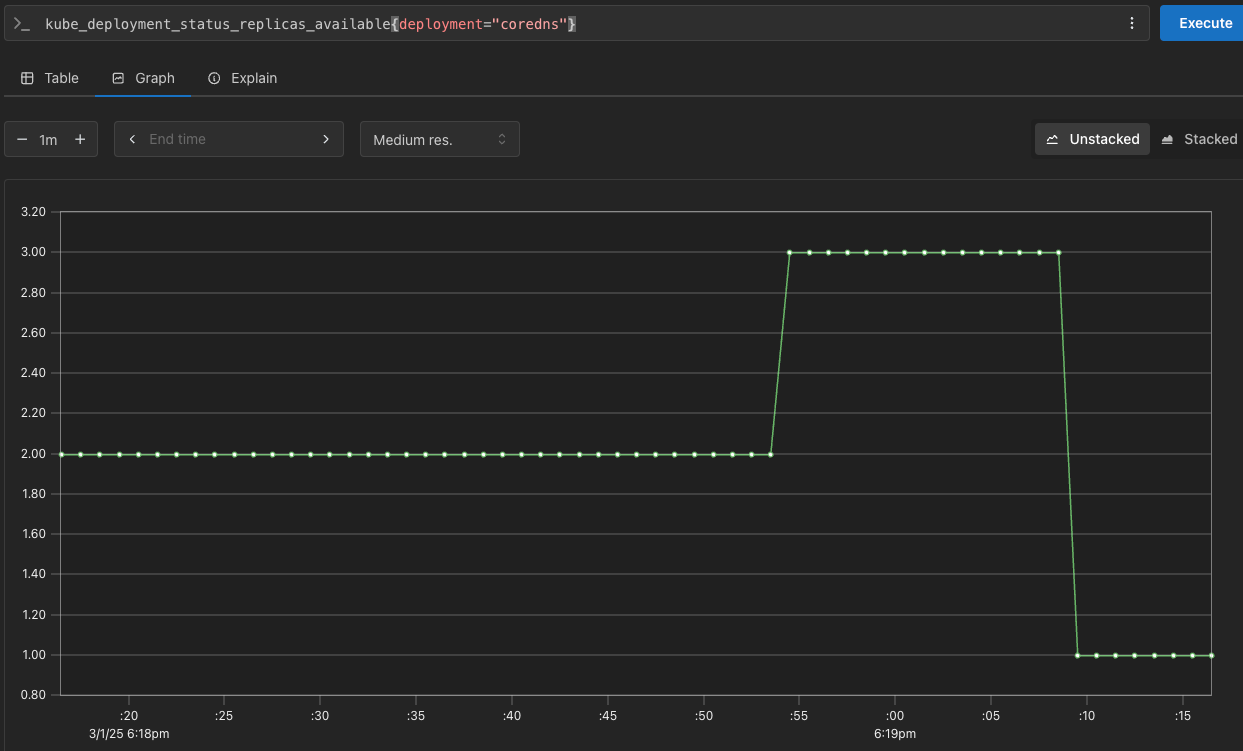

kube-state-metrics (ksm) : k8s api 통해 k8s 오브젝트 정보 수집

# replicas's number

kube_deployment_status_replicas

kube_deployment_status_replicas_available

kube_deployment_status_replicas_available{deployment="coredns"}

# scale out

kubectl scale deployment -n kube-system coredns --replicas 3

# 확인

kube_deployment_status_replicas_available{deployment="coredns"}

# scale in

kubectl scale deployment -n kube-system coredns --replicas 1

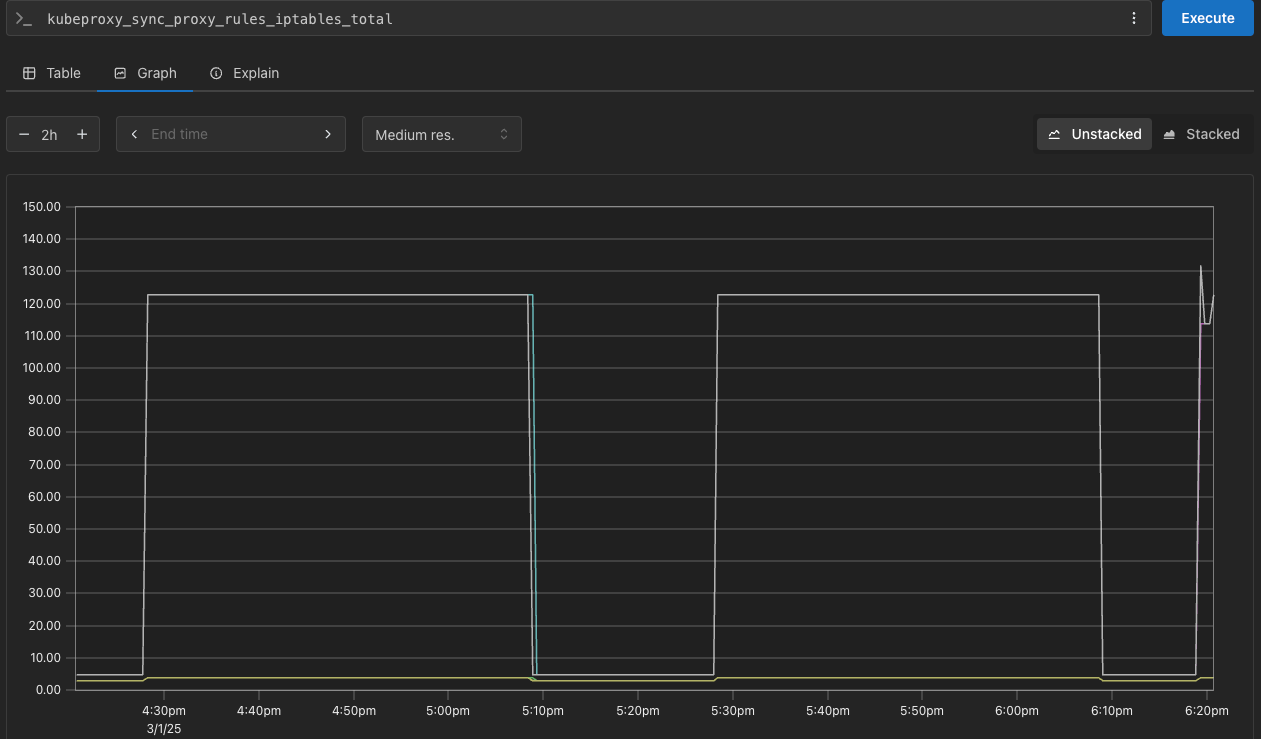

kube-proxy : 이미 내장으로 메트릭 노출 준비가 설정되어 있다.

PromQL 쿼리 : 어플리케이션

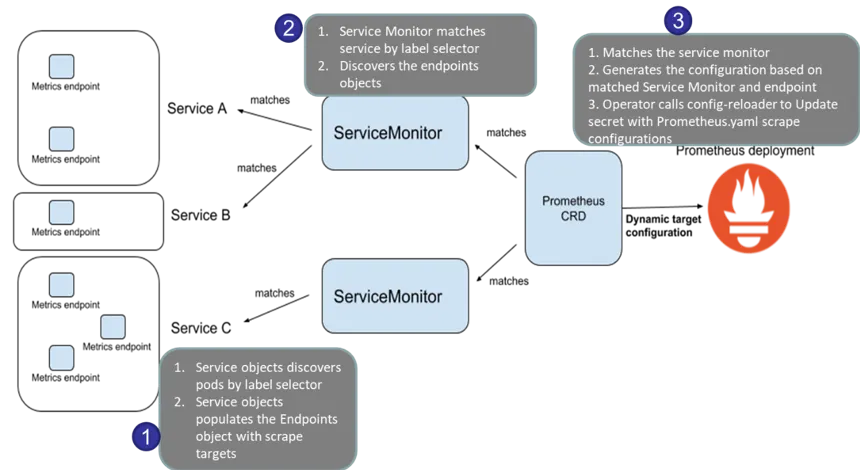

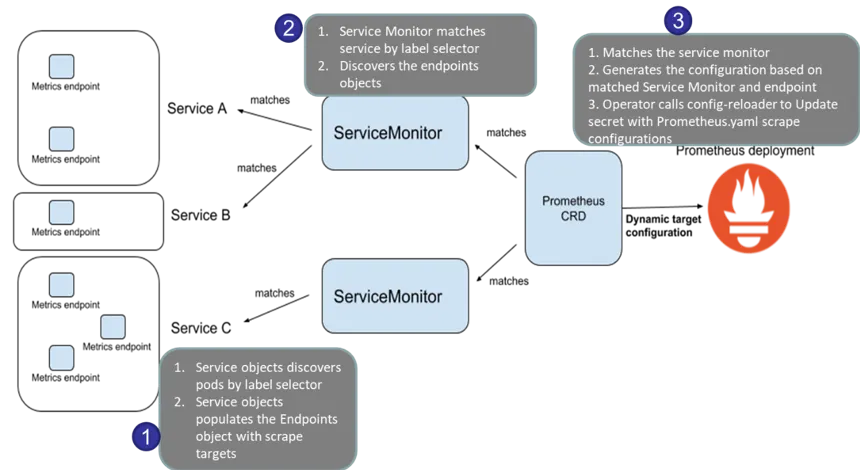

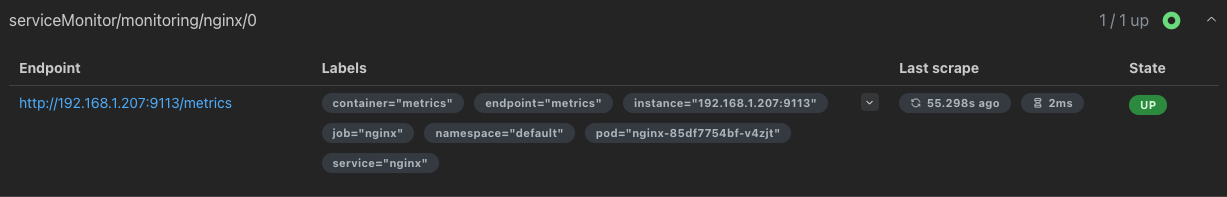

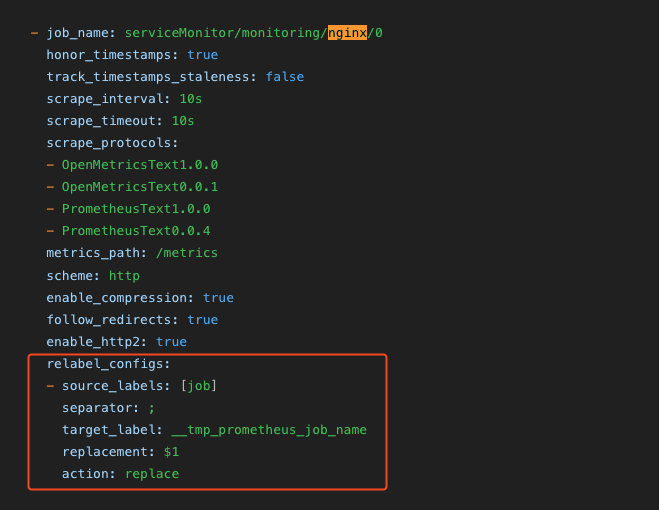

- 서비스모니터 동작

- nginx를 helm으로 설치할 때 프로메테우스 익스포터 옵션 설정 시 자동으로 nginx 프로메테우스 모니터링에 등록 가능

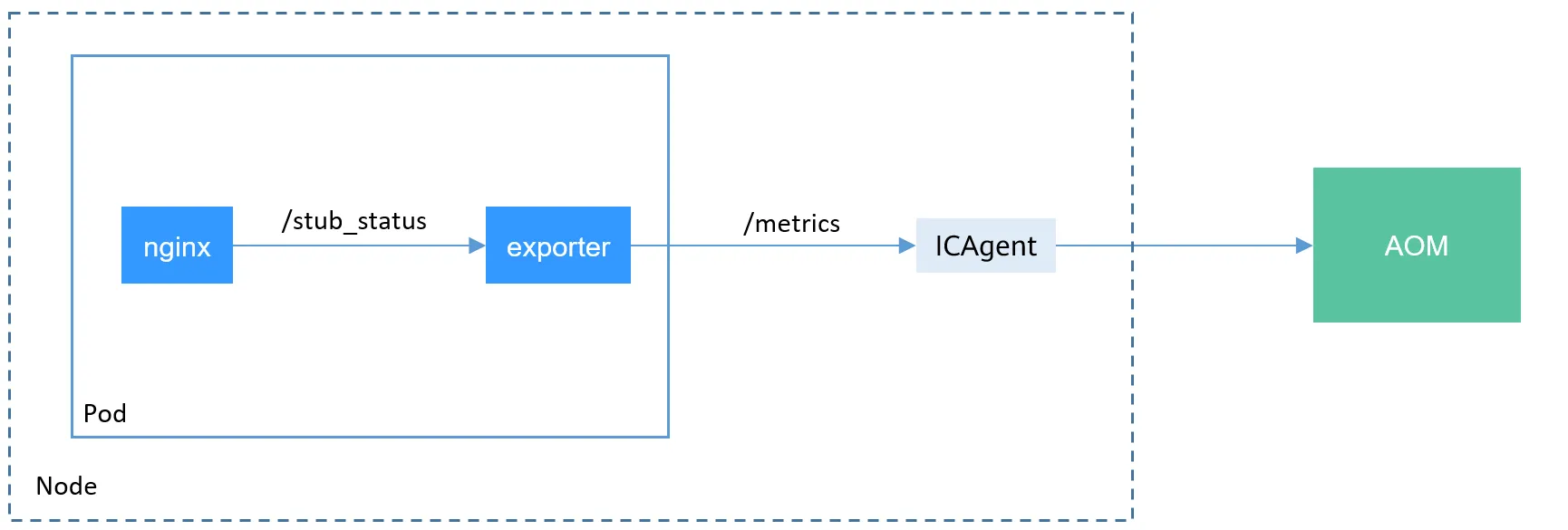

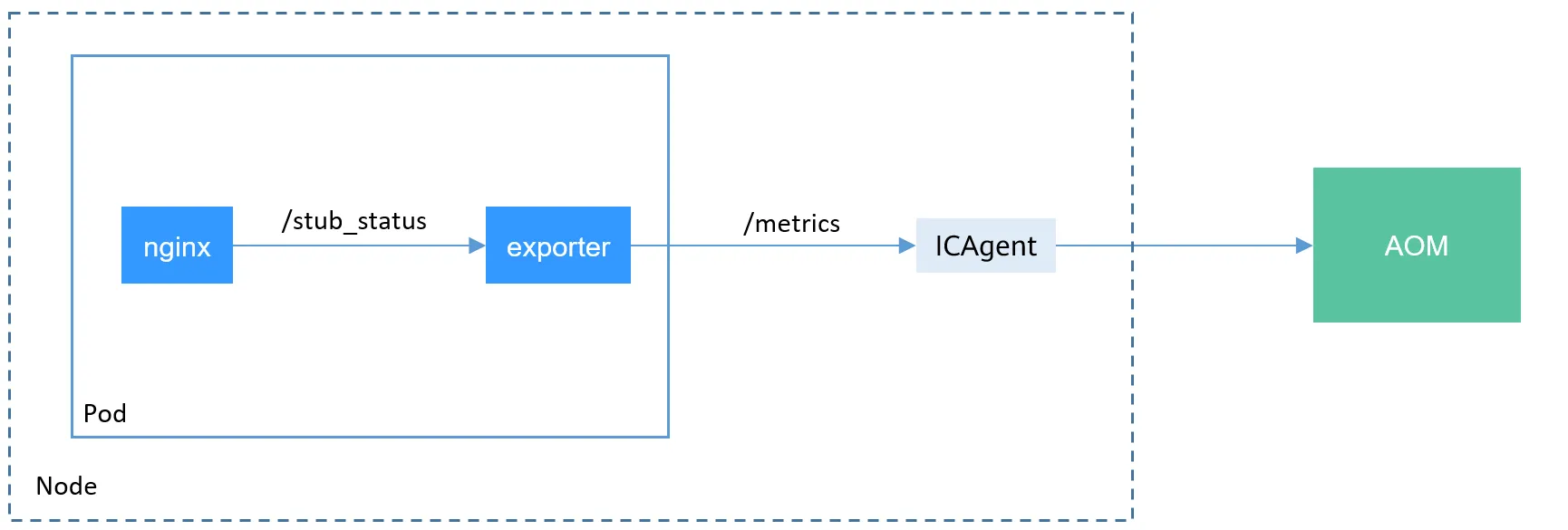

- 기존 어플리케이션 파드에 프로메테우스 모니터링을 투가하려면 사이드카 방식을 사용하며, exporter 컨테이너를 추가

- nginx 웹 서버(with helm)에 metrics 수집 설정 추가

## 모니터링

$ watch -d "kubectl get pod; echo; kubectl get servicemonitors -n monitoring"

## nginx 파드내에 컨테이너 갯수 확인

$ k describe pod -l app.kubernetes.io/instance=nginx

## 파라미터 파일 생성 : 서비스 모니터 방식으로 nginx를 모니터링 대상으로 등록 export port는 9113사용

cat <<EOT > nginx-values.yaml

metrics:

enabled: true

service:

port: 9113

serviceMonitor:

enabled: true

namespace: monitoring

interval: 10s

EOT

## 배포

$ helm upgrade nginx bitnami/nginx --reuse-values -f nginx-values.yaml

nginx-85df7754bf-v4zjt 1/2 Running 0 18s

## 배포가 완료된 이후 describe를 보면 metrics 컨테이너가 추가로 생성되었다.

metrics:

Container ID: containerd://d04ae80dbfba2471d074037c3e9c48019ddad4362a3a8e6a738ef88300f0d04b

Image: docker.io/bitnami/nginx-exporter:1.4.1-debian-12-r3

Image ID: docker.io/bitnami/nginx-exporter@sha256:fea1a013e5769d5eadd5d2d8b3f339d1c465b7de301ab7f454eb4adc7a8959ac

Port: 9113/TCP

Host Port: 0/TCP

Command:

exporter

Args:

--nginx.scrape-uri

http://127.0.0.1:8080/status

--web.listen-address

:9113

State: Running

Started: Sun, 02 Mar 2025 03:28:05 +0900

Ready: True

Restart Count: 0

Limits:

cpu: 150m

ephemeral-storage: 2Gi

memory: 192Mi

Requests:

cpu: 100m

ephemeral-storage: 50Mi

memory: 128Mi

Liveness: http-get http://:metrics/metrics delay=15s timeout=5s period=10s #success=1 #failure=3

Readiness: http-get http://:metrics/metrics delay=5s timeout=1s period=10s #success=1 #failure=3

Environment: <none>

Mounts: <none>

## 확인

$ k get servicemonitor -n monitoring nginx

$ kubectl get servicemonitor -n monitoring nginx -o json | jq

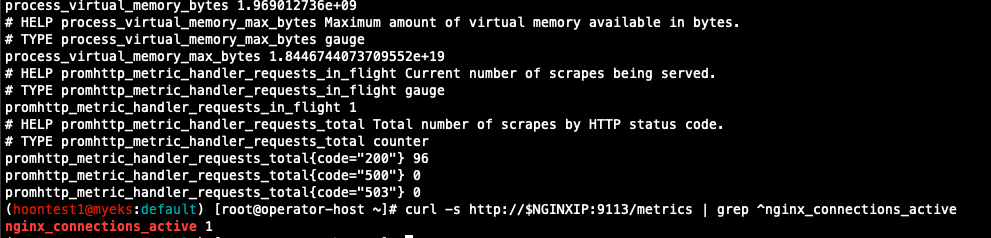

# [운영서버 EC2] 메트릭 확인 >> 프로메테우스에서 Target 확인

## nginx sub_status url 접속해보기

NGINXIP=$(kubectl get pod -l app.kubernetes.io/instance=nginx -o jsonpath="{.items[0].status.podIP}")

curl -s http://$NGINXIP:9113/metrics # nginx_connections_active Y 값 확인해보기

curl -s http://$NGINXIP:9113/metrics | grep ^nginx_connections_active

## 반복 접근

$ while true; do curl -s https://nginx.$MyDomain -I | head -n 1; date; sleep 1; done

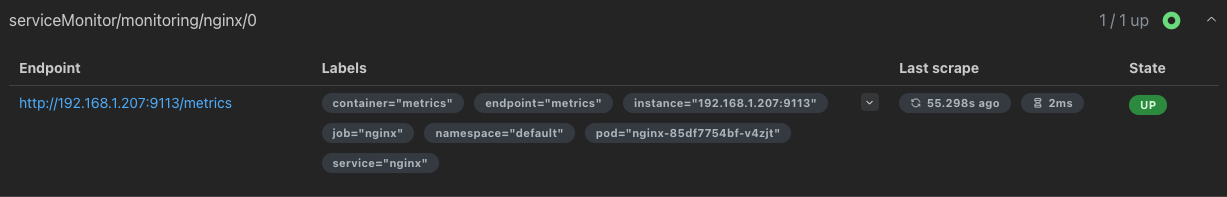

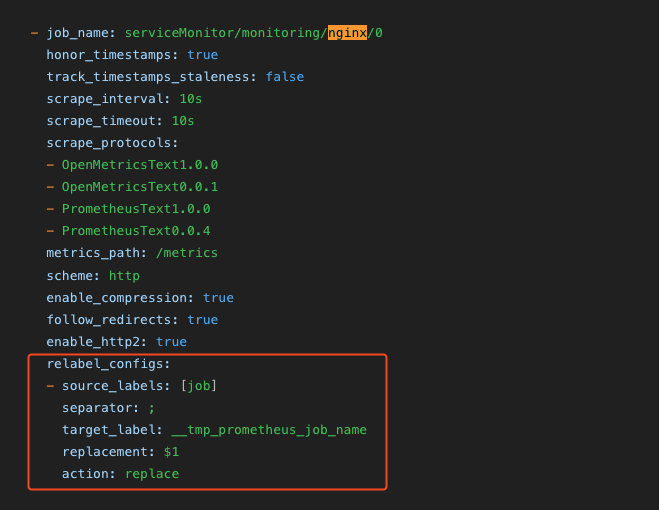

- 프로메테우스에 nginx servicemonitor 추가 확인

- 설정이 자동으로 반영되는 원리는 주요 config 적용 필요 시 reloader 동작

프로메테우스 메트릭 종류 : Counter, Gauge, Histogram, Summary

- Counter : 누적된 값을 표현, 증가 시 구간 별로 변화 확인

- Gauge : 특정 시점의 값을 표현하기 위해 사용, CPU 온도나 메모리 사용향에 대한 현재 시점 값

- Summary : 구간 내에 있는 메트릭 값의 빈도, 중앙값 등 통계적 메트릭

- Histogram : 사전에 미리 정의한 구간 내에 있는 메트릭 값의 빈도를 측정

PromQL Query

- Label Matchers

# 예시

node_memory_Active_bytes

node_memory_Active_bytes{instance="192.168.1.188:9100"}

node_memory_Active_bytes{instance!="192.168.1.188:9100"}

# 정규표현식

node_memory_Active_bytes{instance=~"192.168.+"}

node_memory_Active_bytes{instance=~"192.168.1.+"}

# 다수 대상

node_memory_Active_bytes{instance=~"192.168.1.188:9100|192.168.2.170:9100"}

node_memory_Active_bytes{instance!~"192.168.1.188:9100|192.168.2.170:9100"}

# 여러 조건 AND

kube_deployment_status_replicas_available{namespace="kube-system"}

kube_deployment_status_replicas_available{namespace="kube-system", deployment="coredns"}

- 이진 연산자

# 산술 이진 연산자 : + - * / * ^

node_memory_Active_bytes

node_memory_Active_bytes/1024

node_memory_Active_bytes/1024/1024

# 비교 이진 연산자 : = = ! = > < > = < =

nginx_http_requests_total

nginx_http_requests_total > 100

nginx_http_requests_total > 10000

# 논리/집합 이진 연산자 : and 교집합 , or 합집합 , unless 차집합

kube_pod_status_ready

kube_pod_container_resource_requests

kube_pod_status_ready == 1

kube_pod_container_resource_requests > 1

kube_pod_status_ready == 1 or kube_pod_container_resource_requests > 1

kube_pod_status_ready == 1 and kube_pod_container_resource_requests > 1

- 집계 연산자

#

node_memory_Active_bytes

# 출력 값 중 Top 3

topk(3, node_memory_Active_bytes)

# 출력 값 중 하위 3

bottomk(3, node_memory_Active_bytes)

bottomk(3, node_memory_Active_bytes>0)

# node 그룹별: by

node_cpu_seconds_total

node_cpu_seconds_total{mode="user"}

node_cpu_seconds_total{mode="system"}

avg(node_cpu_seconds_total)

avg(node_cpu_seconds_total) by (instance)

avg(node_cpu_seconds_total{mode="user"}) by (instance)

avg(node_cpu_seconds_total{mode="system"}) by (instance)

#

nginx_http_requests_total

sum(nginx_http_requests_total)

sum(nginx_http_requests_total) by (instance)

# 특정 내용 제외하고 출력 : without

nginx_http_requests_total

sum(nginx_http_requests_total) without (instance)

sum(nginx_http_requests_total) without (instance,container,endpoint,job,namespace)

- 활용

# 서비스 정보 >> 네임스페이스별 >> cluster_ip 별

kube_service_info

count(kube_service_info)

count(kube_service_info) by (namespace)

count(kube_service_info) by (cluster_ip)

# 컨테이너가 사용 메모리 -> 파드별

container_memory_working_set_bytes

sum(container_memory_working_set_bytes)

sum(container_memory_working_set_bytes) by (pod)

topk(5,sum(container_memory_working_set_bytes) by (pod))

topk(5,sum(container_memory_working_set_bytes) by (pod))/1024/1024

Grafana

TSDB 데이터를 시각화, 다양한 데이터 형식 지원

- 그라파나는 시각화 솔루션으로 데이터 자체를 저장하지 않음

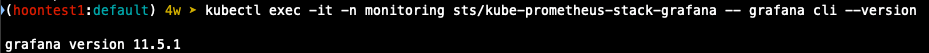

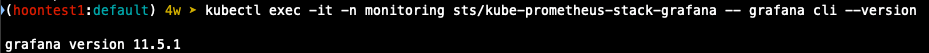

## 그라파나 버전 확인

$ k exec -it -n monitoring sts/kube-prometheus-stack-grafana -- grafana cli --version

## 서비스 주소 확인

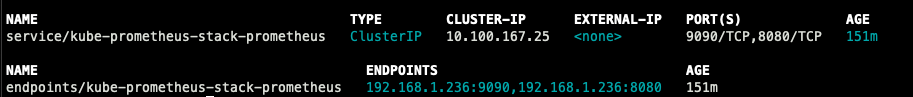

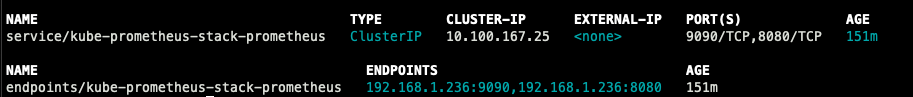

$ k get svc,ep -n monitoring kube-prometheus-stack-prometheus

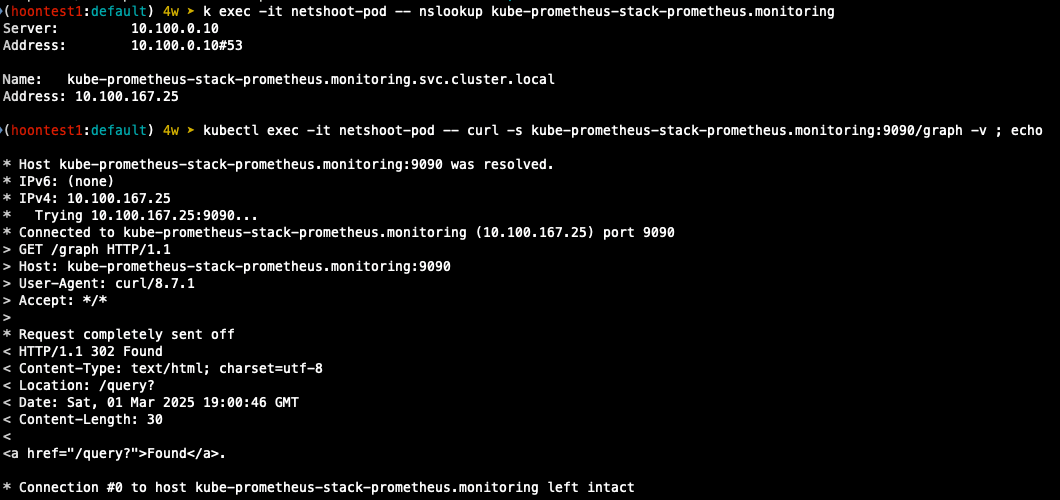

서비스 주소로 접속 확인

# 테스트용 파드 배포

cat <<EOF | kubectl create -f -

apiVersion: v1

kind: Pod

metadata:

name: netshoot-pod

spec:

containers:

- name: netshoot-pod

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

$ k exec -it netshoot-pod -- nslookup kube-prometheus-stack-prometheus.monitoring

$ k exec -it netshoot-pod -- curl -s kube-prometheus-stack-prometheus.monitoring:9090/graph -v ; echo

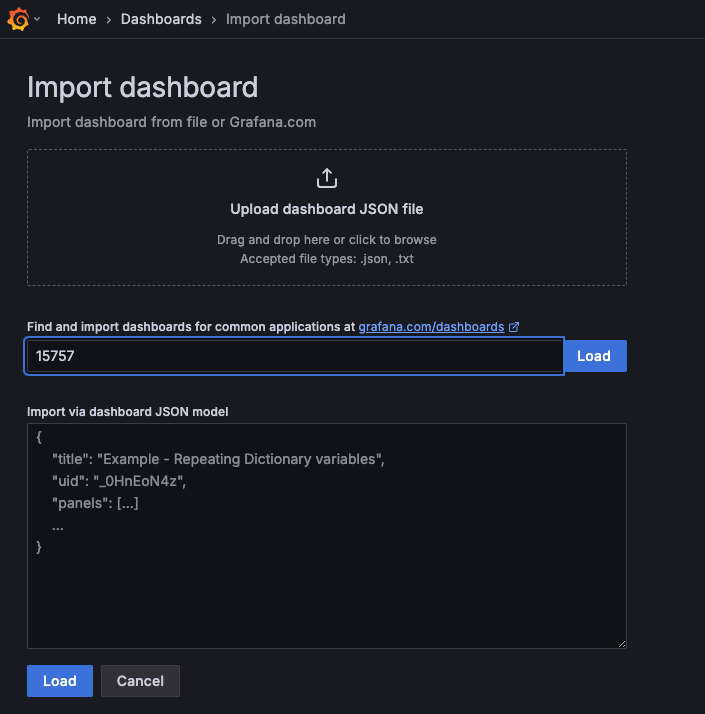

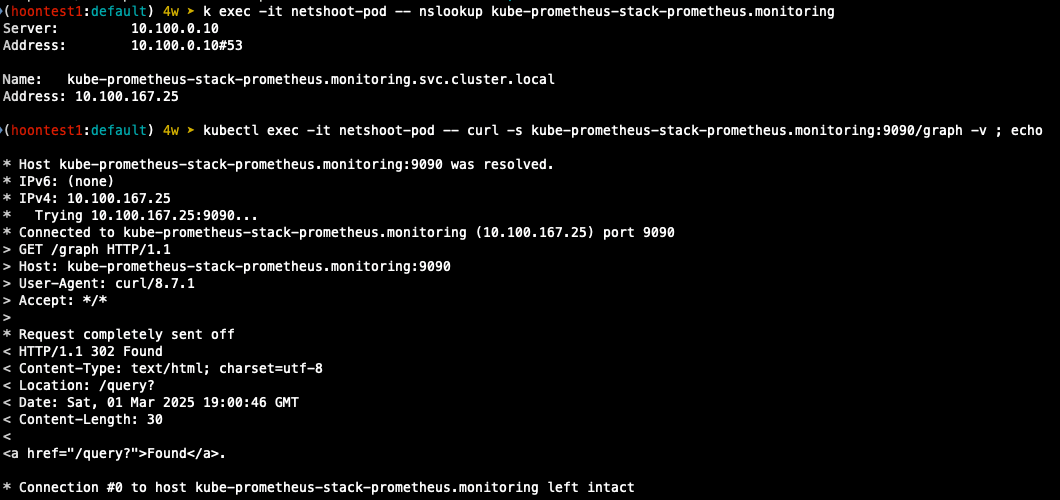

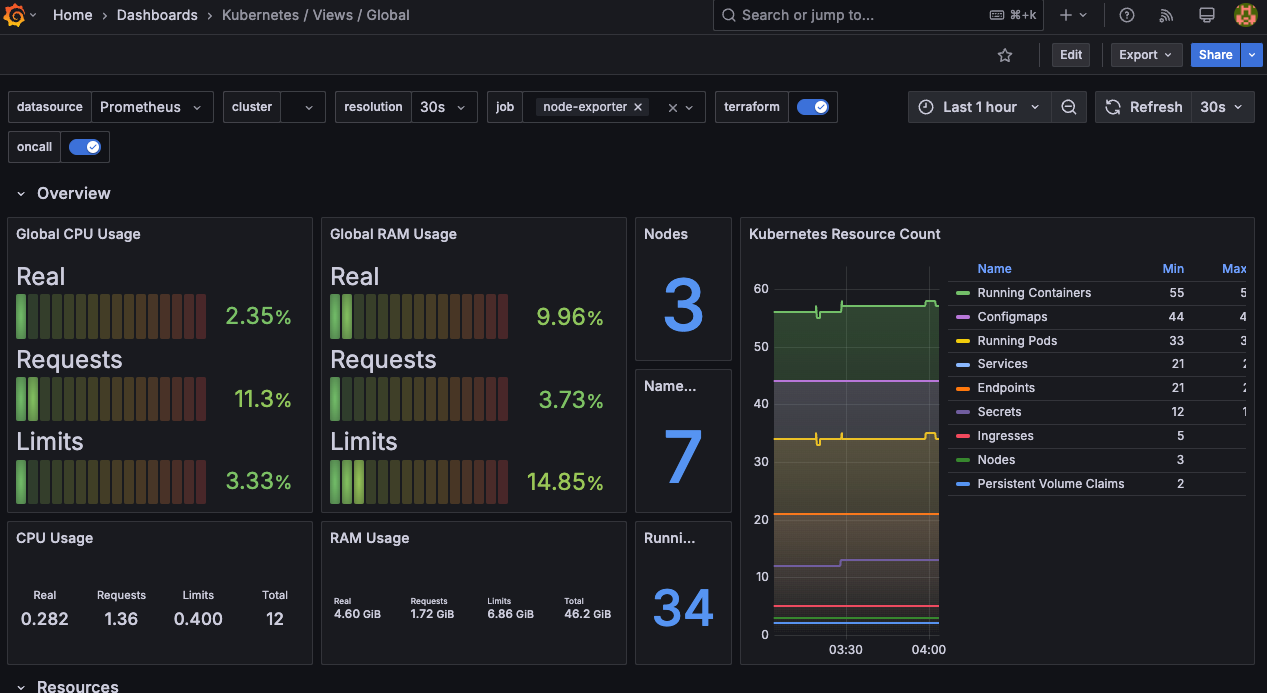

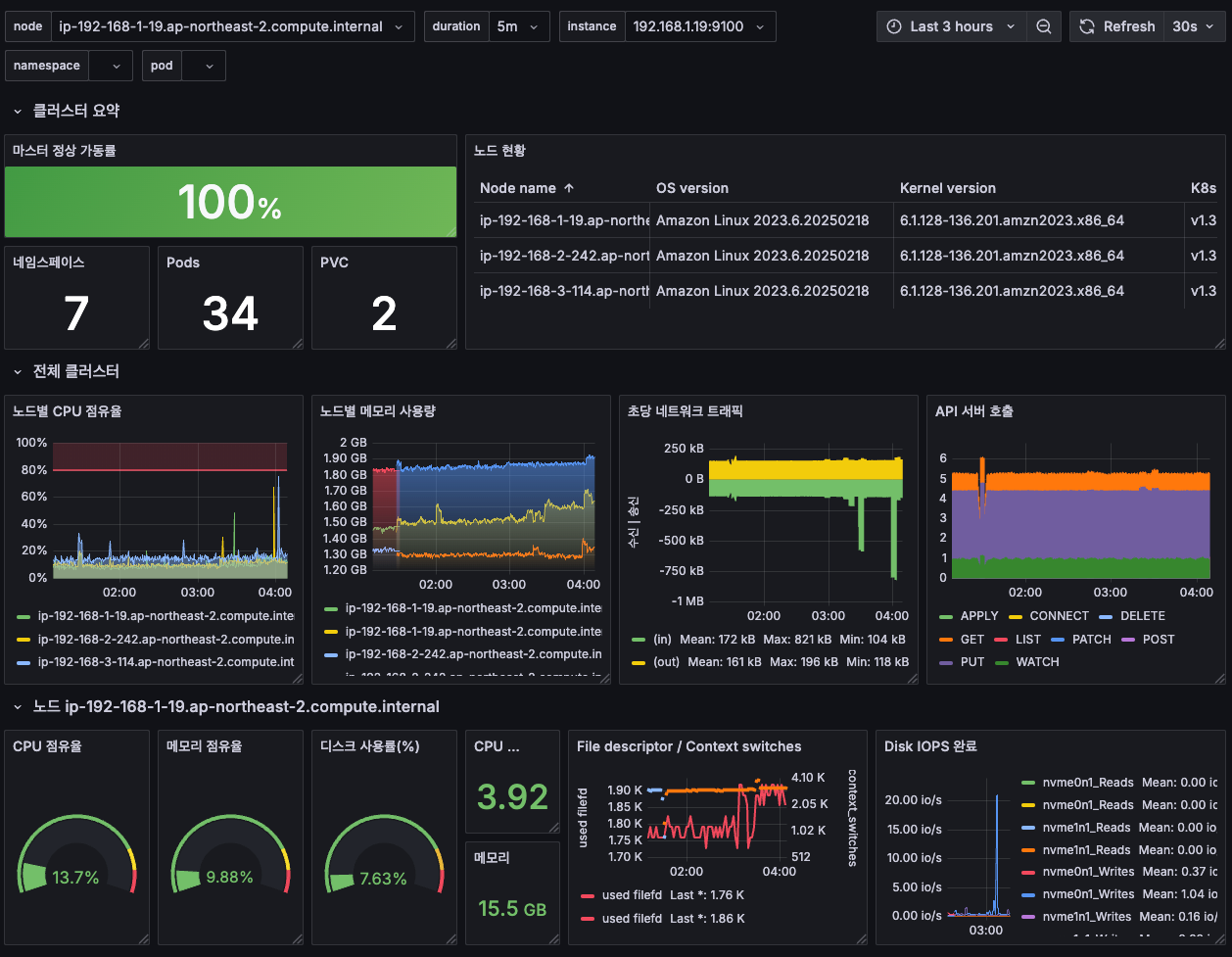

대시보드 사용

- 스택을 통해서 설치된 기본 대시보드 확인

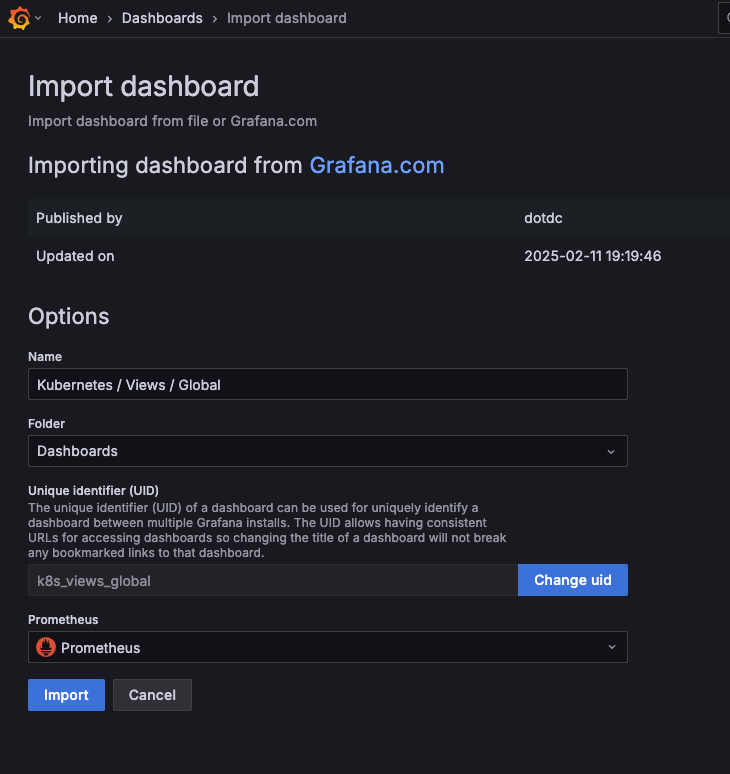

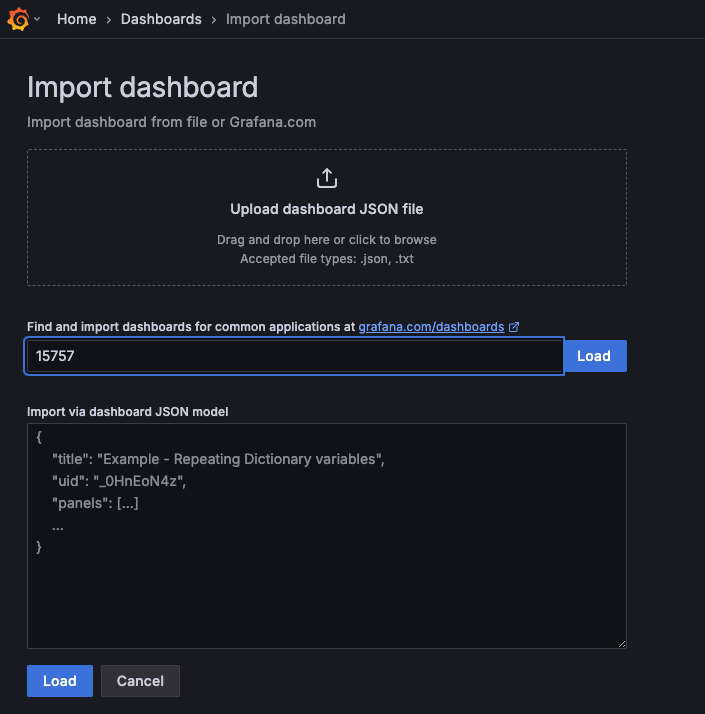

공식 대시보드 가져오기

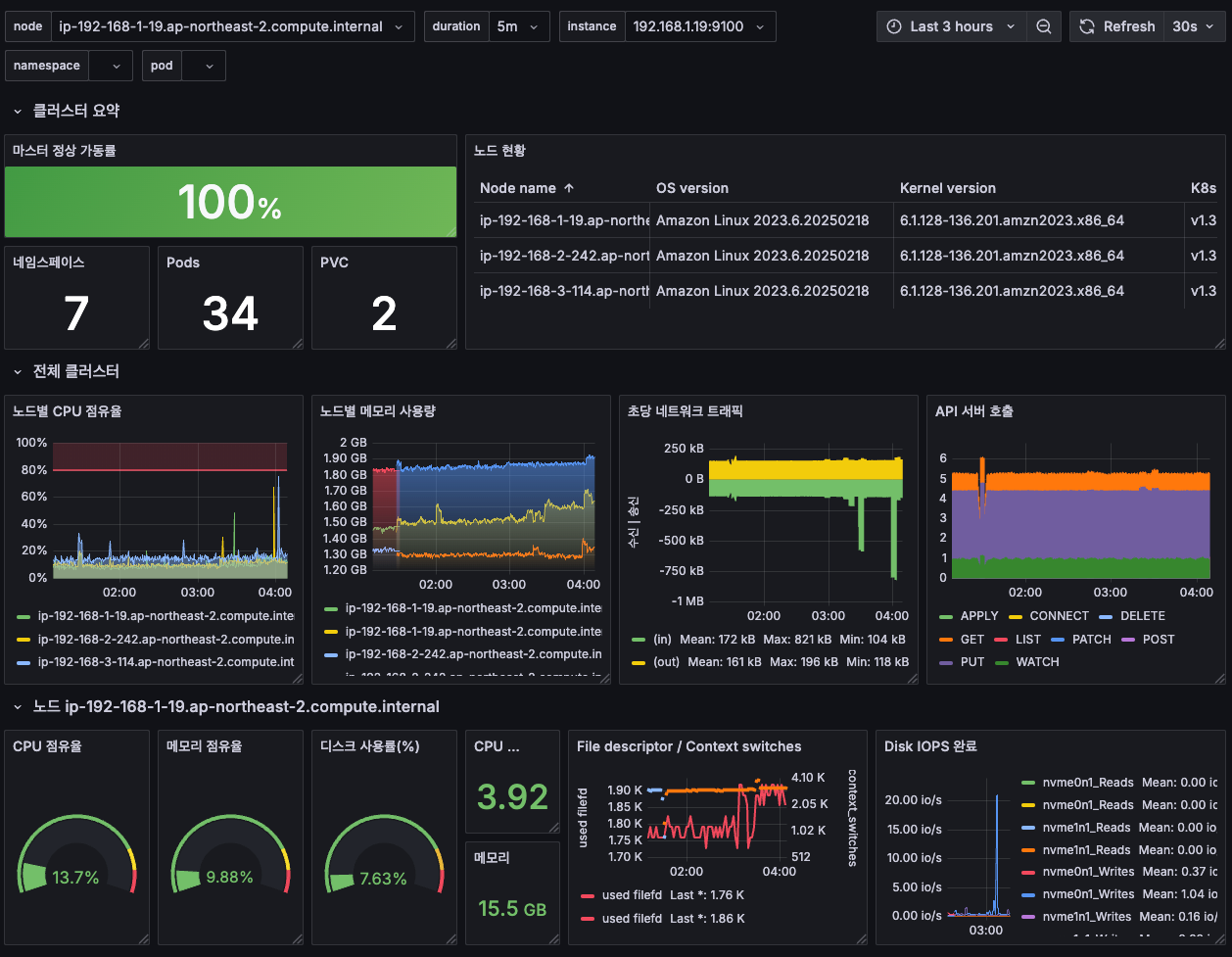

[1 Kubernetes All-in-one Cluster Monitoring KR] Dashboard → New → Import → 17900 입력 후 Load ⇒ 데이터소스(Prometheus 선택) 후 Import 클릭

처음 import하면 여러 데이터가 수집되지 않는 것을 확인할 수 있다.

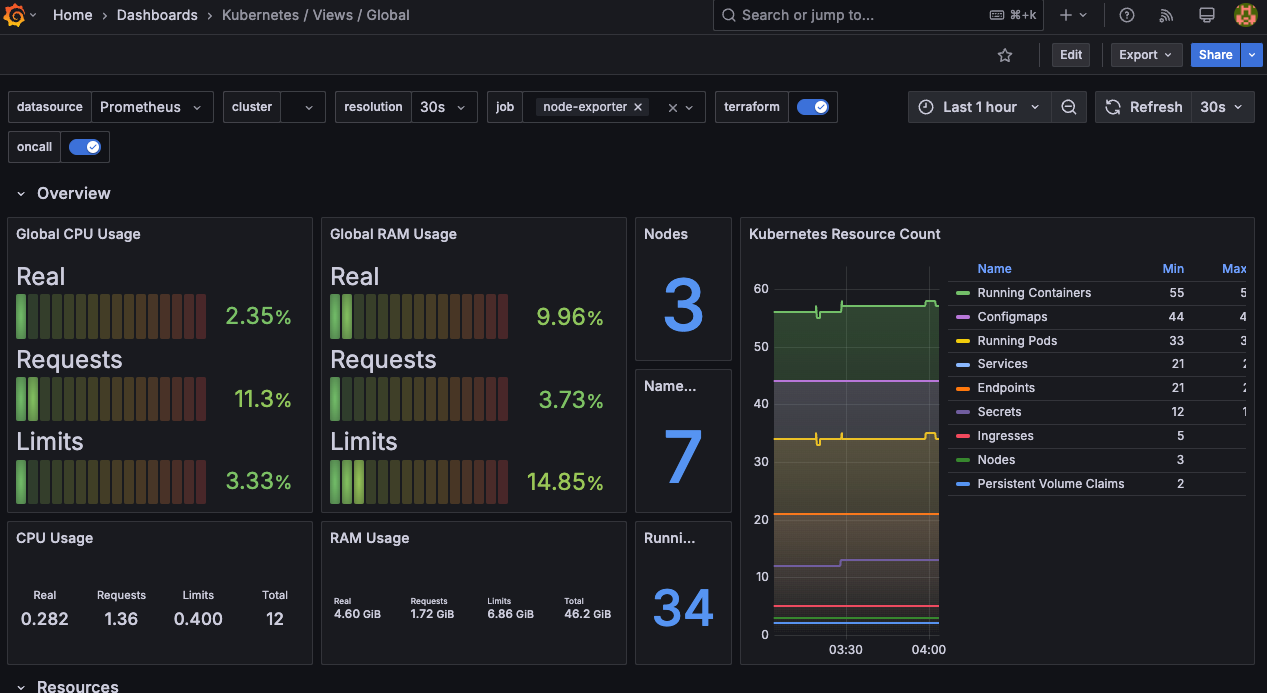

Prometheus에 질의하면서 에러를 잡으면 아래와 같이 그래프가 표시되는 것을 확인할 수 있다.

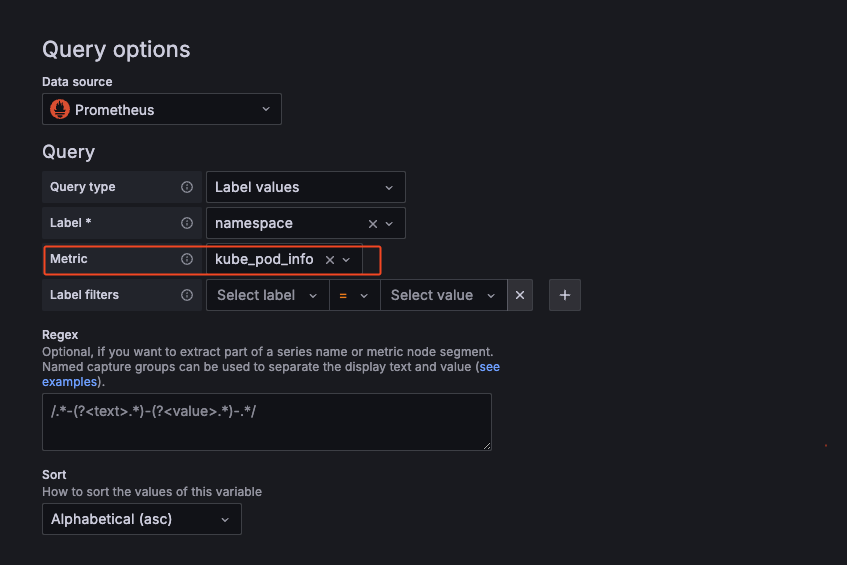

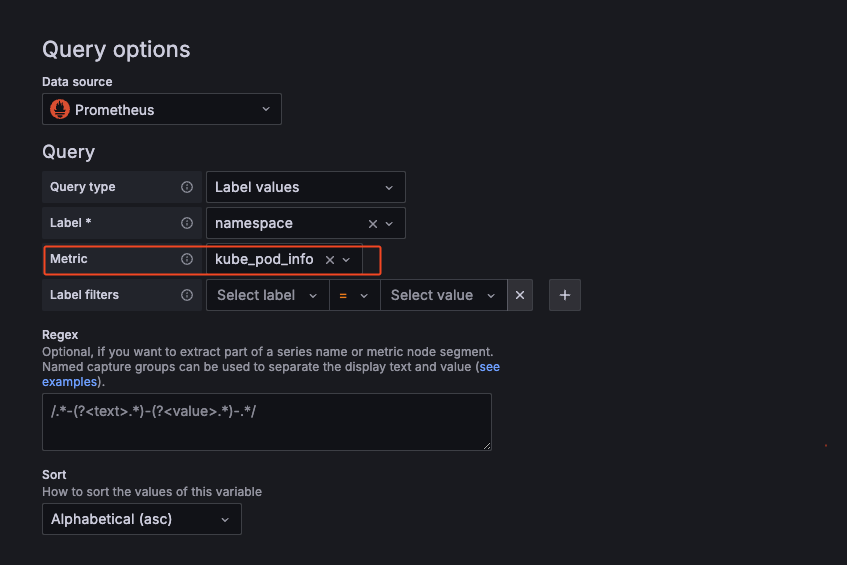

상단 네임스페이스와 파드 정보 필터링 출력되게 수정하기

settings > variables > namespcae > metric "kube_pod_info"로 수정

파드의 리소스 할당 제한 표시

-CPU

## 기존

sum(kube_pod_container_resource_limits_cpu_cores{pod="$pod"})

## 변경

sum(kube_pod_container_resource_limits{resource="cpu", pod="$pod"})

- MEM

# 기존

sum(kube_pod_container_resource_limits_memory_bytes{pod="$pod"})

# 변경

sum(kube_pod_container_resource_limits{resource="memory", pod="$pod"})

문법이 틀린 것을 등록한 느낌보다는 버전 업데이트가 빠르게 되면서 대시보드 업데이트가 안되는 느낌이다.

AWS CNI Metrics 대시보드 등록 하기 - 16032

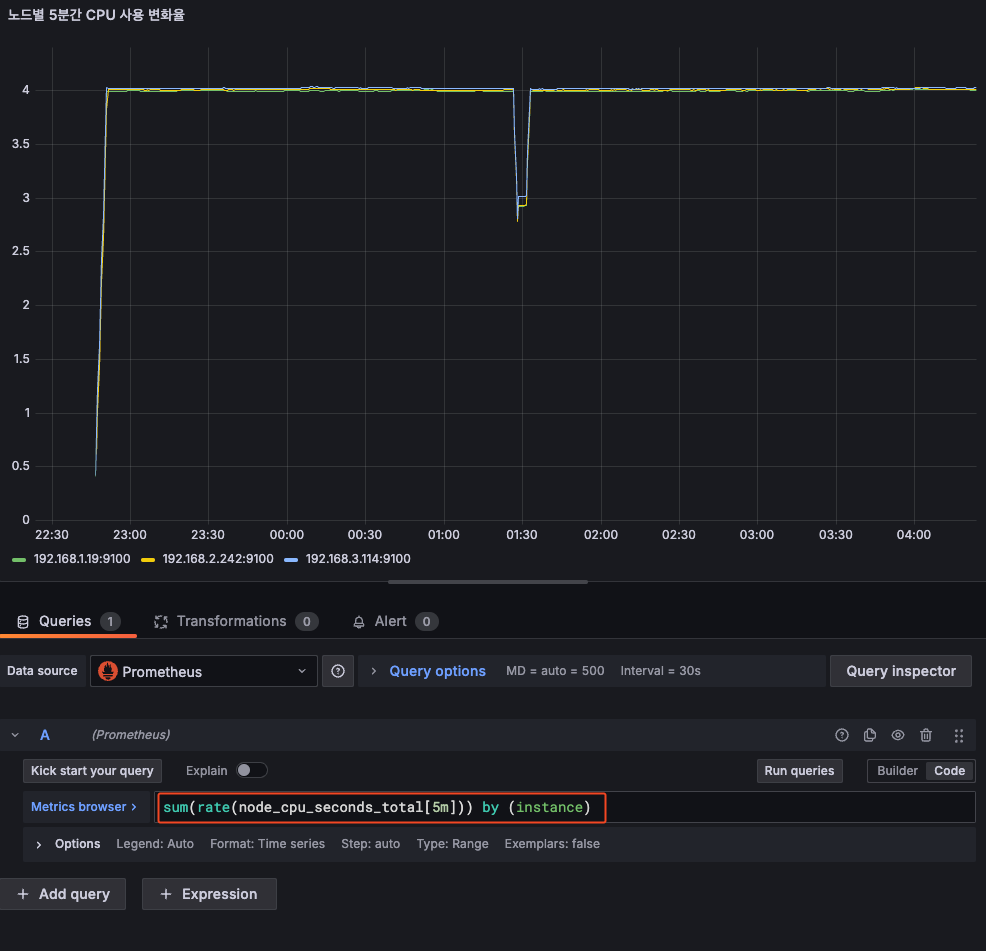

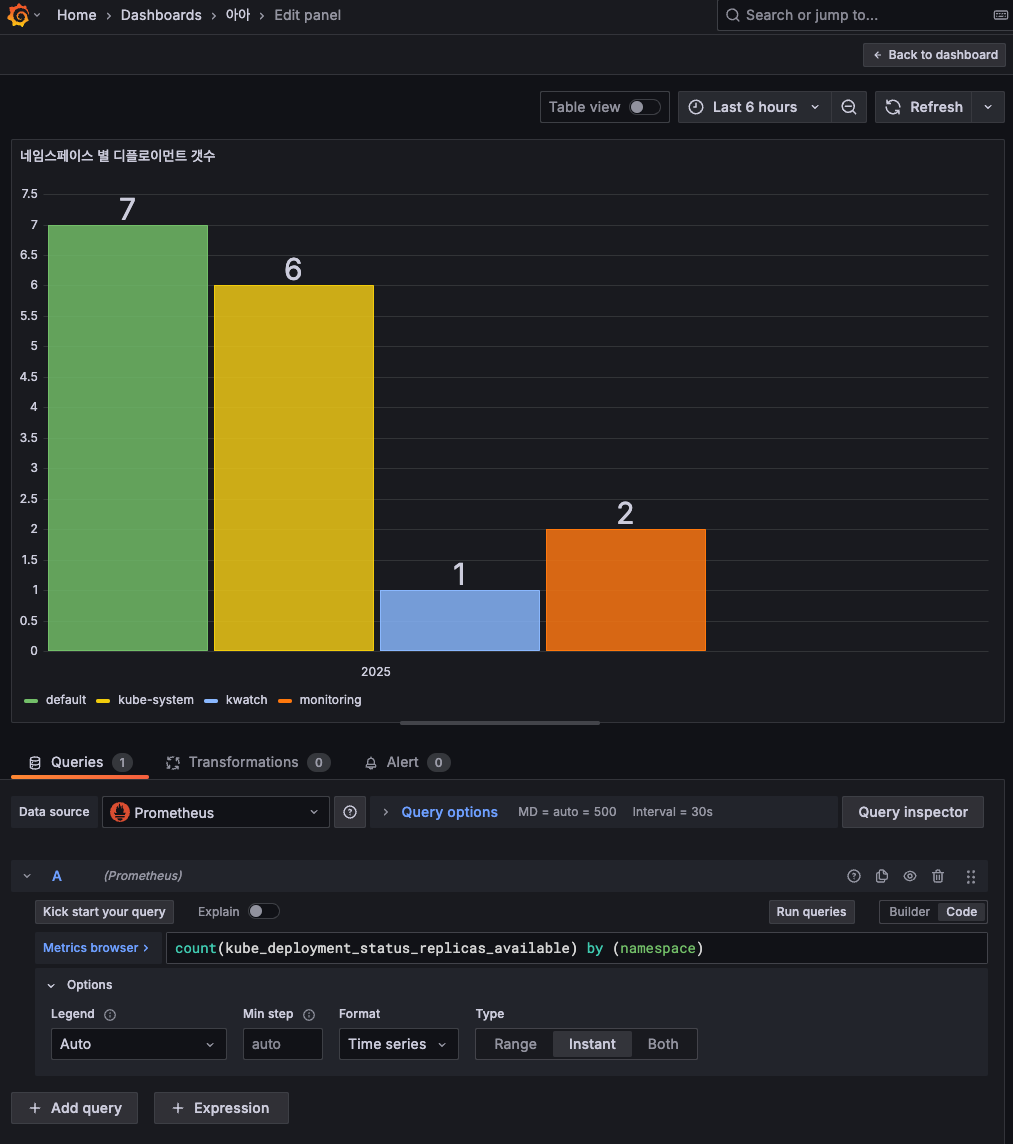

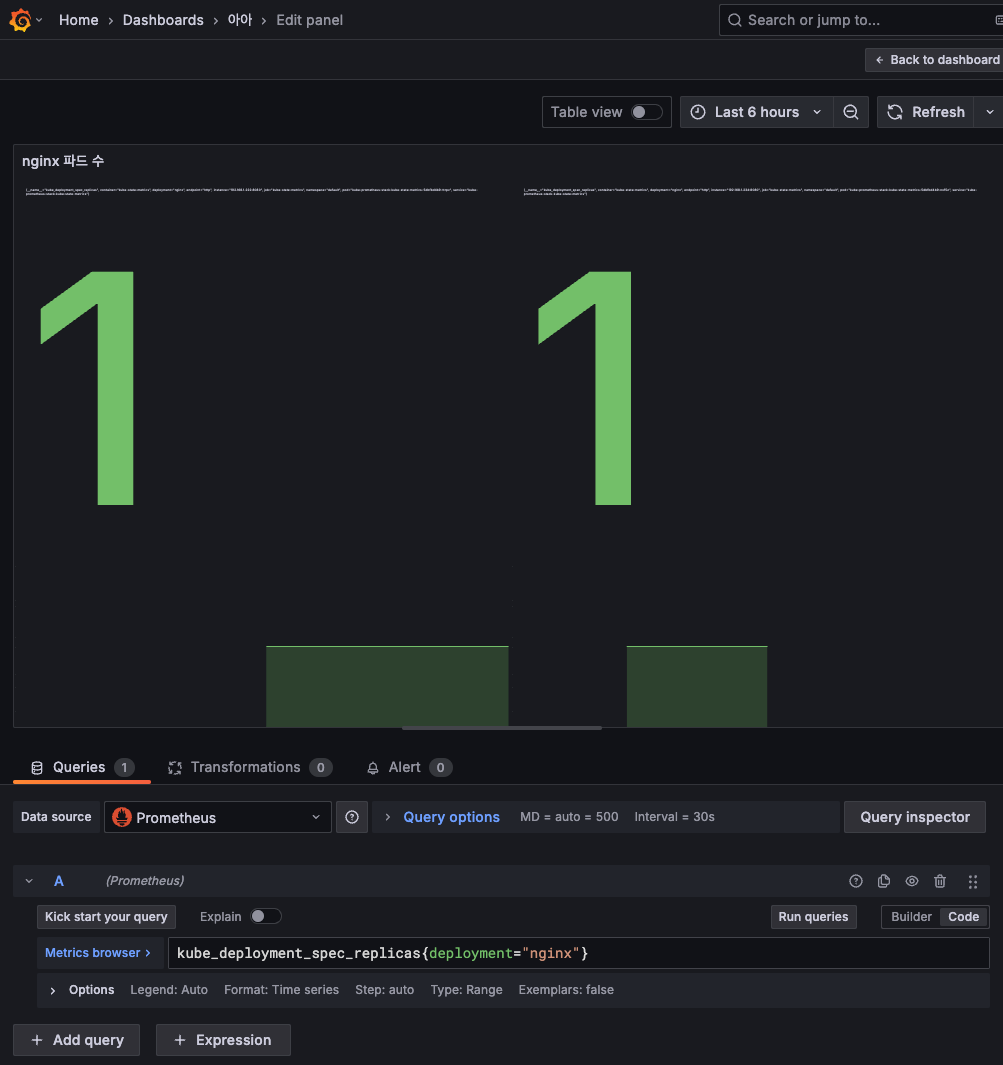

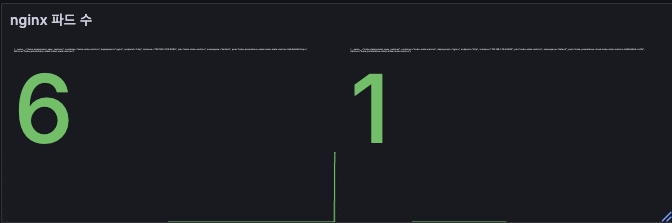

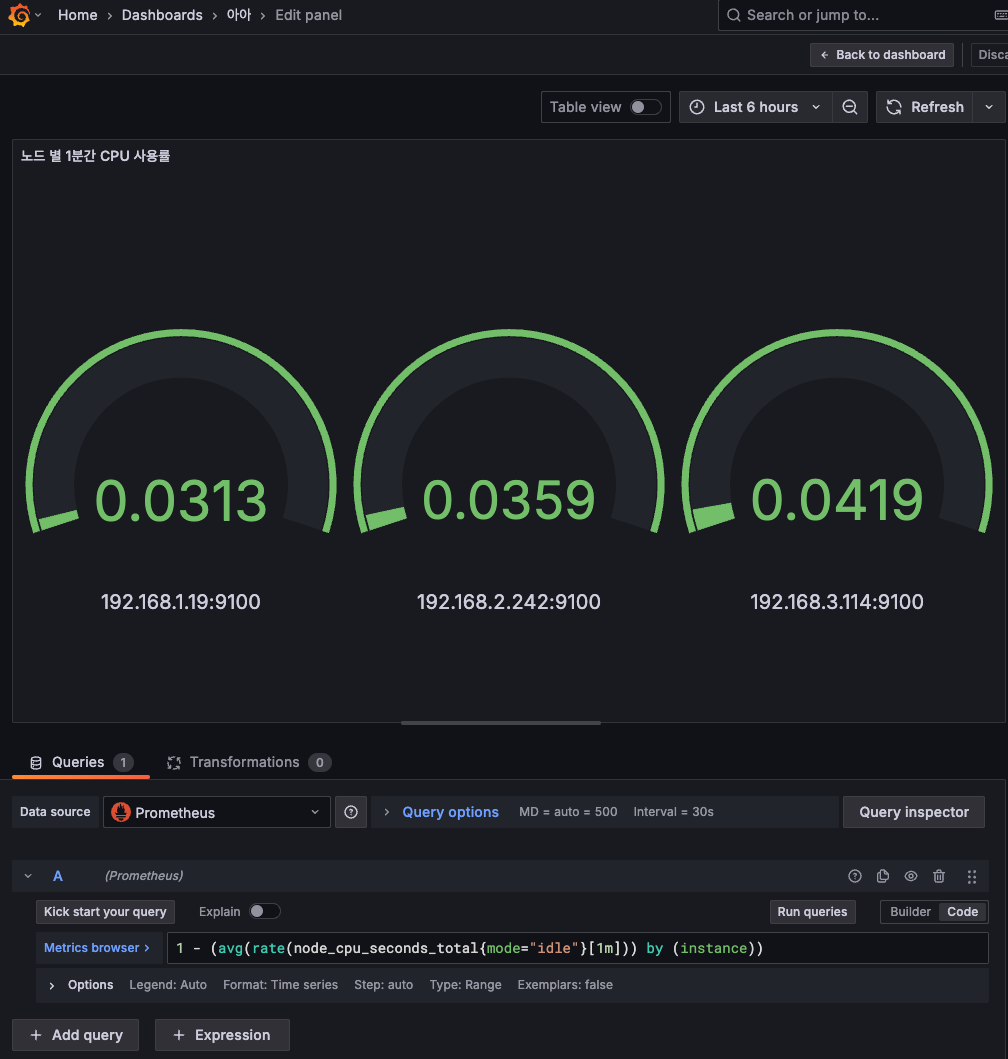

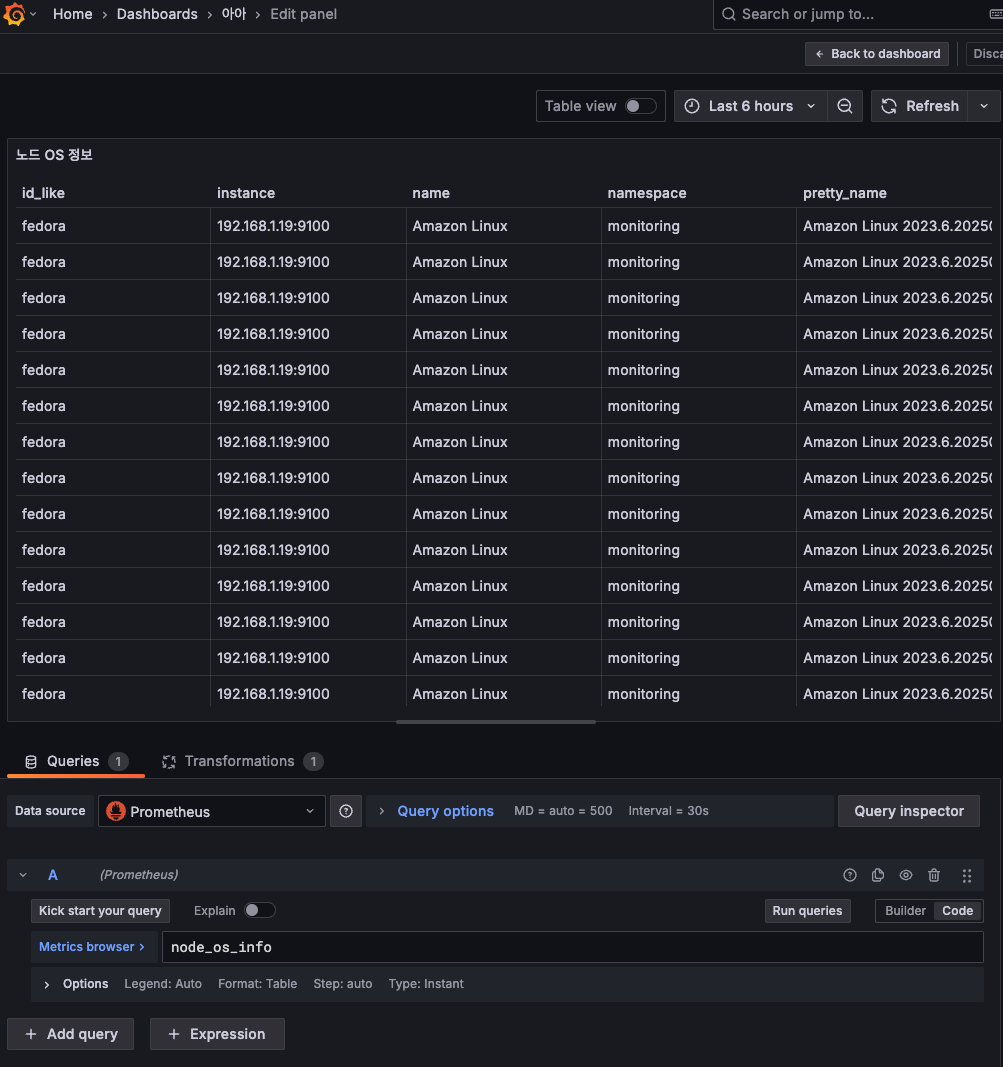

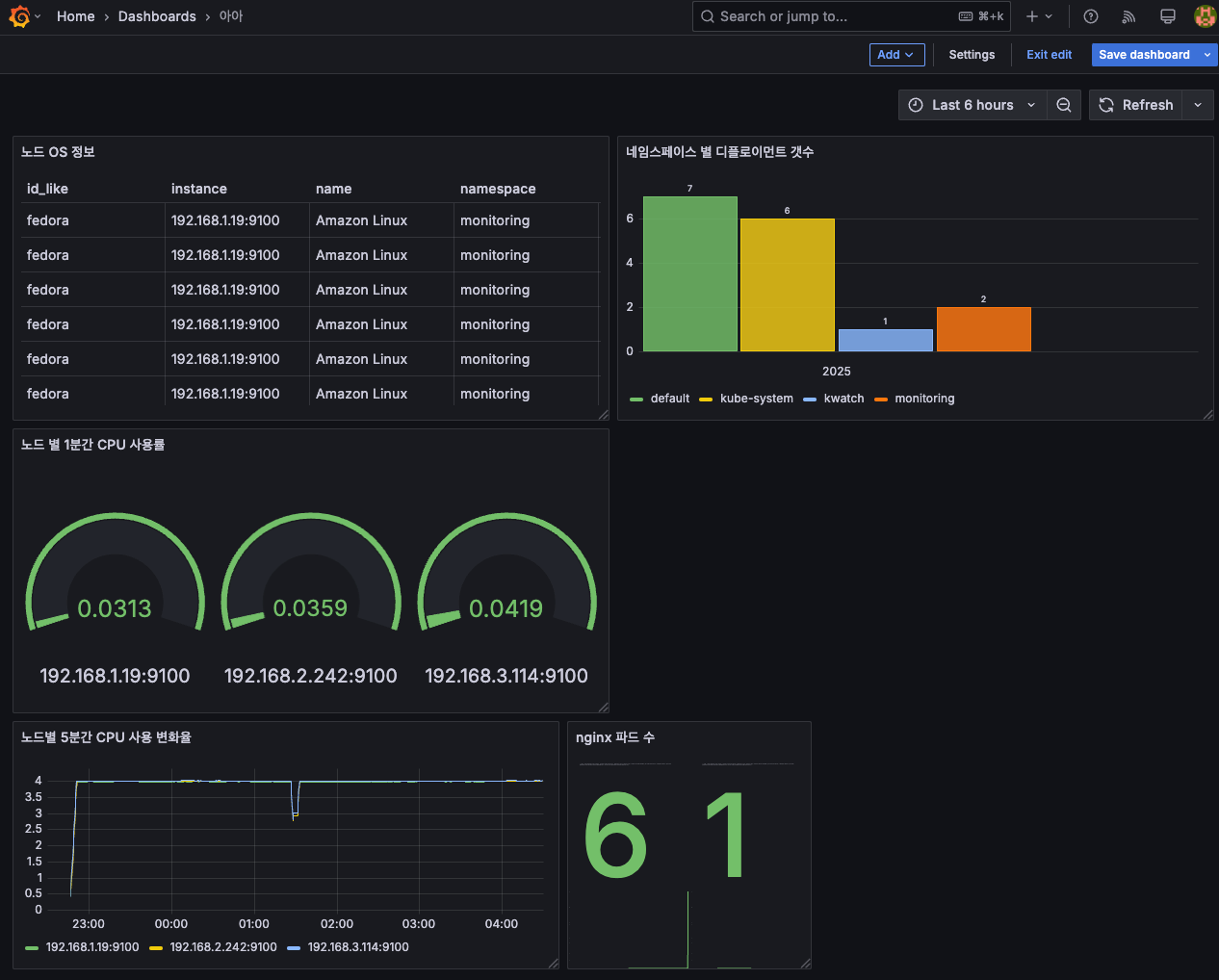

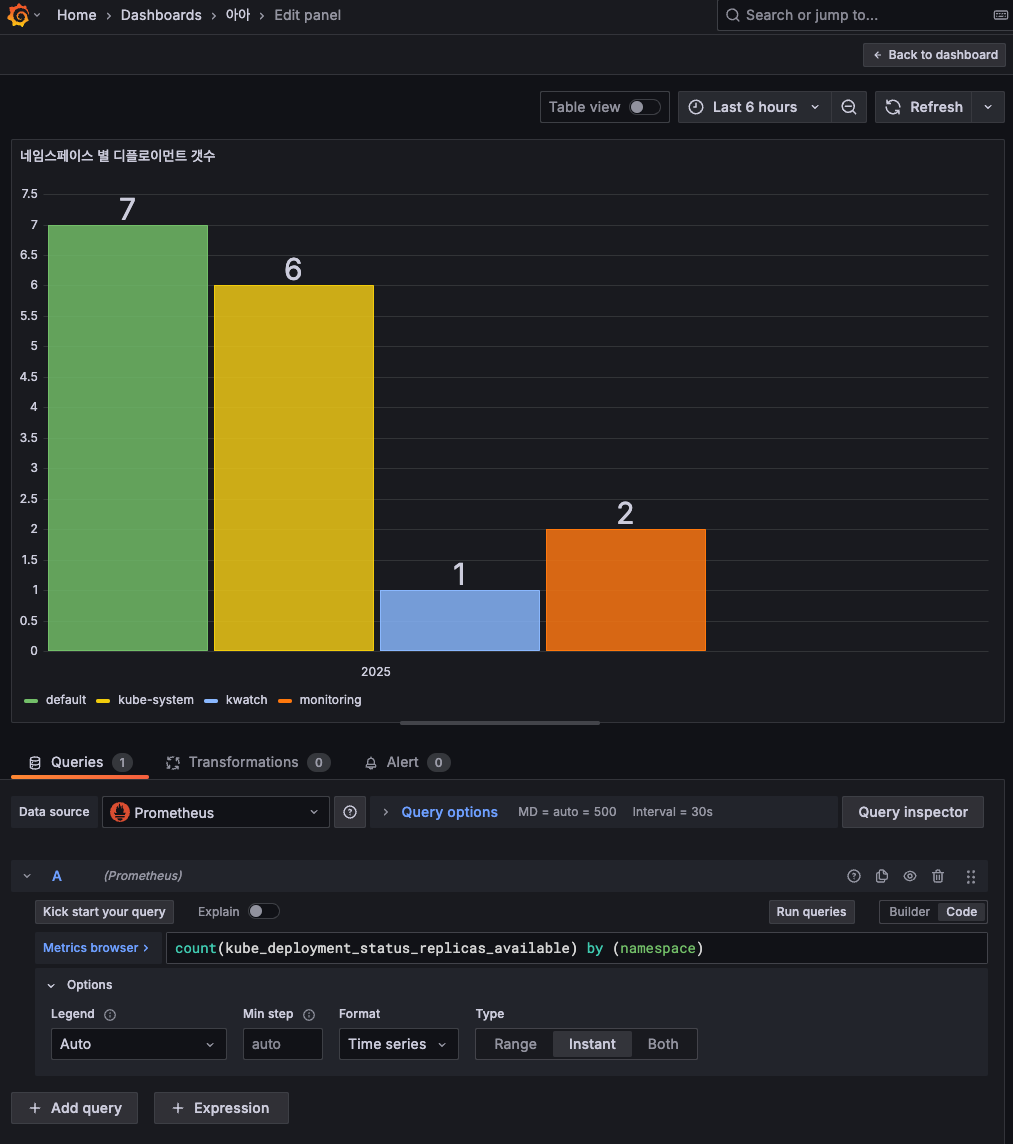

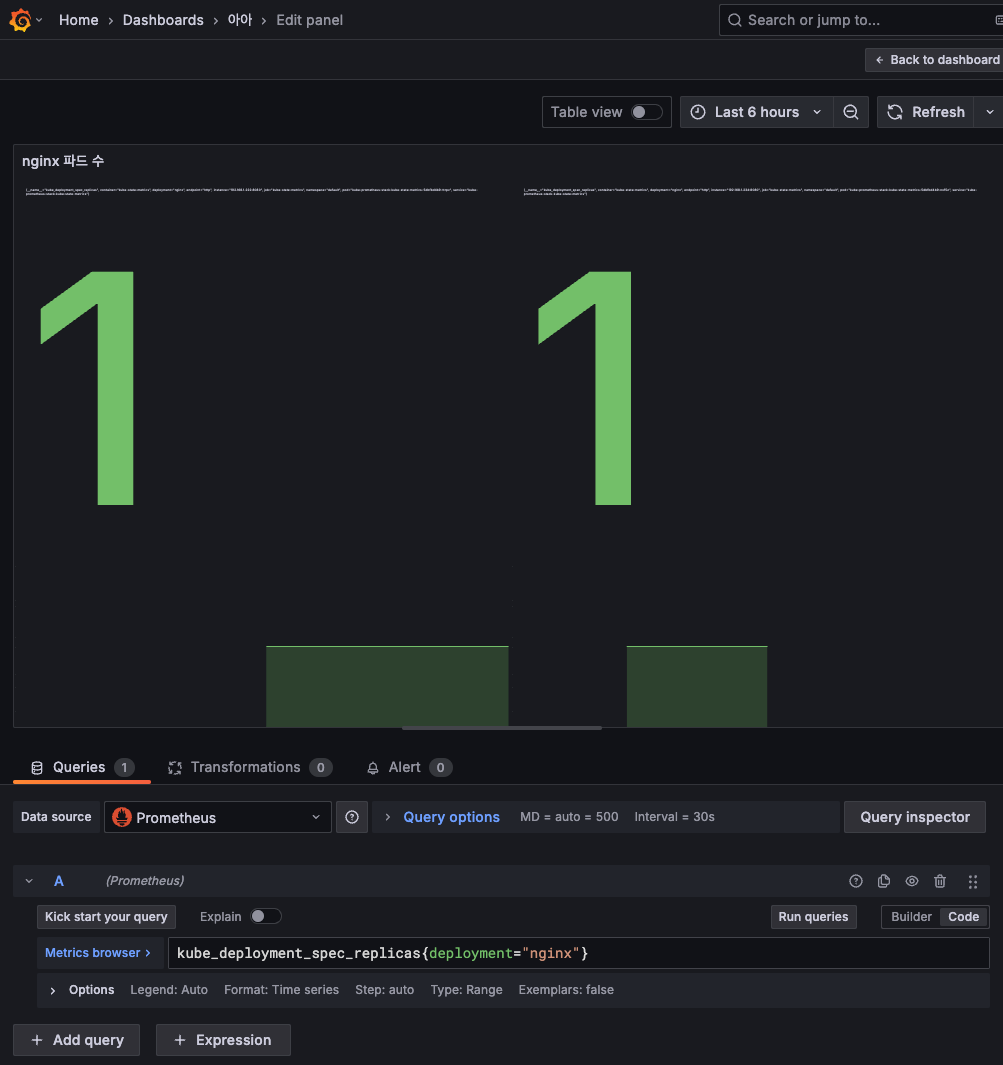

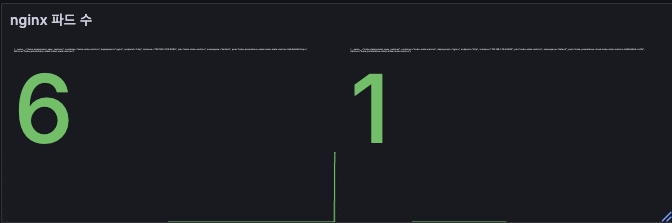

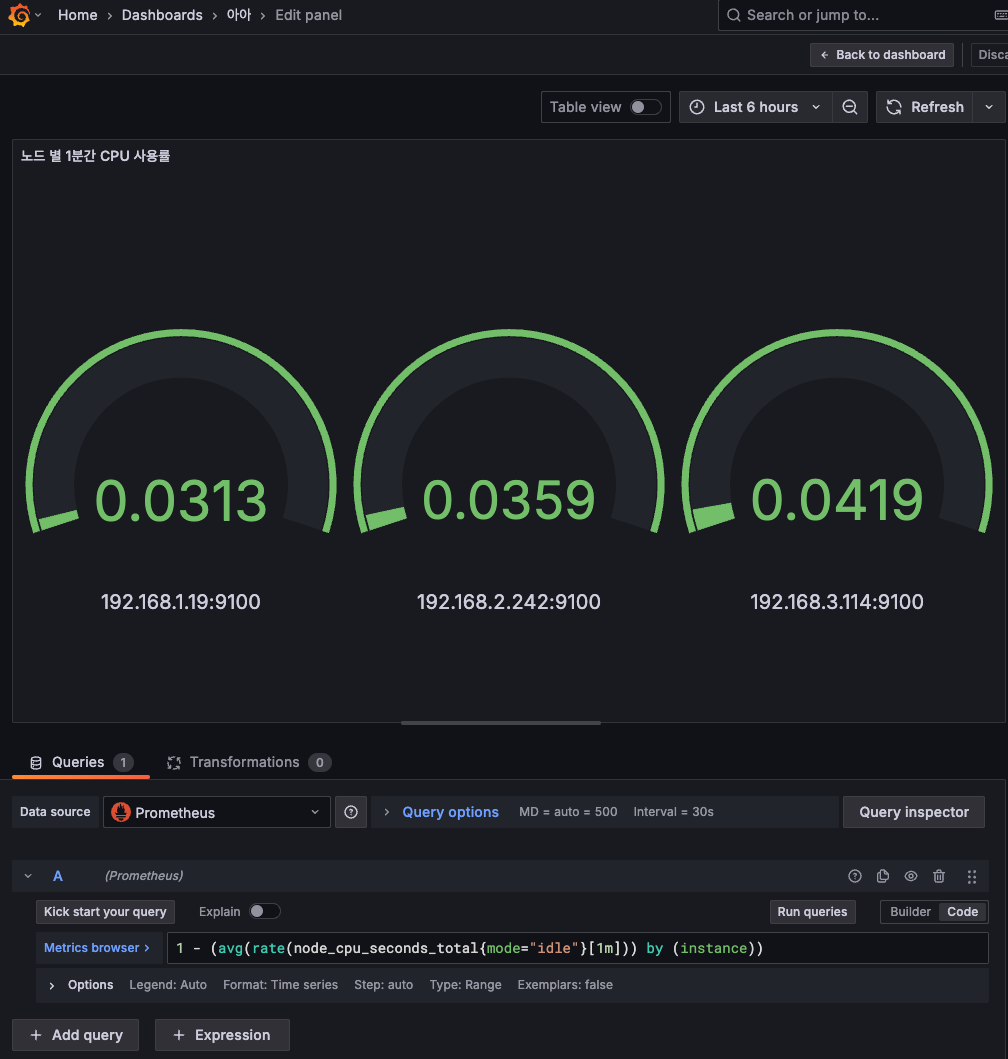

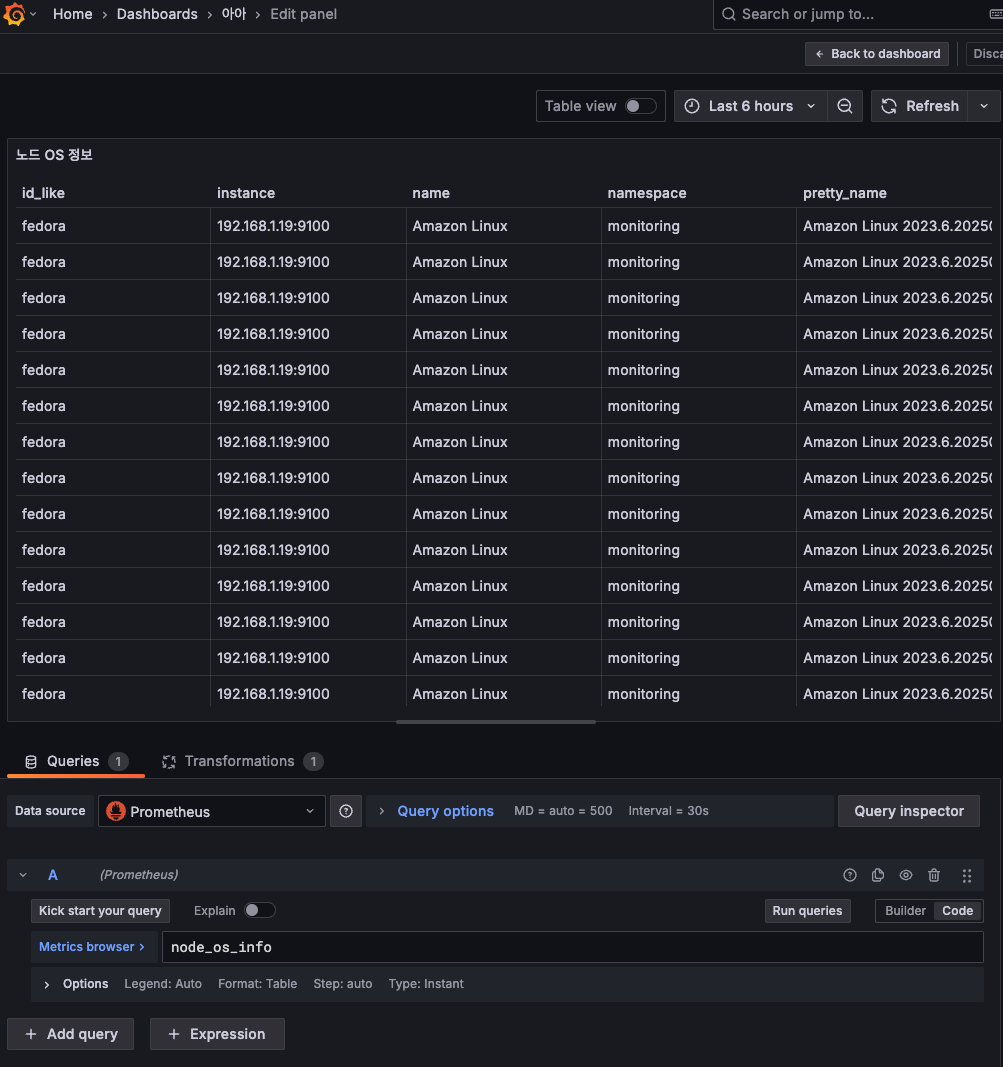

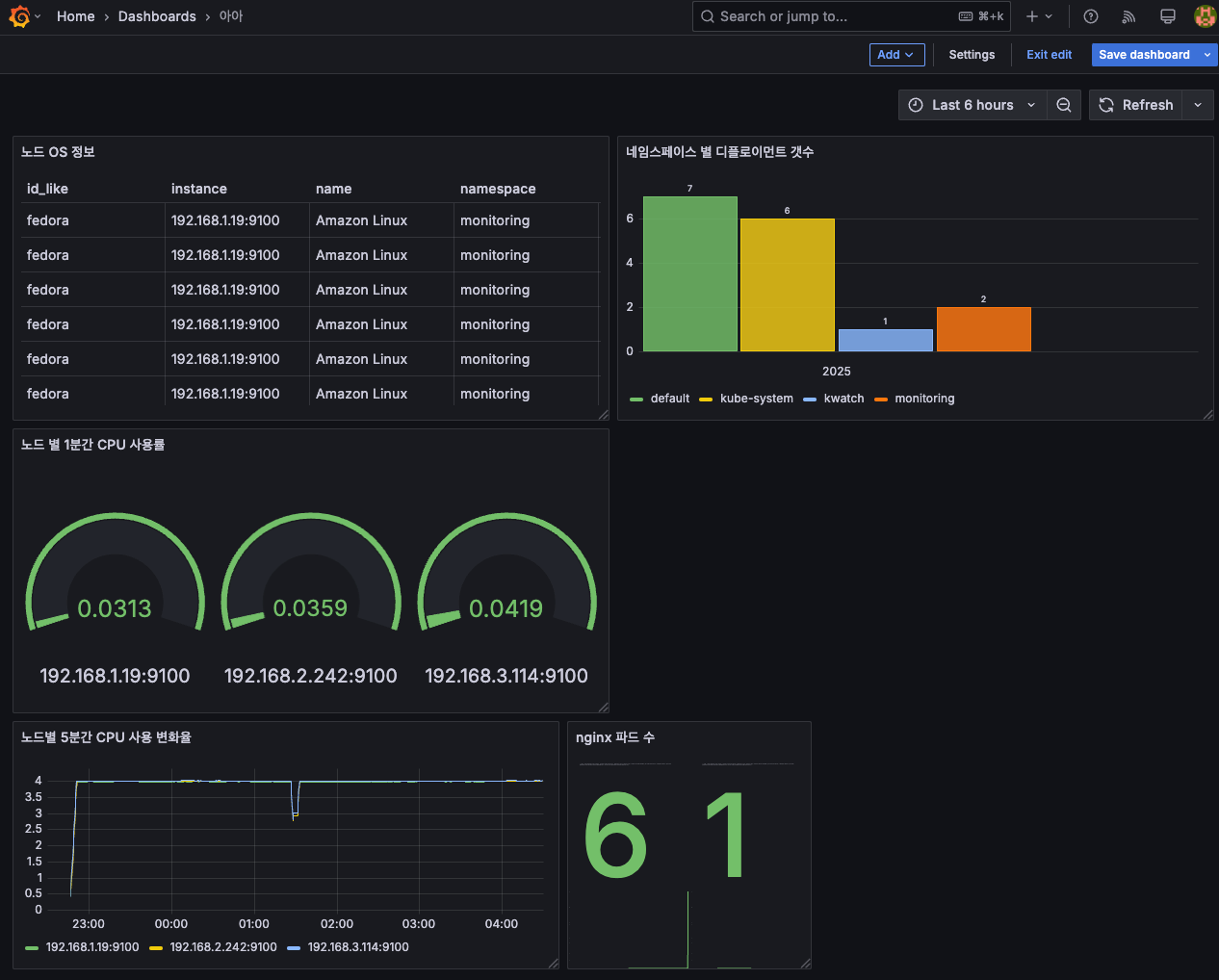

대시보드 만들기

- time series

- bar chart

- stat

## nginx scale 하고 상태 확인

$ k scale deploy nginx --replicas 6

- gauge

- table

기본 값으로 설정할 경우 중복 값이 너무 많아, Transformation으로 보고 싶은 컬럼만 확인할 수 있도록 설정한다.

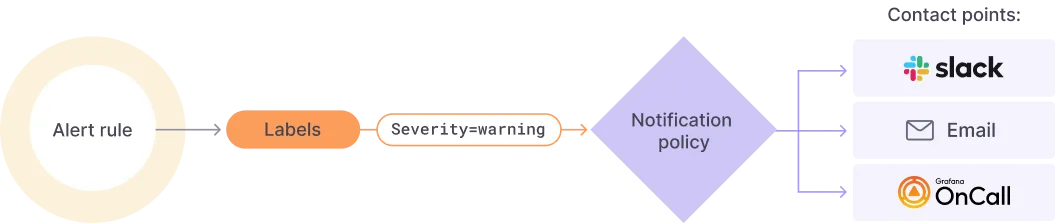

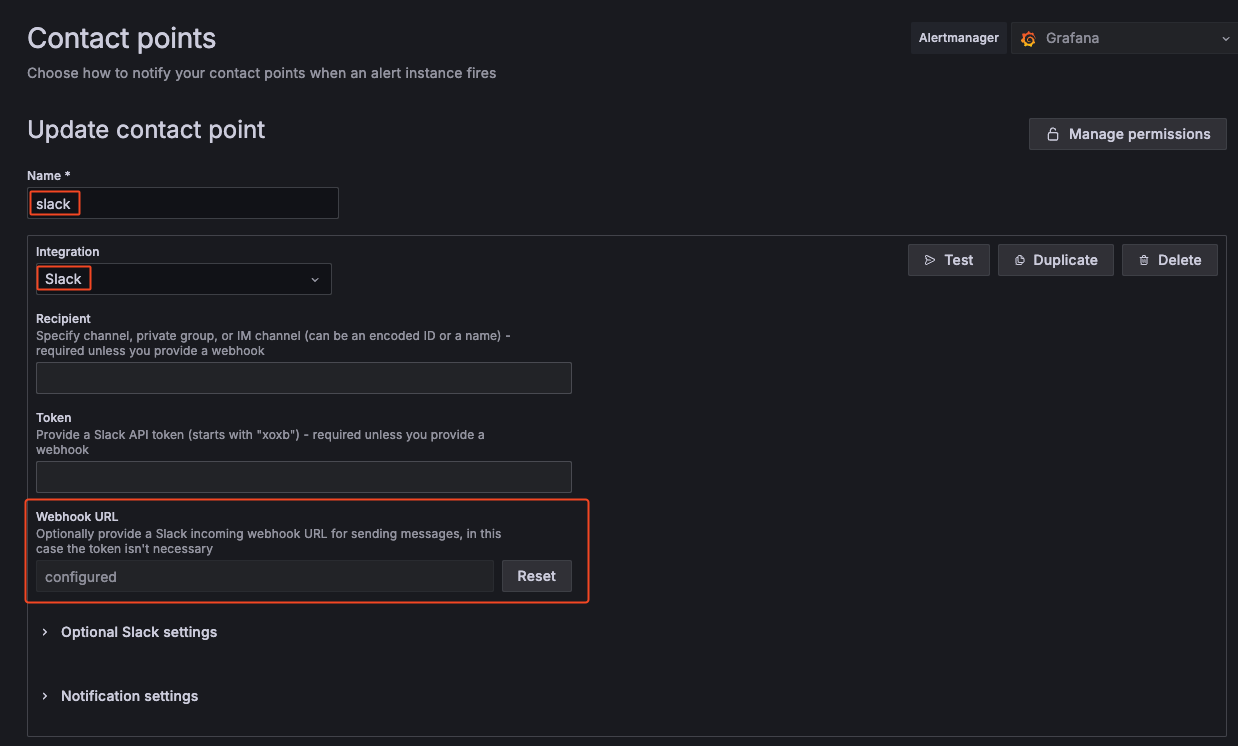

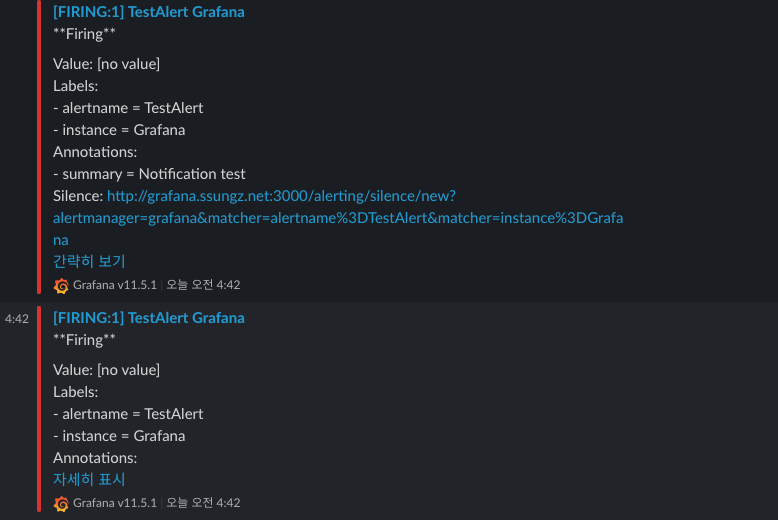

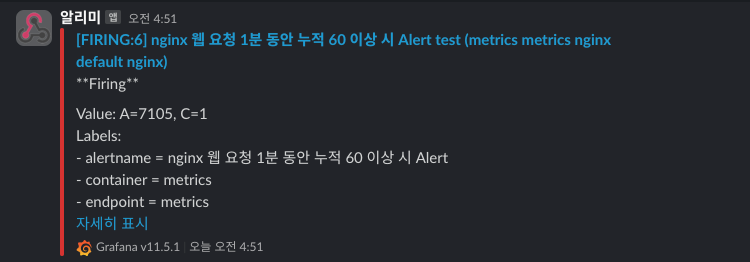

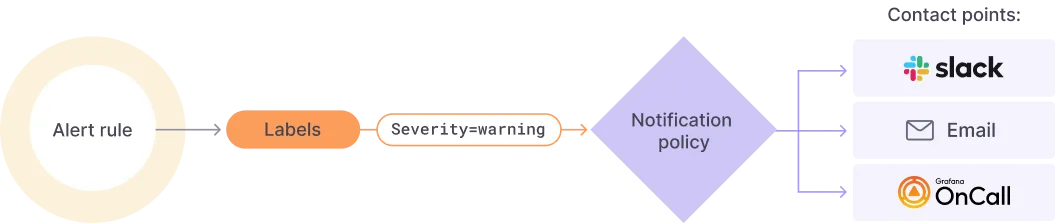

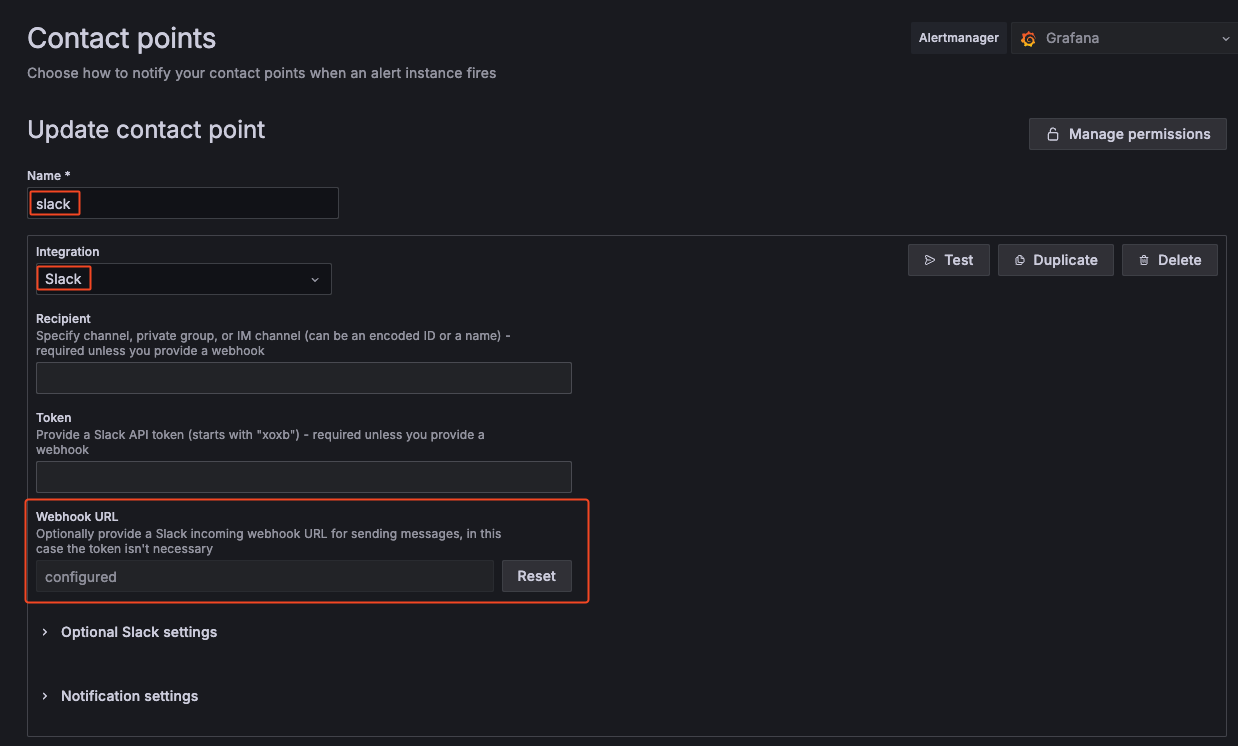

그라파나 얼럿 Alert

사용자가 지정한 룰에 의해 알람이 발생할 경우 여러 매체로 알람이 발송될 수 있도록 설정한다.

설정 위치

[ Grafana > Alerting > Contact points ]

알람을 Slack으로 받을 것이기 때문에 intergration과 이름을 변경한다.

따로 token은 사용하지 않고 webhook URL만 지정했다.

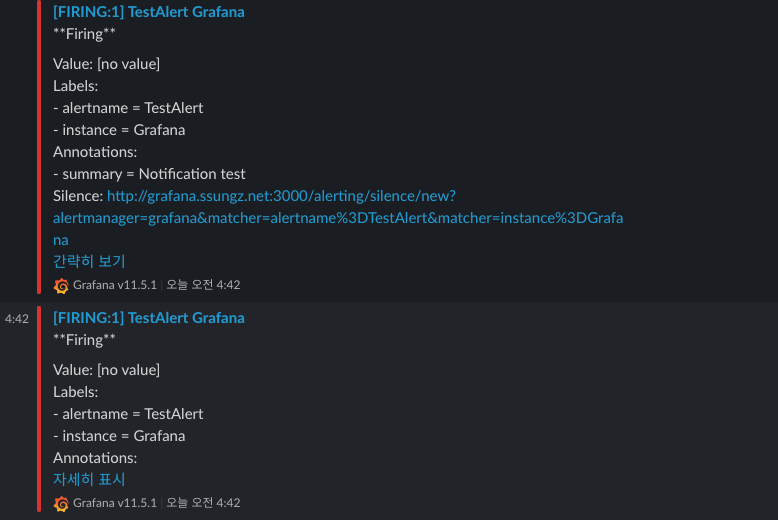

이렇게 지정한 후 테스트를 누르면 Slack으로 테스트 메시지가 발송된다.

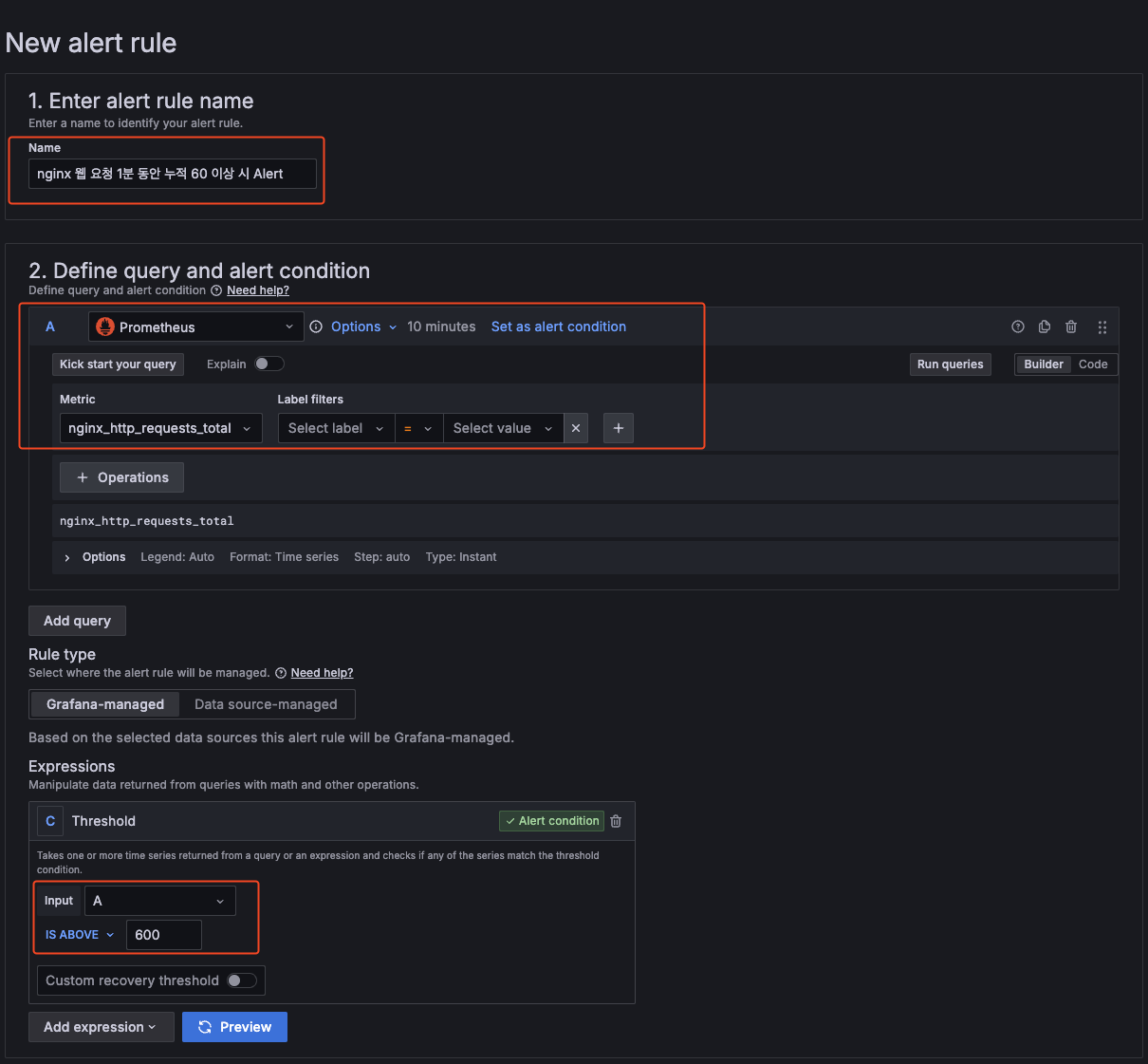

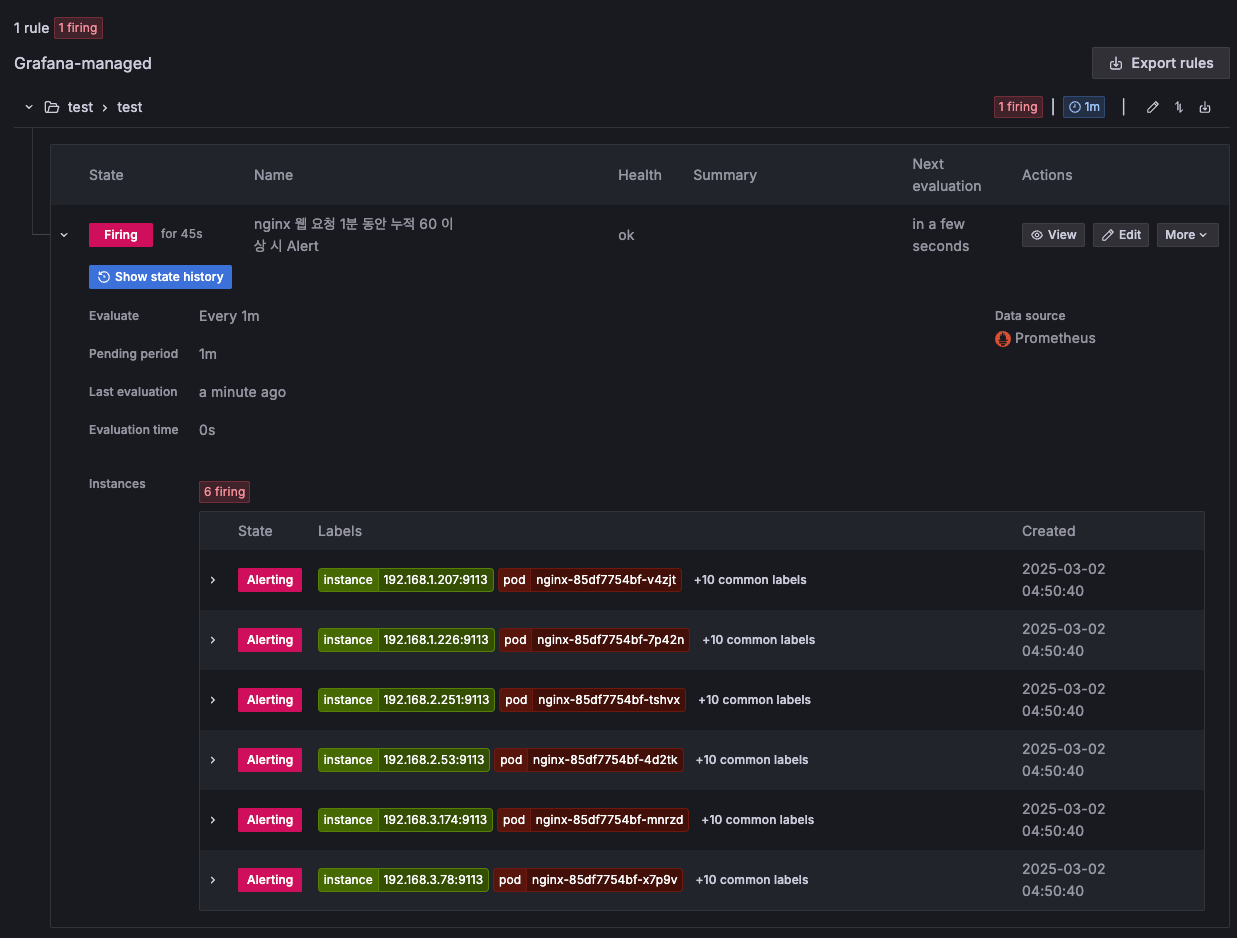

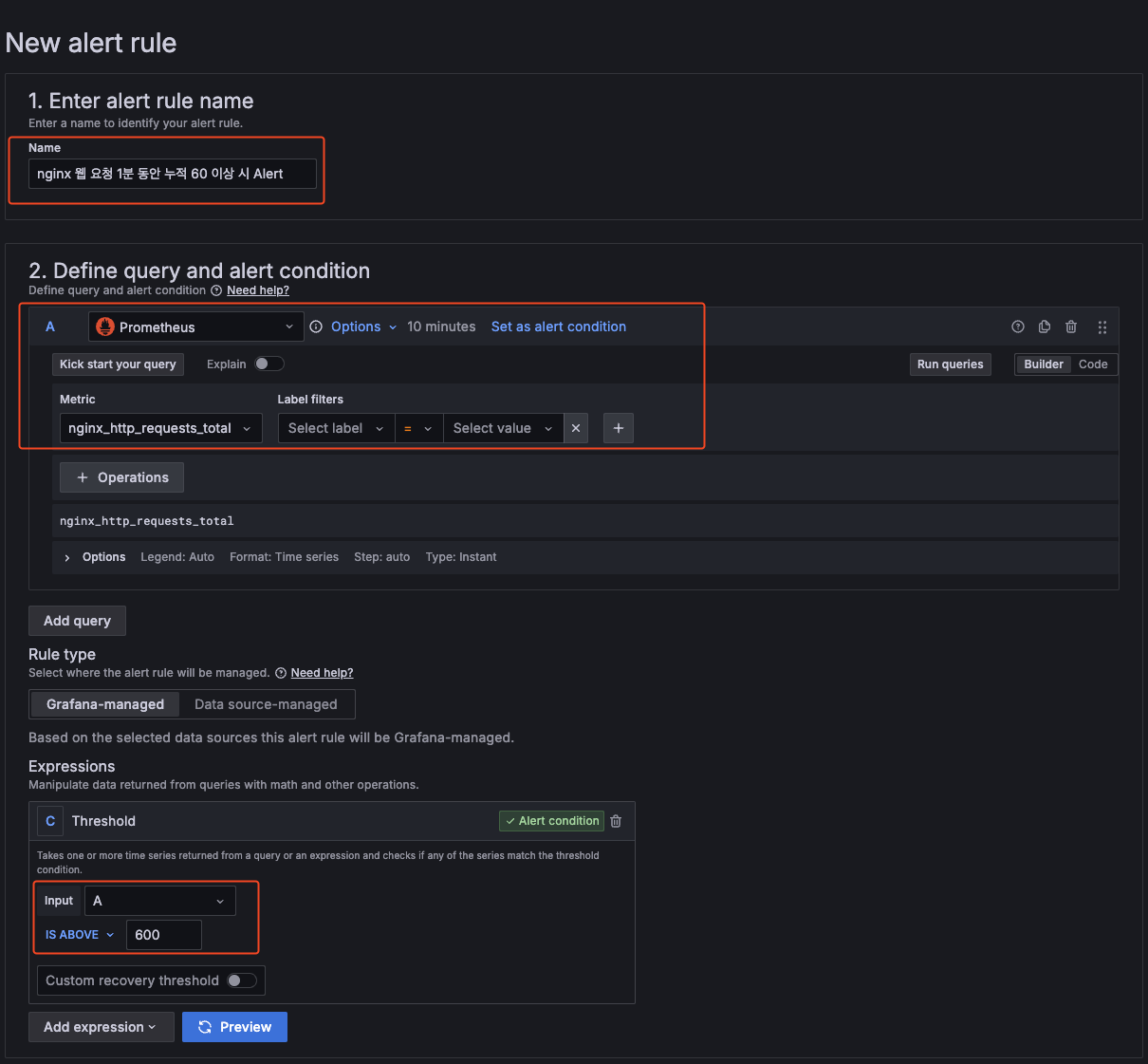

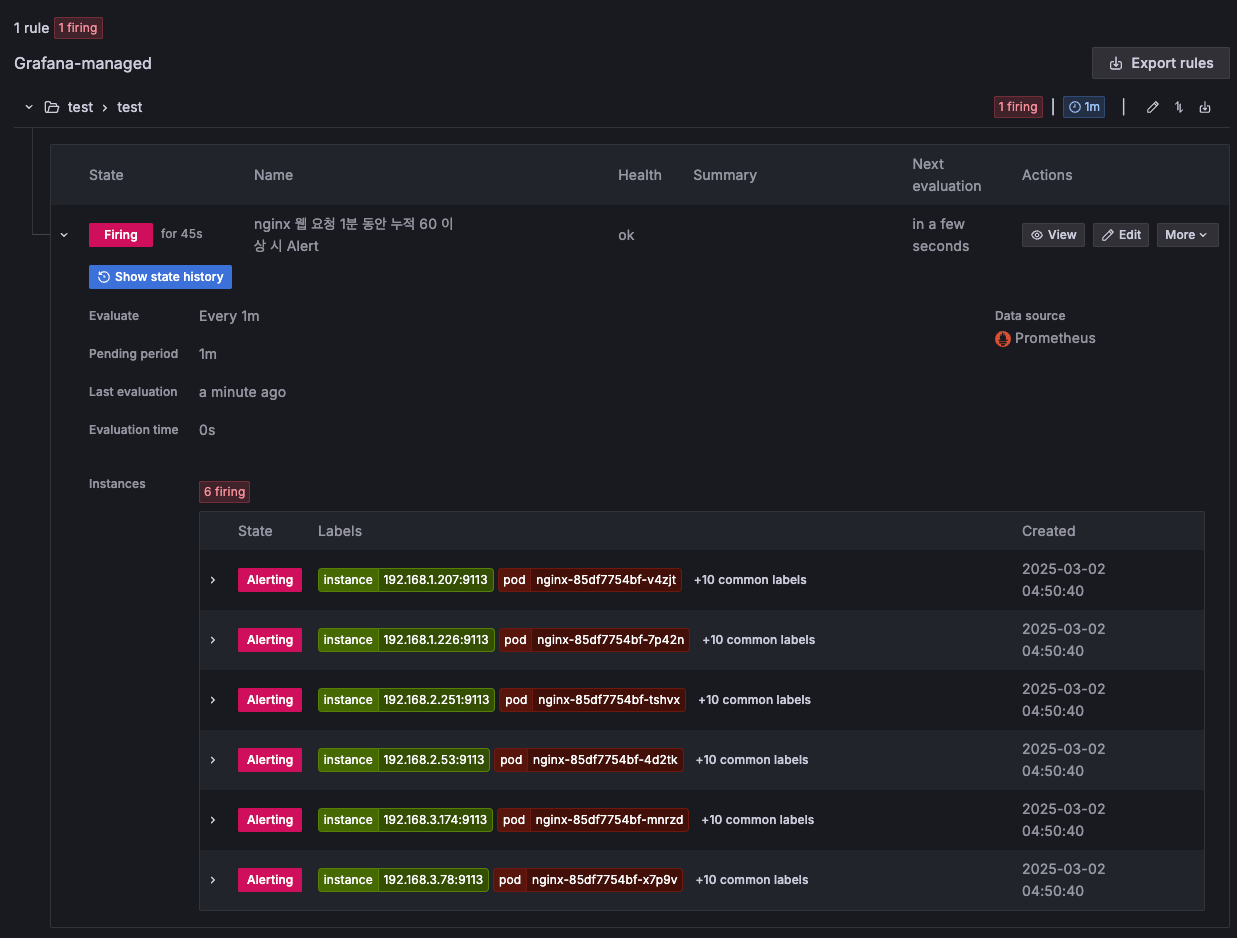

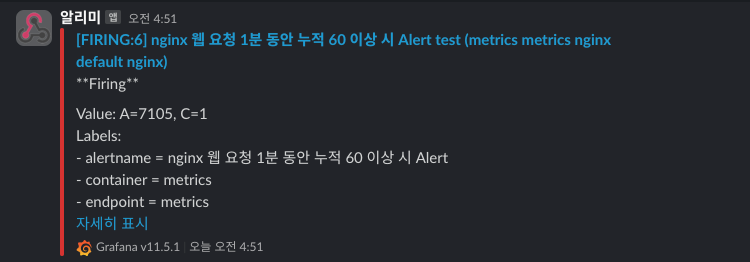

Alerting → Alert ruels → Create alert rule

- nginx 웹 요청 1분 동안 누적 60 이상 시 Alert 설정

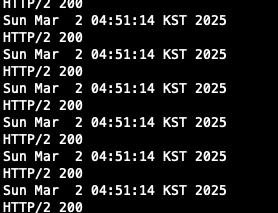

알람 생성 후 nginx로 request 하기

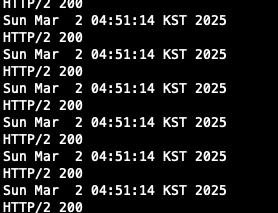

$ while true; do curl -s https://nginx.$MyDomain -I | head -n 1; date; done

생성 시 pending period를 1분으로 설정해 놓아 1분 뒤부터 Alert을 감지 할 수 있다.

1분이 지나면 아래와 같이 alerting이 되는 것을 확인할 수 있고, Slack으로도 알람이 발송되는 것을 확인할 수 있다.

'Cloud > AWS' 카테고리의 다른 글

| [AWS] EKS Autoscaling - KEDA (0) | 2025.03.08 |

|---|---|

| [AWS] EKS AutoScaling - HPA (0) | 2025.03.08 |

| [AWS] EKS Storage (0) | 2025.02.23 |

| [AWS] EKS Networkings (2) (0) | 2025.02.16 |

| [AWS] EKS Networkings (1) (0) | 2025.02.15 |

실습 환경

VPC : 2ea

Work node : 3ea (t3.xlarge)

EC2 : 1ea

EFS : 1ea

- kube-ops-view, AWS LoadBalancer Controller, ExternalDNS, gp3 Storageclass 설치

명령어 or 코드 내에 있는 변수는 이름 그대로의 값을 변수로 잡아 설정했으며,

정확한 명령어를 확인하고 싶을 경우 이전 게시글을 참고하시면 됩니다.

## YAML 파일 다운로드

$ curl -O https://s3.ap-northeast-2.amazonaws.com/cloudformation.cloudneta.net/K8S/myeks-4week.yaml

## 변수 지정

$ CLUSTER_NAME=myeks

$ SSHKEYNAME={KEY 이름}

$ MYACCESSKEYNAME={aws access key}

$ MYSECRETKEYNAME={aws secret key}

## CloudFormation 배포

### yaml 파일 내에 동일한 이름의 stack이 있을 경우 반드시 정리하고 하자.

### Cluster 배포가 안될 수 있음

$ aws cloudformation deploy --template-file myeks-4week.yaml --stack-name $CLUSTER_NAME --parameter-overrides KeyName=$SSHKEYNAME SgIngressSshCidr=$(curl -s ipinfoio/ip)/32 MyIamUserAccessKeyID=$MYACCESSKEY MyIamUserSecretAccessKey=$MYSECRETKEY ClusterBaseName=$CLUSETR_NAME WorkerNodeInstanceType=$WorkerNodeInstanceType --region ap-northeast-2

## 작업용 EC2 IP 출력

$ aws cloudformation describe-stacks --stack-name myeks --query 'Stacks[*].Outputs[0].OutputValue' --output text

## 내 컴퓨터에서 Cluster config 설정

$ eksctl get cluster

$ eks get nodegroup --cluster $CLUSTER_NAME

$ aws sts get-caller-identity --query Arn

$ aws eks udpate-kubeconfig --name myeks --user-alias {arn user}

## Cluster 정보 확인

$ k cluster-info

$ k ns default

$ k get node -v6

$ k get pod -A

$ k get pdb -n kube-system

## kube-ops-view

$ helm repo add geek-cookbook https://geek-cookbook.github.io/charts/

$ helm install kube-ops-view geek-cookbook/kube-ops-view --version 1.2.2 --set service.main.type=ClusterIP -- set env.TZ="Asia/Seoul" --namespace kube-system

## gp3 Storageclass

$ cat <<EOF | kubectl apply -f -=

kiund: StorageClass

apiVersion: storage.k8s.io/v1

metadata:

name: gp3

annotations:

storageclass.kubernetes.io/is-default-class: "true"

allowVolumeExpansion: true

provisioner: ebs.csi.aws.com

volumeBindingMode: WaitForFirstConsumer

parameters:

type: gp3

allowAutoIOPSPerGBIncrease: 'true'

encrypted: 'true'

fsType: xfs

EOF

$ kubectl get sc

## ExternalDNS

$ curl -s https://raw.githubusercontent.com/gasida/PKOS/main/aews/externaldns.yaml | MYDOMAIN=$MyDomain MyDnzHostedZoneID=$MyDnzHostedZoneID envsubst | kubectl apply -f -

## AWS Loadbalancercontroller

$ helm repo add eks https://aws.github.io/eks-charts

$ helm install aws-load-balancer-controller eks/aws-load-balancer-controller -n ube-system --set clusterName=$CLUSTER_NAME \

--set serviceAccount.create=false --set serviceAccount.name=aws-load-balancer-controller

## kube-ops-view 용 ingress 설정

$ cat <<EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

labels:

app.kubernetes.io/name: kubeopsview

name: kubeopsview

namespace: kube-system

spec:

ingressClassName: alb

rules:

- host: kubeopsview.$MyDomain

http:

paths:

- backend:

service:

name: kube-ops-view

port:

number: 8080

path: /

pathType: Prefix

EOF

- 실습을 위한 Book info 예제 배포

## BookInfo 배포

$ k apply -f https://raw.githubusercontent.com/istio/istio/refs/heads/master/samples/bookinfo/platform/kube/bookinfo.yaml

## 배포 확인

$ k get all,sa

## Product 웹 접속 확인

$ k exec "${kubectl get pod -l app=ratings -o jsonpath='{.items[0].metadata.name}')" -c ratings -- curl -sS productpage:9080/productpage | grep -o "<title>.*</title>"

## 로그 확인

$ k stern -l app=productpage

$ k log -l app=productpage -f

- Productpage 접속

## ingress 설정

cat <<EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

labels:

app.kubernetes.io/name: bookinfo

name: bookinfo

spec:

ingressClassName: alb

rules:

- host: bookinfo.$MyDomain

http:

paths:

- backend:

service:

name: productpage

port:

number: 9080

path: /

pathType: Prefix

EOF

## Ingress 확인

$ kubectl get ingress

## bookinfo 웹 페이지 접속 확인

$ echo -e "bookinfo URL = https://bookinfo.$MyDomain/productpage"

$ open "https://bookinfo.$MyDomain/productpage"

## 트래픽 생성을 위한 반복 접근

$ while true; do curl -s -k https://bookinfo.$MyDomain/productpage | grep -o "<title>.*</title>" ; echo "--------------" ; sleep 1; done

배경 소개

모니터링과 관측 가능성 observability(o11y)의 정의와 차이점

| 측면 | 모니터링 | 관측 가능성 |

| 정의 | 특정 메트릭 추적으로 문제 감지 | 외부 출력 데이터로 시스템 상태 이해 |

| 목표 | 문제 발생 시 감지 및 경고 | 문제 원인 진단 및 시스템 최적화 |

| 데이터 소스 | 미리 정의된 메트릭 (CPU, 메모리 등) | 로그, 메트릭, 트레이스, 이벤트 등 |

| 시스템 유형 | 단순한 시스템, 잘 알려진 파라미터 | 복잡한 분산 시스템, 다중 컴포넌트 |

| 상호작용 방식 | 정적 경고 (임계값 기반) | 동적 쿼리 및 분석 (질문 기반) |

- 모니터링의 정의와 특징: 사전에 정의된 기준을 기반으로 시스템의 상태를 감시에 중점

- 모니터링은 IT 시스템의 운영 상태를 추적하고, 성능 지표를 수집하고, 예상치 못한 문제를 조기에 감지하는 과정입니다.

(예: CPU / MEM 사용량, Latency, Error 와 같은 서비스가 운영되는데 반드시 관찰이 필요한 지표들을 모니터링 합니다.)

- 빈도: 연속적이거나, 일정 간격으로 하지만 일반적으로 서비스 모니터링은 24x365 진행하고, 최근에는 hook or 3rd party 상품으로 모니터링 alert을 수신하기도 합니다.

- 관측 가능성의 정의와 특징 : 수집된 다양한 데이터를 활용하여 예측되지 않은 문제까지 분석

- 관측 가능성은 시스템의 내부 상태를 외부 출력 데이터(로그, 메트릭, 트레이스)를 통해 이해할 수 있는 능력을 의미합니다.

(예: 어플리케이션이 Down되지 않았으나, 속도가 느려지는 이슈가 될 경우 트레이스와 로그를 통해 문제 포인트를 파악하는 케이스)

observability의 메트릭 Metric, 로그 log, 추적 tracing 이란?

| 비교 항목 | 메트릭 (Metrics) | 로그(Logs) | 추적(Tracing) |

| 정의 | 수치로 표현된 성능 데이터 | 시스템 이벤트 기록 | 요청이 시스템을 거치는 과정 추적 |

| 형태 | 숫자 (정량적 데이터) | 텍스트 (비정형 데이터) | 트랜잭션 흐름 데이터 |

| 예시 데이터 | CPU 사용률, 응답 시간, 요청 수 | 오류 메시지, 로그인 시도, API 호출 로그 | A 서비스 → B 서비스 → C 서비스 요청 흐름 |

| 주요 목적 | 시스템 성능 모니터링 및 알람 | 이벤트 분석 및 디버깅 | 서비스 간 호출 경로 및 병목 현상 분석 |

| 저장 방식 | 시계열 데이터베이스(TSDB) | 로그 파일 또는 로그 관리 시스템 | 분산 트레이싱 시스템 (Jaeger, Zipkin) |

| 활용 도구 | Prometheus, Grafana | ELK Stack, Loki | Jaeger, Zipkin |

SLI (Service Level Indicator, 서비스 수준 지표)

- SLI는 서비스 품질을 정량적으로 측정하는 주요 성능 지표

- 서비스의 신뢰성과 성능을 평가하는 데 사용되는 실제 측정 지표

SLO (Service Level Objective, 서비스 수준 목표)

- SLO는 서비스가 유지해야 하는 목표 수준을 정의하는 값으로, SLI에 대한 기준선을 설정

- "이 정도의 성능을 유지해야 한다"는 목표를 의미

SLA (Service Level Agreement, 서비스 수준 계약)

- SLA는 서비스 제공자와 고객 간에 체결된 공식적인 계약, 서비스 품질을 보장하는 법적 문서

- SLA는 SLO와 달리 계약 위반 시 보상이 존재

Loggin in EKS

Control Plane Logging

1. Kubernetes API server component logs (api) – kube-apiserver-<nnn...>

2. Audit (audit) – kube-apiserver-audit-<nnn...>

3. Authenticator (authenticator) – authenticator-<nnn...>

4. Controller manager (controllerManager) – kube-controller-manager-<nnn...>

5. Scheduler (scheduler) – kube-scheduler-<nnn...>

- eksctl 기본값

## 모든 로깅 활성화

$ aws eks update-cluster-config --region ap-northeast-2 --name $CLUSTER_NAME \

--logging '{"clusterLogging":[{"types":["api","audit","authenticator","controllerManager","scheduler"],"enabled":true}]}'

## 로그 그룹 확인

$ aws logs describe-log-groups | jq

## 로그 tail 확인

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster | more

## 신규 로그를 바로 출력

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --follow

- 콘솔에서도 확인할 수 있습니다.

## 로그 스트림 이름

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix <로그 스트림 prefix> --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-apiserver --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-apiserver-audit --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-scheduler --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix authenticator --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix kube-controller-manager --follow

$ aws logs tail /aws/eks/$CLUSTER_NAME/cluster --log-stream-name-prefix cloud-controller-manager --follow

- Log Insights를 통해 다양하게 로그를 확인할 수 있습니다.

## 로그 끄기

$ eksctl utils update-cluster-logging --cluster $CLUSTER_NAME --region ap-northeast-2 --disable-types all --approve

## 로그 그룹 삭제

$ aws logs delete-log-group --log-group-name /aws/eks/$CLUSTER_NAME/cluster

실습을 위한 Pod 배포

- NGINX 파드 배포

## nginx 웹서버 배포

$ helm repo add bitnami https://charts.bitnami.com/bitnami

$ helm repo update

## 도메인, 인증서 확인

$ echo $MyDomain $CERT_ARN

## 파라미터 파일 생성

$ cat <<EOT > nginx-values.yaml

service:

type: NodePort

networkPolicy:

enabled: false

resourcesPreset: "nano"

ingress:

enabled: true

ingressClassName: alb

hostname: nginx.$MyDomain

pathType: Prefix

path: /

annotations:

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/load-balancer-name: $CLUSTER_NAME-ingress-alb

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/ssl-redirect: "443"

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/target-type: ip

EOT

## 배포

$ helm install nginx bitnami/nginx --version 19.0.0 -f nginx-values.yaml

## 생성 확인

$ k get ingress,deploy,svc,ep nginx

$ k describe deploy nginx

$ k get targetgroupbindings

## 접속 테스트

$ curl -s https://nginx.$MyDomain

## 로그 확인

$ k stern deploy/nginx

# 반복 접속

$ while true; do curl -s https://nginx.$MyDomain | grep title; date; sleep 1; done

$ while true; do curl -s https://nginx.$MyDomain -I | head -n 1; date; sleep 1; done

- 컨테이너 로그 환경의 로그는 표준 출력 stdou과 표준 에러 stderr로 보내는 것을 권고

## 로그 모니터링

$ k stern deploy/nginx

## 컨테이너 로그 파일 위치

$ k exec -it deploy/nginx -- ls -l /opt/bitnami/nginx/logs/

Container Insights metrics in Amazon CloudWatch & Fluent Bit

- Fluent Bit 컨테이너를 데몬셋으로 동작시키고, 아래 로그를 CloudWatch Logs에 전송

1. /aws/containerinsights/cluster_name/application : 각 컨테이너/파드 로그

2. /aws/containerinsights/cluster_name/host : 노드(호스트) 로그 (/var/log/dmesg, secure, messages)

3. /aws/containerinsights/cluster_name/dataplane : 쿠버네티스 데이터 플레인 로그 (journal, kubelet service, kubeproxy.service)

- [저장] : CloudWatch Logs 에 로그를 저장, 로그 그룹 별 로그 보존 기간 설정 가능

- [시각화] : CloudWatch 의 logs insights 를 사용하여 대상 로그를 분석하고, CloudWatch의 대시보드로 시각화

- 노드의 로그 확인

1) application 로그 소스, 파드로그

## 로그 위치 확인

$ for node in $N1 $N2 $N3; do echo ">>> $node <<<"; ssh ec2-user@$node sudo tree /var/log/containers; echo; done

$ for node in $N1 $N2 $N3; do echo ">>> $node <<<"; ssh ec2-user@$node sudo ls -al /var/log/containers; echo; done

2) host 로그 소스, 노드 로그

## 로그 위치

$ for node in $N1 $N2 $N3; do echo ">>>>> $node <<<<<"; ssh ec2-user@$node sudo tree /var/log/ -L 1; echo; done

$ for node in $N1 $N2 $N3; do echo ">>>>> $node <<<<<"; ssh ec2-user@$node sudo ls -la /var/log/; echo; done

## 호스트 로그 화깅ㄴ

## AML 운영체제는 rocky 계열과 로그 이름이 다름

$ for node in $N1 $N2 $N3; do echo ">>>>> $node <<<<<"; ssh ec2-user@$node sudo cat /var/log/audit/audit.log; echo; done

3) dataplane로그 소스 쿠버네티스 데이터 플레인 로그

## 로그 위치 확인

$ for node in $N1, $N2 $N3; do echo ">>>> $node <<<<"; ssh ec2-user@$node sudo tree /var/log/journal -L 1; echo; done

## 저널 로그 확인

$ ssh ec2-user@$N3 sudo journalctl -x -n 200

$ ssh ec2-user@$N3 sudo journalctl -f## CloudWatch Container Observability 설치

## IRSA 설정

$ eksctl create iamserviceaccount \

--name cloudwatch-agent \

--namespace amazon-cloudwatch --cluster $CLUSTER_NAME \

--role-name $CLUSTER_NAME-cloudwatch-agent-role \

--attach-policy-arn arn:aws:iam::aws:policy/CloudWatchAgentServerPolicy \

--role-only \

--approve

## addon 배포

$ aws eks create-addon --addon-name amazon-cloudwatch-observability --cluster-name myeks --service-account-role-arn arn:aws:iam::<IAM User Account ID직접 입력>:role/myeks-cloudwatch-agent-role

## addon 확인

aws eks list-addons --cluster-name myeks --output table

## 설치 확인

$ k get crd | grep -i cloudwatch

amazoncloudwatchagents.cloudwatch.aws.amazon.com 2025-03-01T15:06:51Z

dcgmexporters.cloudwatch.aws.amazon.com 2025-03-01T15:06:51Z

instrumentations.cloudwatch.aws.amazon.com 2025-03-01T15:06:52Z

neuronmonitors.cloudwatch.aws.amazon.com 2025-03-01T15:06:52Z

- cloudwatch-agent 설정 확인

## cloudwatch-agent 설정 확인

$ k describe cm cloudwatch-agent -n amazon-cloudwatch

Name: cloudwatch-agent

Namespace: amazon-cloudwatch

Labels: app.kubernetes.io/component=amazon-cloudwatch-agent

app.kubernetes.io/instance=amazon-cloudwatch.cloudwatch-agent

app.kubernetes.io/managed-by=amazon-cloudwatch-agent-operator

app.kubernetes.io/name=cloudwatch-agent

app.kubernetes.io/part-of=amazon-cloudwatch-agent

app.kubernetes.io/version=1.300052.0b1024

Annotations: <none>

Data

====

cwagentconfig.json:

----

{"agent":{"region":"ap-northeast-2"},"logs":{"metrics_collected":{"application_signals":{"hosted_in":"myeks"},"kubernetes":{"cluster_name":"myeks","enhanced_container_insights":true}}},"traces":{"traces_collected":{"application_signals":{}}}}

BinaryData

====

Events: <none>

$ k get cm cloudwatch-agent -n amazon-cloudwatch -o jsonpath="{.data.cwagentconfig\.json}" | jq

{

"agent": {

"region": "ap-northeast-2"

},

"logs": {

"metrics_collected": {

"application_signals": {

"hosted_in": "myeks"

},

"kubernetes": {

"cluster_name": "myeks",

"enhanced_container_insights": true

}

}

},

"traces": {

"traces_collected": {

"application_signals": {}

}

}

}

## fluent bit 로그의 input/filter/output 설정 확인

$ k describe cm fluent-bit-config -n amazon-cloudwatch

application-log.conf:

----

[INPUT]

Name tail

Tag application.*

Exclude_Path /var/log/containers/cloudwatch-agent*, /var/log/containers/fluent-bit*, /var/log/containers/aws-node*, /var/log/containers/kube-proxy*

Path /var/log/containers/*.log

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_container.db

Mem_Buf_Limit 50MB

Skip_Long_Lines On

Refresh_Interval 10

Rotate_Wait 30

storage.type filesystem

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag application.*

Path /var/log/containers/fluent-bit*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_log.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[INPUT]

Name tail

Tag application.*

Path /var/log/containers/cloudwatch-agent*

multiline.parser docker, cri

DB /var/fluent-bit/state/flb_cwagent.db

Mem_Buf_Limit 5MB

Skip_Long_Lines On

Refresh_Interval 10

Read_from_Head ${READ_FROM_HEAD}

[FILTER]

Name aws

Match application.*

az false

ec2_instance_id false

Enable_Entity true

[FILTER]

Name kubernetes

Match application.*

Kube_URL https://kubernetes.default.svc:443

Kube_Tag_Prefix application.var.log.containers.

Merge_Log On

Merge_Log_Key log_processed

K8S-Logging.Parser On

K8S-Logging.Exclude Off

Labels Off

Annotations Off

Use_Kubelet On

Kubelet_Port 10250

Buffer_Size 0

Use_Pod_Association On

[OUTPUT]

Name cloudwatch_logs

Match application.*

region ${AWS_REGION}

log_group_name /aws/containerinsights/${CLUSTER_NAME}/application

log_stream_prefix ${HOST_NAME}-

auto_create_group true

extra_user_agent container-insights

add_entity true

- (콘솔) 메트릭 확인 : CW > 인사이트 > Container Insights

운영 서버 EC2 에서 반복 접근하고 로그 확인하기

## 부하 발생

$ yum install -y httpd

$ ab -c 500 -n 30000 https://nginx.$MyDomain/

## 파드 로그 확인

$ k stern deploy/nginx

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

nginx-7c94c9bdcb-pg8hb nginx 192.168.2.43 - - [01/Mar/2025:15:39:03 +0000] "GET / HTTP/1.1" 200 615 "-" "ApacheBench/2.3" "43.201.64.36"

- 콘솔에서 확인하기

- 메트릭 확인 : cloudwatch > insights > container insights

Metric-Server & kwatch & botkube

Metrics-server 확인 : kubelet으로부터 수집한 리소스 메트릭을 수집 및 집계하는 클러스터 애드온 구성 요소

kwatch : 클러스터와 앱에서 탐지되는 것들을 실시간으로 slack, discord와 같은 도구에 노티해준다.

## 닉네임 설정

NICK=ssungz

## configmap 생성

$ cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Namespace

metadata:

name: kwatch

---

apiVersion: v1

kind: ConfigMap

metadata:

name: kwatch

namespace: kwatch

data:

config.yaml: |

alert:

slack:

webhook: 'slack webhook url'

title: $NICK-eks

pvcMonitor:

enabled: true

interval: 5

threshold: 70

EOF

## 배포

$ k apply -f https://raw.githubusercontent.com/abahmed/kwatch/v0.8.5/deploy/deploy.yaml

- 잘못된 이미지 파드 배포 및 확인

## 모니터링

$ watch kubectl get pod

## 잘못된 이미지 정보의 파드 배포

$ cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: nginx-19

spec:

containers:

- name: nginx-pod

image: nginx:1.19.19 # 존재하지 않는 이미지 버전

EOF

kubectl get events -w

## 이미지 업데이트 방안 : set 사용

$ k set image pod nginx-19 nginx-pod=nginx:1.19

## 삭제

$ k delete pod nginx-19

- Slack alert 확인

프로메테우스-스택

프로메테우스는 오픈소스로 모니터링과 alert를 주 기능으로 제공합니다.

다음은 해당 내용을 표로 만든 것입니다.

프로메테우스가 시각화에 뛰어나지 않기 때문에 시각화가 뛰어난 grafana에 data source로 추가하여 모니터링합니다.

| 구성 요소 | 설명 |

| Prometheus | 시계열(time-series) 데이터 수집 및 저장 |

| Grafana | Prometheus 데이터를 시각화하는 대시보드 도구 |

| Alertmanager | Prometheus 경고(Alert)를 관리 및 전송 |

| Node Exporter | Kubernetes 노드 및 시스템 메트릭 수집 |

| Kube State Metrics | Kubernetes 리소스 상태(Pod, Node, Deployment 등) 메트릭 제공 |

| cAdvisor | 컨테이너 리소스 사용량 모니터링 (CPU, 메모리, 디스크, 네트워크) |

운영 EC2에 프로메테우스 직접 설치

# 최신 버전 다운로드

wget https://github.com/prometheus/prometheus/releases/download/v3.2.0/prometheus-3.2.0.linux-amd64.tar.gz

# 압축 해제

tar -xvf prometheus-3.2.0.linux-amd64.tar.gz

cd prometheus-3.2.0.linux-amd64

ls -l

# 바이너리 파일 및 설정 파일 위치 이동

mv prometheus /usr/local/bin/

mv promtool /usr/local/bin/

mkdir -p /etc/prometheus /var/lib/prometheus

mv prometheus.yml /etc/prometheus/

cat /etc/prometheus/prometheus.yml

# 계정 생성 및 권한 설정

useradd --no-create-home --shell /sbin/nologin prometheus

chown -R prometheus:prometheus /etc/prometheus /var/lib/prometheus

chown prometheus:prometheus /usr/local/bin/prometheus /usr/local/bin/promtool

# 서비스 설정 변경

tee /etc/systemd/system/prometheus.service > /dev/null <<EOF

[Unit]

Description=Prometheus

Wants=network-online.target

After=network-online.target

[Service]

User=prometheus

Group=prometheus

Type=simple

ExecStart=/usr/local/bin/prometheus \

--config.file=/etc/prometheus/prometheus.yml \

--storage.tsdb.path=/var/lib/prometheus \

--web.listen-address=0.0.0.0:9090

[Install]

WantedBy=multi-user.target

EOF

# 서비스 등록 및 데몬 시작

systemctl daemon-reload

systemctl enable --now prometheus

systemctl status prometheus

ss -tnlp

# 접속 테스트

curl localhost:9090/metrics

echo -e "http://$(curl -s ipinfo.io/ip):9090"

- node_exporter 설치

서버의 OS 메트릭을 수집 (CPU, Disk, FS 정보가 있는 /proc, /sys를 통해 수집)

# Node Exporter 최신 버전 다운로드

cd ~

wget https://github.com/prometheus/node_exporter/releases/download/v1.9.0/node_exporter-1.9.0.linux-amd64.tar.gz

tar xvfz node_exporter-1.9.0.linux-amd64.tar.gz

cd node_exporter-1.9.0.linux-amd64

cp node_exporter /usr/local/bin/

# 계정 생성 및 권한 설정

groupadd -f node_exporter

useradd -g node_exporter --no-create-home --shell /sbin/nologin node_exporter

chown node_exporter:node_exporter /usr/local/bin/node_exporter

# 서비스 정보 설정

tee /etc/systemd/system/node_exporter.service > /dev/null <<EOF

[Unit]

Description=Node Exporter

Documentation=https://prometheus.io/docs/guides/node-exporter/

Wants=network-online.target

After=network-online.target

[Service]

User=node_exporter

Group=node_exporter

Type=simple

Restart=on-failure

ExecStart=/usr/local/bin/node_exporter \

--web.listen-address=:9200

[Install]

WantedBy=multi-user.target

EOF

# 서비스 등록 및 실행

systemctl daemon-reload

systemctl enable --now node_exporter

systemctl status node_exporter

ss -tnlp

# 접속 테스트

curl localhost:9200/metrics

- prometheus 설정 수집 대상 target 추가

# prometheus.yml 수정

cat << EOF >> /etc/prometheus/prometheus.yml

- job_name: 'node_exporter'

static_configs:

- targets: ["127.0.0.1:9200"]

labels:

alias: 'myec2'

EOF

# prometheus 데몬 재기동

systemctl restart prometheus.service

systemctl status prometheus

- 프로메테우스-스택 설치

# 모니터링

watch kubectl get pod,pvc,svc,ingress -n monitoring

# repo 추가

helm repo add prometheus-community https://prometheus-community.github.io/helm-charts

# 파라미터 파일 생성

cat <<EOT > monitor-values.yaml

prometheus:

prometheusSpec:

scrapeInterval: "15s"

evaluationInterval: "15s"

podMonitorSelectorNilUsesHelmValues: false

serviceMonitorSelectorNilUsesHelmValues: false

retention: 5d

retentionSize: "10GiB"

storageSpec:

volumeClaimTemplate:

spec:

storageClassName: gp3

accessModes: ["ReadWriteOnce"]

resources:

requests:

storage: 30Gi

ingress:

enabled: true

ingressClassName: alb

hosts:

- prometheus.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

grafana:

defaultDashboardsTimezone: Asia/Seoul

adminPassword: prom-operator

ingress:

enabled: true

ingressClassName: alb

hosts:

- grafana.$MyDomain

paths:

- /*

annotations:

alb.ingress.kubernetes.io/scheme: internet-facing

alb.ingress.kubernetes.io/target-type: ip

alb.ingress.kubernetes.io/listen-ports: '[{"HTTPS":443}, {"HTTP":80}]'

alb.ingress.kubernetes.io/certificate-arn: $CERT_ARN

alb.ingress.kubernetes.io/success-codes: 200-399

alb.ingress.kubernetes.io/load-balancer-name: myeks-ingress-alb

alb.ingress.kubernetes.io/group.name: study

alb.ingress.kubernetes.io/ssl-redirect: '443'

persistence:

enabled: true

type: sts

storageClassName: "gp3"

accessModes:

- ReadWriteOnce

size: 20Gi

alertmanager:

enabled: false

defaultRules:

create: false

kubeControllerManager:

enabled: false

kubeEtcd:

enabled: false

kubeScheduler:

enabled: false

prometheus-windows-exporter:

prometheus:

monitor:

enabled: false

EOT

cat monitor-values.yaml

# 배포

helm install kube-prometheus-stack prometheus-community/kube-prometheus-stack --version 69.3.1 \

-f monitor-values.yaml --create-namespace --namespace monitoring

## 확인

helm list -n monitoring

kubectl get sts,ds,deploy,pod,svc,ep,ingress,pvc,pv -n monitoring

kubectl get-all -n monitoring

kubectl get prometheus,servicemonitors -n monitoring

kubectl get crd | grep monitoring

kubectl df-pv

## 프로메테우스 버전 확인

echo -e "https://prometheus.$MyDomain/api/v1/status/buildinfo"

open https://prometheus.$MyDomain/api/v1/status/buildinfo # macOS

kubectl exec -it sts/prometheus-kube-prometheus-stack-prometheus -n monitoring -c prometheus -- prometheus --version

# 그라파나 웹 접속

echo -e "https://grafana.$MyDomain"

open "https://grafana.$MyDomain" # macOS

- 프로메테우스 버전

- 그라파나 웹 페이지 접속

AWS CNI Metrics 수집

## 수집 전 사전 설정으로 podmonitor 배포

cat <<EOF | kubectl create -f -

apiVersion: monitoring.coreos.com/v1

kind: PodMonitor

metadata:

name: aws-cni-metrics

namespace: kube-system

spec:

jobLabel: k8s-app

namespaceSelector:

matchNames:

- kube-system

podMetricsEndpoints:

- interval: 30s

path: /metrics

port: metrics

selector:

matchLabels:

k8s-app: aws-node

EOF

## 배포 확인

$ k get podmonitor -n kube-system

$ k get podmonitor -n kube-system aws-cni-metrics -o yaml | k neat

## metrics url 접속 확인

$ curl -s $N1:61678/metrics | grep '^awscni'

프로메테우스 기본 사용

- 모니터링 대상이 되는 서비스는 일반적으로 자체 웹 서버의 /metrics 엔드포인트 경로에 다양한 메트릭 정보를 노출

- 이후 프로메테우스는 해당 경로에 http get 방식의 메트릭 정보를 가져와 TSDB 형식으로 저장

## 프로메테우스가 각 서비스의 포트로 접속하여 메트릭 정보 확인

$ k get node -o wide

$ k get svc,ep -n monitoring kube-prometheus-stack-prometheus-node-exporter

## (노드 익스포터 경우) 노드의 9100번 포트의 /metrics 접속 시 다양한 메트릭 정보르 확일할 수 있음

$ ssh ec2-user@$N1 curl -s localhost:9100/metrics

프로메테우스 웹 페이지 메뉴

- Query : 프로메테우스 자체 점색어인 PromQL을 이용하여 메트릭 정보 조회

- Alerts : 사전에 정의한 경고 정책에 대한 알람

- Status : 경고 메시지 정책, 모니터링 대상과 같은 현재 상태

- User local time : 출력 시간을 로컬 타임으로 설정

- Enable Query history : PromQL 쿼리 히스토리 활성화

- Enable autocomplete : 자동 완성 기능 활성화

- Enable highlighting : 하이라이팅 기능 활성화

- Enable linter : 문법 오류 감지, 자동 코스 스타일 체크

전체 메트릭 대상 확인 : Status > Target health

(kube-proxy 예시)

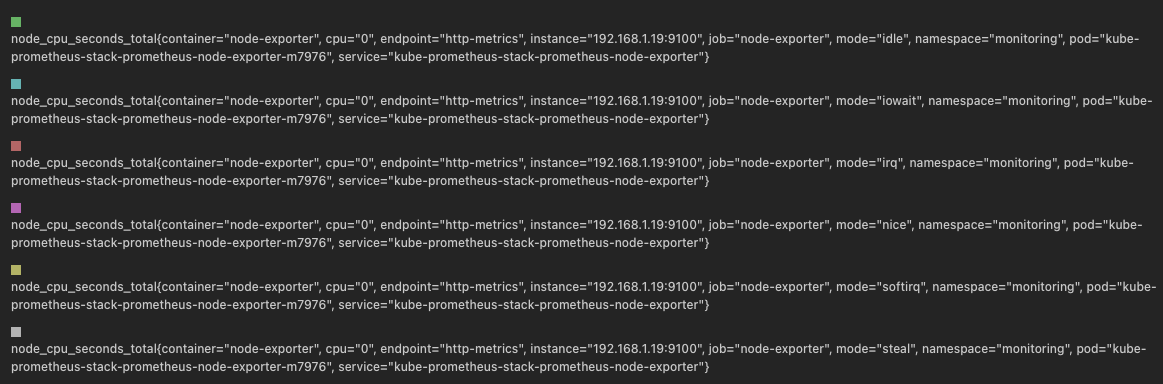

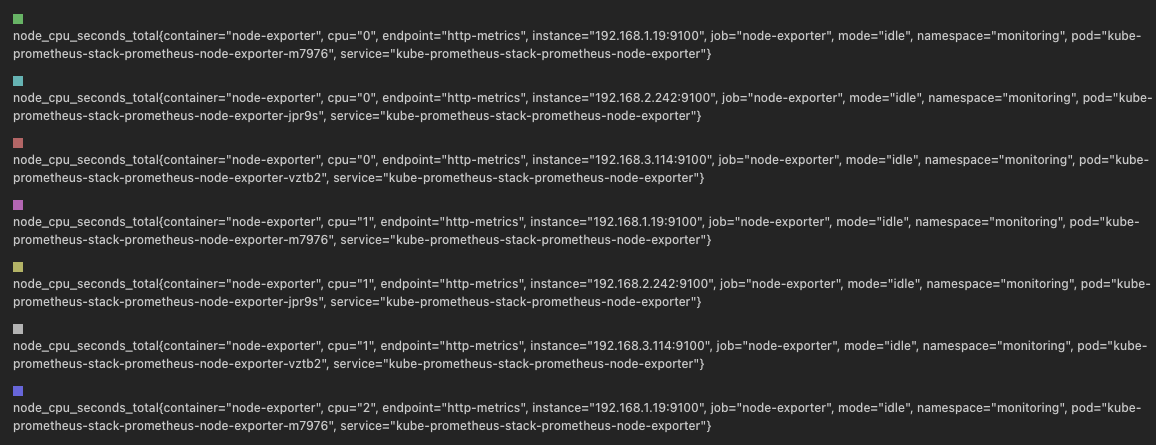

메트릭을 그래프로 조회

## 프로메테우스 웹의 Query에서 수행

# 초당 node의 cpu 정보

node_cpu_seconds_total

## idle mode만 조회

node_cpu_seconds_total{mode="idle"}

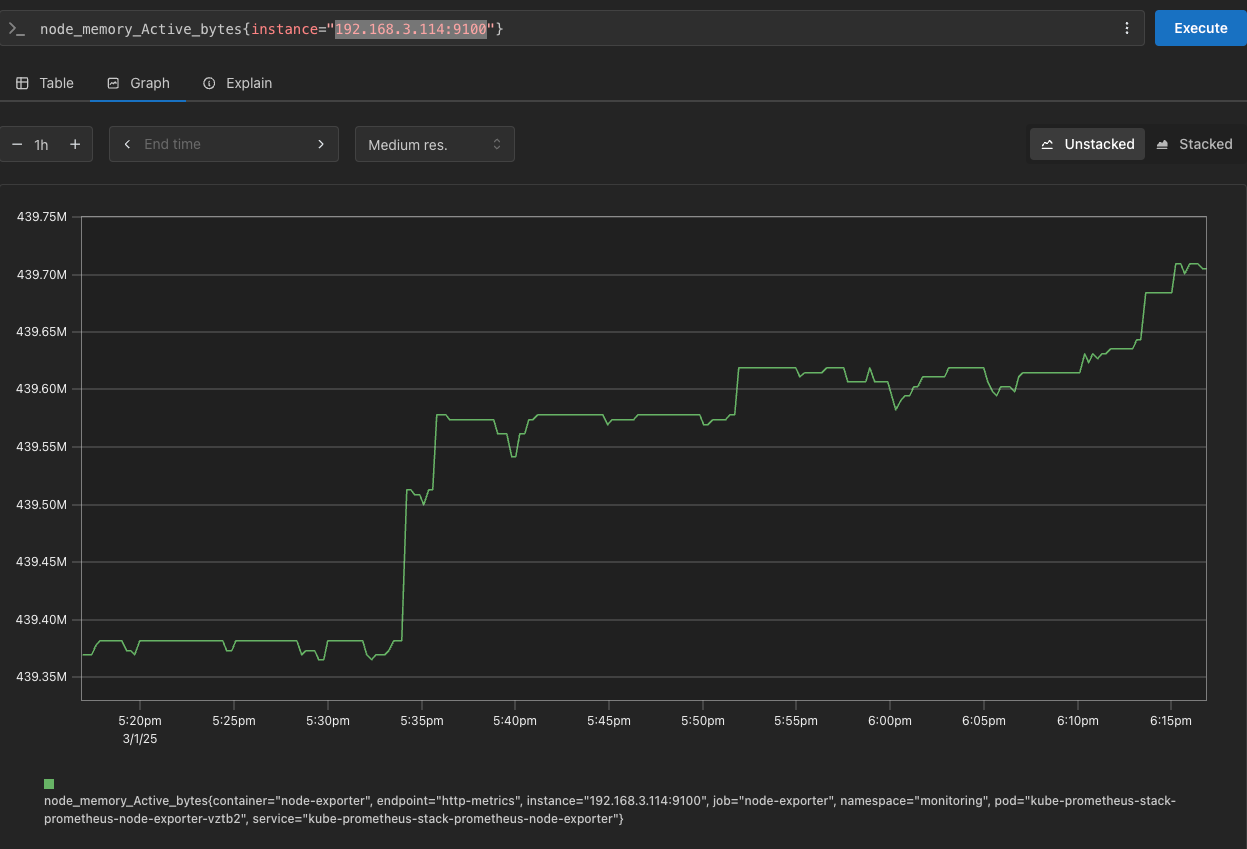

PromQL 쿼리

# Table 아래 쿼리 입력 후 Execute 클릭 -> Graph 확인

## 출력되는 메트릭 정보는 node-exporter 를 통해서 노드에서 수집된 정보

node_memory_Active_bytes

# 특정 노드(인스턴스) 필터링 : 아래 IP는 출력되는 자신의 인스턴스 PrivateIP 입력 후 Execute 클릭 -> Graph 확인

node_memory_Active_bytes{instance="192.168.3.114:9100"}

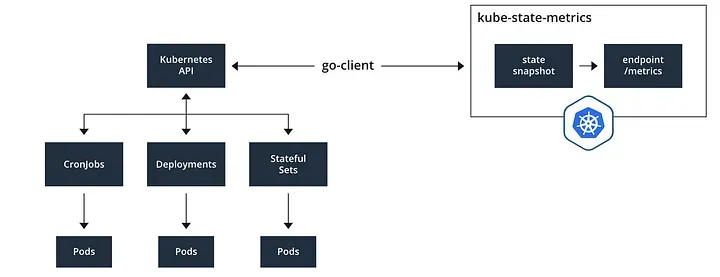

kube-state-metrics (ksm) : k8s api 통해 k8s 오브젝트 정보 수집

# replicas's number

kube_deployment_status_replicas

kube_deployment_status_replicas_available

kube_deployment_status_replicas_available{deployment="coredns"}

# scale out

kubectl scale deployment -n kube-system coredns --replicas 3

# 확인

kube_deployment_status_replicas_available{deployment="coredns"}

# scale in

kubectl scale deployment -n kube-system coredns --replicas 1

kube-proxy : 이미 내장으로 메트릭 노출 준비가 설정되어 있다.

PromQL 쿼리 : 어플리케이션

- 서비스모니터 동작

- nginx를 helm으로 설치할 때 프로메테우스 익스포터 옵션 설정 시 자동으로 nginx 프로메테우스 모니터링에 등록 가능

- 기존 어플리케이션 파드에 프로메테우스 모니터링을 투가하려면 사이드카 방식을 사용하며, exporter 컨테이너를 추가

- nginx 웹 서버(with helm)에 metrics 수집 설정 추가

## 모니터링

$ watch -d "kubectl get pod; echo; kubectl get servicemonitors -n monitoring"

## nginx 파드내에 컨테이너 갯수 확인

$ k describe pod -l app.kubernetes.io/instance=nginx

## 파라미터 파일 생성 : 서비스 모니터 방식으로 nginx를 모니터링 대상으로 등록 export port는 9113사용

cat <<EOT > nginx-values.yaml

metrics:

enabled: true

service:

port: 9113

serviceMonitor:

enabled: true

namespace: monitoring

interval: 10s

EOT

## 배포

$ helm upgrade nginx bitnami/nginx --reuse-values -f nginx-values.yaml

nginx-85df7754bf-v4zjt 1/2 Running 0 18s

## 배포가 완료된 이후 describe를 보면 metrics 컨테이너가 추가로 생성되었다.

metrics:

Container ID: containerd://d04ae80dbfba2471d074037c3e9c48019ddad4362a3a8e6a738ef88300f0d04b

Image: docker.io/bitnami/nginx-exporter:1.4.1-debian-12-r3

Image ID: docker.io/bitnami/nginx-exporter@sha256:fea1a013e5769d5eadd5d2d8b3f339d1c465b7de301ab7f454eb4adc7a8959ac

Port: 9113/TCP

Host Port: 0/TCP

Command:

exporter

Args:

--nginx.scrape-uri

http://127.0.0.1:8080/status

--web.listen-address

:9113

State: Running

Started: Sun, 02 Mar 2025 03:28:05 +0900

Ready: True

Restart Count: 0

Limits:

cpu: 150m

ephemeral-storage: 2Gi

memory: 192Mi

Requests:

cpu: 100m

ephemeral-storage: 50Mi

memory: 128Mi

Liveness: http-get http://:metrics/metrics delay=15s timeout=5s period=10s #success=1 #failure=3

Readiness: http-get http://:metrics/metrics delay=5s timeout=1s period=10s #success=1 #failure=3

Environment: <none>

Mounts: <none>

## 확인

$ k get servicemonitor -n monitoring nginx

$ kubectl get servicemonitor -n monitoring nginx -o json | jq

# [운영서버 EC2] 메트릭 확인 >> 프로메테우스에서 Target 확인

## nginx sub_status url 접속해보기

NGINXIP=$(kubectl get pod -l app.kubernetes.io/instance=nginx -o jsonpath="{.items[0].status.podIP}")

curl -s http://$NGINXIP:9113/metrics # nginx_connections_active Y 값 확인해보기

curl -s http://$NGINXIP:9113/metrics | grep ^nginx_connections_active

## 반복 접근

$ while true; do curl -s https://nginx.$MyDomain -I | head -n 1; date; sleep 1; done

- 프로메테우스에 nginx servicemonitor 추가 확인

- 설정이 자동으로 반영되는 원리는 주요 config 적용 필요 시 reloader 동작

프로메테우스 메트릭 종류 : Counter, Gauge, Histogram, Summary

- Counter : 누적된 값을 표현, 증가 시 구간 별로 변화 확인

- Gauge : 특정 시점의 값을 표현하기 위해 사용, CPU 온도나 메모리 사용향에 대한 현재 시점 값

- Summary : 구간 내에 있는 메트릭 값의 빈도, 중앙값 등 통계적 메트릭

- Histogram : 사전에 미리 정의한 구간 내에 있는 메트릭 값의 빈도를 측정

PromQL Query

- Label Matchers

# 예시

node_memory_Active_bytes

node_memory_Active_bytes{instance="192.168.1.188:9100"}

node_memory_Active_bytes{instance!="192.168.1.188:9100"}

# 정규표현식

node_memory_Active_bytes{instance=~"192.168.+"}

node_memory_Active_bytes{instance=~"192.168.1.+"}

# 다수 대상

node_memory_Active_bytes{instance=~"192.168.1.188:9100|192.168.2.170:9100"}

node_memory_Active_bytes{instance!~"192.168.1.188:9100|192.168.2.170:9100"}

# 여러 조건 AND

kube_deployment_status_replicas_available{namespace="kube-system"}

kube_deployment_status_replicas_available{namespace="kube-system", deployment="coredns"}

- 이진 연산자

# 산술 이진 연산자 : + - * / * ^

node_memory_Active_bytes

node_memory_Active_bytes/1024

node_memory_Active_bytes/1024/1024

# 비교 이진 연산자 : = = ! = > < > = < =

nginx_http_requests_total

nginx_http_requests_total > 100

nginx_http_requests_total > 10000

# 논리/집합 이진 연산자 : and 교집합 , or 합집합 , unless 차집합

kube_pod_status_ready

kube_pod_container_resource_requests

kube_pod_status_ready == 1

kube_pod_container_resource_requests > 1

kube_pod_status_ready == 1 or kube_pod_container_resource_requests > 1

kube_pod_status_ready == 1 and kube_pod_container_resource_requests > 1

- 집계 연산자

#

node_memory_Active_bytes

# 출력 값 중 Top 3

topk(3, node_memory_Active_bytes)

# 출력 값 중 하위 3

bottomk(3, node_memory_Active_bytes)

bottomk(3, node_memory_Active_bytes>0)

# node 그룹별: by

node_cpu_seconds_total

node_cpu_seconds_total{mode="user"}

node_cpu_seconds_total{mode="system"}

avg(node_cpu_seconds_total)

avg(node_cpu_seconds_total) by (instance)

avg(node_cpu_seconds_total{mode="user"}) by (instance)

avg(node_cpu_seconds_total{mode="system"}) by (instance)

#

nginx_http_requests_total

sum(nginx_http_requests_total)

sum(nginx_http_requests_total) by (instance)

# 특정 내용 제외하고 출력 : without

nginx_http_requests_total

sum(nginx_http_requests_total) without (instance)

sum(nginx_http_requests_total) without (instance,container,endpoint,job,namespace)

- 활용

# 서비스 정보 >> 네임스페이스별 >> cluster_ip 별

kube_service_info

count(kube_service_info)

count(kube_service_info) by (namespace)

count(kube_service_info) by (cluster_ip)

# 컨테이너가 사용 메모리 -> 파드별

container_memory_working_set_bytes

sum(container_memory_working_set_bytes)

sum(container_memory_working_set_bytes) by (pod)

topk(5,sum(container_memory_working_set_bytes) by (pod))

topk(5,sum(container_memory_working_set_bytes) by (pod))/1024/1024

Grafana

TSDB 데이터를 시각화, 다양한 데이터 형식 지원

- 그라파나는 시각화 솔루션으로 데이터 자체를 저장하지 않음

## 그라파나 버전 확인